Estudio: los modelos de OpenAI memorizaron contenido con derechos de autor

Un estudio reciente sugiere que OpenAI podría haber utilizado material protegido por derechos de autor para entrenar algunos de sus modelos de IA, añadiendo más leña al fuego de las batallas legales que enfrenta la compañía. Autores, programadores y otros creadores de contenido han acusado a OpenAI de usar sus obras —como libros y código— sin permiso para desarrollar sus modelos de IA. Aunque OpenAI se ha defendido alegando el uso justo, los demandantes argumentan que la ley de derechos de autor de EE. UU. no proporciona una excepción para los datos de entrenamiento.

El estudio, una colaboración entre investigadores de la Universidad de Washington, la Universidad de Copenhague y Stanford, presenta una nueva técnica para detectar datos de entrenamiento "memorizados" en modelos a los que se accede a través de una API, como los de OpenAI. Los modelos de IA esencialmente aprenden de grandes cantidades de datos para reconocer patrones, lo que les permite crear ensayos, imágenes y más. Aunque la mayoría de los resultados no son copias directas de los datos de entrenamiento, algunos lo son inevitablemente debido al proceso de aprendizaje. Por ejemplo, se sabe que los modelos de imágenes han reproducido capturas de pantalla de películas, mientras que los modelos de lenguaje han sido sorprendidos prácticamente plagiando artículos de noticias.

El método descrito en el estudio se centra en palabras de "alta sorpresa" —palabras que son inusuales en un contexto dado. Por ejemplo, en la frase "Jack y yo nos sentamos perfectamente quietos con el radar zumbando," "radar" sería una palabra de alta sorpresa porque es menos esperada que palabras como "motor" o "radio" para preceder a "zumbando."

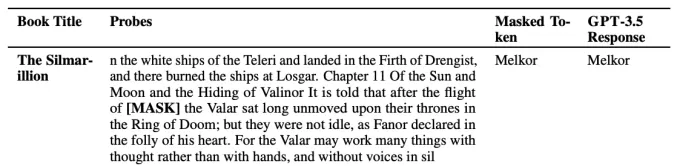

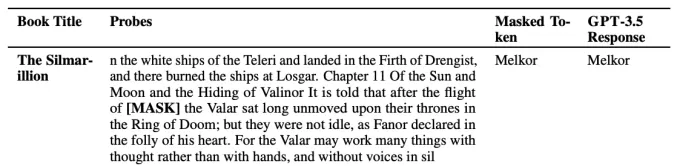

Los investigadores probaron varios modelos de OpenAI, incluyendo GPT-4 y GPT-3.5, eliminando palabras de alta sorpresa de extractos de libros de ficción y artículos del New York Times y pidiendo a los modelos que predijeran estas palabras faltantes. Si los modelos adivinaban correctamente las palabras, esto sugería que habían memorizado el texto durante el entrenamiento.

Un ejemplo de hacer que un modelo "adivine" una palabra de alta sorpresa. Créditos de la imagen: OpenAI Los resultados indicaron que GPT-4 probablemente había memorizado partes de libros de ficción populares, incluyendo aquellos en el conjunto de datos BookMIA de libros electrónicos protegidos por derechos de autor. También parecía haber memorizado algunos artículos del New York Times, aunque con una frecuencia menor.Abhilasha Ravichander, estudiante de doctorado en la Universidad de Washington y coautora del estudio, enfatizó a TechCrunch que estos hallazgos destacan los "datos controvertidos" que podrían haber sido utilizados para entrenar estos modelos. "Para tener modelos de lenguaje grandes que sean confiables, necesitamos modelos que podamos sondear, auditar y examinar científicamente," afirmó Ravichander. "Nuestro trabajo busca proporcionar una herramienta para sondear modelos de lenguaje grandes, pero hay una necesidad real de mayor transparencia de datos en todo el ecosistema."

OpenAI ha presionado por reglas más relajadas sobre el uso de datos protegidos por derechos de autor para desarrollar modelos de IA. Aunque la compañía tiene algunos acuerdos de licencia de contenido y ofrece opciones de exclusión para los titulares de derechos de autor, ha presionado a varios gobiernos para establecer reglas de "uso justo" específicamente para el entrenamiento de IA.

Artículo relacionado

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

comentario (32)

0/200

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

comentario (32)

0/200

![WilliamGonzalez]() WilliamGonzalez

WilliamGonzalez

25 de agosto de 2025 11:01:06 GMT+02:00

25 de agosto de 2025 11:01:06 GMT+02:00

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

![GregoryBaker]() GregoryBaker

GregoryBaker

23 de agosto de 2025 13:01:18 GMT+02:00

23 de agosto de 2025 13:01:18 GMT+02:00

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

![JohnGarcia]() JohnGarcia

JohnGarcia

23 de abril de 2025 17:10:14 GMT+02:00

23 de abril de 2025 17:10:14 GMT+02:00

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

22 de abril de 2025 02:12:42 GMT+02:00

22 de abril de 2025 02:12:42 GMT+02:00

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

![WillLopez]() WillLopez

WillLopez

21 de abril de 2025 13:49:05 GMT+02:00

21 de abril de 2025 13:49:05 GMT+02:00

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

![WillMitchell]() WillMitchell

WillMitchell

21 de abril de 2025 05:30:11 GMT+02:00

21 de abril de 2025 05:30:11 GMT+02:00

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0

Un estudio reciente sugiere que OpenAI podría haber utilizado material protegido por derechos de autor para entrenar algunos de sus modelos de IA, añadiendo más leña al fuego de las batallas legales que enfrenta la compañía. Autores, programadores y otros creadores de contenido han acusado a OpenAI de usar sus obras —como libros y código— sin permiso para desarrollar sus modelos de IA. Aunque OpenAI se ha defendido alegando el uso justo, los demandantes argumentan que la ley de derechos de autor de EE. UU. no proporciona una excepción para los datos de entrenamiento.

El estudio, una colaboración entre investigadores de la Universidad de Washington, la Universidad de Copenhague y Stanford, presenta una nueva técnica para detectar datos de entrenamiento "memorizados" en modelos a los que se accede a través de una API, como los de OpenAI. Los modelos de IA esencialmente aprenden de grandes cantidades de datos para reconocer patrones, lo que les permite crear ensayos, imágenes y más. Aunque la mayoría de los resultados no son copias directas de los datos de entrenamiento, algunos lo son inevitablemente debido al proceso de aprendizaje. Por ejemplo, se sabe que los modelos de imágenes han reproducido capturas de pantalla de películas, mientras que los modelos de lenguaje han sido sorprendidos prácticamente plagiando artículos de noticias.

El método descrito en el estudio se centra en palabras de "alta sorpresa" —palabras que son inusuales en un contexto dado. Por ejemplo, en la frase "Jack y yo nos sentamos perfectamente quietos con el radar zumbando," "radar" sería una palabra de alta sorpresa porque es menos esperada que palabras como "motor" o "radio" para preceder a "zumbando."

Los investigadores probaron varios modelos de OpenAI, incluyendo GPT-4 y GPT-3.5, eliminando palabras de alta sorpresa de extractos de libros de ficción y artículos del New York Times y pidiendo a los modelos que predijeran estas palabras faltantes. Si los modelos adivinaban correctamente las palabras, esto sugería que habían memorizado el texto durante el entrenamiento.

Abhilasha Ravichander, estudiante de doctorado en la Universidad de Washington y coautora del estudio, enfatizó a TechCrunch que estos hallazgos destacan los "datos controvertidos" que podrían haber sido utilizados para entrenar estos modelos. "Para tener modelos de lenguaje grandes que sean confiables, necesitamos modelos que podamos sondear, auditar y examinar científicamente," afirmó Ravichander. "Nuestro trabajo busca proporcionar una herramienta para sondear modelos de lenguaje grandes, pero hay una necesidad real de mayor transparencia de datos en todo el ecosistema."

OpenAI ha presionado por reglas más relajadas sobre el uso de datos protegidos por derechos de autor para desarrollar modelos de IA. Aunque la compañía tiene algunos acuerdos de licencia de contenido y ofrece opciones de exclusión para los titulares de derechos de autor, ha presionado a varios gobiernos para establecer reglas de "uso justo" específicamente para el entrenamiento de IA.

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

25 de agosto de 2025 11:01:06 GMT+02:00

25 de agosto de 2025 11:01:06 GMT+02:00

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

23 de agosto de 2025 13:01:18 GMT+02:00

23 de agosto de 2025 13:01:18 GMT+02:00

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

23 de abril de 2025 17:10:14 GMT+02:00

23 de abril de 2025 17:10:14 GMT+02:00

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

22 de abril de 2025 02:12:42 GMT+02:00

22 de abril de 2025 02:12:42 GMT+02:00

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

21 de abril de 2025 13:49:05 GMT+02:00

21 de abril de 2025 13:49:05 GMT+02:00

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

21 de abril de 2025 05:30:11 GMT+02:00

21 de abril de 2025 05:30:11 GMT+02:00

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0