Studie: OpenAI -Modelle merkten aus dem urheberrechtlich geschützten Inhalt aus

Eine kürzliche Studie legt nahe, dass OpenAI tatsächlich urheberrechtlich geschütztes Material verwendet haben könnte, um einige seiner KI-Modelle zu trainieren, was die laufenden rechtlichen Auseinandersetzungen des Unternehmens weiter anheizt. Autoren, Programmierer und andere Inhaltsersteller haben OpenAI beschuldigt, ihre Werke – wie Bücher und Code – ohne Erlaubnis verwendet zu haben, um seine KI-Modelle zu entwickeln. Während OpenAI sich mit dem Argument der fairen Nutzung verteidigt, argumentieren die Kläger, dass das US-Urheberrecht keine Ausnahme für Trainingsdaten vorsieht.

Die Studie, eine Zusammenarbeit von Forschern der University of Washington, der University of Copenhagen und Stanford, stellt eine neue Technik vor, um „gespeicherte“ Trainingsdaten in Modellen zu erkennen, die über eine API zugänglich sind, wie jene von OpenAI. KI-Modelle lernen im Wesentlichen aus riesigen Datenmengen, um Muster zu erkennen, was ihnen ermöglicht, Essays, Bilder und mehr zu erstellen. Obwohl die meisten Ausgaben keine direkten Kopien der Trainingsdaten sind, sind einige aufgrund des Lernprozesses unvermeidlich. Zum Beispiel ist bekannt, dass Bildmodelle Filmscreenshots reproduzieren, während Sprachmodelle Nachrichtenartikel im Wesentlichen plagiiert haben.

Die in der Studie beschriebene Methode konzentriert sich auf „hoch überraschende“ Wörter – Wörter, die in einem bestimmten Kontext ungewöhnlich sind. Zum Beispiel wäre in dem Satz „Jack und ich saßen völlig still, während das Radar summte“ das Wort „Radar“ ein hoch überraschendes Wort, da es weniger erwartet wird als Wörter wie „Motor“ oder „Radio“ vor „summte“.

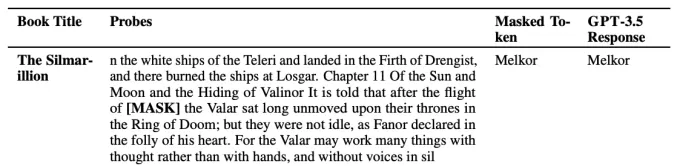

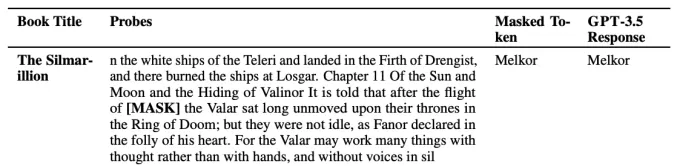

Die Forscher testeten mehrere OpenAI-Modelle, einschließlich GPT-4 und GPT-3.5, indem sie hoch überraschende Wörter aus Auszügen von Fiktionsbüchern und Artikeln der New York Times entfernten und die Modelle aufforderten, diese fehlenden Wörter vorherzusagen. Wenn die Modelle die Wörter korrekt erraten, deutete dies darauf hin, dass sie den Text während des Trainings gespeichert hatten.

Ein Beispiel dafür, wie ein Modell ein hoch überraschendes Wort „errät“. Bildnachweis: OpenAI Die Ergebnisse zeigten, dass GPT-4 wahrscheinlich Teile populärer Fiktionsbücher gespeichert hatte, einschließlich solcher im BookMIA-Datensatz urheberrechtlich geschützter E-Books. Es schien auch einige Artikel der New York Times gespeichert zu haben, allerdings in geringerem Umfang.Abhilasha Ravichander, eine Doktorandin an der University of Washington und Mitautorin der Studie, betonte gegenüber TechCrunch, dass diese Ergebnisse die „umstrittenen Daten“ hervorheben, die möglicherweise zum Trainieren dieser Modelle verwendet wurden. „Um große Sprachmodelle zu haben, die vertrauenswürdig sind, brauchen wir Modelle, die wir untersuchen, prüfen und wissenschaftlich analysieren können“, erklärte Ravichander. „Unsere Arbeit zielt darauf ab, ein Werkzeug bereitzustellen, um große Sprachmodelle zu untersuchen, aber es gibt ein echtes Bedürfnis nach größerer Datentransparenz im gesamten Ökosystem.“

OpenAI hat sich für lockerere Regeln zur Verwendung urheberrechtlich geschützter Daten zur Entwicklung von KI-Modellen eingesetzt. Obwohl das Unternehmen einige Lizenzvereinbarungen für Inhalte hat und Opt-out-Optionen für Urheberrechtsinhaber anbietet, hat es verschiedene Regierungen dazu gedrängt, spezifische „Fair Use“-Regeln für das KI-Training einzuführen.

Verwandter Artikel

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

Kommentare (32)

0/200

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

Kommentare (32)

0/200

![WilliamGonzalez]() WilliamGonzalez

WilliamGonzalez

25. August 2025 11:01:06 MESZ

25. August 2025 11:01:06 MESZ

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

![GregoryBaker]() GregoryBaker

GregoryBaker

23. August 2025 13:01:18 MESZ

23. August 2025 13:01:18 MESZ

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

![JohnGarcia]() JohnGarcia

JohnGarcia

23. April 2025 17:10:14 MESZ

23. April 2025 17:10:14 MESZ

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

22. April 2025 02:12:42 MESZ

22. April 2025 02:12:42 MESZ

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

![WillLopez]() WillLopez

WillLopez

21. April 2025 13:49:05 MESZ

21. April 2025 13:49:05 MESZ

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

![WillMitchell]() WillMitchell

WillMitchell

21. April 2025 05:30:11 MESZ

21. April 2025 05:30:11 MESZ

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0

Eine kürzliche Studie legt nahe, dass OpenAI tatsächlich urheberrechtlich geschütztes Material verwendet haben könnte, um einige seiner KI-Modelle zu trainieren, was die laufenden rechtlichen Auseinandersetzungen des Unternehmens weiter anheizt. Autoren, Programmierer und andere Inhaltsersteller haben OpenAI beschuldigt, ihre Werke – wie Bücher und Code – ohne Erlaubnis verwendet zu haben, um seine KI-Modelle zu entwickeln. Während OpenAI sich mit dem Argument der fairen Nutzung verteidigt, argumentieren die Kläger, dass das US-Urheberrecht keine Ausnahme für Trainingsdaten vorsieht.

Die Studie, eine Zusammenarbeit von Forschern der University of Washington, der University of Copenhagen und Stanford, stellt eine neue Technik vor, um „gespeicherte“ Trainingsdaten in Modellen zu erkennen, die über eine API zugänglich sind, wie jene von OpenAI. KI-Modelle lernen im Wesentlichen aus riesigen Datenmengen, um Muster zu erkennen, was ihnen ermöglicht, Essays, Bilder und mehr zu erstellen. Obwohl die meisten Ausgaben keine direkten Kopien der Trainingsdaten sind, sind einige aufgrund des Lernprozesses unvermeidlich. Zum Beispiel ist bekannt, dass Bildmodelle Filmscreenshots reproduzieren, während Sprachmodelle Nachrichtenartikel im Wesentlichen plagiiert haben.

Die in der Studie beschriebene Methode konzentriert sich auf „hoch überraschende“ Wörter – Wörter, die in einem bestimmten Kontext ungewöhnlich sind. Zum Beispiel wäre in dem Satz „Jack und ich saßen völlig still, während das Radar summte“ das Wort „Radar“ ein hoch überraschendes Wort, da es weniger erwartet wird als Wörter wie „Motor“ oder „Radio“ vor „summte“.

Die Forscher testeten mehrere OpenAI-Modelle, einschließlich GPT-4 und GPT-3.5, indem sie hoch überraschende Wörter aus Auszügen von Fiktionsbüchern und Artikeln der New York Times entfernten und die Modelle aufforderten, diese fehlenden Wörter vorherzusagen. Wenn die Modelle die Wörter korrekt erraten, deutete dies darauf hin, dass sie den Text während des Trainings gespeichert hatten.

Abhilasha Ravichander, eine Doktorandin an der University of Washington und Mitautorin der Studie, betonte gegenüber TechCrunch, dass diese Ergebnisse die „umstrittenen Daten“ hervorheben, die möglicherweise zum Trainieren dieser Modelle verwendet wurden. „Um große Sprachmodelle zu haben, die vertrauenswürdig sind, brauchen wir Modelle, die wir untersuchen, prüfen und wissenschaftlich analysieren können“, erklärte Ravichander. „Unsere Arbeit zielt darauf ab, ein Werkzeug bereitzustellen, um große Sprachmodelle zu untersuchen, aber es gibt ein echtes Bedürfnis nach größerer Datentransparenz im gesamten Ökosystem.“

OpenAI hat sich für lockerere Regeln zur Verwendung urheberrechtlich geschützter Daten zur Entwicklung von KI-Modellen eingesetzt. Obwohl das Unternehmen einige Lizenzvereinbarungen für Inhalte hat und Opt-out-Optionen für Urheberrechtsinhaber anbietet, hat es verschiedene Regierungen dazu gedrängt, spezifische „Fair Use“-Regeln für das KI-Training einzuführen.

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

25. August 2025 11:01:06 MESZ

25. August 2025 11:01:06 MESZ

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

23. August 2025 13:01:18 MESZ

23. August 2025 13:01:18 MESZ

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

23. April 2025 17:10:14 MESZ

23. April 2025 17:10:14 MESZ

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

22. April 2025 02:12:42 MESZ

22. April 2025 02:12:42 MESZ

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

21. April 2025 13:49:05 MESZ

21. April 2025 13:49:05 MESZ

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

21. April 2025 05:30:11 MESZ

21. April 2025 05:30:11 MESZ

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0