Meta défend la version Llama 4, cite les bogues comme cause de rapports de qualité mixte

Durant le week-end, Meta, la puissance derrière Facebook, Instagram, WhatsApp et Quest VR, a surpris tout le monde en dévoilant son dernier modèle de langage AI, Llama 4. Pas un, mais trois nouvelles versions ont été présentées, chacune dotée de capacités améliorées grâce à l'architecture "Mixture-of-Experts" et une nouvelle approche d'entraînement appelée MetaP, impliquant des hyperparamètres fixes. De plus, les trois modèles offrent des fenêtres de contexte étendues, leur permettant de traiter plus d'informations en une seule interaction.

Malgré l'enthousiasme de la sortie, la réaction de la communauté AI a été au mieux tiède. Samedi, Meta a rendu deux de ces modèles, Llama 4 Scout et Llama 4 Maverick, disponibles au téléchargement et à l'utilisation, mais la réponse a été loin d'être enthousiaste.

Llama 4 suscite confusion et critiques parmi les utilisateurs AI

Un message non vérifié sur le forum 1point3acres, une communauté populaire de langue chinoise en Amérique du Nord, a trouvé son chemin vers le subreddit r/LocalLlama sur Reddit. Le message, prétendument d'un chercheur de l'organisation GenAI de Meta, affirmait que Llama 4 sous-performait sur des benchmarks tiers internes. Il suggérait que la direction de Meta avait manipulé les résultats en mélangeant les ensembles de tests pendant l'entraînement pour atteindre divers indicateurs et présenter un résultat favorable. L'authenticité de cette affirmation a été accueillie avec scepticisme, et Meta n'a pas encore répondu aux demandes de VentureBeat.

Cependant, les doutes sur les performances de Llama 4 ne s'arrêtent pas là. Sur X, l'utilisateur @cto_junior a exprimé son incrédulité face aux performances du modèle, citant un test indépendant où Llama 4 Maverick a obtenu seulement 16 % sur le benchmark polyglot aider, qui teste les tâches de codage. Ce score est nettement inférieur à celui de modèles plus anciens de taille similaire comme DeepSeek V3 et Claude 3.7 Sonnet.

Le docteur en AI et auteur Andriy Burkov a également pris la parole sur X pour remettre en question la fenêtre de contexte annoncée de 10 millions de tokens pour Llama 4 Scout, déclarant qu'elle est "virtuelle" car le modèle n'a pas été entraîné sur des prompts dépassant 256k tokens. Il a averti que l'envoi de prompts plus longs entraînerait probablement des sorties de faible qualité.

Sur le subreddit r/LocalLlama, l'utilisateur Dr_Karminski a partagé sa déception envers Llama 4, comparant ses mauvaises performances à celles du modèle non-raisonnant V3 de DeepSeek sur des tâches comme la simulation de mouvements de balle dans un heptagone.

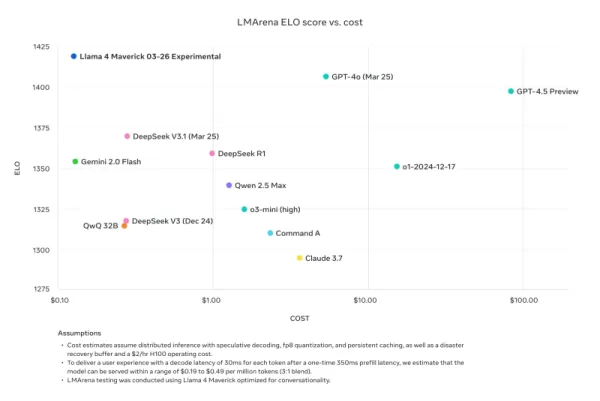

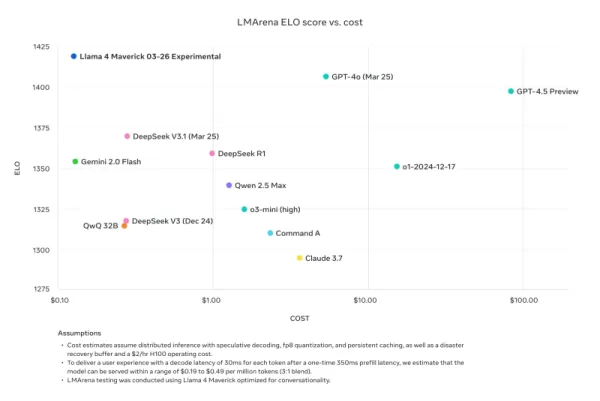

Nathan Lambert, ancien chercheur chez Meta et actuel scientifique senior chez AI2, a critiqué les comparaisons de benchmarks de Meta sur son blog Interconnects Substack. Il a souligné que le modèle Llama 4 Maverick utilisé dans les supports promotionnels de Meta était différent de celui publié publiquement, optimisé plutôt pour la conversation. Lambert a noté l'écart, disant : "Sournois. Les résultats ci-dessous sont faux, et c'est une grave offense à la communauté de Meta de ne pas publier le modèle utilisé pour leur grande campagne marketing." Il a ajouté que bien que le modèle promotionnel "nuise à la réputation technique de la sortie car son caractère est juvénile", le modèle réellement disponible sur d'autres plateformes était "assez intelligent et a un ton raisonnable."

Meta répond, niant l'entraînement sur les ensembles de tests et citant des bugs dans l'implémentation en raison d'un déploiement rapide

En réponse aux critiques et accusations, le vice-président et chef de GenAI de Meta, Ahmad Al-Dahle, s'est exprimé sur X pour répondre aux préoccupations. Il a exprimé son enthousiasme pour l'engagement de la communauté avec Llama 4 mais a reconnu des rapports de qualité incohérente à travers différents services. Il a attribué ces problèmes au déploiement rapide et au temps nécessaire pour stabiliser les implémentations publiques. Al-Dahle a fermement nié les allégations d'entraînement sur les ensembles de tests, soulignant que la qualité variable était due à des bugs d'implémentation plutôt qu'à une inconduite. Il a réaffirmé la croyance de Meta dans les avancées significatives des modèles Llama 4 et leur engagement à travailler avec la communauté pour réaliser leur potentiel.

Cependant, la réponse n'a pas suffi à apaiser les frustrations de la communauté, beaucoup signalant encore de mauvaises performances et exigeant plus de documentation technique sur les processus d'entraînement des modèles. Cette sortie a rencontré plus de problèmes que les versions précédentes de Llama, soulevant des questions sur son développement et son déploiement.

Le timing de cette sortie est notable, car elle suit le départ de Joelle Pineau, vice-présidente de la recherche chez Meta, qui a annoncé son départ sur LinkedIn la semaine dernière avec gratitude pour son temps dans l'entreprise. Pineau avait également promu la famille de modèles Llama 4 pendant le week-end.

Alors que Llama 4 continue d'être adopté par d'autres fournisseurs d'inférence avec des résultats mitigés, il est clair que la sortie initiale n'a pas été le succès espéré par Meta. La prochaine Meta LlamaCon, le 29 avril, qui sera le premier rassemblement pour les développeurs tiers de la famille de modèles, risque d'être un foyer de discussions et de débats. Nous suivrons de près les développements, alors restez à l'écoute.

Article connexe

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Mise à jour de l'IA d'Anthropic : Claude effectue désormais des recherches instantanées dans tout l'espace de travail de Google

La mise à jour majeure apportée aujourd'hui par Anthropic transforme Claude d'un assistant IA en ce que l'entreprise appelle un "véritable collaborateur virtuel", en introduisant des capacités de rech

Mise à jour de l'IA d'Anthropic : Claude effectue désormais des recherches instantanées dans tout l'espace de travail de Google

La mise à jour majeure apportée aujourd'hui par Anthropic transforme Claude d'un assistant IA en ce que l'entreprise appelle un "véritable collaborateur virtuel", en introduisant des capacités de rech

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

commentaires (8)

0/200

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

commentaires (8)

0/200

![JohnWilson]() JohnWilson

JohnWilson

26 août 2025 03:01:18 UTC+02:00

26 août 2025 03:01:18 UTC+02:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

21 août 2025 23:01:34 UTC+02:00

21 août 2025 23:01:34 UTC+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

12 août 2025 13:00:59 UTC+02:00

12 août 2025 13:00:59 UTC+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

24 avril 2025 21:47:05 UTC+02:00

24 avril 2025 21:47:05 UTC+02:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

24 avril 2025 13:01:02 UTC+02:00

24 avril 2025 13:01:02 UTC+02:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

24 avril 2025 01:06:55 UTC+02:00

24 avril 2025 01:06:55 UTC+02:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

Durant le week-end, Meta, la puissance derrière Facebook, Instagram, WhatsApp et Quest VR, a surpris tout le monde en dévoilant son dernier modèle de langage AI, Llama 4. Pas un, mais trois nouvelles versions ont été présentées, chacune dotée de capacités améliorées grâce à l'architecture "Mixture-of-Experts" et une nouvelle approche d'entraînement appelée MetaP, impliquant des hyperparamètres fixes. De plus, les trois modèles offrent des fenêtres de contexte étendues, leur permettant de traiter plus d'informations en une seule interaction.

Malgré l'enthousiasme de la sortie, la réaction de la communauté AI a été au mieux tiède. Samedi, Meta a rendu deux de ces modèles, Llama 4 Scout et Llama 4 Maverick, disponibles au téléchargement et à l'utilisation, mais la réponse a été loin d'être enthousiaste.

Llama 4 suscite confusion et critiques parmi les utilisateurs AI

Un message non vérifié sur le forum 1point3acres, une communauté populaire de langue chinoise en Amérique du Nord, a trouvé son chemin vers le subreddit r/LocalLlama sur Reddit. Le message, prétendument d'un chercheur de l'organisation GenAI de Meta, affirmait que Llama 4 sous-performait sur des benchmarks tiers internes. Il suggérait que la direction de Meta avait manipulé les résultats en mélangeant les ensembles de tests pendant l'entraînement pour atteindre divers indicateurs et présenter un résultat favorable. L'authenticité de cette affirmation a été accueillie avec scepticisme, et Meta n'a pas encore répondu aux demandes de VentureBeat.

Cependant, les doutes sur les performances de Llama 4 ne s'arrêtent pas là. Sur X, l'utilisateur @cto_junior a exprimé son incrédulité face aux performances du modèle, citant un test indépendant où Llama 4 Maverick a obtenu seulement 16 % sur le benchmark polyglot aider, qui teste les tâches de codage. Ce score est nettement inférieur à celui de modèles plus anciens de taille similaire comme DeepSeek V3 et Claude 3.7 Sonnet.

Le docteur en AI et auteur Andriy Burkov a également pris la parole sur X pour remettre en question la fenêtre de contexte annoncée de 10 millions de tokens pour Llama 4 Scout, déclarant qu'elle est "virtuelle" car le modèle n'a pas été entraîné sur des prompts dépassant 256k tokens. Il a averti que l'envoi de prompts plus longs entraînerait probablement des sorties de faible qualité.

Sur le subreddit r/LocalLlama, l'utilisateur Dr_Karminski a partagé sa déception envers Llama 4, comparant ses mauvaises performances à celles du modèle non-raisonnant V3 de DeepSeek sur des tâches comme la simulation de mouvements de balle dans un heptagone.

Nathan Lambert, ancien chercheur chez Meta et actuel scientifique senior chez AI2, a critiqué les comparaisons de benchmarks de Meta sur son blog Interconnects Substack. Il a souligné que le modèle Llama 4 Maverick utilisé dans les supports promotionnels de Meta était différent de celui publié publiquement, optimisé plutôt pour la conversation. Lambert a noté l'écart, disant : "Sournois. Les résultats ci-dessous sont faux, et c'est une grave offense à la communauté de Meta de ne pas publier le modèle utilisé pour leur grande campagne marketing." Il a ajouté que bien que le modèle promotionnel "nuise à la réputation technique de la sortie car son caractère est juvénile", le modèle réellement disponible sur d'autres plateformes était "assez intelligent et a un ton raisonnable."

Meta répond, niant l'entraînement sur les ensembles de tests et citant des bugs dans l'implémentation en raison d'un déploiement rapide

En réponse aux critiques et accusations, le vice-président et chef de GenAI de Meta, Ahmad Al-Dahle, s'est exprimé sur X pour répondre aux préoccupations. Il a exprimé son enthousiasme pour l'engagement de la communauté avec Llama 4 mais a reconnu des rapports de qualité incohérente à travers différents services. Il a attribué ces problèmes au déploiement rapide et au temps nécessaire pour stabiliser les implémentations publiques. Al-Dahle a fermement nié les allégations d'entraînement sur les ensembles de tests, soulignant que la qualité variable était due à des bugs d'implémentation plutôt qu'à une inconduite. Il a réaffirmé la croyance de Meta dans les avancées significatives des modèles Llama 4 et leur engagement à travailler avec la communauté pour réaliser leur potentiel.

Cependant, la réponse n'a pas suffi à apaiser les frustrations de la communauté, beaucoup signalant encore de mauvaises performances et exigeant plus de documentation technique sur les processus d'entraînement des modèles. Cette sortie a rencontré plus de problèmes que les versions précédentes de Llama, soulevant des questions sur son développement et son déploiement.

Le timing de cette sortie est notable, car elle suit le départ de Joelle Pineau, vice-présidente de la recherche chez Meta, qui a annoncé son départ sur LinkedIn la semaine dernière avec gratitude pour son temps dans l'entreprise. Pineau avait également promu la famille de modèles Llama 4 pendant le week-end.

Alors que Llama 4 continue d'être adopté par d'autres fournisseurs d'inférence avec des résultats mitigés, il est clair que la sortie initiale n'a pas été le succès espéré par Meta. La prochaine Meta LlamaCon, le 29 avril, qui sera le premier rassemblement pour les développeurs tiers de la famille de modèles, risque d'être un foyer de discussions et de débats. Nous suivrons de près les développements, alors restez à l'écoute.

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Mise à jour de l'IA d'Anthropic : Claude effectue désormais des recherches instantanées dans tout l'espace de travail de Google

La mise à jour majeure apportée aujourd'hui par Anthropic transforme Claude d'un assistant IA en ce que l'entreprise appelle un "véritable collaborateur virtuel", en introduisant des capacités de rech

Mise à jour de l'IA d'Anthropic : Claude effectue désormais des recherches instantanées dans tout l'espace de travail de Google

La mise à jour majeure apportée aujourd'hui par Anthropic transforme Claude d'un assistant IA en ce que l'entreprise appelle un "véritable collaborateur virtuel", en introduisant des capacités de rech

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

26 août 2025 03:01:18 UTC+02:00

26 août 2025 03:01:18 UTC+02:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

21 août 2025 23:01:34 UTC+02:00

21 août 2025 23:01:34 UTC+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

12 août 2025 13:00:59 UTC+02:00

12 août 2025 13:00:59 UTC+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

24 avril 2025 21:47:05 UTC+02:00

24 avril 2025 21:47:05 UTC+02:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

24 avril 2025 13:01:02 UTC+02:00

24 avril 2025 13:01:02 UTC+02:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

24 avril 2025 01:06:55 UTC+02:00

24 avril 2025 01:06:55 UTC+02:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0