메타는 LLAMA 4 릴리스를 방어하고 혼합 품질 보고서의 원인으로 버그를 인용합니다.

주말 동안 페이스북, 인스타그램, 왓츠앱, 퀘스트 VR을 이끄는 메타가 최신 AI 언어 모델 라마 4를 공개하며 모두를 놀라게 했다. 하나가 아닌 세 가지 새로운 버전이 소개되었으며, 각 버전은 "Mixture-of-Experts" 아키텍처와 고정 하이퍼파라미터를 사용하는 새로운 훈련 방식인 MetaP 덕분에 향상된 기능을 자랑한다. 더욱이, 세 모델 모두 광범위한 컨텍스트 윈도우를 제공하여 단일 상호작용에서 더 많은 정보를 처리할 수 있다.

출시의 흥분에도 불구하고 AI 커뮤니티의 반응은 미지근했다. 토요일, 메타는 라마 4 스카우트와 라마 4 매버릭 두 모델을 다운로드 및 사용 가능하게 했으나, 반응은 열광적이지 않았다.

라마 4, AI 사용자들 사이에서 혼란과 비판 불러일으켜

북아메리카의 인기 중국어 커뮤니티 1point3acres 포럼에 올라온 검증되지 않은 게시물이 레딧의 r/LocalLlama 서브레딧에 퍼졌다. 메타의 GenAI 조직 연구원으로 추정되는 이 게시물은 라마 4가 내부 타사 벤치마크에서 저조한 성능을 보였다고 주장했다. 이는 메타의 리더십이 사후 훈련 중 테스트 세트를 혼합하여 다양한 메트릭을 충족하고 유리한 결과를 제시했다고 암시했다. 이 주장의 진위 여부는 회의적인 반응을 얻었으며, 메타는 VentureBeat의 문의에 아직 응답하지 않았다.

하지만 라마 4의 성능에 대한 의구심은 여기서 그치지 않았다. X에서 사용자 @cto_junior는 모델의 성능에 대한 불신을 표하며, 라마 4 매버릭이 코딩 작업을 테스트하는 aider 폴리글롯 벤치마크에서 16%라는 낮은 점수를 기록했다고 밝혔다. 이 점수는 DeepSeek V3나 Claude 3.7 Sonnet 같은 비슷한 크기의 구형 모델보다 훨씬 낮다.

AI 박사이자 작가인 Andriy Burkov도 X에서 라마 4 스카우트의 광고된 1000만 토큰 컨텍스트 윈도우에 의문을 제기하며, 모델이 256k 토큰 이상의 프롬프트로 훈련되지 않았기 때문에 "가상"이라고 말했다. 그는 더 긴 프롬프트를 보내면 낮은 품질의 출력이 나올 가능성이 높다고 경고했다.

r/LocalLlama 서브레딧에서 사용자 Dr_Karminski는 라마 4의 성능에 실망을 표하며, 칠각형 내 공의 움직임을 시뮬레이션하는 작업에서 DeepSeek의 비추론 V3 모델과 비교해 저조한 성능을 보였다고 전했다.

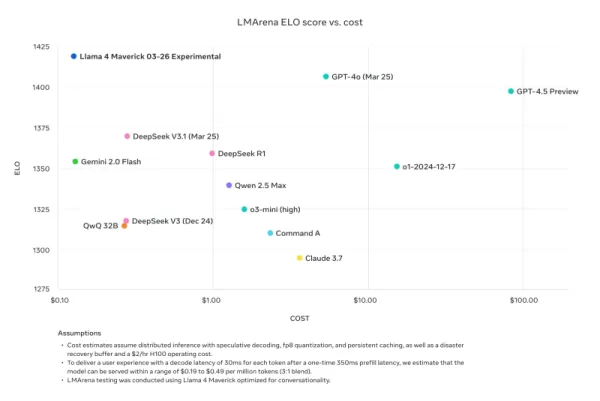

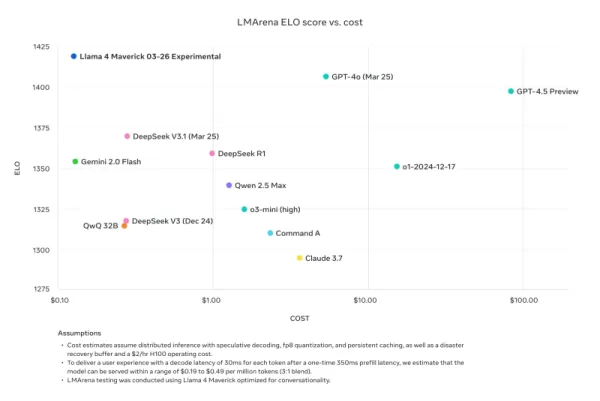

전 메타 연구원이자 현재 AI2의 선임 연구원인 Nathan Lambert는 자신의 Interconnects Substack 블로그에서 메타의 벤치마크 비교를 비판했다. 그는 메타의 홍보 자료에 사용된 라마 4 매버릭 모델이 공개된 모델과 달리 대화성에 최적화되었다고 지적했다. Lambert는 "교활하다. 아래 결과는 가짜이며, 메타 커뮤니티에 그들이 주요 마케팅에 사용한 모델을 공개하지 않은 것은 큰 실례다"라고 말했다. 그는 홍보 모델이 "출시의 기술적 명성을 떨어뜨리고 있으며 그 성격이 유치하다"고 덧붙였지만, 다른 플랫폼에서 사용 가능한 실제 모델은 "상당히 똑똑하고 합리적인 톤을 가지고 있다"고 했다.

메타, '테스트 세트 훈련' 부인하며 빠른 출시로 인한 구현 버그 지적

비판과 비난에 대응해 메타의 GenAI 부사장 겸 책임자인 Ahmad Al-Dahle는 X에서 우려를 해결했다. 그는 커뮤니티의 라마 4 참여에 열정을 표했지만, 다양한 서비스에서 일관되지 않은 품질 보고를 인정했다. 그는 이러한 문제를 빠른 출시와 공개 구현 안정화에 필요한 시간 때문이라고 설명했다. Al-Dahle는 테스트 세트 훈련 혐의를 단호히 부인하며, 가변 품질은 부정 행위가 아닌 구현 버그 때문이라고 강조했다. 그는 라마 4 모델의 상당한 발전에 대한 메타의 믿음과 커뮤니티와 협력해 잠재력을 실현하겠다는 약속을 재확인했다.

그러나 이 응답은 커뮤니티의 좌절을 진정시키지 못했으며, 많은 이들이 여전히 저조한 성능을 보고하고 모델 훈련 과정에 대한 더 많은 기술적 문서를 요구했다. 이번 출시는 이전 라마 버전보다 더 많은 문제를 겪으며 개발과 출시에 대한 의문을 불러일으켰다.

이번 출시 시기는 메타의 연구 부사장 Joelle Pineau가 지난주 LinkedIn에서 회사 떠남을 발표하며 감사의 마음을 전한 직후라는 점에서 주목할 만하다. Pineau는 주말 동안 라마 4 모델 제품군을 홍보하기도 했다.

라마 4가 다른 추론 제공자들에 의해 채택되며 혼합된 결과를 보이고 있는 가운데, 초기 출시가 메타가 기대했던 성공을 거두지 못한 것이 분명하다. 4월 29일에 열리는 최초의 모델 제품군 타사 개발자 모임인 메타 라마콘은 토론과 논쟁의 중심지가 될 가능성이 높다. 우리는 발전 상황을 면밀히 주시할 것이니, 계속 지켜봐 달라.

관련 기사

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

마누스, 웹 스크래핑을 위한 100개 이상의 에이전트를 갖춘 '와이드 리서치' AI 도구 출시

소비자와 전문 사용자 모두를 위한 선구적인 멀티 에이전트 오케스트레이션 플랫폼으로 주목받았던 중국의 AI 혁신 기업 마누스가 기존의 AI 연구 접근 방식에 도전하는 획기적인 기술 적용 사례를 공개했습니다.AI 기반 연구에 대한 재고몇 시간 동안 조사를 수행하여 상세한 보고서를 작성할 수 있는 전문 '딥 리서치' 에이전트를 개발한 OpenAI, Google,

마누스, 웹 스크래핑을 위한 100개 이상의 에이전트를 갖춘 '와이드 리서치' AI 도구 출시

소비자와 전문 사용자 모두를 위한 선구적인 멀티 에이전트 오케스트레이션 플랫폼으로 주목받았던 중국의 AI 혁신 기업 마누스가 기존의 AI 연구 접근 방식에 도전하는 획기적인 기술 적용 사례를 공개했습니다.AI 기반 연구에 대한 재고몇 시간 동안 조사를 수행하여 상세한 보고서를 작성할 수 있는 전문 '딥 리서치' 에이전트를 개발한 OpenAI, Google,

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

의견 (8)

0/200

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

의견 (8)

0/200

![JohnWilson]() JohnWilson

JohnWilson

2025년 8월 26일 오전 10시 1분 18초 GMT+09:00

2025년 8월 26일 오전 10시 1분 18초 GMT+09:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

2025년 8월 22일 오전 6시 1분 34초 GMT+09:00

2025년 8월 22일 오전 6시 1분 34초 GMT+09:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

2025년 8월 12일 오후 8시 0분 59초 GMT+09:00

2025년 8월 12일 오후 8시 0분 59초 GMT+09:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

2025년 4월 25일 오전 4시 47분 5초 GMT+09:00

2025년 4월 25일 오전 4시 47분 5초 GMT+09:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

2025년 4월 24일 오후 8시 1분 2초 GMT+09:00

2025년 4월 24일 오후 8시 1분 2초 GMT+09:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

2025년 4월 24일 오전 8시 6분 55초 GMT+09:00

2025년 4월 24일 오전 8시 6분 55초 GMT+09:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

주말 동안 페이스북, 인스타그램, 왓츠앱, 퀘스트 VR을 이끄는 메타가 최신 AI 언어 모델 라마 4를 공개하며 모두를 놀라게 했다. 하나가 아닌 세 가지 새로운 버전이 소개되었으며, 각 버전은 "Mixture-of-Experts" 아키텍처와 고정 하이퍼파라미터를 사용하는 새로운 훈련 방식인 MetaP 덕분에 향상된 기능을 자랑한다. 더욱이, 세 모델 모두 광범위한 컨텍스트 윈도우를 제공하여 단일 상호작용에서 더 많은 정보를 처리할 수 있다.

출시의 흥분에도 불구하고 AI 커뮤니티의 반응은 미지근했다. 토요일, 메타는 라마 4 스카우트와 라마 4 매버릭 두 모델을 다운로드 및 사용 가능하게 했으나, 반응은 열광적이지 않았다.

라마 4, AI 사용자들 사이에서 혼란과 비판 불러일으켜

북아메리카의 인기 중국어 커뮤니티 1point3acres 포럼에 올라온 검증되지 않은 게시물이 레딧의 r/LocalLlama 서브레딧에 퍼졌다. 메타의 GenAI 조직 연구원으로 추정되는 이 게시물은 라마 4가 내부 타사 벤치마크에서 저조한 성능을 보였다고 주장했다. 이는 메타의 리더십이 사후 훈련 중 테스트 세트를 혼합하여 다양한 메트릭을 충족하고 유리한 결과를 제시했다고 암시했다. 이 주장의 진위 여부는 회의적인 반응을 얻었으며, 메타는 VentureBeat의 문의에 아직 응답하지 않았다.

하지만 라마 4의 성능에 대한 의구심은 여기서 그치지 않았다. X에서 사용자 @cto_junior는 모델의 성능에 대한 불신을 표하며, 라마 4 매버릭이 코딩 작업을 테스트하는 aider 폴리글롯 벤치마크에서 16%라는 낮은 점수를 기록했다고 밝혔다. 이 점수는 DeepSeek V3나 Claude 3.7 Sonnet 같은 비슷한 크기의 구형 모델보다 훨씬 낮다.

AI 박사이자 작가인 Andriy Burkov도 X에서 라마 4 스카우트의 광고된 1000만 토큰 컨텍스트 윈도우에 의문을 제기하며, 모델이 256k 토큰 이상의 프롬프트로 훈련되지 않았기 때문에 "가상"이라고 말했다. 그는 더 긴 프롬프트를 보내면 낮은 품질의 출력이 나올 가능성이 높다고 경고했다.

r/LocalLlama 서브레딧에서 사용자 Dr_Karminski는 라마 4의 성능에 실망을 표하며, 칠각형 내 공의 움직임을 시뮬레이션하는 작업에서 DeepSeek의 비추론 V3 모델과 비교해 저조한 성능을 보였다고 전했다.

전 메타 연구원이자 현재 AI2의 선임 연구원인 Nathan Lambert는 자신의 Interconnects Substack 블로그에서 메타의 벤치마크 비교를 비판했다. 그는 메타의 홍보 자료에 사용된 라마 4 매버릭 모델이 공개된 모델과 달리 대화성에 최적화되었다고 지적했다. Lambert는 "교활하다. 아래 결과는 가짜이며, 메타 커뮤니티에 그들이 주요 마케팅에 사용한 모델을 공개하지 않은 것은 큰 실례다"라고 말했다. 그는 홍보 모델이 "출시의 기술적 명성을 떨어뜨리고 있으며 그 성격이 유치하다"고 덧붙였지만, 다른 플랫폼에서 사용 가능한 실제 모델은 "상당히 똑똑하고 합리적인 톤을 가지고 있다"고 했다.

메타, '테스트 세트 훈련' 부인하며 빠른 출시로 인한 구현 버그 지적

비판과 비난에 대응해 메타의 GenAI 부사장 겸 책임자인 Ahmad Al-Dahle는 X에서 우려를 해결했다. 그는 커뮤니티의 라마 4 참여에 열정을 표했지만, 다양한 서비스에서 일관되지 않은 품질 보고를 인정했다. 그는 이러한 문제를 빠른 출시와 공개 구현 안정화에 필요한 시간 때문이라고 설명했다. Al-Dahle는 테스트 세트 훈련 혐의를 단호히 부인하며, 가변 품질은 부정 행위가 아닌 구현 버그 때문이라고 강조했다. 그는 라마 4 모델의 상당한 발전에 대한 메타의 믿음과 커뮤니티와 협력해 잠재력을 실현하겠다는 약속을 재확인했다.

그러나 이 응답은 커뮤니티의 좌절을 진정시키지 못했으며, 많은 이들이 여전히 저조한 성능을 보고하고 모델 훈련 과정에 대한 더 많은 기술적 문서를 요구했다. 이번 출시는 이전 라마 버전보다 더 많은 문제를 겪으며 개발과 출시에 대한 의문을 불러일으켰다.

이번 출시 시기는 메타의 연구 부사장 Joelle Pineau가 지난주 LinkedIn에서 회사 떠남을 발표하며 감사의 마음을 전한 직후라는 점에서 주목할 만하다. Pineau는 주말 동안 라마 4 모델 제품군을 홍보하기도 했다.

라마 4가 다른 추론 제공자들에 의해 채택되며 혼합된 결과를 보이고 있는 가운데, 초기 출시가 메타가 기대했던 성공을 거두지 못한 것이 분명하다. 4월 29일에 열리는 최초의 모델 제품군 타사 개발자 모임인 메타 라마콘은 토론과 논쟁의 중심지가 될 가능성이 높다. 우리는 발전 상황을 면밀히 주시할 것이니, 계속 지켜봐 달라.

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

마누스, 웹 스크래핑을 위한 100개 이상의 에이전트를 갖춘 '와이드 리서치' AI 도구 출시

소비자와 전문 사용자 모두를 위한 선구적인 멀티 에이전트 오케스트레이션 플랫폼으로 주목받았던 중국의 AI 혁신 기업 마누스가 기존의 AI 연구 접근 방식에 도전하는 획기적인 기술 적용 사례를 공개했습니다.AI 기반 연구에 대한 재고몇 시간 동안 조사를 수행하여 상세한 보고서를 작성할 수 있는 전문 '딥 리서치' 에이전트를 개발한 OpenAI, Google,

마누스, 웹 스크래핑을 위한 100개 이상의 에이전트를 갖춘 '와이드 리서치' AI 도구 출시

소비자와 전문 사용자 모두를 위한 선구적인 멀티 에이전트 오케스트레이션 플랫폼으로 주목받았던 중국의 AI 혁신 기업 마누스가 기존의 AI 연구 접근 방식에 도전하는 획기적인 기술 적용 사례를 공개했습니다.AI 기반 연구에 대한 재고몇 시간 동안 조사를 수행하여 상세한 보고서를 작성할 수 있는 전문 '딥 리서치' 에이전트를 개발한 OpenAI, Google,

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

2025년 8월 26일 오전 10시 1분 18초 GMT+09:00

2025년 8월 26일 오전 10시 1분 18초 GMT+09:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

2025년 8월 22일 오전 6시 1분 34초 GMT+09:00

2025년 8월 22일 오전 6시 1분 34초 GMT+09:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

2025년 8월 12일 오후 8시 0분 59초 GMT+09:00

2025년 8월 12일 오후 8시 0분 59초 GMT+09:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

2025년 4월 25일 오전 4시 47분 5초 GMT+09:00

2025년 4월 25일 오전 4시 47분 5초 GMT+09:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

2025년 4월 24일 오후 8시 1분 2초 GMT+09:00

2025년 4월 24일 오후 8시 1분 2초 GMT+09:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

2025년 4월 24일 오전 8시 6분 55초 GMT+09:00

2025년 4월 24일 오전 8시 6분 55초 GMT+09:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0