MetaはLlama 4リリースを擁護し、バグを混合品質レポートの原因として引用します

週末、Facebook、Instagram、WhatsApp、Quest VRを運営するMetaは、最新のAI言語モデルLlama 4を公開し、驚きを与えた。3つの新バージョンが導入され、それぞれ「Mixture-of-Experts」アーキテクチャと固定ハイパーパラメータを用いた新しいトレーニング手法MetaPにより強化された機能を持つ。さらに、3つのモデルはすべて広範なコンテキストウィンドウを備え、1回の対話でより多くの情報を処理できる。

リリースの興奮にもかかわらず、AIコミュニティの反応はせいぜい冷淡だった。土曜日、MetaはLlama 4 ScoutとLlama 4 Maverickの2つのモデルをダウンロードと使用可能にしたが、反応は熱狂的とは程遠い。

Llama 4、AIユーザーの間で混乱と批判を呼ぶ

北米の中国語コミュニティで人気の1point3acresフォーラムに投稿された未検証の投稿が、Redditのr/LocalLlamaサブレディットに広まった。この投稿は、MetaのGenAI組織の研究者によるものとされ、Llama 4が内部のサードパーティベンチマークで期待外れだったと主張。Metaの経営陣がテストセットを混ぜて結果を操作し、好ましい結果を示したと示唆した。この主張の真偽は疑問視され、MetaはVentureBeatからの問い合わせにまだ回答していない。

しかし、Llama 4のパフォーマンスに対する疑問はそれだけに止まらなかった。Xでユーザー@cto_juniorは、Llama 4 Maverickがコーディングタスクをテストするaider polyglotベンチマークでわずか16%のスコアを記録した独立テストを引用し、モデルのパフォーマンスに疑問を呈した。このスコアは、DeepSeek V3やClaude 3.7 Sonnetといった同規模の旧モデルよりも大幅に低い。

AI博士で著者のAndriy BurkovもXで、Llama 4 Scoutの宣伝されている1000万トークンのコンテキストウィンドウが「仮想」だと指摘。モデルは256kトークンを超えるプロンプトでトレーニングされておらず、長いプロンプトを送ると低品質な出力になる可能性が高いと警告した。

r/LocalLlamaサブレディットでは、ユーザーDr_KarminskiがLlama 4の性能に失望を表明し、七角形内でのボールの動きをシミュレートするタスクでDeepSeekの非推論V3モデルと比較して劣ると述べた。

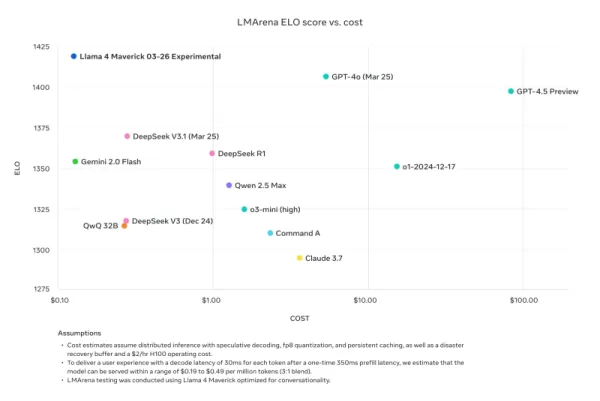

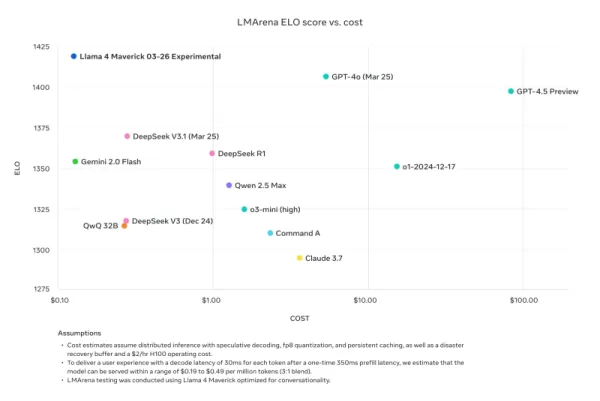

元Meta研究者で現在AI2のシニア研究者であるNathan Lambertは、自身のInterconnects SubstackブログでMetaのベンチマーク比較を批判。Metaのプロモーション資料で使用されたLlama 4 Maverickモデルは公開されたものとは異なり、会話向けに最適化されていたと指摘。「狡猾だ。以下の結果は偽物で、マーケティングのために使用したモデルを公開しないのはMetaコミュニティに対する重大な侮辱だ」と述べ、プロモーションモデルは「その性格が幼稚でリリースの技術的評判を損なっている」としつつ、他のプラットフォームで利用可能な実際のモデルは「かなり賢く、合理的なトーンを持っている」と付け加えた。

Meta、テストセットでのトレーニング否定と迅速な展開によるバグを理由に反論

批判と非難に対し、MetaのGenAI副社長兼責任者のAhmad Al-DahleはXで懸念に対応。Llama 4へのコミュニティの関与に熱意を示しつつ、異なるサービスでの品質のばらつきを認め、迅速な展開と公開実装の安定化に時間がかかるためだと説明。テストセットでのトレーニングの疑惑を強く否定し、品質の変動は不正ではなく実装バグによるものだと強調。MetaはLlama 4モデルの大きな進歩を信じ、コミュニティと協力してその可能性を実現する決意を再確認した。

しかし、この対応はコミュニティの不満を鎮めるには至らず、多くの人が依然として性能の低さを報告し、モデルのトレーニングプロセスに関する詳細な技術文書を求めている。このリリースは以前のLlamaバージョンよりも多くの問題に直面し、開発と展開に関する疑問を呼んでいる。

このリリースのタイミングは、Metaの研究副社長Joelle Pineauが先週LinkedInで退社を発表し、会社での時間に感謝を述べたことに続く注目すべきもの。Pineauは週末にLlama 4モデルファミリーを宣伝していた。

Llama 4が他の推論プロバイダーに採用される中、結果はまちまちで、Metaが期待した成功とは言えない。4月29日に開催されるMeta LlamaConは、モデルファミリーのサードパーティ開発者向け初の集会となり、議論と論争の場となるだろう。引き続き動向を注視するので、注目してほしい。

関連記事

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

AnthropicのAIアップグレード:クロードがグーグルのワークスペース全体を瞬時に検索するようになった

Anthropicの本日のメジャーアップグレードは、ClaudeをAIアシスタントから同社が「真のバーチャルコラボレーター」と呼ぶものへと変貌させ、画期的な自律的研究機能とシームレスなGoogle Workspace統合を導入しました。これらの進化により、クロードはますます混雑する企業向けAI生産性分野において、OpenAIやマイクロソフトに対抗する強力な競争相手となる。新しいリサーチ大国自律的な

AnthropicのAIアップグレード:クロードがグーグルのワークスペース全体を瞬時に検索するようになった

Anthropicの本日のメジャーアップグレードは、ClaudeをAIアシスタントから同社が「真のバーチャルコラボレーター」と呼ぶものへと変貌させ、画期的な自律的研究機能とシームレスなGoogle Workspace統合を導入しました。これらの進化により、クロードはますます混雑する企業向けAI生産性分野において、OpenAIやマイクロソフトに対抗する強力な競争相手となる。新しいリサーチ大国自律的な

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

コメント (8)

0/200

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

コメント (8)

0/200

![JohnWilson]() JohnWilson

JohnWilson

2025年8月26日 10:01:18 JST

2025年8月26日 10:01:18 JST

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

2025年8月22日 6:01:34 JST

2025年8月22日 6:01:34 JST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

2025年8月12日 20:00:59 JST

2025年8月12日 20:00:59 JST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

2025年4月25日 4:47:05 JST

2025年4月25日 4:47:05 JST

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

2025年4月24日 20:01:02 JST

2025年4月24日 20:01:02 JST

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

2025年4月24日 8:06:55 JST

2025年4月24日 8:06:55 JST

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

週末、Facebook、Instagram、WhatsApp、Quest VRを運営するMetaは、最新のAI言語モデルLlama 4を公開し、驚きを与えた。3つの新バージョンが導入され、それぞれ「Mixture-of-Experts」アーキテクチャと固定ハイパーパラメータを用いた新しいトレーニング手法MetaPにより強化された機能を持つ。さらに、3つのモデルはすべて広範なコンテキストウィンドウを備え、1回の対話でより多くの情報を処理できる。

リリースの興奮にもかかわらず、AIコミュニティの反応はせいぜい冷淡だった。土曜日、MetaはLlama 4 ScoutとLlama 4 Maverickの2つのモデルをダウンロードと使用可能にしたが、反応は熱狂的とは程遠い。

Llama 4、AIユーザーの間で混乱と批判を呼ぶ

北米の中国語コミュニティで人気の1point3acresフォーラムに投稿された未検証の投稿が、Redditのr/LocalLlamaサブレディットに広まった。この投稿は、MetaのGenAI組織の研究者によるものとされ、Llama 4が内部のサードパーティベンチマークで期待外れだったと主張。Metaの経営陣がテストセットを混ぜて結果を操作し、好ましい結果を示したと示唆した。この主張の真偽は疑問視され、MetaはVentureBeatからの問い合わせにまだ回答していない。

しかし、Llama 4のパフォーマンスに対する疑問はそれだけに止まらなかった。Xでユーザー@cto_juniorは、Llama 4 Maverickがコーディングタスクをテストするaider polyglotベンチマークでわずか16%のスコアを記録した独立テストを引用し、モデルのパフォーマンスに疑問を呈した。このスコアは、DeepSeek V3やClaude 3.7 Sonnetといった同規模の旧モデルよりも大幅に低い。

AI博士で著者のAndriy BurkovもXで、Llama 4 Scoutの宣伝されている1000万トークンのコンテキストウィンドウが「仮想」だと指摘。モデルは256kトークンを超えるプロンプトでトレーニングされておらず、長いプロンプトを送ると低品質な出力になる可能性が高いと警告した。

r/LocalLlamaサブレディットでは、ユーザーDr_KarminskiがLlama 4の性能に失望を表明し、七角形内でのボールの動きをシミュレートするタスクでDeepSeekの非推論V3モデルと比較して劣ると述べた。

元Meta研究者で現在AI2のシニア研究者であるNathan Lambertは、自身のInterconnects SubstackブログでMetaのベンチマーク比較を批判。Metaのプロモーション資料で使用されたLlama 4 Maverickモデルは公開されたものとは異なり、会話向けに最適化されていたと指摘。「狡猾だ。以下の結果は偽物で、マーケティングのために使用したモデルを公開しないのはMetaコミュニティに対する重大な侮辱だ」と述べ、プロモーションモデルは「その性格が幼稚でリリースの技術的評判を損なっている」としつつ、他のプラットフォームで利用可能な実際のモデルは「かなり賢く、合理的なトーンを持っている」と付け加えた。

Meta、テストセットでのトレーニング否定と迅速な展開によるバグを理由に反論

批判と非難に対し、MetaのGenAI副社長兼責任者のAhmad Al-DahleはXで懸念に対応。Llama 4へのコミュニティの関与に熱意を示しつつ、異なるサービスでの品質のばらつきを認め、迅速な展開と公開実装の安定化に時間がかかるためだと説明。テストセットでのトレーニングの疑惑を強く否定し、品質の変動は不正ではなく実装バグによるものだと強調。MetaはLlama 4モデルの大きな進歩を信じ、コミュニティと協力してその可能性を実現する決意を再確認した。

しかし、この対応はコミュニティの不満を鎮めるには至らず、多くの人が依然として性能の低さを報告し、モデルのトレーニングプロセスに関する詳細な技術文書を求めている。このリリースは以前のLlamaバージョンよりも多くの問題に直面し、開発と展開に関する疑問を呼んでいる。

このリリースのタイミングは、Metaの研究副社長Joelle Pineauが先週LinkedInで退社を発表し、会社での時間に感謝を述べたことに続く注目すべきもの。Pineauは週末にLlama 4モデルファミリーを宣伝していた。

Llama 4が他の推論プロバイダーに採用される中、結果はまちまちで、Metaが期待した成功とは言えない。4月29日に開催されるMeta LlamaConは、モデルファミリーのサードパーティ開発者向け初の集会となり、議論と論争の場となるだろう。引き続き動向を注視するので、注目してほしい。

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

AnthropicのAIアップグレード:クロードがグーグルのワークスペース全体を瞬時に検索するようになった

Anthropicの本日のメジャーアップグレードは、ClaudeをAIアシスタントから同社が「真のバーチャルコラボレーター」と呼ぶものへと変貌させ、画期的な自律的研究機能とシームレスなGoogle Workspace統合を導入しました。これらの進化により、クロードはますます混雑する企業向けAI生産性分野において、OpenAIやマイクロソフトに対抗する強力な競争相手となる。新しいリサーチ大国自律的な

AnthropicのAIアップグレード:クロードがグーグルのワークスペース全体を瞬時に検索するようになった

Anthropicの本日のメジャーアップグレードは、ClaudeをAIアシスタントから同社が「真のバーチャルコラボレーター」と呼ぶものへと変貌させ、画期的な自律的研究機能とシームレスなGoogle Workspace統合を導入しました。これらの進化により、クロードはますます混雑する企業向けAI生産性分野において、OpenAIやマイクロソフトに対抗する強力な競争相手となる。新しいリサーチ大国自律的な

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

2025年8月26日 10:01:18 JST

2025年8月26日 10:01:18 JST

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

2025年8月22日 6:01:34 JST

2025年8月22日 6:01:34 JST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

2025年8月12日 20:00:59 JST

2025年8月12日 20:00:59 JST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

2025年4月25日 4:47:05 JST

2025年4月25日 4:47:05 JST

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

2025年4月24日 20:01:02 JST

2025年4月24日 20:01:02 JST

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

2025年4月24日 8:06:55 JST

2025年4月24日 8:06:55 JST

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0