Meta defende a liberação do llama 4, cita bugs como causa de relatórios de qualidade mista

Durante o fim de semana, a Meta, a potência por trás do Facebook, Instagram, WhatsApp e Quest VR, surpreendeu a todos ao revelar seu mais recente modelo de linguagem de IA, o Llama 4. Não apenas um, mas três novas versões foram apresentadas, cada uma com capacidades aprimoradas graças à arquitetura "Mixture-of-Experts" e uma nova abordagem de treinamento chamada MetaP, que envolve hiperparâmetros fixos. Além disso, todos os três modelos vêm com janelas de contexto expansivas, permitindo que processem mais informações em uma única interação.

Apesar da empolgação com o lançamento, a reação da comunidade de IA tem sido, na melhor das hipóteses, morna. No sábado, a Meta disponibilizou dois desses modelos, Llama 4 Scout e Llama 4 Maverick, para download e uso, mas a resposta está longe de ser entusiástica.

Llama 4 Gera Confusão e Críticas Entre Usuários de IA

Uma postagem não verificada no fórum 1point3acres, uma comunidade popular em língua chinesa na América do Norte, chegou ao subreddit r/LocalLlama no Reddit. A postagem, supostamente de um pesquisador da organização GenAI da Meta, alegava que o Llama 4 teve desempenho inferior em benchmarks de terceiros internos. Sugeria que a liderança da Meta manipulou os resultados ao misturar conjuntos de testes durante o pós-treinamento para atender a várias métricas e apresentar um resultado favorável. A autenticidade dessa alegação foi recebida com ceticismo, e a Meta ainda não respondeu às perguntas da VentureBeat.

No entanto, as dúvidas sobre o desempenho do Llama 4 não pararam por aí. No X, o usuário @cto_junior expressou descrença no desempenho do modelo, citando um teste independente onde o Llama 4 Maverick obteve apenas 16% no benchmark poliglota aider, que testa tarefas de codificação. Essa pontuação é significativamente menor do que a de modelos mais antigos de tamanho semelhante, como DeepSeek V3 e Claude 3.7 Sonnet.

O doutor em IA e autor Andriy Burkov também usou o X para questionar a janela de contexto de 10 milhões de tokens anunciada para o Llama 4 Scout, afirmando que ela é "virtual" porque o modelo não foi treinado em prompts superiores a 256 mil tokens. Ele alertou que enviar prompts mais longos provavelmente resultaria em saídas de baixa qualidade.

No subreddit r/LocalLlama, o usuário Dr_Karminski compartilhou decepção com o Llama 4, comparando seu desempenho fraco ao do modelo V3 sem raciocínio da DeepSeek em tarefas como simular movimentos de bola dentro de um heptágono.

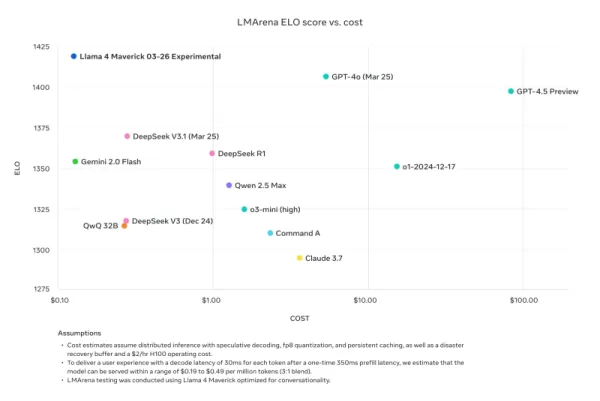

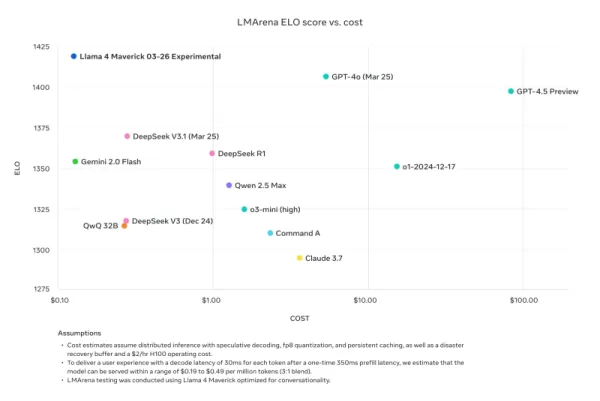

Nathan Lambert, ex-pesquisador da Meta e atual Cientista Sênior de Pesquisa na AI2, criticou as comparações de benchmark da Meta em seu blog Interconnects Substack. Ele apontou que o modelo Llama 4 Maverick usado nos materiais promocionais da Meta era diferente do lançado publicamente, otimizado em vez disso para conversacionalidade. Lambert destacou a discrepância, dizendo: "Furtivo. Os resultados abaixo são falsos, e é uma grande desfeita à comunidade da Meta não lançar o modelo que eles usaram para criar sua grande campanha de marketing." Ele acrescentou que, enquanto o modelo promocional estava "prejudicando a reputação técnica do lançamento porque seu caráter é juvenil," o modelo real disponível em outras plataformas era "bastante inteligente e tem um tom razoável."

Meta Responde, Negando 'Treinamento em Conjuntos de Teste' e Citando Bugs na Implementação Devido ao Lançamento Rápido

Em resposta às críticas e acusações, o vice-presidente e chefe de GenAI da Meta, Ahmad Al-Dahle, usou o X para abordar as preocupações. Ele expressou entusiasmo pelo envolvimento da comunidade com o Llama 4, mas reconheceu relatos de qualidade inconsistente em diferentes serviços. Ele atribuiu esses problemas ao lançamento rápido e ao tempo necessário para que as implementações públicas se estabilizem. Al-Dahle negou firmemente as alegações de treinamento em conjuntos de teste, enfatizando que a qualidade variável era devido a bugs de implementação, e não a qualquer má conduta. Ele reafirmou a crença da Meta nos avanços significativos dos modelos Llama 4 e seu compromisso em trabalhar com a comunidade para realizar seu potencial.

No entanto, a resposta fez pouco para acalmar as frustrações da comunidade, com muitos ainda relatando desempenho ruim e exigindo mais documentação técnica sobre os processos de treinamento dos modelos. Este lançamento enfrentou mais problemas do que as versões anteriores do Llama, levantando questões sobre seu desenvolvimento e implementação.

O momento deste lançamento é notável, pois segue a saída de Joelle Pineau, vice-presidente de Pesquisa da Meta, que anunciou sua saída no LinkedIn na última semana com gratidão por seu tempo na empresa. Pineau também promoveu a família de modelos Llama 4 durante o fim de semana.

À medida que o Llama 4 continua a ser adotado por outros provedores de inferência com resultados mistos, está claro que o lançamento inicial não foi o sucesso que a Meta poderia ter esperado. A próxima Meta LlamaCon, em 29 de abril, que será o primeiro encontro para desenvolvedores terceirizados da família de modelos, provavelmente será um foco de discussão e debate. Estaremos acompanhando de perto os desenvolvimentos, então fique atento.

Artigo relacionado

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Atualização de IA do Anthropic: Claude agora pesquisa todo o espaço de trabalho do Google instantaneamente

A grande atualização de hoje da Anthropic transforma o Claude de um assistente de IA no que a empresa chama de "verdadeiro colaborador virtual", introduzindo recursos inovadores de pesquisa autônoma e

Atualização de IA do Anthropic: Claude agora pesquisa todo o espaço de trabalho do Google instantaneamente

A grande atualização de hoje da Anthropic transforma o Claude de um assistente de IA no que a empresa chama de "verdadeiro colaborador virtual", introduzindo recursos inovadores de pesquisa autônoma e

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

Comentários (8)

0/200

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

Comentários (8)

0/200

![JohnWilson]() JohnWilson

JohnWilson

26 de Agosto de 2025 à18 02:01:18 WEST

26 de Agosto de 2025 à18 02:01:18 WEST

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

21 de Agosto de 2025 à34 22:01:34 WEST

21 de Agosto de 2025 à34 22:01:34 WEST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

12 de Agosto de 2025 à59 12:00:59 WEST

12 de Agosto de 2025 à59 12:00:59 WEST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

24 de Abril de 2025 à5 20:47:05 WEST

24 de Abril de 2025 à5 20:47:05 WEST

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

24 de Abril de 2025 à2 12:01:02 WEST

24 de Abril de 2025 à2 12:01:02 WEST

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

24 de Abril de 2025 à55 00:06:55 WEST

24 de Abril de 2025 à55 00:06:55 WEST

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

Durante o fim de semana, a Meta, a potência por trás do Facebook, Instagram, WhatsApp e Quest VR, surpreendeu a todos ao revelar seu mais recente modelo de linguagem de IA, o Llama 4. Não apenas um, mas três novas versões foram apresentadas, cada uma com capacidades aprimoradas graças à arquitetura "Mixture-of-Experts" e uma nova abordagem de treinamento chamada MetaP, que envolve hiperparâmetros fixos. Além disso, todos os três modelos vêm com janelas de contexto expansivas, permitindo que processem mais informações em uma única interação.

Apesar da empolgação com o lançamento, a reação da comunidade de IA tem sido, na melhor das hipóteses, morna. No sábado, a Meta disponibilizou dois desses modelos, Llama 4 Scout e Llama 4 Maverick, para download e uso, mas a resposta está longe de ser entusiástica.

Llama 4 Gera Confusão e Críticas Entre Usuários de IA

Uma postagem não verificada no fórum 1point3acres, uma comunidade popular em língua chinesa na América do Norte, chegou ao subreddit r/LocalLlama no Reddit. A postagem, supostamente de um pesquisador da organização GenAI da Meta, alegava que o Llama 4 teve desempenho inferior em benchmarks de terceiros internos. Sugeria que a liderança da Meta manipulou os resultados ao misturar conjuntos de testes durante o pós-treinamento para atender a várias métricas e apresentar um resultado favorável. A autenticidade dessa alegação foi recebida com ceticismo, e a Meta ainda não respondeu às perguntas da VentureBeat.

No entanto, as dúvidas sobre o desempenho do Llama 4 não pararam por aí. No X, o usuário @cto_junior expressou descrença no desempenho do modelo, citando um teste independente onde o Llama 4 Maverick obteve apenas 16% no benchmark poliglota aider, que testa tarefas de codificação. Essa pontuação é significativamente menor do que a de modelos mais antigos de tamanho semelhante, como DeepSeek V3 e Claude 3.7 Sonnet.

O doutor em IA e autor Andriy Burkov também usou o X para questionar a janela de contexto de 10 milhões de tokens anunciada para o Llama 4 Scout, afirmando que ela é "virtual" porque o modelo não foi treinado em prompts superiores a 256 mil tokens. Ele alertou que enviar prompts mais longos provavelmente resultaria em saídas de baixa qualidade.

No subreddit r/LocalLlama, o usuário Dr_Karminski compartilhou decepção com o Llama 4, comparando seu desempenho fraco ao do modelo V3 sem raciocínio da DeepSeek em tarefas como simular movimentos de bola dentro de um heptágono.

Nathan Lambert, ex-pesquisador da Meta e atual Cientista Sênior de Pesquisa na AI2, criticou as comparações de benchmark da Meta em seu blog Interconnects Substack. Ele apontou que o modelo Llama 4 Maverick usado nos materiais promocionais da Meta era diferente do lançado publicamente, otimizado em vez disso para conversacionalidade. Lambert destacou a discrepância, dizendo: "Furtivo. Os resultados abaixo são falsos, e é uma grande desfeita à comunidade da Meta não lançar o modelo que eles usaram para criar sua grande campanha de marketing." Ele acrescentou que, enquanto o modelo promocional estava "prejudicando a reputação técnica do lançamento porque seu caráter é juvenil," o modelo real disponível em outras plataformas era "bastante inteligente e tem um tom razoável."

Meta Responde, Negando 'Treinamento em Conjuntos de Teste' e Citando Bugs na Implementação Devido ao Lançamento Rápido

Em resposta às críticas e acusações, o vice-presidente e chefe de GenAI da Meta, Ahmad Al-Dahle, usou o X para abordar as preocupações. Ele expressou entusiasmo pelo envolvimento da comunidade com o Llama 4, mas reconheceu relatos de qualidade inconsistente em diferentes serviços. Ele atribuiu esses problemas ao lançamento rápido e ao tempo necessário para que as implementações públicas se estabilizem. Al-Dahle negou firmemente as alegações de treinamento em conjuntos de teste, enfatizando que a qualidade variável era devido a bugs de implementação, e não a qualquer má conduta. Ele reafirmou a crença da Meta nos avanços significativos dos modelos Llama 4 e seu compromisso em trabalhar com a comunidade para realizar seu potencial.

No entanto, a resposta fez pouco para acalmar as frustrações da comunidade, com muitos ainda relatando desempenho ruim e exigindo mais documentação técnica sobre os processos de treinamento dos modelos. Este lançamento enfrentou mais problemas do que as versões anteriores do Llama, levantando questões sobre seu desenvolvimento e implementação.

O momento deste lançamento é notável, pois segue a saída de Joelle Pineau, vice-presidente de Pesquisa da Meta, que anunciou sua saída no LinkedIn na última semana com gratidão por seu tempo na empresa. Pineau também promoveu a família de modelos Llama 4 durante o fim de semana.

À medida que o Llama 4 continua a ser adotado por outros provedores de inferência com resultados mistos, está claro que o lançamento inicial não foi o sucesso que a Meta poderia ter esperado. A próxima Meta LlamaCon, em 29 de abril, que será o primeiro encontro para desenvolvedores terceirizados da família de modelos, provavelmente será um foco de discussão e debate. Estaremos acompanhando de perto os desenvolvimentos, então fique atento.

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Atualização de IA do Anthropic: Claude agora pesquisa todo o espaço de trabalho do Google instantaneamente

A grande atualização de hoje da Anthropic transforma o Claude de um assistente de IA no que a empresa chama de "verdadeiro colaborador virtual", introduzindo recursos inovadores de pesquisa autônoma e

Atualização de IA do Anthropic: Claude agora pesquisa todo o espaço de trabalho do Google instantaneamente

A grande atualização de hoje da Anthropic transforma o Claude de um assistente de IA no que a empresa chama de "verdadeiro colaborador virtual", introduzindo recursos inovadores de pesquisa autônoma e

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

26 de Agosto de 2025 à18 02:01:18 WEST

26 de Agosto de 2025 à18 02:01:18 WEST

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

21 de Agosto de 2025 à34 22:01:34 WEST

21 de Agosto de 2025 à34 22:01:34 WEST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

12 de Agosto de 2025 à59 12:00:59 WEST

12 de Agosto de 2025 à59 12:00:59 WEST

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

24 de Abril de 2025 à5 20:47:05 WEST

24 de Abril de 2025 à5 20:47:05 WEST

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

24 de Abril de 2025 à2 12:01:02 WEST

24 de Abril de 2025 à2 12:01:02 WEST

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

24 de Abril de 2025 à55 00:06:55 WEST

24 de Abril de 2025 à55 00:06:55 WEST

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0