Meta Defiense Llama 4 Lanzamiento, cita errores como causa de informes de calidad mixta

Durante el fin de semana, Meta, la potencia detrás de Facebook, Instagram, WhatsApp y Quest VR, sorprendió a todos al presentar su último modelo de lenguaje de IA, Llama 4. No solo uno, sino tres nuevas versiones fueron introducidas, cada una con capacidades mejoradas gracias a la arquitectura "Mixture-of-Experts" y un nuevo enfoque de entrenamiento llamado MetaP, que implica hiperparámetros fijos. Además, todos los modelos vienen con ventanas de contexto expansivas, permitiéndoles procesar más información en una sola interacción.

A pesar de la emoción del lanzamiento, la reacción de la comunidad de IA ha sido, en el mejor de los casos, tibia. El sábado, Meta puso a disposición para descarga y uso dos de estos modelos, Llama 4 Scout y Llama 4 Maverick, pero la respuesta ha estado lejos de ser entusiasta.

Llama 4 Genera Confusión y Críticas Entre Usuarios de IA

Una publicación no verificada en el foro 1point3acres, una comunidad popular en chino en América del Norte, llegó al subreddit r/LocalLlama en Reddit. La publicación, supuestamente de un investigador de la organización GenAI de Meta, afirmaba que Llama 4 tuvo un desempeño inferior en pruebas internas de terceros. Sugería que el liderazgo de Meta manipuló los resultados mezclando conjuntos de pruebas durante el post-entrenamiento para cumplir con varias métricas y presentar un resultado favorable. La autenticidad de esta afirmación fue recibida con escepticismo, y Meta aún no ha respondido a las consultas de VentureBeat.

Sin embargo, las dudas sobre el rendimiento de Llama 4 no terminaron ahí. En X, el usuario @cto_junior expresó incredulidad sobre el rendimiento del modelo, citando una prueba independiente donde Llama 4 Maverick obtuvo solo un 16% en el benchmark aider polyglot, que evalúa tareas de codificación. Esta puntuación es significativamente menor que la de modelos más antiguos de tamaño similar como DeepSeek V3 y Claude 3.7 Sonnet.

El doctor en IA y autor Andriy Burkov también recurrió a X para cuestionar la ventana de contexto de 10 millones de tokens anunciada para Llama 4 Scout, afirmando que es "virtual" porque el modelo no fue entrenado con prompts más largos de 256k tokens. Advirtió que enviar prompts más largos probablemente resultaría en salidas de baja calidad.

En el subreddit r/LocalLlama, el usuario Dr_Karminski expresó decepción con Llama 4, comparando su pobre rendimiento con el modelo V3 sin razonamiento de DeepSeek en tareas como simular movimientos de pelotas dentro de un heptágono.

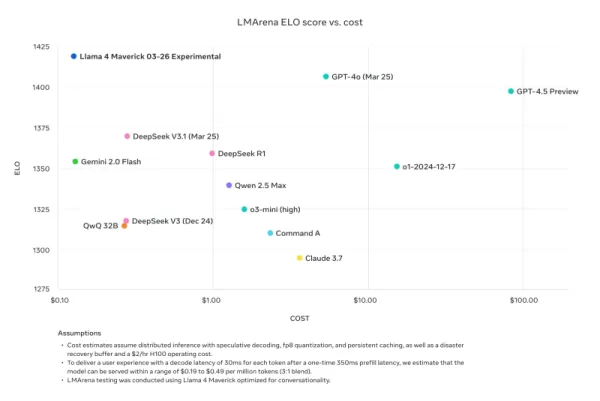

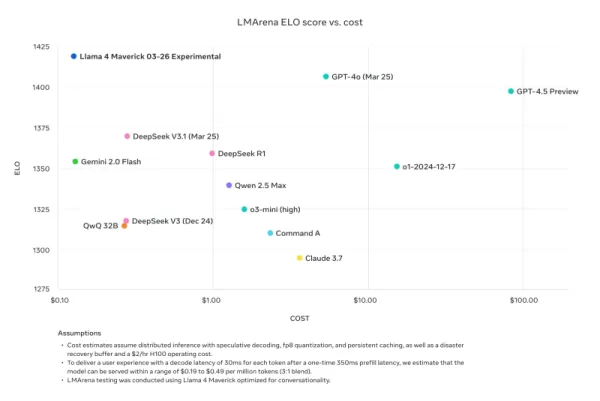

Nathan Lambert, exinvestigador de Meta y actual Científico Investigador Senior en AI2, criticó las comparaciones de benchmarks de Meta en su blog Interconnects Substack. Señaló que el modelo Llama 4 Maverick usado en los materiales promocionales de Meta era diferente al lanzado públicamente, optimizado en cambio para la conversacionalidad. Lambert notó la discrepancia, diciendo: "Astuto. Los resultados a continuación son falsos, y es un gran desaire a la comunidad de Meta no lanzar el modelo que usaron para crear su gran campaña de marketing." Añadió que mientras el modelo promocional estaba "dañando la reputación técnica del lanzamiento porque su carácter es juvenil," el modelo real disponible en otras plataformas era "bastante inteligente y tiene un tono razonable."

Meta Responde, Niega 'Entrenamiento en Conjuntos de Prueba' y Cita Errores en la Implementación Debido al Rápido Lanzamiento

En respuesta a las críticas y acusaciones, el VP y Jefe de GenAI de Meta, Ahmad Al-Dahle, recurrió a X para abordar las preocupaciones. Expresó entusiasmo por el compromiso de la comunidad con Llama 4, pero reconoció informes de calidad inconsistente en diferentes servicios. Atribuyó estos problemas al rápido lanzamiento y al tiempo necesario para que las implementaciones públicas se estabilicen. Al-Dahle negó firmemente las acusaciones de entrenamiento en conjuntos de prueba, enfatizando que la calidad variable se debía a errores de implementación en lugar de cualquier mala conducta. Reafirmó la creencia de Meta en los avances significativos de los modelos Llama 4 y su compromiso de trabajar con la comunidad para realizar su potencial.

Sin embargo, la respuesta hizo poco para calmar las frustraciones de la comunidad, con muchos aún reportando un rendimiento pobre y exigiendo más documentación técnica sobre los procesos de entrenamiento de los modelos. Este lanzamiento ha enfrentado más problemas que las versiones anteriores de Llama, generando preguntas sobre su desarrollo y lanzamiento.

El momento de este lanzamiento es notable, ya que sigue a la salida de Joelle Pineau, VP de Investigación de Meta, quien anunció su salida en LinkedIn la semana pasada con gratitud por su tiempo en la empresa. Pineau también había promocionado la familia de modelos Llama 4 durante el fin de semana.

A medida que Llama 4 sigue siendo adoptado por otros proveedores de inferencia con resultados mixtos, está claro que el lanzamiento inicial no ha sido el éxito que Meta podría haber esperado. La próxima Meta LlamaCon el 29 de abril, que será la primera reunión para desarrolladores de terceros de la familia de modelos, probablemente será un hervidero de discusión y debate. Estaremos atentos a los desarrollos, así que mantente informado.

Artículo relacionado

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Actualización de la IA de Anthropic: Claude ahora busca en todo el espacio de trabajo de Google al instante

La importante actualización de hoy de Anthropic transforma a Claude de un asistente de IA en lo que la empresa denomina un "verdadero colaborador virtual", introduciendo innovadoras capacidades de inv

Actualización de la IA de Anthropic: Claude ahora busca en todo el espacio de trabajo de Google al instante

La importante actualización de hoy de Anthropic transforma a Claude de un asistente de IA en lo que la empresa denomina un "verdadero colaborador virtual", introduciendo innovadoras capacidades de inv

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

comentario (8)

0/200

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

comentario (8)

0/200

![JohnWilson]() JohnWilson

JohnWilson

26 de agosto de 2025 03:01:18 GMT+02:00

26 de agosto de 2025 03:01:18 GMT+02:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

21 de agosto de 2025 23:01:34 GMT+02:00

21 de agosto de 2025 23:01:34 GMT+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

12 de agosto de 2025 13:00:59 GMT+02:00

12 de agosto de 2025 13:00:59 GMT+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

24 de abril de 2025 21:47:05 GMT+02:00

24 de abril de 2025 21:47:05 GMT+02:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

24 de abril de 2025 13:01:02 GMT+02:00

24 de abril de 2025 13:01:02 GMT+02:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

24 de abril de 2025 01:06:55 GMT+02:00

24 de abril de 2025 01:06:55 GMT+02:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

Durante el fin de semana, Meta, la potencia detrás de Facebook, Instagram, WhatsApp y Quest VR, sorprendió a todos al presentar su último modelo de lenguaje de IA, Llama 4. No solo uno, sino tres nuevas versiones fueron introducidas, cada una con capacidades mejoradas gracias a la arquitectura "Mixture-of-Experts" y un nuevo enfoque de entrenamiento llamado MetaP, que implica hiperparámetros fijos. Además, todos los modelos vienen con ventanas de contexto expansivas, permitiéndoles procesar más información en una sola interacción.

A pesar de la emoción del lanzamiento, la reacción de la comunidad de IA ha sido, en el mejor de los casos, tibia. El sábado, Meta puso a disposición para descarga y uso dos de estos modelos, Llama 4 Scout y Llama 4 Maverick, pero la respuesta ha estado lejos de ser entusiasta.

Llama 4 Genera Confusión y Críticas Entre Usuarios de IA

Una publicación no verificada en el foro 1point3acres, una comunidad popular en chino en América del Norte, llegó al subreddit r/LocalLlama en Reddit. La publicación, supuestamente de un investigador de la organización GenAI de Meta, afirmaba que Llama 4 tuvo un desempeño inferior en pruebas internas de terceros. Sugería que el liderazgo de Meta manipuló los resultados mezclando conjuntos de pruebas durante el post-entrenamiento para cumplir con varias métricas y presentar un resultado favorable. La autenticidad de esta afirmación fue recibida con escepticismo, y Meta aún no ha respondido a las consultas de VentureBeat.

Sin embargo, las dudas sobre el rendimiento de Llama 4 no terminaron ahí. En X, el usuario @cto_junior expresó incredulidad sobre el rendimiento del modelo, citando una prueba independiente donde Llama 4 Maverick obtuvo solo un 16% en el benchmark aider polyglot, que evalúa tareas de codificación. Esta puntuación es significativamente menor que la de modelos más antiguos de tamaño similar como DeepSeek V3 y Claude 3.7 Sonnet.

El doctor en IA y autor Andriy Burkov también recurrió a X para cuestionar la ventana de contexto de 10 millones de tokens anunciada para Llama 4 Scout, afirmando que es "virtual" porque el modelo no fue entrenado con prompts más largos de 256k tokens. Advirtió que enviar prompts más largos probablemente resultaría en salidas de baja calidad.

En el subreddit r/LocalLlama, el usuario Dr_Karminski expresó decepción con Llama 4, comparando su pobre rendimiento con el modelo V3 sin razonamiento de DeepSeek en tareas como simular movimientos de pelotas dentro de un heptágono.

Nathan Lambert, exinvestigador de Meta y actual Científico Investigador Senior en AI2, criticó las comparaciones de benchmarks de Meta en su blog Interconnects Substack. Señaló que el modelo Llama 4 Maverick usado en los materiales promocionales de Meta era diferente al lanzado públicamente, optimizado en cambio para la conversacionalidad. Lambert notó la discrepancia, diciendo: "Astuto. Los resultados a continuación son falsos, y es un gran desaire a la comunidad de Meta no lanzar el modelo que usaron para crear su gran campaña de marketing." Añadió que mientras el modelo promocional estaba "dañando la reputación técnica del lanzamiento porque su carácter es juvenil," el modelo real disponible en otras plataformas era "bastante inteligente y tiene un tono razonable."

Meta Responde, Niega 'Entrenamiento en Conjuntos de Prueba' y Cita Errores en la Implementación Debido al Rápido Lanzamiento

En respuesta a las críticas y acusaciones, el VP y Jefe de GenAI de Meta, Ahmad Al-Dahle, recurrió a X para abordar las preocupaciones. Expresó entusiasmo por el compromiso de la comunidad con Llama 4, pero reconoció informes de calidad inconsistente en diferentes servicios. Atribuyó estos problemas al rápido lanzamiento y al tiempo necesario para que las implementaciones públicas se estabilicen. Al-Dahle negó firmemente las acusaciones de entrenamiento en conjuntos de prueba, enfatizando que la calidad variable se debía a errores de implementación en lugar de cualquier mala conducta. Reafirmó la creencia de Meta en los avances significativos de los modelos Llama 4 y su compromiso de trabajar con la comunidad para realizar su potencial.

Sin embargo, la respuesta hizo poco para calmar las frustraciones de la comunidad, con muchos aún reportando un rendimiento pobre y exigiendo más documentación técnica sobre los procesos de entrenamiento de los modelos. Este lanzamiento ha enfrentado más problemas que las versiones anteriores de Llama, generando preguntas sobre su desarrollo y lanzamiento.

El momento de este lanzamiento es notable, ya que sigue a la salida de Joelle Pineau, VP de Investigación de Meta, quien anunció su salida en LinkedIn la semana pasada con gratitud por su tiempo en la empresa. Pineau también había promocionado la familia de modelos Llama 4 durante el fin de semana.

A medida que Llama 4 sigue siendo adoptado por otros proveedores de inferencia con resultados mixtos, está claro que el lanzamiento inicial no ha sido el éxito que Meta podría haber esperado. La próxima Meta LlamaCon el 29 de abril, que será la primera reunión para desarrolladores de terceros de la familia de modelos, probablemente será un hervidero de discusión y debate. Estaremos atentos a los desarrollos, así que mantente informado.

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Actualización de la IA de Anthropic: Claude ahora busca en todo el espacio de trabajo de Google al instante

La importante actualización de hoy de Anthropic transforma a Claude de un asistente de IA en lo que la empresa denomina un "verdadero colaborador virtual", introduciendo innovadoras capacidades de inv

Actualización de la IA de Anthropic: Claude ahora busca en todo el espacio de trabajo de Google al instante

La importante actualización de hoy de Anthropic transforma a Claude de un asistente de IA en lo que la empresa denomina un "verdadero colaborador virtual", introduciendo innovadoras capacidades de inv

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

26 de agosto de 2025 03:01:18 GMT+02:00

26 de agosto de 2025 03:01:18 GMT+02:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

21 de agosto de 2025 23:01:34 GMT+02:00

21 de agosto de 2025 23:01:34 GMT+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

12 de agosto de 2025 13:00:59 GMT+02:00

12 de agosto de 2025 13:00:59 GMT+02:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

24 de abril de 2025 21:47:05 GMT+02:00

24 de abril de 2025 21:47:05 GMT+02:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

24 de abril de 2025 13:01:02 GMT+02:00

24 de abril de 2025 13:01:02 GMT+02:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

24 de abril de 2025 01:06:55 GMT+02:00

24 de abril de 2025 01:06:55 GMT+02:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0