Meta защищает релиз Llama 4, цитирует ошибки в качестве причины отчетов о смешанных качествах

В выходные Meta, компания, стоящая за Facebook, Instagram, WhatsApp и Quest VR, удивила всех, представив свою последнюю модель искусственного интеллекта Llama 4. Было представлено не одна, а три новых версии, каждая из которых обладает улучшенными возможностями благодаря архитектуре "Mixture-of-Experts" и новому подходу к обучению под названием MetaP, который включает фиксированные гиперпараметры. Более того, все три модели имеют расширенные контекстные окна, что позволяет им обрабатывать больше информации за одно взаимодействие.

Несмотря на ажиотаж вокруг выпуска, реакция сообщества ИИ была в лучшем случае прохладной. В субботу Meta сделала две из этих моделей, Llama 4 Scout и Llama 4 Maverick, доступными для загрузки и использования, но отклик был далеко не восторженным.

Llama 4 вызывает недоумение и критику среди пользователей ИИ

Непроверенный пост на форуме 1point3acres, популярном китайскоязычном сообществе в Северной Америке, попал на сабреддит r/LocalLlama в Reddit. Пост, предположительно от исследователя из организации Meta’s GenAI, утверждал, что Llama 4 показала низкие результаты на внутренних тестах третьих сторон. В нем говорилось, что руководство Meta манипулировало результатами, смешивая тестовые наборы во время пост-обучения, чтобы соответствовать различным метрикам и представить благоприятный результат. Подлинность этого утверждения вызвала скептицизм, и Meta пока не ответила на запросы VentureBeat.

Однако сомнения в производительности Llama 4 на этом не закончились. В X пользователь @cto_junior выразил недоверие к производительности модели, ссылаясь на независимый тест, в котором Llama 4 Maverick набрала всего 16% в тесте aider polyglot benchmark, который проверяет задачи по программированию. Этот результат значительно ниже, чем у более старых моделей аналогичного размера, таких как DeepSeek V3 и Claude 3.7 Sonnet.

Доктор философии в области ИИ и автор Андрий Бурков также в X усомнился в заявленном 10-миллионном токенном контекстном окне для Llama 4 Scout, заявив, что оно "виртуальное", поскольку модель не обучалась на промптах длиннее 256 тысяч токенов. Он предупредил, что отправка более длинных промптов, скорее всего, приведет к низкокачественным результатам.

На сабреддите r/LocalLlama пользователь Dr_Karminski выразил разочарование в Llama 4, сравнивая ее низкую производительность с моделью DeepSeek V3 без рассуждений в задачах, таких как симуляция движения шара в гептагоне.

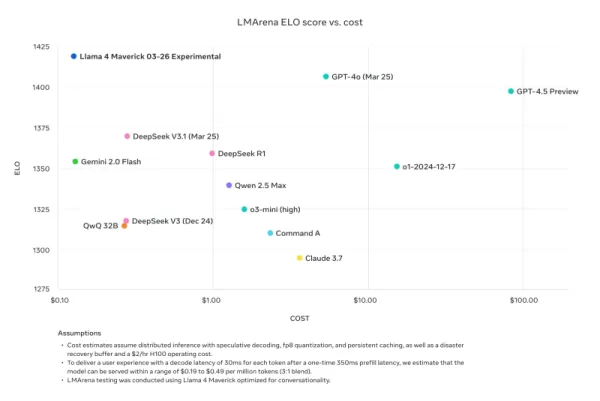

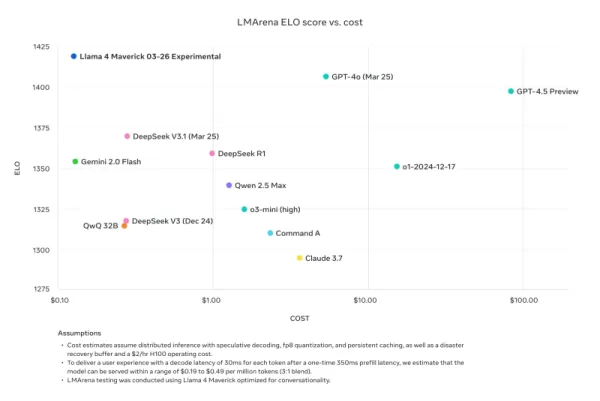

Натан Ламберт, бывший исследователь Meta и текущий старший научный сотрудник AI2, раскритиковал сравнения Meta с бенчмарками в своем блоге Interconnects Substack. Он указал, что модель Llama 4 Maverick, использованная в рекламных материалах Meta, отличается от той, что была публично выпущена, и была оптимизирована для разговорного стиля. Ламберт отметил это несоответствие, сказав: "Хитро. Результаты ниже фальшивые, и это серьезное пренебрежение к сообществу Meta, не выпустив модель, которую они использовали для своей крупной маркетинговой кампании." Он добавил, что, хотя рекламная модель "подрывает техническую репутацию релиза из-за своего инфантильного характера", реальная модель, доступная на других платформах, "довольно умная и имеет разумный тон."

Meta отвечает, отрицая "обучение на тестовых наборах" и ссылаясь на ошибки в реализации из-за быстрого выпуска

В ответ на критику и обвинения вице-президент и глава GenAI Meta Ахмад Аль-Дахле в X обратился к сообществу, чтобы развеять опасения. Он выразил энтузиазм по поводу вовлеченности сообщества в Llama 4, но признал сообщения о нестабильном качестве на разных сервисах. Он объяснил эти проблемы быстрым выпуском и временем, необходимым для стабилизации публичных реализаций. Аль-Дахле категорически опроверг обвинения в обучении на тестовых наборах, подчеркнув, что переменное качество связано с ошибками в реализации, а не с какими-либо нарушениями. Он подтвердил убежденность Meta в значительных достижениях моделей Llama 4 и их приверженность работе с сообществом для реализации их потенциала.

Однако этот ответ мало успокоил разочарование сообщества, многие по-прежнему сообщают о низкой производительности и требуют больше технической документации о процессах обучения моделей. Этот релиз столкнулся с большим количеством проблем, чем предыдущие версии Llama, что вызывает вопросы о его разработке и выпуске.

Время выпуска примечательно, поскольку оно последовало за уходом Джоэль Пино, вице-президента Meta по исследованиям, которая на прошлой неделе объявила о своем уходе в LinkedIn с благодарностью за время, проведенное в компании. Пино также продвигала семейство моделей Llama 4 в выходные.

Поскольку Llama 4 продолжает внедряться другими провайдерами с неоднозначными результатами, очевидно, что первоначальный релиз не стал тем успехом, на который могла надеяться Meta. Предстоящая конференция Meta LlamaCon 29 апреля, которая станет первым собранием для сторонних разработчиков семейства моделей, вероятно, будет полна обсуждений и споров. Мы будем внимательно следить за развитием событий, так что оставайтесь на связи.

Связанная статья

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Модернизация искусственного интеллекта Anthropic: Клод теперь мгновенно ищет все рабочее пространство Google

Сегодняшнее обновление от Anthropic превращает Claude из ИИ-ассистента в то, что компания называет "настоящим виртуальным сотрудником", предоставляя революционные возможности автономного исследования

Модернизация искусственного интеллекта Anthropic: Клод теперь мгновенно ищет все рабочее пространство Google

Сегодняшнее обновление от Anthropic превращает Claude из ИИ-ассистента в то, что компания называет "настоящим виртуальным сотрудником", предоставляя революционные возможности автономного исследования

ИИ Alibaba "ZeroSearch" сокращает расходы на обучение на 88% благодаря автономному обучению

ZeroSearch от Alibaba: Изменение эффективности обучения ИИИсследователи Alibaba Group разработали революционный метод обучения систем искусственного интеллекта поиску информации в обход дорогостоящих

Комментарии (8)

ИИ Alibaba "ZeroSearch" сокращает расходы на обучение на 88% благодаря автономному обучению

ZeroSearch от Alibaba: Изменение эффективности обучения ИИИсследователи Alibaba Group разработали революционный метод обучения систем искусственного интеллекта поиску информации в обход дорогостоящих

Комментарии (8)

![JohnWilson]() JohnWilson

JohnWilson

26 августа 2025 г., 4:01:18 GMT+03:00

26 августа 2025 г., 4:01:18 GMT+03:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

22 августа 2025 г., 0:01:34 GMT+03:00

22 августа 2025 г., 0:01:34 GMT+03:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

12 августа 2025 г., 14:00:59 GMT+03:00

12 августа 2025 г., 14:00:59 GMT+03:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

24 апреля 2025 г., 22:47:05 GMT+03:00

24 апреля 2025 г., 22:47:05 GMT+03:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

24 апреля 2025 г., 14:01:02 GMT+03:00

24 апреля 2025 г., 14:01:02 GMT+03:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

24 апреля 2025 г., 2:06:55 GMT+03:00

24 апреля 2025 г., 2:06:55 GMT+03:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

В выходные Meta, компания, стоящая за Facebook, Instagram, WhatsApp и Quest VR, удивила всех, представив свою последнюю модель искусственного интеллекта Llama 4. Было представлено не одна, а три новых версии, каждая из которых обладает улучшенными возможностями благодаря архитектуре "Mixture-of-Experts" и новому подходу к обучению под названием MetaP, который включает фиксированные гиперпараметры. Более того, все три модели имеют расширенные контекстные окна, что позволяет им обрабатывать больше информации за одно взаимодействие.

Несмотря на ажиотаж вокруг выпуска, реакция сообщества ИИ была в лучшем случае прохладной. В субботу Meta сделала две из этих моделей, Llama 4 Scout и Llama 4 Maverick, доступными для загрузки и использования, но отклик был далеко не восторженным.

Llama 4 вызывает недоумение и критику среди пользователей ИИ

Непроверенный пост на форуме 1point3acres, популярном китайскоязычном сообществе в Северной Америке, попал на сабреддит r/LocalLlama в Reddit. Пост, предположительно от исследователя из организации Meta’s GenAI, утверждал, что Llama 4 показала низкие результаты на внутренних тестах третьих сторон. В нем говорилось, что руководство Meta манипулировало результатами, смешивая тестовые наборы во время пост-обучения, чтобы соответствовать различным метрикам и представить благоприятный результат. Подлинность этого утверждения вызвала скептицизм, и Meta пока не ответила на запросы VentureBeat.

Однако сомнения в производительности Llama 4 на этом не закончились. В X пользователь @cto_junior выразил недоверие к производительности модели, ссылаясь на независимый тест, в котором Llama 4 Maverick набрала всего 16% в тесте aider polyglot benchmark, который проверяет задачи по программированию. Этот результат значительно ниже, чем у более старых моделей аналогичного размера, таких как DeepSeek V3 и Claude 3.7 Sonnet.

Доктор философии в области ИИ и автор Андрий Бурков также в X усомнился в заявленном 10-миллионном токенном контекстном окне для Llama 4 Scout, заявив, что оно "виртуальное", поскольку модель не обучалась на промптах длиннее 256 тысяч токенов. Он предупредил, что отправка более длинных промптов, скорее всего, приведет к низкокачественным результатам.

На сабреддите r/LocalLlama пользователь Dr_Karminski выразил разочарование в Llama 4, сравнивая ее низкую производительность с моделью DeepSeek V3 без рассуждений в задачах, таких как симуляция движения шара в гептагоне.

Натан Ламберт, бывший исследователь Meta и текущий старший научный сотрудник AI2, раскритиковал сравнения Meta с бенчмарками в своем блоге Interconnects Substack. Он указал, что модель Llama 4 Maverick, использованная в рекламных материалах Meta, отличается от той, что была публично выпущена, и была оптимизирована для разговорного стиля. Ламберт отметил это несоответствие, сказав: "Хитро. Результаты ниже фальшивые, и это серьезное пренебрежение к сообществу Meta, не выпустив модель, которую они использовали для своей крупной маркетинговой кампании." Он добавил, что, хотя рекламная модель "подрывает техническую репутацию релиза из-за своего инфантильного характера", реальная модель, доступная на других платформах, "довольно умная и имеет разумный тон."

Meta отвечает, отрицая "обучение на тестовых наборах" и ссылаясь на ошибки в реализации из-за быстрого выпуска

В ответ на критику и обвинения вице-президент и глава GenAI Meta Ахмад Аль-Дахле в X обратился к сообществу, чтобы развеять опасения. Он выразил энтузиазм по поводу вовлеченности сообщества в Llama 4, но признал сообщения о нестабильном качестве на разных сервисах. Он объяснил эти проблемы быстрым выпуском и временем, необходимым для стабилизации публичных реализаций. Аль-Дахле категорически опроверг обвинения в обучении на тестовых наборах, подчеркнув, что переменное качество связано с ошибками в реализации, а не с какими-либо нарушениями. Он подтвердил убежденность Meta в значительных достижениях моделей Llama 4 и их приверженность работе с сообществом для реализации их потенциала.

Однако этот ответ мало успокоил разочарование сообщества, многие по-прежнему сообщают о низкой производительности и требуют больше технической документации о процессах обучения моделей. Этот релиз столкнулся с большим количеством проблем, чем предыдущие версии Llama, что вызывает вопросы о его разработке и выпуске.

Время выпуска примечательно, поскольку оно последовало за уходом Джоэль Пино, вице-президента Meta по исследованиям, которая на прошлой неделе объявила о своем уходе в LinkedIn с благодарностью за время, проведенное в компании. Пино также продвигала семейство моделей Llama 4 в выходные.

Поскольку Llama 4 продолжает внедряться другими провайдерами с неоднозначными результатами, очевидно, что первоначальный релиз не стал тем успехом, на который могла надеяться Meta. Предстоящая конференция Meta LlamaCon 29 апреля, которая станет первым собранием для сторонних разработчиков семейства моделей, вероятно, будет полна обсуждений и споров. Мы будем внимательно следить за развитием событий, так что оставайтесь на связи.

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Модернизация искусственного интеллекта Anthropic: Клод теперь мгновенно ищет все рабочее пространство Google

Сегодняшнее обновление от Anthropic превращает Claude из ИИ-ассистента в то, что компания называет "настоящим виртуальным сотрудником", предоставляя революционные возможности автономного исследования

Модернизация искусственного интеллекта Anthropic: Клод теперь мгновенно ищет все рабочее пространство Google

Сегодняшнее обновление от Anthropic превращает Claude из ИИ-ассистента в то, что компания называет "настоящим виртуальным сотрудником", предоставляя революционные возможности автономного исследования

ИИ Alibaba "ZeroSearch" сокращает расходы на обучение на 88% благодаря автономному обучению

ZeroSearch от Alibaba: Изменение эффективности обучения ИИИсследователи Alibaba Group разработали революционный метод обучения систем искусственного интеллекта поиску информации в обход дорогостоящих

ИИ Alibaba "ZeroSearch" сокращает расходы на обучение на 88% благодаря автономному обучению

ZeroSearch от Alibaba: Изменение эффективности обучения ИИИсследователи Alibaba Group разработали революционный метод обучения систем искусственного интеллекта поиску информации в обход дорогостоящих

26 августа 2025 г., 4:01:18 GMT+03:00

26 августа 2025 г., 4:01:18 GMT+03:00

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

22 августа 2025 г., 0:01:34 GMT+03:00

22 августа 2025 г., 0:01:34 GMT+03:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

12 августа 2025 г., 14:00:59 GMT+03:00

12 августа 2025 г., 14:00:59 GMT+03:00

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

24 апреля 2025 г., 22:47:05 GMT+03:00

24 апреля 2025 г., 22:47:05 GMT+03:00

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

24 апреля 2025 г., 14:01:02 GMT+03:00

24 апреля 2025 г., 14:01:02 GMT+03:00

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

24 апреля 2025 г., 2:06:55 GMT+03:00

24 апреля 2025 г., 2:06:55 GMT+03:00

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0