Meta verteidigt LLAMA 4 Release, zitiert Fehler als Ursache für Berichte mit gemischter Qualität

Am Wochenende überraschte Meta, das Kraftpaket hinter Facebook, Instagram, WhatsApp und Quest VR, alle mit der Vorstellung ihres neuesten KI-Sprachmodells, Llama 4. Nicht nur eines, sondern drei neue Versionen wurden eingeführt, jede mit verbesserten Fähigkeiten dank der "Mixture-of-Experts"-Architektur und einem neuartigen Trainingsansatz namens MetaP, der feste Hyperparameter verwendet. Darüber hinaus verfügen alle drei Modelle über erweiterte Kontextfenster, die es ihnen ermöglichen, mehr Informationen in einer einzigen Interaktion zu verarbeiten.

Trotz der Aufregung um die Veröffentlichung war die Reaktion der KI-Community bestenfalls verhalten. Am Samstag stellte Meta zwei dieser Modelle, Llama 4 Scout und Llama 4 Maverick, zum Download und zur Nutzung bereit, aber die Resonanz war alles andere als enthusiastisch.

Llama 4 löst Verwirrung und Kritik unter KI-Nutzern aus

Ein unbestätigter Beitrag im 1point3acres-Forum, einer beliebten chinesischsprachigen Community in Nordamerika, fand seinen Weg in das r/LocalLlama-Subreddit auf Reddit. Der Beitrag, angeblich von einem Forscher der GenAI-Organisation von Meta, behauptete, dass Llama 4 bei internen Benchmarks von Drittanbietern schlecht abgeschnitten habe. Es wurde angedeutet, dass die Führung von Meta die Ergebnisse manipuliert habe, indem sie Testsets während des Post-Trainings vermischte, um verschiedene Metriken zu erfüllen und ein positives Ergebnis zu präsentieren. Die Authentizität dieser Behauptung wurde mit Skepsis aufgenommen, und Meta hat bisher nicht auf Anfragen von VentureBeat reagiert.

Doch die Zweifel an der Leistung von Llama 4 hörten damit nicht auf. Auf X äußerte der Nutzer @cto_junior Unglauben über die Leistung des Modells und verwies auf einen unabhängigen Test, bei dem Llama 4 Maverick im aider-Polyglot-Benchmark, der Programmieraufgaben testet, nur 16 % erreichte. Dieser Wert liegt deutlich unter dem älterer, ähnlich großer Modelle wie DeepSeek V3 und Claude 3.7 Sonnet.

KI-Doktor und Autor Andriy Burkov nutzte ebenfalls X, um das beworbene 10-Millionen-Token-Kontextfenster von Llama 4 Scout in Frage zu stellen und erklärte, es sei "virtuell", da das Modell nicht mit Prompts trainiert wurde, die länger als 256k Token sind. Er warnte, dass längere Prompts wahrscheinlich zu minderwertigen Ergebnissen führen würden.

Im r/LocalLlama-Subreddit äußerte der Nutzer Dr_Karminski Enttäuschung über Llama 4 und verglich dessen schlechte Leistung mit dem nicht-räsonierenden V3-Modell von DeepSeek bei Aufgaben wie der Simulation von Ballbewegungen in einem Heptagon.

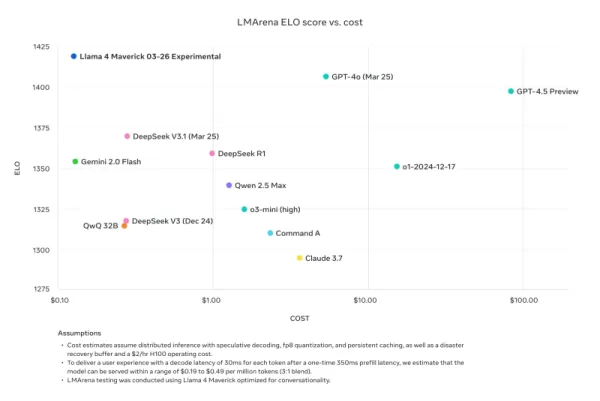

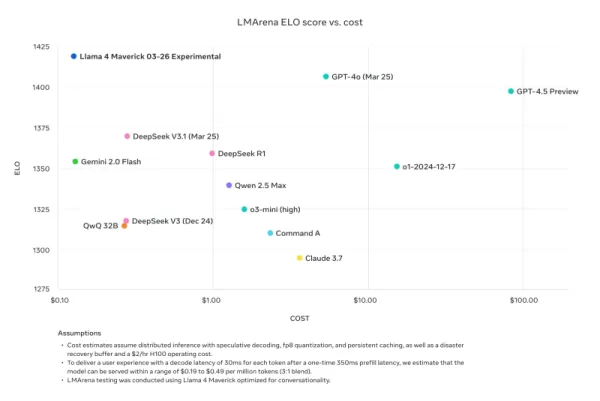

Nathan Lambert, ein ehemaliger Meta-Forscher und aktueller Senior Research Scientist bei AI2, kritisierte Metas Benchmark-Vergleiche in seinem Interconnects-Substack-Blog. Er wies darauf hin, dass das in Metas Werbematerialien verwendete Llama 4 Maverick-Modell nicht dasselbe war wie das öffentlich freigegebene, sondern für Konversation optimiert wurde. Lambert bemerkte den Widerspruch und sagte: „Hinterlistig. Die untenstehenden Ergebnisse sind gefälscht, und es ist ein großer Affront gegen die Community von Meta, nicht das Modell zu veröffentlichen, das sie für ihre große Marketingkampagne verwendet haben.“ Er fügte hinzu, dass das beworbene Modell „den technischen Ruf der Veröffentlichung ruiniert, weil sein Charakter jugendlich ist“, während das tatsächlich auf anderen Plattformen verfügbare Modell „ziemlich klug ist und einen angemessenen Ton hat“.

Meta reagiert, bestreitet „Training mit Testsets“ und verweist auf Fehler in der Implementierung aufgrund der schnellen Einführung

Als Reaktion auf die Kritik und Anschuldigungen ging Ahmad Al-Dahle, Vizepräsident und Leiter von GenAI bei Meta, auf X, um die Bedenken anzusprechen. Er zeigte sich begeistert von der Beteiligung der Community an Llama 4, räumte jedoch Berichte über uneinheitliche Qualität bei verschiedenen Diensten ein. Er führte diese Probleme auf die schnelle Einführung und die Zeit zurück, die für die Stabilisierung öffentlicher Implementierungen benötigt wird. Al-Dahle wies die Vorwürfe des Trainings mit Testsets entschieden zurück und betonte, dass die variable Qualität auf Implementierungsfehler und nicht auf Fehlverhalten zurückzuführen sei. Er bekräftigte Metas Glauben an die bedeutenden Fortschritte der Llama 4-Modelle und ihr Engagement, mit der Community zusammenzuarbeiten, um ihr Potenzial zu verwirklichen.

Die Antwort konnte die Frustrationen der Community jedoch kaum lindern, da viele weiterhin von schlechter Leistung berichteten und mehr technische Dokumentation über die Trainingsprozesse der Modelle forderten. Diese Veröffentlichung hatte mehr Probleme als frühere Llama-Versionen, was Fragen zu ihrer Entwicklung und Einführung aufwirft.

Das Timing dieser Veröffentlichung ist bemerkenswert, da sie auf den Abgang von Joelle Pineau folgt, der Vizepräsidentin für Forschung bei Meta, die letzte Woche auf LinkedIn ihren Ausstieg mit Dank für ihre Zeit im Unternehmen bekannt gab. Pineau hatte am Wochenende auch die Llama 4-Modellfamilie beworben.

Da Llama 4 weiterhin von anderen Inferenzanbietern mit gemischten Ergebnissen übernommen wird, ist klar, dass die anfängliche Veröffentlichung nicht der Erfolg war, den Meta sich erhofft haben könnte. Die bevorstehende Meta LlamaCon am 29. April, das erste Treffen für Drittentwickler der Modellfamilie, wird wahrscheinlich ein Brennpunkt für Diskussionen und Debatten sein. Wir werden die Entwicklungen genau im Auge behalten, also bleiben Sie dran.

Verwandter Artikel

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Anthropic's AI Upgrade: Claude durchsucht jetzt sofort den gesamten Google-Arbeitsbereich

Das heutige wichtige Upgrade von Anthropic verwandelt Claude von einem KI-Assistenten in einen, wie das Unternehmen es nennt, "echten virtuellen Mitarbeiter", der bahnbrechende autonome Forschungsfunk

Anthropic's AI Upgrade: Claude durchsucht jetzt sofort den gesamten Google-Arbeitsbereich

Das heutige wichtige Upgrade von Anthropic verwandelt Claude von einem KI-Assistenten in einen, wie das Unternehmen es nennt, "echten virtuellen Mitarbeiter", der bahnbrechende autonome Forschungsfunk

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

Kommentare (8)

0/200

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

Kommentare (8)

0/200

![JohnWilson]() JohnWilson

JohnWilson

26. August 2025 03:01:18 MESZ

26. August 2025 03:01:18 MESZ

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

![HarryRoberts]() HarryRoberts

HarryRoberts

21. August 2025 23:01:34 MESZ

21. August 2025 23:01:34 MESZ

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

![ArthurJones]() ArthurJones

ArthurJones

12. August 2025 13:00:59 MESZ

12. August 2025 13:00:59 MESZ

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

24. April 2025 21:47:05 MESZ

24. April 2025 21:47:05 MESZ

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

![AlbertLee]() AlbertLee

AlbertLee

24. April 2025 13:01:02 MESZ

24. April 2025 13:01:02 MESZ

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

![HarryLewis]() HarryLewis

HarryLewis

24. April 2025 01:06:55 MESZ

24. April 2025 01:06:55 MESZ

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0

Am Wochenende überraschte Meta, das Kraftpaket hinter Facebook, Instagram, WhatsApp und Quest VR, alle mit der Vorstellung ihres neuesten KI-Sprachmodells, Llama 4. Nicht nur eines, sondern drei neue Versionen wurden eingeführt, jede mit verbesserten Fähigkeiten dank der "Mixture-of-Experts"-Architektur und einem neuartigen Trainingsansatz namens MetaP, der feste Hyperparameter verwendet. Darüber hinaus verfügen alle drei Modelle über erweiterte Kontextfenster, die es ihnen ermöglichen, mehr Informationen in einer einzigen Interaktion zu verarbeiten.

Trotz der Aufregung um die Veröffentlichung war die Reaktion der KI-Community bestenfalls verhalten. Am Samstag stellte Meta zwei dieser Modelle, Llama 4 Scout und Llama 4 Maverick, zum Download und zur Nutzung bereit, aber die Resonanz war alles andere als enthusiastisch.

Llama 4 löst Verwirrung und Kritik unter KI-Nutzern aus

Ein unbestätigter Beitrag im 1point3acres-Forum, einer beliebten chinesischsprachigen Community in Nordamerika, fand seinen Weg in das r/LocalLlama-Subreddit auf Reddit. Der Beitrag, angeblich von einem Forscher der GenAI-Organisation von Meta, behauptete, dass Llama 4 bei internen Benchmarks von Drittanbietern schlecht abgeschnitten habe. Es wurde angedeutet, dass die Führung von Meta die Ergebnisse manipuliert habe, indem sie Testsets während des Post-Trainings vermischte, um verschiedene Metriken zu erfüllen und ein positives Ergebnis zu präsentieren. Die Authentizität dieser Behauptung wurde mit Skepsis aufgenommen, und Meta hat bisher nicht auf Anfragen von VentureBeat reagiert.

Doch die Zweifel an der Leistung von Llama 4 hörten damit nicht auf. Auf X äußerte der Nutzer @cto_junior Unglauben über die Leistung des Modells und verwies auf einen unabhängigen Test, bei dem Llama 4 Maverick im aider-Polyglot-Benchmark, der Programmieraufgaben testet, nur 16 % erreichte. Dieser Wert liegt deutlich unter dem älterer, ähnlich großer Modelle wie DeepSeek V3 und Claude 3.7 Sonnet.

KI-Doktor und Autor Andriy Burkov nutzte ebenfalls X, um das beworbene 10-Millionen-Token-Kontextfenster von Llama 4 Scout in Frage zu stellen und erklärte, es sei "virtuell", da das Modell nicht mit Prompts trainiert wurde, die länger als 256k Token sind. Er warnte, dass längere Prompts wahrscheinlich zu minderwertigen Ergebnissen führen würden.

Im r/LocalLlama-Subreddit äußerte der Nutzer Dr_Karminski Enttäuschung über Llama 4 und verglich dessen schlechte Leistung mit dem nicht-räsonierenden V3-Modell von DeepSeek bei Aufgaben wie der Simulation von Ballbewegungen in einem Heptagon.

Nathan Lambert, ein ehemaliger Meta-Forscher und aktueller Senior Research Scientist bei AI2, kritisierte Metas Benchmark-Vergleiche in seinem Interconnects-Substack-Blog. Er wies darauf hin, dass das in Metas Werbematerialien verwendete Llama 4 Maverick-Modell nicht dasselbe war wie das öffentlich freigegebene, sondern für Konversation optimiert wurde. Lambert bemerkte den Widerspruch und sagte: „Hinterlistig. Die untenstehenden Ergebnisse sind gefälscht, und es ist ein großer Affront gegen die Community von Meta, nicht das Modell zu veröffentlichen, das sie für ihre große Marketingkampagne verwendet haben.“ Er fügte hinzu, dass das beworbene Modell „den technischen Ruf der Veröffentlichung ruiniert, weil sein Charakter jugendlich ist“, während das tatsächlich auf anderen Plattformen verfügbare Modell „ziemlich klug ist und einen angemessenen Ton hat“.

Meta reagiert, bestreitet „Training mit Testsets“ und verweist auf Fehler in der Implementierung aufgrund der schnellen Einführung

Als Reaktion auf die Kritik und Anschuldigungen ging Ahmad Al-Dahle, Vizepräsident und Leiter von GenAI bei Meta, auf X, um die Bedenken anzusprechen. Er zeigte sich begeistert von der Beteiligung der Community an Llama 4, räumte jedoch Berichte über uneinheitliche Qualität bei verschiedenen Diensten ein. Er führte diese Probleme auf die schnelle Einführung und die Zeit zurück, die für die Stabilisierung öffentlicher Implementierungen benötigt wird. Al-Dahle wies die Vorwürfe des Trainings mit Testsets entschieden zurück und betonte, dass die variable Qualität auf Implementierungsfehler und nicht auf Fehlverhalten zurückzuführen sei. Er bekräftigte Metas Glauben an die bedeutenden Fortschritte der Llama 4-Modelle und ihr Engagement, mit der Community zusammenzuarbeiten, um ihr Potenzial zu verwirklichen.

Die Antwort konnte die Frustrationen der Community jedoch kaum lindern, da viele weiterhin von schlechter Leistung berichteten und mehr technische Dokumentation über die Trainingsprozesse der Modelle forderten. Diese Veröffentlichung hatte mehr Probleme als frühere Llama-Versionen, was Fragen zu ihrer Entwicklung und Einführung aufwirft.

Das Timing dieser Veröffentlichung ist bemerkenswert, da sie auf den Abgang von Joelle Pineau folgt, der Vizepräsidentin für Forschung bei Meta, die letzte Woche auf LinkedIn ihren Ausstieg mit Dank für ihre Zeit im Unternehmen bekannt gab. Pineau hatte am Wochenende auch die Llama 4-Modellfamilie beworben.

Da Llama 4 weiterhin von anderen Inferenzanbietern mit gemischten Ergebnissen übernommen wird, ist klar, dass die anfängliche Veröffentlichung nicht der Erfolg war, den Meta sich erhofft haben könnte. Die bevorstehende Meta LlamaCon am 29. April, das erste Treffen für Drittentwickler der Modellfamilie, wird wahrscheinlich ein Brennpunkt für Diskussionen und Debatten sein. Wir werden die Entwicklungen genau im Auge behalten, also bleiben Sie dran.

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Anthropic's AI Upgrade: Claude durchsucht jetzt sofort den gesamten Google-Arbeitsbereich

Das heutige wichtige Upgrade von Anthropic verwandelt Claude von einem KI-Assistenten in einen, wie das Unternehmen es nennt, "echten virtuellen Mitarbeiter", der bahnbrechende autonome Forschungsfunk

Anthropic's AI Upgrade: Claude durchsucht jetzt sofort den gesamten Google-Arbeitsbereich

Das heutige wichtige Upgrade von Anthropic verwandelt Claude von einem KI-Assistenten in einen, wie das Unternehmen es nennt, "echten virtuellen Mitarbeiter", der bahnbrechende autonome Forschungsfunk

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

26. August 2025 03:01:18 MESZ

26. August 2025 03:01:18 MESZ

Meta's Llama 4 drop was wild! Three versions with that fancy Mixture-of-Experts setup? Sounds powerful, but those bugs they mentioned make me wonder if it’s ready for prime time. Anyone tried it yet? 🧐

0

0

21. August 2025 23:01:34 MESZ

21. August 2025 23:01:34 MESZ

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? Kinda feels like Meta rushed this out to beat the competition. Hope they patch it up soon! 🦙

0

0

12. August 2025 13:00:59 MESZ

12. August 2025 13:00:59 MESZ

Wow, Llama 4 sounds like a beast with that Mixture-of-Experts setup! But bugs causing mixed quality? That’s a bit concerning for a big player like Meta. Hope they iron it out soon, I’m curious to see how it stacks up against other models! 🦙

0

0

24. April 2025 21:47:05 MESZ

24. April 2025 21:47:05 MESZ

Llama 4 a l’air d’une sacrée avancée avec son architecture Mixture-of-Experts ! 😎 Mais les bugs, sérieux ? Ça sent la sortie précipitée pour faire la course avec les autres géants. Curieux de voir ce que ça donne après les correctifs.

0

0

24. April 2025 13:01:02 MESZ

24. April 2025 13:01:02 MESZ

¡Llama 4 con tres versiones nuevas! 😲 La arquitectura Mixture-of-Experts suena brutal, pero lo de los bugs me da mala espina. Meta siempre quiere estar a la cabeza, ¿no? Espero que lo pulan pronto.

0

0

24. April 2025 01:06:55 MESZ

24. April 2025 01:06:55 MESZ

ラマ4の発表、めっちゃ驚いた!😮 3つのバージョンってすごいけど、バグで品質がバラバラって…。ちょっと不安だな。AIの進化は楽しみだけど、倫理面どうするんだろ?

0

0