Google Lance un Modèle Gemini AI sur Appareil pour Robots

Google DeepMind Dévoile Gemini Robotics sur Appareil pour Contrôle Hors Ligne des Robots

Google DeepMind vient de publier une mise à jour passionnante dans le domaine de la robotique—Gemini Robotics sur Appareil, un nouveau modèle de langage qui permet aux robots d'exécuter des tâches sans connexion Internet. Cela s'appuie sur leur précédent modèle Gemini Robotics (sorti en mars) mais avec une amélioration clé : traitement local.

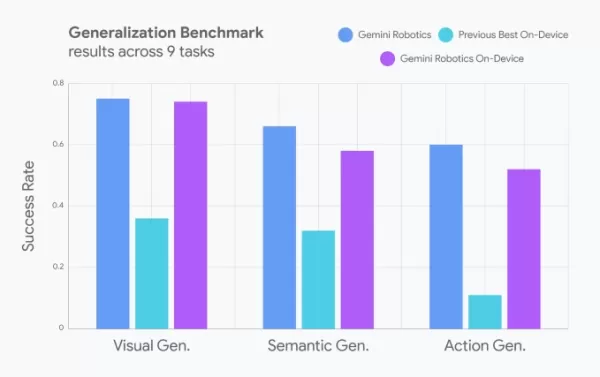

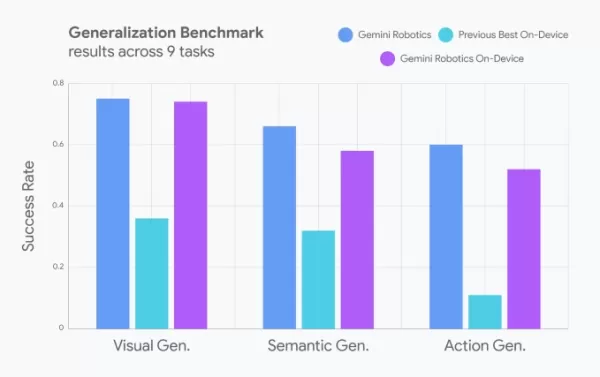

Les développeurs peuvent désormais ajuster les mouvements des robots à l'aide de commandes en langage naturel, facilitant l'adaptation des robots à différentes tâches. Google affirme que ses performances sont presque équivalentes à celles de son homologue basé sur le cloud et surpassent les autres modèles sur appareil (bien qu'ils n'aient pas précisé lesquels).

Crédits d'image : Google Compétences des Robots dans le Monde Réel : Du Linge aux Chaînes de Montage

Dans les démonstrations, les robots utilisant ce modèle ont réussi à :

- Ouvrir des sacs à fermeture éclair

- Plier des vêtements

- S'adapter à de nouveaux objets (comme assembler des pièces sur une chaîne industrielle)

Initialement entraîné pour les robots ALOHA, le modèle a ensuite été adapté pour fonctionner sur :

- Franka FR3 (un robot industriel à deux bras)

- L'humanoïde Apollo d'Apptronik

SDK Gemini Robotics : Entraînement des Robots avec des Démonstrations

Google a également annoncé un SDK Gemini Robotics, permettant aux développeurs d'entraîner des robots à l'aide de 50 à 100 démonstrations de tâches dans le simulateur physique MuJoCo. Cela pourrait accélérer l'apprentissage des robots pour des applications réelles.

La Vision Globale : L'Avancée de l'IA dans la Robotique

Google n'est pas seul dans cette course :

- Nvidia développe des modèles de base pour les humanoïdes

- Hugging Face travaille sur des modèles ouverts—et des robots réels

- RLWRLD (une startup coréenne) développe des modèles fondamentaux pour la robotique

L'avenir des robots alimentés par l'IA s'intensifie—et cela se passe hors ligne, sur appareil, et en temps réel.

Envie de plus d'informations technologiques ?

Rejoignez-nous à TechCrunch Disrupt à Boston, MA (15 juillet) pour des plongées approfondies dans l'IA, la robotique et les tendances du capital-risque. Économisez plus de 200 $ sur les pass toutes scènes et connectez-vous avec des leaders de Precursor Ventures, NEA, Index Ventures, et Underscore VC.

👉 INSCRIVEZ-VOUS MAINTENANT

Article connexe

Google relance l'application "Ask Photos", alimentée par l'IA, avec des fonctions de vitesse améliorées

Après une interruption temporaire des tests, Google relance sa fonctionnalité de recherche "Ask Photos" basée sur l'IA dans Google Photos en y apportant des améliorations significatives. Alimentée par

Google relance l'application "Ask Photos", alimentée par l'IA, avec des fonctions de vitesse améliorées

Après une interruption temporaire des tests, Google relance sa fonctionnalité de recherche "Ask Photos" basée sur l'IA dans Google Photos en y apportant des améliorations significatives. Alimentée par

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

commentaires (3)

0/200

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

commentaires (3)

0/200

![JuanLewis]() JuanLewis

JuanLewis

27 août 2025 07:01:00 UTC+02:00

27 août 2025 07:01:00 UTC+02:00

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

![RonaldNelson]() RonaldNelson

RonaldNelson

4 août 2025 08:48:52 UTC+02:00

4 août 2025 08:48:52 UTC+02:00

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

28 juillet 2025 03:19:30 UTC+02:00

28 juillet 2025 03:19:30 UTC+02:00

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0

Google DeepMind Dévoile Gemini Robotics sur Appareil pour Contrôle Hors Ligne des Robots

Google DeepMind vient de publier une mise à jour passionnante dans le domaine de la robotique—Gemini Robotics sur Appareil, un nouveau modèle de langage qui permet aux robots d'exécuter des tâches sans connexion Internet. Cela s'appuie sur leur précédent modèle Gemini Robotics (sorti en mars) mais avec une amélioration clé : traitement local.

Les développeurs peuvent désormais ajuster les mouvements des robots à l'aide de commandes en langage naturel, facilitant l'adaptation des robots à différentes tâches. Google affirme que ses performances sont presque équivalentes à celles de son homologue basé sur le cloud et surpassent les autres modèles sur appareil (bien qu'ils n'aient pas précisé lesquels).

Compétences des Robots dans le Monde Réel : Du Linge aux Chaînes de Montage

Dans les démonstrations, les robots utilisant ce modèle ont réussi à :

- Ouvrir des sacs à fermeture éclair

- Plier des vêtements

- S'adapter à de nouveaux objets (comme assembler des pièces sur une chaîne industrielle)

Initialement entraîné pour les robots ALOHA, le modèle a ensuite été adapté pour fonctionner sur :

- Franka FR3 (un robot industriel à deux bras)

- L'humanoïde Apollo d'Apptronik

SDK Gemini Robotics : Entraînement des Robots avec des Démonstrations

Google a également annoncé un SDK Gemini Robotics, permettant aux développeurs d'entraîner des robots à l'aide de 50 à 100 démonstrations de tâches dans le simulateur physique MuJoCo. Cela pourrait accélérer l'apprentissage des robots pour des applications réelles.

La Vision Globale : L'Avancée de l'IA dans la Robotique

Google n'est pas seul dans cette course :

- Nvidia développe des modèles de base pour les humanoïdes

- Hugging Face travaille sur des modèles ouverts—et des robots réels

- RLWRLD (une startup coréenne) développe des modèles fondamentaux pour la robotique

L'avenir des robots alimentés par l'IA s'intensifie—et cela se passe hors ligne, sur appareil, et en temps réel.

Envie de plus d'informations technologiques ?

Rejoignez-nous à TechCrunch Disrupt à Boston, MA (15 juillet) pour des plongées approfondies dans l'IA, la robotique et les tendances du capital-risque. Économisez plus de 200 $ sur les pass toutes scènes et connectez-vous avec des leaders de Precursor Ventures, NEA, Index Ventures, et Underscore VC.

👉 INSCRIVEZ-VOUS MAINTENANT

Google relance l'application "Ask Photos", alimentée par l'IA, avec des fonctions de vitesse améliorées

Après une interruption temporaire des tests, Google relance sa fonctionnalité de recherche "Ask Photos" basée sur l'IA dans Google Photos en y apportant des améliorations significatives. Alimentée par

Google relance l'application "Ask Photos", alimentée par l'IA, avec des fonctions de vitesse améliorées

Après une interruption temporaire des tests, Google relance sa fonctionnalité de recherche "Ask Photos" basée sur l'IA dans Google Photos en y apportant des améliorations significatives. Alimentée par

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

27 août 2025 07:01:00 UTC+02:00

27 août 2025 07:01:00 UTC+02:00

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

4 août 2025 08:48:52 UTC+02:00

4 août 2025 08:48:52 UTC+02:00

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

28 juillet 2025 03:19:30 UTC+02:00

28 juillet 2025 03:19:30 UTC+02:00

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0