Google、デバイス上Gemini AIモデルをロボット向けに公開

Google DeepMind、Gemini Robotics On-Deviceをオフラインのロボット制御向けに発表

Google DeepMindがロボティクス分野でエキサイティングなアップデートを発表—Gemini Robotics On-Deviceは、ロボットがインターネット接続なしでタスクを実行できる新しい言語モデルです。これは以前のGemini Roboticsモデル(3月リリース)を基盤に、重要なアップグレード:ローカル処理を備えています。

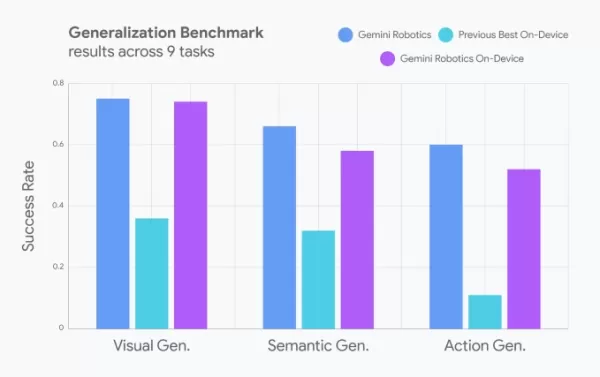

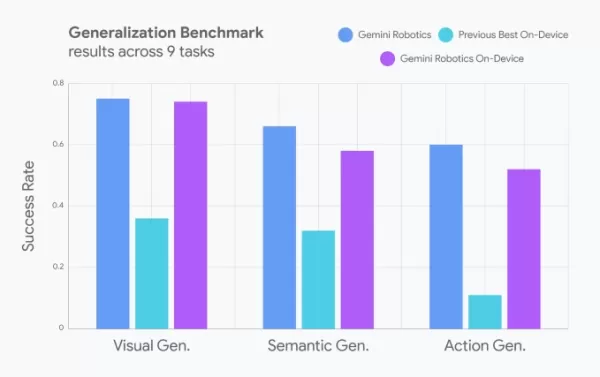

開発者は自然言語プロンプトを使用してロボットの動きを微調整でき、さまざまなタスクにロボットを適応させるのが簡単になりました。Googleは、そのパフォーマンスがクラウドベースのモデルとほぼ同等で、他のデバイス上モデル(具体的なものは未指定)を上回ると主張しています。

画像提供:Google 現実世界のロボットスキル:洗濯から組み立てラインまで

デモでは、このモデルを搭載したロボットが以下のタスクを成功裏に実行しました:

- バッグのジッパーを開ける

- 服を畳む

- 新しい物体に対応(産業用ベルトでの部品組み立てなど)

元々はALOHAロボット向けに訓練され、後に以下のロボットでも動作するよう適応されました:

- Franka FR3(双腕産業用ロボット)

- ApptronikのApolloヒューマノイド

Gemini Robotics SDK:デモンストレーションでロボットを訓練

Googleはまた、Gemini Robotics SDKを発表し、開発者がMuJoCo物理シミュレータで50~100のタスクデモンストレーションを使用してロボットを訓練できるようにしました。これにより、現実世界のアプリケーションでのロボット学習が加速する可能性があります。

大きな視点:AIのロボティクスへの進出

Googleはこのレースで一人ではありません:

- Nvidiaはヒューマノイド向けの基礎モデルを構築中

- Hugging Faceはオープンなモデルと実際のロボットに取り組んでいます

- RLWRLD(韓国スタートアップ)はロボティクス向けの基礎モデルを開発中

AI駆動のロボットの未来は熱を帯びており、オフライン、デバイス上、リアルタイムで進行中です。

さらに技術的洞察が必要ですか?

Boston, MA(7月15日)のTechCrunch Disruptに参加して、AI、ロボティクス、ベンチャートレンドについての深い議論を体験してください。All Stageパスで200ドル以上節約し、Precursor Ventures、NEA、Index Ventures、Underscore VCのリーダーとつながりましょう。

👉 今すぐ登録

関連記事

グーグル、AIを活用した「Ask Photos」を再開、スピード機能も向上

Googleは、一時的にテストを停止していたGoogleフォトのAIによる「Ask Photos」検索機能を大幅に強化し、再開する。GoogleのGemini AIテクノロジーを搭載したこの革新的な機能は、自然言語によるクエリを通じて、ユーザーが特定の画像を探し出せるようにします。Ask Photosの主な改善点Googleは最近、特にレスポンスタイムと結果の精度に関して、この機能の初期の欠点を認

グーグル、AIを活用した「Ask Photos」を再開、スピード機能も向上

Googleは、一時的にテストを停止していたGoogleフォトのAIによる「Ask Photos」検索機能を大幅に強化し、再開する。GoogleのGemini AIテクノロジーを搭載したこの革新的な機能は、自然言語によるクエリを通じて、ユーザーが特定の画像を探し出せるようにします。Ask Photosの主な改善点Googleは最近、特にレスポンスタイムと結果の精度に関して、この機能の初期の欠点を認

Google AI Ultraを発表:月額249.99ドルのプレミアムサブスクリプション

グーグル、プレミアムAIウルトラ・サブスクリプションを発表Google I/O 2025で、グーグルは新しい包括的なAIサブスクリプション・サービス「Google AI Ultra」を発表した。月額249.99ドルのこのプレミアムサービスでは、現在利用可能なグーグルの最先端の人工知能ツールに独占的にアクセスできる。AIウルトラに含まれるものVeo 3:グーグルの最先端AI動画生成プラットフォームF

Google AI Ultraを発表:月額249.99ドルのプレミアムサブスクリプション

グーグル、プレミアムAIウルトラ・サブスクリプションを発表Google I/O 2025で、グーグルは新しい包括的なAIサブスクリプション・サービス「Google AI Ultra」を発表した。月額249.99ドルのこのプレミアムサービスでは、現在利用可能なグーグルの最先端の人工知能ツールに独占的にアクセスできる。AIウルトラに含まれるものVeo 3:グーグルの最先端AI動画生成プラットフォームF

マイクロソフト、AIトークンが推論ミスを増加させるとの研究結果を発表

LLM推論効率の新たな洞察マイクロソフトの新しい研究は、大規模言語モデルにおける高度な推論技術が、異なるAIシステム間で一様な改善をもたらさないことを実証している。彼らの画期的な研究は、9つの主要な基礎モデルが推論中に様々なスケーリングアプローチにどのように反応するかを分析した。推論時間のスケーリング手法の評価研究チームは、3つの異なるスケーリング手法にわたって、厳密なテスト手法を実施した:従来の

コメント (3)

0/200

マイクロソフト、AIトークンが推論ミスを増加させるとの研究結果を発表

LLM推論効率の新たな洞察マイクロソフトの新しい研究は、大規模言語モデルにおける高度な推論技術が、異なるAIシステム間で一様な改善をもたらさないことを実証している。彼らの画期的な研究は、9つの主要な基礎モデルが推論中に様々なスケーリングアプローチにどのように反応するかを分析した。推論時間のスケーリング手法の評価研究チームは、3つの異なるスケーリング手法にわたって、厳密なテスト手法を実施した:従来の

コメント (3)

0/200

![JuanLewis]() JuanLewis

JuanLewis

2025年8月27日 14:01:00 JST

2025年8月27日 14:01:00 JST

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

![RonaldNelson]() RonaldNelson

RonaldNelson

2025年8月4日 15:48:52 JST

2025年8月4日 15:48:52 JST

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

2025年7月28日 10:19:30 JST

2025年7月28日 10:19:30 JST

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0

Google DeepMind、Gemini Robotics On-Deviceをオフラインのロボット制御向けに発表

Google DeepMindがロボティクス分野でエキサイティングなアップデートを発表—Gemini Robotics On-Deviceは、ロボットがインターネット接続なしでタスクを実行できる新しい言語モデルです。これは以前のGemini Roboticsモデル(3月リリース)を基盤に、重要なアップグレード:ローカル処理を備えています。

開発者は自然言語プロンプトを使用してロボットの動きを微調整でき、さまざまなタスクにロボットを適応させるのが簡単になりました。Googleは、そのパフォーマンスがクラウドベースのモデルとほぼ同等で、他のデバイス上モデル(具体的なものは未指定)を上回ると主張しています。

現実世界のロボットスキル:洗濯から組み立てラインまで

デモでは、このモデルを搭載したロボットが以下のタスクを成功裏に実行しました:

- バッグのジッパーを開ける

- 服を畳む

- 新しい物体に対応(産業用ベルトでの部品組み立てなど)

元々はALOHAロボット向けに訓練され、後に以下のロボットでも動作するよう適応されました:

- Franka FR3(双腕産業用ロボット)

- ApptronikのApolloヒューマノイド

Gemini Robotics SDK:デモンストレーションでロボットを訓練

Googleはまた、Gemini Robotics SDKを発表し、開発者がMuJoCo物理シミュレータで50~100のタスクデモンストレーションを使用してロボットを訓練できるようにしました。これにより、現実世界のアプリケーションでのロボット学習が加速する可能性があります。

大きな視点:AIのロボティクスへの進出

Googleはこのレースで一人ではありません:

- Nvidiaはヒューマノイド向けの基礎モデルを構築中

- Hugging Faceはオープンなモデルと実際のロボットに取り組んでいます

- RLWRLD(韓国スタートアップ)はロボティクス向けの基礎モデルを開発中

AI駆動のロボットの未来は熱を帯びており、オフライン、デバイス上、リアルタイムで進行中です。

さらに技術的洞察が必要ですか?

Boston, MA(7月15日)のTechCrunch Disruptに参加して、AI、ロボティクス、ベンチャートレンドについての深い議論を体験してください。All Stageパスで200ドル以上節約し、Precursor Ventures、NEA、Index Ventures、Underscore VCのリーダーとつながりましょう。

👉 今すぐ登録

グーグル、AIを活用した「Ask Photos」を再開、スピード機能も向上

Googleは、一時的にテストを停止していたGoogleフォトのAIによる「Ask Photos」検索機能を大幅に強化し、再開する。GoogleのGemini AIテクノロジーを搭載したこの革新的な機能は、自然言語によるクエリを通じて、ユーザーが特定の画像を探し出せるようにします。Ask Photosの主な改善点Googleは最近、特にレスポンスタイムと結果の精度に関して、この機能の初期の欠点を認

グーグル、AIを活用した「Ask Photos」を再開、スピード機能も向上

Googleは、一時的にテストを停止していたGoogleフォトのAIによる「Ask Photos」検索機能を大幅に強化し、再開する。GoogleのGemini AIテクノロジーを搭載したこの革新的な機能は、自然言語によるクエリを通じて、ユーザーが特定の画像を探し出せるようにします。Ask Photosの主な改善点Googleは最近、特にレスポンスタイムと結果の精度に関して、この機能の初期の欠点を認

Google AI Ultraを発表:月額249.99ドルのプレミアムサブスクリプション

グーグル、プレミアムAIウルトラ・サブスクリプションを発表Google I/O 2025で、グーグルは新しい包括的なAIサブスクリプション・サービス「Google AI Ultra」を発表した。月額249.99ドルのこのプレミアムサービスでは、現在利用可能なグーグルの最先端の人工知能ツールに独占的にアクセスできる。AIウルトラに含まれるものVeo 3:グーグルの最先端AI動画生成プラットフォームF

Google AI Ultraを発表:月額249.99ドルのプレミアムサブスクリプション

グーグル、プレミアムAIウルトラ・サブスクリプションを発表Google I/O 2025で、グーグルは新しい包括的なAIサブスクリプション・サービス「Google AI Ultra」を発表した。月額249.99ドルのこのプレミアムサービスでは、現在利用可能なグーグルの最先端の人工知能ツールに独占的にアクセスできる。AIウルトラに含まれるものVeo 3:グーグルの最先端AI動画生成プラットフォームF

マイクロソフト、AIトークンが推論ミスを増加させるとの研究結果を発表

LLM推論効率の新たな洞察マイクロソフトの新しい研究は、大規模言語モデルにおける高度な推論技術が、異なるAIシステム間で一様な改善をもたらさないことを実証している。彼らの画期的な研究は、9つの主要な基礎モデルが推論中に様々なスケーリングアプローチにどのように反応するかを分析した。推論時間のスケーリング手法の評価研究チームは、3つの異なるスケーリング手法にわたって、厳密なテスト手法を実施した:従来の

マイクロソフト、AIトークンが推論ミスを増加させるとの研究結果を発表

LLM推論効率の新たな洞察マイクロソフトの新しい研究は、大規模言語モデルにおける高度な推論技術が、異なるAIシステム間で一様な改善をもたらさないことを実証している。彼らの画期的な研究は、9つの主要な基礎モデルが推論中に様々なスケーリングアプローチにどのように反応するかを分析した。推論時間のスケーリング手法の評価研究チームは、3つの異なるスケーリング手法にわたって、厳密なテスト手法を実施した:従来の

2025年8月27日 14:01:00 JST

2025年8月27日 14:01:00 JST

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

2025年8月4日 15:48:52 JST

2025年8月4日 15:48:52 JST

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

2025年7月28日 10:19:30 JST

2025年7月28日 10:19:30 JST

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0