Google Startet Geräteinterne Gemini AI-Modell für Roboter

Google DeepMind Enthüllt Gemini Robotics On-Device für Offline-Robotersteuerung

Google DeepMind hat gerade ein aufregendes Update im Bereich Robotik veröffentlicht—Gemini Robotics On-Device, ein neues Sprachmodell, das Robotern ermöglicht, Aufgaben ohne Internetverbindung auszuführen. Dies baut auf ihrem früheren Gemini Robotics-Modell (veröffentlicht im März) auf, jedoch mit einem entscheidenden Upgrade: lokale Verarbeitung.

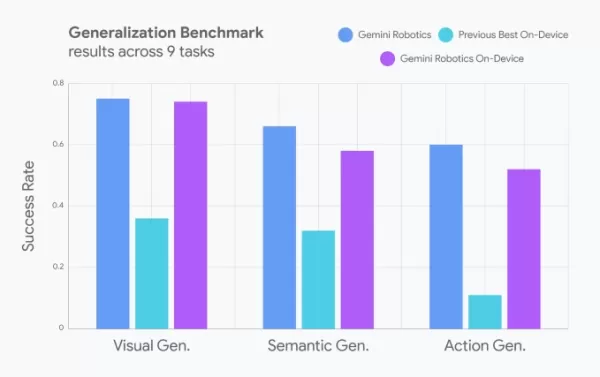

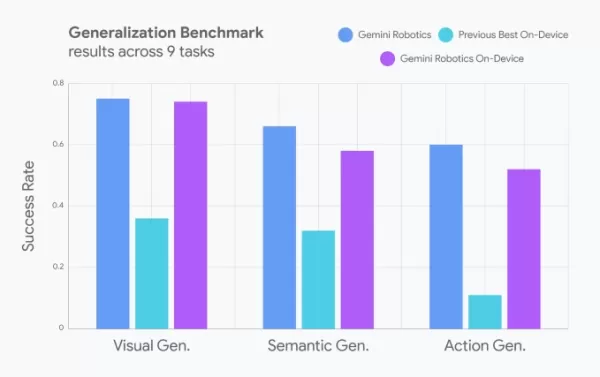

Entwickler können nun Roboterbewegungen mit natürlichen Sprachbefehlen optimieren, was die Anpassung von Robotern an verschiedene Aufgaben erleichtert. Google gibt an, dass die Leistung fast mit der cloudbasierten Version mithält und andere geräteinterne Modelle übertrifft (ohne jedoch anzugeben, welche).

Bildnachweis: Google Reale Roboterfähigkeiten: Von Wäsche bis zu Fließbändern

In Demos führten Roboter, die dieses Modell nutzen, erfolgreich folgende Aufgaben aus:

- Reißverschlüsse öffnen

- Kleidung falten

- Anpassung an neue Objekte (wie das Zusammenbauen von Teilen an einem industriellen Fließband)

Ursprünglich für ALOHA-Roboter trainiert, wurde das Modell später angepasst für:

- Franka FR3 (ein zweiarmiger Industrieroboter)

- Apptroniks Apollo-Humanoid

Gemini Robotics SDK: Roboter mit Demonstrationen trainieren

Google kündigte auch ein Gemini Robotics SDK an, das Entwicklern ermöglicht, Roboter mit 50-100 Aufgaben-Demonstrationen im MuJoCo-Physiksimulator zu trainieren. Dies könnte das Lernen von Robotern für reale Anwendungen beschleunigen.

Das größere Bild: Der Vorstoß von KI in die Robotik

Google ist nicht allein in diesem Wettlauf:

- Nvidia entwickelt Grundlagenmodelle für Humanoide

- Hugging Face arbeitet an offenen Modellen – und echten Robotern

- RLWRLD (ein koreanisches Startup) entwickelt grundlegende Modelle für Robotik

Die Zukunft von KI-gesteuerten Robotern heizt sich auf – und das geschieht offline, geräteintern und in Echtzeit.

Möchten Sie mehr Technik-Einblicke?

Besuchen Sie uns auf der TechCrunch Disrupt in Boston, MA (15. Juli) für tiefgehende Einblicke in KI, Robotik und Venture-Trends. Sparen Sie über 200 $ bei All Stage Pässen und vernetzen Sie sich mit Führungskräften von Precursor Ventures, NEA, Index Ventures und Underscore VC.

👉 JETZT REGISTRIEREN

Verwandter Artikel

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Microsoft-Studie: Mehr KI-Token erhöhen Denkfehler

Neue Einsichten in die Effizienz von LLM-ReasoningNeue Forschungsergebnisse von Microsoft zeigen, dass fortschrittliche Schlussfolgerungstechniken in großen Sprachmodellen nicht zu einheitlichen Verbe

Kommentare (3)

0/200

Microsoft-Studie: Mehr KI-Token erhöhen Denkfehler

Neue Einsichten in die Effizienz von LLM-ReasoningNeue Forschungsergebnisse von Microsoft zeigen, dass fortschrittliche Schlussfolgerungstechniken in großen Sprachmodellen nicht zu einheitlichen Verbe

Kommentare (3)

0/200

![JuanLewis]() JuanLewis

JuanLewis

27. August 2025 07:01:00 MESZ

27. August 2025 07:01:00 MESZ

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

![RonaldNelson]() RonaldNelson

RonaldNelson

4. August 2025 08:48:52 MESZ

4. August 2025 08:48:52 MESZ

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

28. Juli 2025 03:19:30 MESZ

28. Juli 2025 03:19:30 MESZ

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0

Google DeepMind Enthüllt Gemini Robotics On-Device für Offline-Robotersteuerung

Google DeepMind hat gerade ein aufregendes Update im Bereich Robotik veröffentlicht—Gemini Robotics On-Device, ein neues Sprachmodell, das Robotern ermöglicht, Aufgaben ohne Internetverbindung auszuführen. Dies baut auf ihrem früheren Gemini Robotics-Modell (veröffentlicht im März) auf, jedoch mit einem entscheidenden Upgrade: lokale Verarbeitung.

Entwickler können nun Roboterbewegungen mit natürlichen Sprachbefehlen optimieren, was die Anpassung von Robotern an verschiedene Aufgaben erleichtert. Google gibt an, dass die Leistung fast mit der cloudbasierten Version mithält und andere geräteinterne Modelle übertrifft (ohne jedoch anzugeben, welche).

Reale Roboterfähigkeiten: Von Wäsche bis zu Fließbändern

In Demos führten Roboter, die dieses Modell nutzen, erfolgreich folgende Aufgaben aus:

- Reißverschlüsse öffnen

- Kleidung falten

- Anpassung an neue Objekte (wie das Zusammenbauen von Teilen an einem industriellen Fließband)

Ursprünglich für ALOHA-Roboter trainiert, wurde das Modell später angepasst für:

- Franka FR3 (ein zweiarmiger Industrieroboter)

- Apptroniks Apollo-Humanoid

Gemini Robotics SDK: Roboter mit Demonstrationen trainieren

Google kündigte auch ein Gemini Robotics SDK an, das Entwicklern ermöglicht, Roboter mit 50-100 Aufgaben-Demonstrationen im MuJoCo-Physiksimulator zu trainieren. Dies könnte das Lernen von Robotern für reale Anwendungen beschleunigen.

Das größere Bild: Der Vorstoß von KI in die Robotik

Google ist nicht allein in diesem Wettlauf:

- Nvidia entwickelt Grundlagenmodelle für Humanoide

- Hugging Face arbeitet an offenen Modellen – und echten Robotern

- RLWRLD (ein koreanisches Startup) entwickelt grundlegende Modelle für Robotik

Die Zukunft von KI-gesteuerten Robotern heizt sich auf – und das geschieht offline, geräteintern und in Echtzeit.

Möchten Sie mehr Technik-Einblicke?

Besuchen Sie uns auf der TechCrunch Disrupt in Boston, MA (15. Juli) für tiefgehende Einblicke in KI, Robotik und Venture-Trends. Sparen Sie über 200 $ bei All Stage Pässen und vernetzen Sie sich mit Führungskräften von Precursor Ventures, NEA, Index Ventures und Underscore VC.

👉 JETZT REGISTRIEREN

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Microsoft-Studie: Mehr KI-Token erhöhen Denkfehler

Neue Einsichten in die Effizienz von LLM-ReasoningNeue Forschungsergebnisse von Microsoft zeigen, dass fortschrittliche Schlussfolgerungstechniken in großen Sprachmodellen nicht zu einheitlichen Verbe

Microsoft-Studie: Mehr KI-Token erhöhen Denkfehler

Neue Einsichten in die Effizienz von LLM-ReasoningNeue Forschungsergebnisse von Microsoft zeigen, dass fortschrittliche Schlussfolgerungstechniken in großen Sprachmodellen nicht zu einheitlichen Verbe

27. August 2025 07:01:00 MESZ

27. August 2025 07:01:00 MESZ

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

4. August 2025 08:48:52 MESZ

4. August 2025 08:48:52 MESZ

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

28. Juli 2025 03:19:30 MESZ

28. Juli 2025 03:19:30 MESZ

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0