Google Lanza Modelo de IA Gemini en Dispositivo para Robots

Google DeepMind Presenta Gemini Robotics On-Device para Control de Robots Sin Conexión

Google DeepMind acaba de lanzar una actualización emocionante en el ámbito de la robótica—Gemini Robotics On-Device, un nuevo modelo de lenguaje que permite a los robots realizar tareas sin necesidad de conexión a internet. Esto se basa en su anterior modelo Gemini Robotics (lanzado en marzo) pero con una mejora clave: procesamiento local.

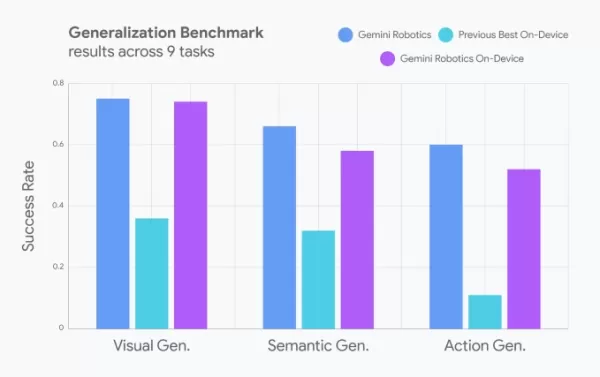

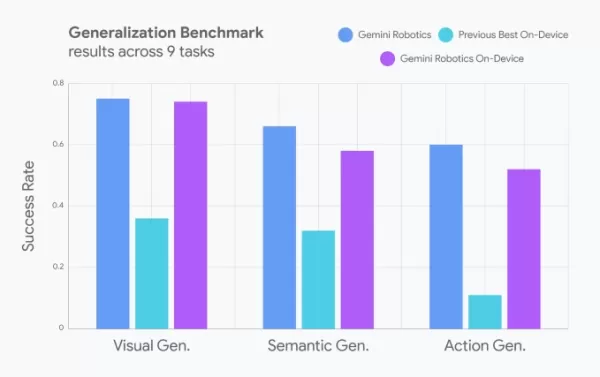

Los desarrolladores ahora pueden ajustar los movimientos de los robots usando prompts en lenguaje natural, facilitando la adaptación de los robots para diferentes tareas. Google afirma que su rendimiento es casi equiparable al de su contraparte basada en la nube y supera a otros modelos en dispositivo (aunque no especificaron cuáles).

Créditos de la imagen: Google Habilidades de Robots en el Mundo Real: Desde la Lavandería hasta Líneas de Ensamblaje

En demostraciones, los robots que ejecutan este modelo lograron:

- Abrir cremalleras de bolsas

- Doblar ropa

- Adaptarse a nuevos objetos (como ensamblar piezas en una cinta industrial)

Originalmente entrenado para robots ALOHA, el modelo fue adaptado posteriormente para funcionar en:

- Franka FR3 (un robot industrial de doble brazo)

- Humanoide Apollo de Apptronik

SDK de Gemini Robotics: Entrenamiento de Robots con Demostraciones

Google también anunció un SDK de Gemini Robotics, que permite a los desarrolladores entrenar robots usando 50-100 demostraciones de tareas en el simulador físico MuJoCo. Esto podría acelerar el aprendizaje de robots para aplicaciones en el mundo real.

La Visión Más Amplia: El Avance de la IA en la Robótica

Google no está solo en esta carrera:

- Nvidia está desarrollando modelos fundacionales para humanoides

- Hugging Face está trabajando en modelos abiertos—y robots reales

- RLWRLD (una startup coreana) está desarrollando modelos fundacionales para robótica

El futuro de los robots impulsados por IA está calentándose—y está ocurriendo sin conexión, en dispositivo y en tiempo real.

¿Quieres más información sobre tecnología?

Únete a nosotros en TechCrunch Disrupt en Boston, MA (15 de julio) para profundizar en IA, robótica y tendencias de capital de riesgo. Ahorra más de $200 en pases para todas las etapas y conéctate con líderes de Precursor Ventures, NEA, Index Ventures y Underscore VC.

👉 REGÍSTRATE AHORA

Artículo relacionado

Google relanza "Ask Photos" con IA y funciones de velocidad mejoradas

Tras una interrupción temporal de las pruebas, Google relanza su función de búsqueda "Ask Photos" basada en IA en Google Fotos con importantes mejoras. Gracias a la tecnología Gemini AI de Google, est

Google relanza "Ask Photos" con IA y funciones de velocidad mejoradas

Tras una interrupción temporal de las pruebas, Google relanza su función de búsqueda "Ask Photos" basada en IA en Google Fotos con importantes mejoras. Gracias a la tecnología Gemini AI de Google, est

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

Un estudio de Microsoft revela que más tokens de IA aumentan los errores de razonamiento

Nuevos conocimientos sobre la eficacia del razonamiento LLMUna nueva investigación de Microsoft demuestra que las técnicas avanzadas de razonamiento de los grandes modelos lingüísticos no producen mej

comentario (3)

0/200

Un estudio de Microsoft revela que más tokens de IA aumentan los errores de razonamiento

Nuevos conocimientos sobre la eficacia del razonamiento LLMUna nueva investigación de Microsoft demuestra que las técnicas avanzadas de razonamiento de los grandes modelos lingüísticos no producen mej

comentario (3)

0/200

![JuanLewis]() JuanLewis

JuanLewis

27 de agosto de 2025 07:01:00 GMT+02:00

27 de agosto de 2025 07:01:00 GMT+02:00

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

![RonaldNelson]() RonaldNelson

RonaldNelson

4 de agosto de 2025 08:48:52 GMT+02:00

4 de agosto de 2025 08:48:52 GMT+02:00

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

28 de julio de 2025 03:19:30 GMT+02:00

28 de julio de 2025 03:19:30 GMT+02:00

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0

Google DeepMind Presenta Gemini Robotics On-Device para Control de Robots Sin Conexión

Google DeepMind acaba de lanzar una actualización emocionante en el ámbito de la robótica—Gemini Robotics On-Device, un nuevo modelo de lenguaje que permite a los robots realizar tareas sin necesidad de conexión a internet. Esto se basa en su anterior modelo Gemini Robotics (lanzado en marzo) pero con una mejora clave: procesamiento local.

Los desarrolladores ahora pueden ajustar los movimientos de los robots usando prompts en lenguaje natural, facilitando la adaptación de los robots para diferentes tareas. Google afirma que su rendimiento es casi equiparable al de su contraparte basada en la nube y supera a otros modelos en dispositivo (aunque no especificaron cuáles).

Habilidades de Robots en el Mundo Real: Desde la Lavandería hasta Líneas de Ensamblaje

En demostraciones, los robots que ejecutan este modelo lograron:

- Abrir cremalleras de bolsas

- Doblar ropa

- Adaptarse a nuevos objetos (como ensamblar piezas en una cinta industrial)

Originalmente entrenado para robots ALOHA, el modelo fue adaptado posteriormente para funcionar en:

- Franka FR3 (un robot industrial de doble brazo)

- Humanoide Apollo de Apptronik

SDK de Gemini Robotics: Entrenamiento de Robots con Demostraciones

Google también anunció un SDK de Gemini Robotics, que permite a los desarrolladores entrenar robots usando 50-100 demostraciones de tareas en el simulador físico MuJoCo. Esto podría acelerar el aprendizaje de robots para aplicaciones en el mundo real.

La Visión Más Amplia: El Avance de la IA en la Robótica

Google no está solo en esta carrera:

- Nvidia está desarrollando modelos fundacionales para humanoides

- Hugging Face está trabajando en modelos abiertos—y robots reales

- RLWRLD (una startup coreana) está desarrollando modelos fundacionales para robótica

El futuro de los robots impulsados por IA está calentándose—y está ocurriendo sin conexión, en dispositivo y en tiempo real.

¿Quieres más información sobre tecnología?

Únete a nosotros en TechCrunch Disrupt en Boston, MA (15 de julio) para profundizar en IA, robótica y tendencias de capital de riesgo. Ahorra más de $200 en pases para todas las etapas y conéctate con líderes de Precursor Ventures, NEA, Index Ventures y Underscore VC.

👉 REGÍSTRATE AHORA

Google relanza "Ask Photos" con IA y funciones de velocidad mejoradas

Tras una interrupción temporal de las pruebas, Google relanza su función de búsqueda "Ask Photos" basada en IA en Google Fotos con importantes mejoras. Gracias a la tecnología Gemini AI de Google, est

Google relanza "Ask Photos" con IA y funciones de velocidad mejoradas

Tras una interrupción temporal de las pruebas, Google relanza su función de búsqueda "Ask Photos" basada en IA en Google Fotos con importantes mejoras. Gracias a la tecnología Gemini AI de Google, est

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

Un estudio de Microsoft revela que más tokens de IA aumentan los errores de razonamiento

Nuevos conocimientos sobre la eficacia del razonamiento LLMUna nueva investigación de Microsoft demuestra que las técnicas avanzadas de razonamiento de los grandes modelos lingüísticos no producen mej

Un estudio de Microsoft revela que más tokens de IA aumentan los errores de razonamiento

Nuevos conocimientos sobre la eficacia del razonamiento LLMUna nueva investigación de Microsoft demuestra que las técnicas avanzadas de razonamiento de los grandes modelos lingüísticos no producen mej

27 de agosto de 2025 07:01:00 GMT+02:00

27 de agosto de 2025 07:01:00 GMT+02:00

Super cool that robots can now think offline with Gemini! Imagine them zipping around without Wi-Fi, making decisions on the fly. Can’t wait to see this in action at home! 🤖

0

0

4 de agosto de 2025 08:48:52 GMT+02:00

4 de agosto de 2025 08:48:52 GMT+02:00

This is wild! Robots running Gemini AI offline? Google’s pushing the future hard. Can’t wait to see how this shakes up industries, but I’m low-key worried about robots getting too smart too fast. 😅

0

0

28 de julio de 2025 03:19:30 GMT+02:00

28 de julio de 2025 03:19:30 GMT+02:00

Super cool to see Google pushing offline AI for robots with Gemini! 🤖 Makes me wonder how soon we’ll have fully autonomous helpers at home. Exciting times!

0

0