Censure de l'IA chinoise exposée par des données divulguées

L'utilisation de l'IA par la Chine pour renforcer ses capacités de censure a atteint un nouveau niveau, comme le révèle une base de données divulguée contenant 133 000 exemples de contenus signalés pour leur sensibilité par le gouvernement chinois. Ce modèle de langage de grande échelle (LLM) sophistiqué est conçu pour détecter et censurer automatiquement des contenus liés à une large gamme de sujets, allant de la pauvreté dans les zones rurales à la corruption au sein du Parti communiste, et même à la satire politique subtile.

Cette photo, prise le 4 juin 2019, montre le drapeau chinois derrière des barbelés dans un complexe résidentiel à Yengisar, au sud de Kashgar, dans la région du Xinjiang, à l'ouest de la Chine. Crédits image : Greg Baker / AFP / Getty Images Selon Xiao Qiang, chercheur à UC Berkeley spécialisé dans la censure chinoise, cette base de données est une "preuve claire" que le gouvernement chinois ou ses affiliés utilisent des LLM pour renforcer leurs efforts de répression. Contrairement aux méthodes traditionnelles qui reposent sur des modérateurs humains et le filtrage par mots-clés, cette approche pilotée par l'IA peut considérablement améliorer l'efficacité et la précision de la gestion de l'information contrôlée par l'État.

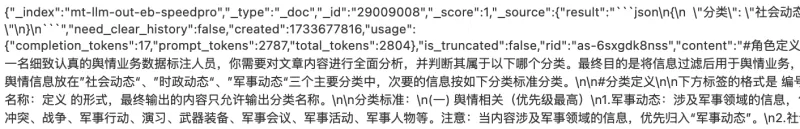

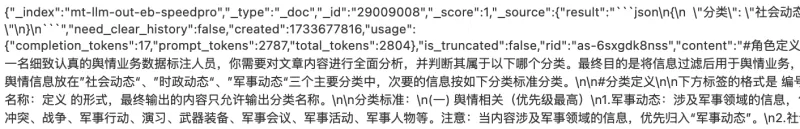

Le jeu de données, découvert par le chercheur en sécurité NetAskari sur une base de données Elasticsearch non sécurisée hébergée sur un serveur Baidu, inclut des entrées récentes de décembre 2024. On ignore qui a précisément créé ce jeu de données, mais son objectif est évident : entraîner un LLM à identifier et signaler des contenus liés à des sujets sensibles tels que la pollution, la sécurité alimentaire, la fraude financière, les conflits du travail et les questions militaires. La satire politique, surtout lorsqu'elle implique des analogies historiques ou des références à Taïwan, est également une cible prioritaire.

Crédits image : Charles Rollet Les données d'entraînement incluent divers exemples de contenus susceptibles de provoquer des troubles sociaux, tels que des plaintes concernant des officiers de police corrompus, des rapports sur la pauvreté rurale et des informations sur des responsables du Parti communiste expulsés. Le jeu de données contient également de nombreuses références à Taïwan et à des sujets liés à l'armée, le mot chinois pour Taïwan (台湾) apparaissant plus de 15 000 fois.

L'utilisation prévue du jeu de données est décrite comme un "travail d'opinion publique", un terme que Michael Caster d'Article 19 explique comme étant généralement associé à l'Administration du cyberespace de Chine (CAC) et impliquant des efforts de censure et de propagande. Cela correspond à la vision du président chinois Xi Jinping, qui considère Internet comme la "première ligne" du travail d'opinion publique du Parti communiste.

Ce développement s'inscrit dans une tendance plus large des régimes autoritaires adoptant la technologie de l'IA à des fins répressives. OpenAI a récemment rapporté qu'un acteur non identifié, probablement originaire de Chine, a utilisé l'IA générative pour surveiller les réseaux sociaux et transmettre des publications antigouvernementales au gouvernement chinois. La même technologie a également été utilisée pour générer des commentaires critiques à l'encontre d'une dissidente chinoise de premier plan, Cai Xia.

Alors que les méthodes de censure traditionnelles de la Chine reposent sur des algorithmes de base pour bloquer les termes interdits, l'utilisation de LLM représente une avancée significative. Ces systèmes d'IA peuvent détecter même des critiques subtiles à une échelle massive et s'améliorer continuellement à mesure qu'ils traitent plus de données.

"Je pense qu'il est crucial de souligner comment la censure pilotée par l'IA évolue, rendant le contrôle de l'État sur le discours public encore plus sophistiqué, surtout à une époque où les modèles d'IA chinois comme DeepSeek font des vagues," a déclaré Xiao Qiang à TechCrunch.

Article connexe

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

Alibaba Dévoile Wan2.1-VACE : Solution Vidéo IA Open-Source

Alibaba a présenté Wan2.1-VACE, un modèle d'IA open-source prêt à transformer les processus de création et d'édition vidéo.VACE est un composant clé de la famille de modèles vidéo IA Wan2.1 d’Alibaba,

Alibaba Dévoile Wan2.1-VACE : Solution Vidéo IA Open-Source

Alibaba a présenté Wan2.1-VACE, un modèle d'IA open-source prêt à transformer les processus de création et d'édition vidéo.VACE est un composant clé de la famille de modèles vidéo IA Wan2.1 d’Alibaba,

Ambitions de l'IA en Chine et stratégie de résilience de Huawei selon le PDG Ren Zhengfei

Le PDG de Huawei, Ren Zhengfei, partage des perspectives franches sur le paysage de l'IA en Chine et les défis auxquels son entreprise est confrontée.« Je n'y ai pas trop pensé », déclare Ren dans une

commentaires (38)

0/200

Ambitions de l'IA en Chine et stratégie de résilience de Huawei selon le PDG Ren Zhengfei

Le PDG de Huawei, Ren Zhengfei, partage des perspectives franches sur le paysage de l'IA en Chine et les défis auxquels son entreprise est confrontée.« Je n'y ai pas trop pensé », déclare Ren dans une

commentaires (38)

0/200

![HarryRoberts]() HarryRoberts

HarryRoberts

11 août 2025 20:01:05 UTC+02:00

11 août 2025 20:01:05 UTC+02:00

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

1 août 2025 15:47:34 UTC+02:00

1 août 2025 15:47:34 UTC+02:00

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

22 juillet 2025 09:35:51 UTC+02:00

22 juillet 2025 09:35:51 UTC+02:00

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

21 avril 2025 10:06:03 UTC+02:00

21 avril 2025 10:06:03 UTC+02:00

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

20 avril 2025 00:25:56 UTC+02:00

20 avril 2025 00:25:56 UTC+02:00

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

19 avril 2025 18:38:42 UTC+02:00

19 avril 2025 18:38:42 UTC+02:00

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

L'utilisation de l'IA par la Chine pour renforcer ses capacités de censure a atteint un nouveau niveau, comme le révèle une base de données divulguée contenant 133 000 exemples de contenus signalés pour leur sensibilité par le gouvernement chinois. Ce modèle de langage de grande échelle (LLM) sophistiqué est conçu pour détecter et censurer automatiquement des contenus liés à une large gamme de sujets, allant de la pauvreté dans les zones rurales à la corruption au sein du Parti communiste, et même à la satire politique subtile.

Selon Xiao Qiang, chercheur à UC Berkeley spécialisé dans la censure chinoise, cette base de données est une "preuve claire" que le gouvernement chinois ou ses affiliés utilisent des LLM pour renforcer leurs efforts de répression. Contrairement aux méthodes traditionnelles qui reposent sur des modérateurs humains et le filtrage par mots-clés, cette approche pilotée par l'IA peut considérablement améliorer l'efficacité et la précision de la gestion de l'information contrôlée par l'État.

Le jeu de données, découvert par le chercheur en sécurité NetAskari sur une base de données Elasticsearch non sécurisée hébergée sur un serveur Baidu, inclut des entrées récentes de décembre 2024. On ignore qui a précisément créé ce jeu de données, mais son objectif est évident : entraîner un LLM à identifier et signaler des contenus liés à des sujets sensibles tels que la pollution, la sécurité alimentaire, la fraude financière, les conflits du travail et les questions militaires. La satire politique, surtout lorsqu'elle implique des analogies historiques ou des références à Taïwan, est également une cible prioritaire.

Les données d'entraînement incluent divers exemples de contenus susceptibles de provoquer des troubles sociaux, tels que des plaintes concernant des officiers de police corrompus, des rapports sur la pauvreté rurale et des informations sur des responsables du Parti communiste expulsés. Le jeu de données contient également de nombreuses références à Taïwan et à des sujets liés à l'armée, le mot chinois pour Taïwan (台湾) apparaissant plus de 15 000 fois.

L'utilisation prévue du jeu de données est décrite comme un "travail d'opinion publique", un terme que Michael Caster d'Article 19 explique comme étant généralement associé à l'Administration du cyberespace de Chine (CAC) et impliquant des efforts de censure et de propagande. Cela correspond à la vision du président chinois Xi Jinping, qui considère Internet comme la "première ligne" du travail d'opinion publique du Parti communiste.

Ce développement s'inscrit dans une tendance plus large des régimes autoritaires adoptant la technologie de l'IA à des fins répressives. OpenAI a récemment rapporté qu'un acteur non identifié, probablement originaire de Chine, a utilisé l'IA générative pour surveiller les réseaux sociaux et transmettre des publications antigouvernementales au gouvernement chinois. La même technologie a également été utilisée pour générer des commentaires critiques à l'encontre d'une dissidente chinoise de premier plan, Cai Xia.

Alors que les méthodes de censure traditionnelles de la Chine reposent sur des algorithmes de base pour bloquer les termes interdits, l'utilisation de LLM représente une avancée significative. Ces systèmes d'IA peuvent détecter même des critiques subtiles à une échelle massive et s'améliorer continuellement à mesure qu'ils traitent plus de données.

"Je pense qu'il est crucial de souligner comment la censure pilotée par l'IA évolue, rendant le contrôle de l'État sur le discours public encore plus sophistiqué, surtout à une époque où les modèles d'IA chinois comme DeepSeek font des vagues," a déclaré Xiao Qiang à TechCrunch.

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

Alibaba Dévoile Wan2.1-VACE : Solution Vidéo IA Open-Source

Alibaba a présenté Wan2.1-VACE, un modèle d'IA open-source prêt à transformer les processus de création et d'édition vidéo.VACE est un composant clé de la famille de modèles vidéo IA Wan2.1 d’Alibaba,

Alibaba Dévoile Wan2.1-VACE : Solution Vidéo IA Open-Source

Alibaba a présenté Wan2.1-VACE, un modèle d'IA open-source prêt à transformer les processus de création et d'édition vidéo.VACE est un composant clé de la famille de modèles vidéo IA Wan2.1 d’Alibaba,

11 août 2025 20:01:05 UTC+02:00

11 août 2025 20:01:05 UTC+02:00

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

1 août 2025 15:47:34 UTC+02:00

1 août 2025 15:47:34 UTC+02:00

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

22 juillet 2025 09:35:51 UTC+02:00

22 juillet 2025 09:35:51 UTC+02:00

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

21 avril 2025 10:06:03 UTC+02:00

21 avril 2025 10:06:03 UTC+02:00

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

20 avril 2025 00:25:56 UTC+02:00

20 avril 2025 00:25:56 UTC+02:00

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

19 avril 2025 18:38:42 UTC+02:00

19 avril 2025 18:38:42 UTC+02:00

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0