Censura de IA china expuesta por datos filtrados

El uso de la IA por parte de China para mejorar sus capacidades de censura ha alcanzado un nuevo nivel, según revela una base de datos filtrada que contiene 133,000 ejemplos de contenido marcado por su sensibilidad por el gobierno chino. Este sofisticado modelo de lenguaje grande (LLM) está diseñado para detectar y censurar automáticamente contenido relacionado con una amplia gama de temas, desde la pobreza en áreas rurales hasta la corrupción dentro del Partido Comunista e incluso sátiras políticas sutiles.

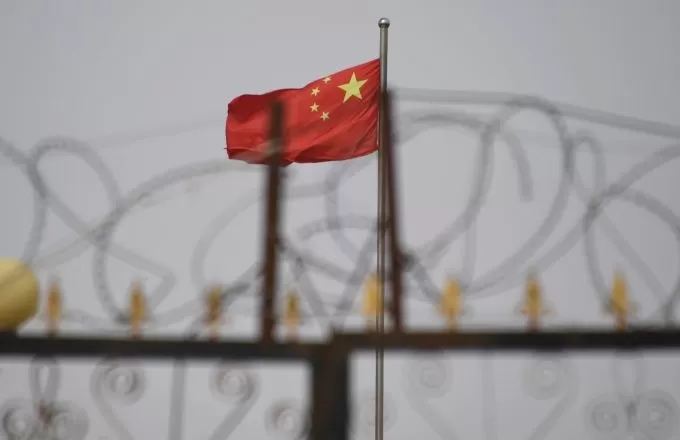

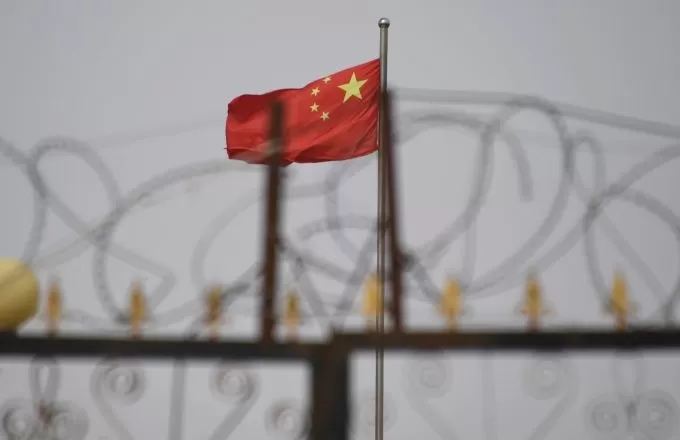

Esta foto tomada el 4 de junio de 2019 muestra la bandera china detrás de alambre de púas en un complejo residencial en Yengisar, al sur de Kashgar, en la región occidental de Xinjiang, China. Créditos de la imagen: Greg Baker / AFP / Getty Images Según Xiao Qiang, investigador de UC Berkeley especializado en censura china, esta base de datos es "evidencia clara" de que el gobierno chino o sus afiliados están utilizando LLMs para reforzar sus esfuerzos de represión. A diferencia de los métodos tradicionales que dependen de moderadores humanos y filtrado de palabras clave, este enfoque impulsado por IA puede mejorar significativamente la eficiencia y precisión de la gestión de información controlada por el estado.

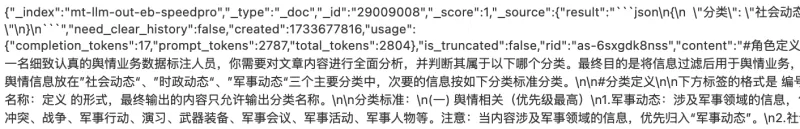

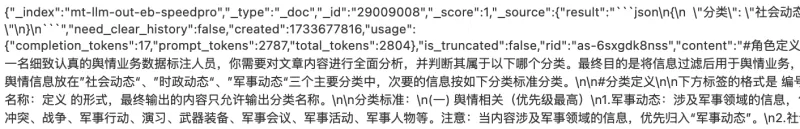

El conjunto de datos, descubierto por el investigador de seguridad NetAskari en una base de datos Elasticsearch no segura alojada en un servidor de Baidu, incluye entradas recientes de diciembre de 2024. No está claro quién creó exactamente el conjunto de datos, pero su propósito es evidente: entrenar un LLM para identificar y marcar contenido relacionado con temas sensibles como la contaminación, la seguridad alimentaria, el fraude financiero, los conflictos laborales y asuntos militares. La sátira política, especialmente cuando involucra analogías históricas o referencias a Taiwán, también es un objetivo de alta prioridad.

Créditos de la imagen: Charles Rollet Los datos de entrenamiento incluyen varios ejemplos de contenido que podrían potencialmente generar disturbios sociales, como quejas sobre oficiales de policía corruptos, informes sobre pobreza rural y noticias sobre funcionarios del Partido Comunista expulsados. El conjunto de datos también contiene numerosas referencias a Taiwán y temas relacionados con el ejército, con la palabra china para Taiwán (台湾) apareciendo más de 15,000 veces.

El uso previsto del conjunto de datos se describe como "trabajo de opinión pública", un término que Michael Caster de Article 19 explica que generalmente está asociado con la Administración del Ciberespacio de China (CAC) e implica esfuerzos de censura y propaganda. Esto se alinea con la visión del presidente chino Xi Jinping de internet como la "primera línea" del trabajo de opinión pública del Partido Comunista.

Este desarrollo es parte de una tendencia más amplia de regímenes autoritarios que adoptan tecnología de IA para fines represivos. OpenAI informó recientemente que un actor no identificado, probablemente de China, utilizó IA generativa para monitorear redes sociales y reenviar publicaciones antigubernamentales al gobierno chino. La misma tecnología también se utilizó para generar comentarios críticos sobre una destacada disidente china, Cai Xia.

Mientras que los métodos de censura tradicionales de China dependen de algoritmos básicos para bloquear términos en la lista negra, el uso de LLMs representa un avance significativo. Estos sistemas de IA pueden detectar incluso críticas sutiles a gran escala y mejorar continuamente a medida que procesan más datos.

"Creo que es crucial destacar cómo la censura impulsada por IA está evolucionando, haciendo que el control estatal sobre el discurso público sea aún más sofisticado, especialmente en un momento en que modelos de IA chinos como DeepSeek están causando revuelo," dijo Xiao Qiang a TechCrunch.

Artículo relacionado

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

Alibaba presenta Wan2.1-VACE: solución de video de IA de código abierto

Alibaba ha presentado Wan2.1-VACE, un modelo de IA de código abierto diseñado para transformar los procesos de creación y edición de videos.VACE es un componente clave de la familia de modelos de IA d

comentario (38)

0/200

Alibaba presenta Wan2.1-VACE: solución de video de IA de código abierto

Alibaba ha presentado Wan2.1-VACE, un modelo de IA de código abierto diseñado para transformar los procesos de creación y edición de videos.VACE es un componente clave de la familia de modelos de IA d

comentario (38)

0/200

![HarryRoberts]() HarryRoberts

HarryRoberts

11 de agosto de 2025 20:01:05 GMT+02:00

11 de agosto de 2025 20:01:05 GMT+02:00

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

1 de agosto de 2025 15:47:34 GMT+02:00

1 de agosto de 2025 15:47:34 GMT+02:00

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

22 de julio de 2025 09:35:51 GMT+02:00

22 de julio de 2025 09:35:51 GMT+02:00

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

21 de abril de 2025 10:06:03 GMT+02:00

21 de abril de 2025 10:06:03 GMT+02:00

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

20 de abril de 2025 00:25:56 GMT+02:00

20 de abril de 2025 00:25:56 GMT+02:00

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

19 de abril de 2025 18:38:42 GMT+02:00

19 de abril de 2025 18:38:42 GMT+02:00

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

El uso de la IA por parte de China para mejorar sus capacidades de censura ha alcanzado un nuevo nivel, según revela una base de datos filtrada que contiene 133,000 ejemplos de contenido marcado por su sensibilidad por el gobierno chino. Este sofisticado modelo de lenguaje grande (LLM) está diseñado para detectar y censurar automáticamente contenido relacionado con una amplia gama de temas, desde la pobreza en áreas rurales hasta la corrupción dentro del Partido Comunista e incluso sátiras políticas sutiles.

Según Xiao Qiang, investigador de UC Berkeley especializado en censura china, esta base de datos es "evidencia clara" de que el gobierno chino o sus afiliados están utilizando LLMs para reforzar sus esfuerzos de represión. A diferencia de los métodos tradicionales que dependen de moderadores humanos y filtrado de palabras clave, este enfoque impulsado por IA puede mejorar significativamente la eficiencia y precisión de la gestión de información controlada por el estado.

El conjunto de datos, descubierto por el investigador de seguridad NetAskari en una base de datos Elasticsearch no segura alojada en un servidor de Baidu, incluye entradas recientes de diciembre de 2024. No está claro quién creó exactamente el conjunto de datos, pero su propósito es evidente: entrenar un LLM para identificar y marcar contenido relacionado con temas sensibles como la contaminación, la seguridad alimentaria, el fraude financiero, los conflictos laborales y asuntos militares. La sátira política, especialmente cuando involucra analogías históricas o referencias a Taiwán, también es un objetivo de alta prioridad.

Los datos de entrenamiento incluyen varios ejemplos de contenido que podrían potencialmente generar disturbios sociales, como quejas sobre oficiales de policía corruptos, informes sobre pobreza rural y noticias sobre funcionarios del Partido Comunista expulsados. El conjunto de datos también contiene numerosas referencias a Taiwán y temas relacionados con el ejército, con la palabra china para Taiwán (台湾) apareciendo más de 15,000 veces.

El uso previsto del conjunto de datos se describe como "trabajo de opinión pública", un término que Michael Caster de Article 19 explica que generalmente está asociado con la Administración del Ciberespacio de China (CAC) e implica esfuerzos de censura y propaganda. Esto se alinea con la visión del presidente chino Xi Jinping de internet como la "primera línea" del trabajo de opinión pública del Partido Comunista.

Este desarrollo es parte de una tendencia más amplia de regímenes autoritarios que adoptan tecnología de IA para fines represivos. OpenAI informó recientemente que un actor no identificado, probablemente de China, utilizó IA generativa para monitorear redes sociales y reenviar publicaciones antigubernamentales al gobierno chino. La misma tecnología también se utilizó para generar comentarios críticos sobre una destacada disidente china, Cai Xia.

Mientras que los métodos de censura tradicionales de China dependen de algoritmos básicos para bloquear términos en la lista negra, el uso de LLMs representa un avance significativo. Estos sistemas de IA pueden detectar incluso críticas sutiles a gran escala y mejorar continuamente a medida que procesan más datos.

"Creo que es crucial destacar cómo la censura impulsada por IA está evolucionando, haciendo que el control estatal sobre el discurso público sea aún más sofisticado, especialmente en un momento en que modelos de IA chinos como DeepSeek están causando revuelo," dijo Xiao Qiang a TechCrunch.

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

Alibaba presenta Wan2.1-VACE: solución de video de IA de código abierto

Alibaba ha presentado Wan2.1-VACE, un modelo de IA de código abierto diseñado para transformar los procesos de creación y edición de videos.VACE es un componente clave de la familia de modelos de IA d

Alibaba presenta Wan2.1-VACE: solución de video de IA de código abierto

Alibaba ha presentado Wan2.1-VACE, un modelo de IA de código abierto diseñado para transformar los procesos de creación y edición de videos.VACE es un componente clave de la familia de modelos de IA d

11 de agosto de 2025 20:01:05 GMT+02:00

11 de agosto de 2025 20:01:05 GMT+02:00

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

1 de agosto de 2025 15:47:34 GMT+02:00

1 de agosto de 2025 15:47:34 GMT+02:00

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

22 de julio de 2025 09:35:51 GMT+02:00

22 de julio de 2025 09:35:51 GMT+02:00

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

21 de abril de 2025 10:06:03 GMT+02:00

21 de abril de 2025 10:06:03 GMT+02:00

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

20 de abril de 2025 00:25:56 GMT+02:00

20 de abril de 2025 00:25:56 GMT+02:00

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

19 de abril de 2025 18:38:42 GMT+02:00

19 de abril de 2025 18:38:42 GMT+02:00

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0