中國人工智能審查制度被洩漏的數據暴露

中國利用AI增強其審查能力已達到新水平,一個洩露的數據庫顯示,中國政府標記了133,000個敏感內容示例。這種精密的大型語言模型(LLM)旨在自動檢測和審查與廣泛主題相關的內容,從農村貧困到共產黨內部的腐敗,甚至是微妙的政治諷刺。

這張攝於2019年6月4日的照片顯示,中國新疆西部焉耆地區喀什以南的一個住宅區內,中國國旗在鐵絲網後。圖片來源:Greg Baker / AFP / Getty Images 據專攻中國審查研究的加州大學伯克利分校研究員蕭強表示,這個數據庫是“明確證據”,證明中國政府或其關聯機構正在使用LLM來加強其壓制行動。與依賴人工審核和關鍵詞過濾的傳統方法不同,這種AI驅動的方法能顯著提升國家控制資訊管理的效率和精確度。

該數據集由安全研究員NetAskari在百度伺服器上一個未受保護的Elasticsearch數據庫中發現,包含2024年12月的最新條目。目前尚不清楚數據集的具體創建者,但其目的顯而易見:訓練LLM以識別和標記與敏感話題相關的內容,如污染、食品安全、金融詐騙、勞資糾紛和軍事事務。政治諷刺,尤其是涉及歷史類比或台灣的內容,也是高度優先的目標。

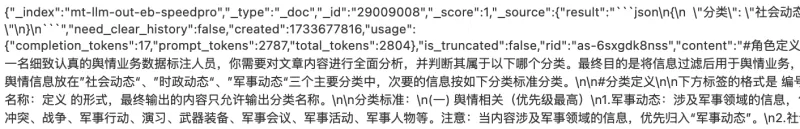

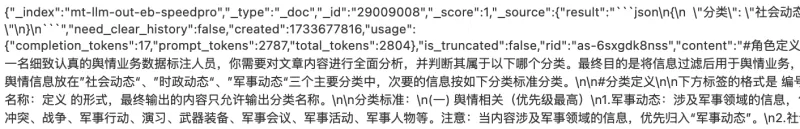

圖片來源:Charles Rollet 訓練數據包括可能引發社會動盪的各種內容示例,如對腐敗警察的投訴、農村貧困報導,以及被開除的共產黨官員的新聞。數據集還廣泛提及台灣和軍事相關話題,其中“台灣”一詞出現超過15,000次。

數據集的預定用途被描述為“輿論工作”,Article 19的Michael Caster解釋,這一術語通常與中國國家互聯網資訊辦公室(CAC)相關,涉及審查和宣傳工作。這與中國國家主席習近平將互聯網視為共產黨輿論工作“前線”的觀點一致。

這一發展是專制政權採用AI技術進行壓制目的的更廣泛趨勢的一部分。OpenAI最近報告稱,一個可能來自中國的未知行動者使用生成式AI監控社交媒體,並將反政府帖子轉發給中國政府。同一技術還被用於生成對著名中國異見人士蔡霞的批評評論。

雖然中國的傳統審查方法依賴基本算法來屏蔽黑名單術語,但LLM的使用代表了重大進展。這些AI系統能夠在大規模檢測甚至微妙的批評,並隨著處理更多數據而不斷改進。

“我認為必須強調AI驅動的審查如何演變,使國家對公共話語的控制更加精密,特別是在DeepSeek等中國AI模型掀起波瀾的時刻,”蕭強對TechCrunch表示。

相關文章

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

阿里巴巴推出Wan2.1-VACE:開源AI視頻解決方案

阿里巴巴推出了Wan2.1-VACE,一款開源AI模型,旨在改變視頻創作與編輯流程。VACE是阿里巴巴Wan2.1視頻AI模型系列的關鍵組成部分,公司宣稱這是「業界首個為多樣化視頻生成與編輯任務提供全面解決方案的開源模型」。如果阿里巴巴能夠簡化視頻製作流程,將多種工具整合到單一平台,可能會重新定義行業標準。VACE能做什麼?它可以從多種輸入生成視頻,例如文字提示、靜態圖像或短視頻片段。除了視頻創作

阿里巴巴推出Wan2.1-VACE:開源AI視頻解決方案

阿里巴巴推出了Wan2.1-VACE,一款開源AI模型,旨在改變視頻創作與編輯流程。VACE是阿里巴巴Wan2.1視頻AI模型系列的關鍵組成部分,公司宣稱這是「業界首個為多樣化視頻生成與編輯任務提供全面解決方案的開源模型」。如果阿里巴巴能夠簡化視頻製作流程,將多種工具整合到單一平台,可能會重新定義行業標準。VACE能做什麼?它可以從多種輸入生成視頻,例如文字提示、靜態圖像或短視頻片段。除了視頻創作

華為首席執行官任正非談中國AI雄心與韌性策略

華為首席執行官任正非分享對中國AI格局及公司面臨挑戰的坦率見解。「我沒多想,」任在人民日報問答中表示。「過多思考無益。」在策略規劃與危機應對的時代,他的建議簡單直接:「無視障礙,行動並穩步前進。」這種理念引導華為應對全球制裁與限制,體現任正非回應中的沉靜決心。談及華為Ascend AI晶片,任保持坦誠,避免誇大。他承認現實不如炒作。「美國誇大了華為的進展。我們還沒那麼先進,」他承認,指出其晶片落後

評論 (38)

0/200

華為首席執行官任正非談中國AI雄心與韌性策略

華為首席執行官任正非分享對中國AI格局及公司面臨挑戰的坦率見解。「我沒多想,」任在人民日報問答中表示。「過多思考無益。」在策略規劃與危機應對的時代,他的建議簡單直接:「無視障礙,行動並穩步前進。」這種理念引導華為應對全球制裁與限制,體現任正非回應中的沉靜決心。談及華為Ascend AI晶片,任保持坦誠,避免誇大。他承認現實不如炒作。「美國誇大了華為的進展。我們還沒那麼先進,」他承認,指出其晶片落後

評論 (38)

0/200

![HarryRoberts]() HarryRoberts

HarryRoberts

2025-08-12 02:01:05

2025-08-12 02:01:05

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

2025-08-01 21:47:34

2025-08-01 21:47:34

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

2025-07-22 15:35:51

2025-07-22 15:35:51

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

2025-04-21 16:06:03

2025-04-21 16:06:03

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

2025-04-20 06:25:56

2025-04-20 06:25:56

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

2025-04-20 00:38:42

2025-04-20 00:38:42

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

中國利用AI增強其審查能力已達到新水平,一個洩露的數據庫顯示,中國政府標記了133,000個敏感內容示例。這種精密的大型語言模型(LLM)旨在自動檢測和審查與廣泛主題相關的內容,從農村貧困到共產黨內部的腐敗,甚至是微妙的政治諷刺。

據專攻中國審查研究的加州大學伯克利分校研究員蕭強表示,這個數據庫是“明確證據”,證明中國政府或其關聯機構正在使用LLM來加強其壓制行動。與依賴人工審核和關鍵詞過濾的傳統方法不同,這種AI驅動的方法能顯著提升國家控制資訊管理的效率和精確度。

該數據集由安全研究員NetAskari在百度伺服器上一個未受保護的Elasticsearch數據庫中發現,包含2024年12月的最新條目。目前尚不清楚數據集的具體創建者,但其目的顯而易見:訓練LLM以識別和標記與敏感話題相關的內容,如污染、食品安全、金融詐騙、勞資糾紛和軍事事務。政治諷刺,尤其是涉及歷史類比或台灣的內容,也是高度優先的目標。

訓練數據包括可能引發社會動盪的各種內容示例,如對腐敗警察的投訴、農村貧困報導,以及被開除的共產黨官員的新聞。數據集還廣泛提及台灣和軍事相關話題,其中“台灣”一詞出現超過15,000次。

數據集的預定用途被描述為“輿論工作”,Article 19的Michael Caster解釋,這一術語通常與中國國家互聯網資訊辦公室(CAC)相關,涉及審查和宣傳工作。這與中國國家主席習近平將互聯網視為共產黨輿論工作“前線”的觀點一致。

這一發展是專制政權採用AI技術進行壓制目的的更廣泛趨勢的一部分。OpenAI最近報告稱,一個可能來自中國的未知行動者使用生成式AI監控社交媒體,並將反政府帖子轉發給中國政府。同一技術還被用於生成對著名中國異見人士蔡霞的批評評論。

雖然中國的傳統審查方法依賴基本算法來屏蔽黑名單術語,但LLM的使用代表了重大進展。這些AI系統能夠在大規模檢測甚至微妙的批評,並隨著處理更多數據而不斷改進。

“我認為必須強調AI驅動的審查如何演變,使國家對公共話語的控制更加精密,特別是在DeepSeek等中國AI模型掀起波瀾的時刻,”蕭強對TechCrunch表示。

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

阿里巴巴推出Wan2.1-VACE:開源AI視頻解決方案

阿里巴巴推出了Wan2.1-VACE,一款開源AI模型,旨在改變視頻創作與編輯流程。VACE是阿里巴巴Wan2.1視頻AI模型系列的關鍵組成部分,公司宣稱這是「業界首個為多樣化視頻生成與編輯任務提供全面解決方案的開源模型」。如果阿里巴巴能夠簡化視頻製作流程,將多種工具整合到單一平台,可能會重新定義行業標準。VACE能做什麼?它可以從多種輸入生成視頻,例如文字提示、靜態圖像或短視頻片段。除了視頻創作

阿里巴巴推出Wan2.1-VACE:開源AI視頻解決方案

阿里巴巴推出了Wan2.1-VACE,一款開源AI模型,旨在改變視頻創作與編輯流程。VACE是阿里巴巴Wan2.1視頻AI模型系列的關鍵組成部分,公司宣稱這是「業界首個為多樣化視頻生成與編輯任務提供全面解決方案的開源模型」。如果阿里巴巴能夠簡化視頻製作流程,將多種工具整合到單一平台,可能會重新定義行業標準。VACE能做什麼?它可以從多種輸入生成視頻,例如文字提示、靜態圖像或短視頻片段。除了視頻創作

2025-08-12 02:01:05

2025-08-12 02:01:05

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

2025-08-01 21:47:34

2025-08-01 21:47:34

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

2025-07-22 15:35:51

2025-07-22 15:35:51

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

2025-04-21 16:06:03

2025-04-21 16:06:03

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

2025-04-20 06:25:56

2025-04-20 06:25:56

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

2025-04-20 00:38:42

2025-04-20 00:38:42

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0