Censura da IA chinesa exposta por dados vazados

A utilização da IA pela China para aprimorar suas capacidades de censura alcançou um novo nível, conforme revelado por um banco de dados vazado contendo 133.000 exemplos de conteúdo sinalizado como sensível pelo governo chinês. Este modelo de linguagem de grande escala (LLM) sofisticado foi projetado para detectar e censurar automaticamente conteúdos relacionados a uma ampla gama de tópicos, desde pobreza em áreas rurais até corrupção dentro do Partido Comunista e até mesmo sátiras políticas sutis.

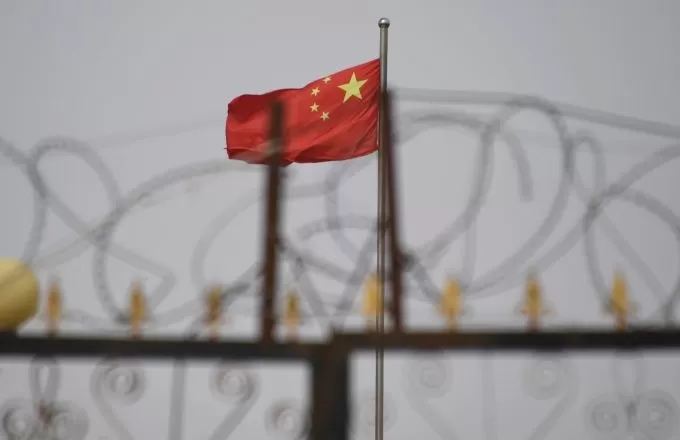

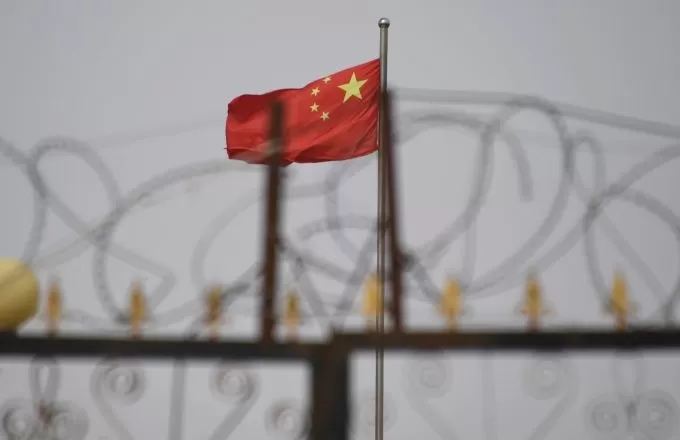

Esta foto, tirada em 4 de junho de 2019, mostra a bandeira chinesa atrás de arames farpados em um complexo residencial em Yengisar, ao sul de Kashgar, na região oeste de Xinjiang, na China. Créditos da imagem: Greg Baker / AFP / Getty Images De acordo com Xiao Qiang, pesquisador da UC Berkeley especializado em censura chinesa, este banco de dados é uma "evidência clara" de que o governo chinês ou seus afiliados estão usando LLMs para reforçar seus esforços de repressão. Diferentemente dos métodos tradicionais que dependem de moderadores humanos e filtragem por palavras-chave, essa abordagem baseada em IA pode aumentar significativamente a eficiência e a precisão do gerenciamento de informações controlado pelo estado.

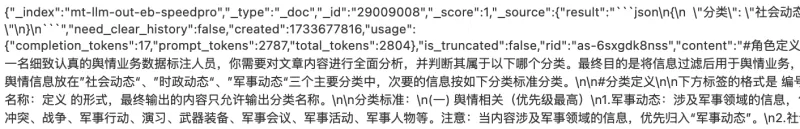

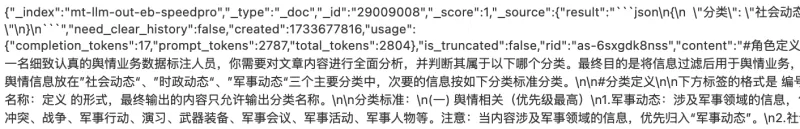

O conjunto de dados, descoberto pelo pesquisador de segurança NetAskari em um banco de dados Elasticsearch não seguro hospedado em um servidor Baidu!

, inclui entradas recentes de dezembro de 2024. Não está claro quem exatamente criou o conjunto de dados, mas seu propósito é evidente: treinar um LLM para identificar e sinalizar conteúdos relacionados a tópicos sensíveis, como poluição, segurança alimentar, fraudes financeiras, disputas trabalhistas e assuntos militares. A sátira política, especialmente quando envolve analogias históricas ou referências a Taiwan, também é um alvo de alta prioridade.

Créditos da imagem: Charles Rollet Os dados de treinamento incluem vários exemplos de conteúdos que poderiam potencialmente incitar agitação social, como reclamações sobre policiais corruptos, relatórios sobre pobreza rural e notícias sobre membros expulsos do Partido Comunista. O conjunto de dados também contém extensas referências a Taiwan e tópicos relacionados ao exército, com a palavra chinesa para Taiwan (台湾) aparecendo mais de 15.000 vezes.

O uso pretendido do conjunto de dados é descrito como "trabalho de opinião pública", um termo que Michael Caster, da Article 19, explica estar tipicamente associado à Administração do Ciberespaço da China (CAC) e envolve esforços de censura e propaganda. Isso está alinhado com a visão do presidente chinês Xi Jinping sobre a internet como a "linha de frente" do trabalho de opinião pública do Partido Comunista.

Esse desenvolvimento faz parte de uma tendência mais ampla de regimes autoritários adotando tecnologia de IA para propósitos repressivos. A OpenAI relatou recentemente que um ator não identificado, provavelmente da China, usou IA generativa para monitorar redes sociais e encaminhar postagens antigoverno ao governo chinês. A mesma tecnologia também foi usada para gerar comentários críticos sobre a proeminente dissidente chinesa, Cai Xia.

Embora os métodos tradicionais de censura da China dependam de algoritmos básicos para bloquear termos na lista negra, o uso de LLMs representa um avanço significativo. Esses sistemas de IA podem detectar críticas até mesmo sutis em uma escala massiva e melhorar continuamente à medida que processam mais dados.

"Acho crucial destacar como a censura impulsionada por IA está evoluindo, tornando o controle estatal sobre o discurso público ainda mais sofisticado, especialmente em um momento em que modelos de IA chineses, como o DeepSeek, estão fazendo ondas," disse Xiao Qiang ao TechCrunch.

Artigo relacionado

ByteDance Revela o Modelo de IA Seed-Thinking-v1.5 para Impulsionar Capacidades de Raciocínio

A corrida por IA com raciocínio avançado começou com o modelo o1 da OpenAI em setembro de 2024, ganhando impulso com o lançamento do R1 da DeepSeek em janeiro de 2025.Os principais desenvolvedores de

ByteDance Revela o Modelo de IA Seed-Thinking-v1.5 para Impulsionar Capacidades de Raciocínio

A corrida por IA com raciocínio avançado começou com o modelo o1 da OpenAI em setembro de 2024, ganhando impulso com o lançamento do R1 da DeepSeek em janeiro de 2025.Os principais desenvolvedores de

Alibaba Revela Wan2.1-VACE: Solução de Vídeo de IA de Código Aberto

Alibaba apresentou o Wan2.1-VACE, um modelo de IA de código aberto pronto para transformar os processos de criação e edição de vídeos.VACE é um componente chave da família de modelos de IA de vídeo Wa

Alibaba Revela Wan2.1-VACE: Solução de Vídeo de IA de Código Aberto

Alibaba apresentou o Wan2.1-VACE, um modelo de IA de código aberto pronto para transformar os processos de criação e edição de vídeos.VACE é um componente chave da família de modelos de IA de vídeo Wa

CEO da Huawei, Ren Zhengfei, sobre as Ambições de IA da China e Estratégia de Resiliência

O CEO da Huawei, Ren Zhengfei, compartilha insights francos sobre o cenário de IA da China e os desafios enfrentados por sua empresa."Não me detive nisso," Ren afirma em um Q&A do People’s Daily. "Pen

Comentários (38)

0/200

CEO da Huawei, Ren Zhengfei, sobre as Ambições de IA da China e Estratégia de Resiliência

O CEO da Huawei, Ren Zhengfei, compartilha insights francos sobre o cenário de IA da China e os desafios enfrentados por sua empresa."Não me detive nisso," Ren afirma em um Q&A do People’s Daily. "Pen

Comentários (38)

0/200

![HarryRoberts]() HarryRoberts

HarryRoberts

11 de Agosto de 2025 à5 19:01:05 WEST

11 de Agosto de 2025 à5 19:01:05 WEST

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

1 de Agosto de 2025 à34 14:47:34 WEST

1 de Agosto de 2025 à34 14:47:34 WEST

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

22 de Julho de 2025 à51 08:35:51 WEST

22 de Julho de 2025 à51 08:35:51 WEST

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

21 de Abril de 2025 à3 09:06:03 WEST

21 de Abril de 2025 à3 09:06:03 WEST

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

19 de Abril de 2025 à56 23:25:56 WEST

19 de Abril de 2025 à56 23:25:56 WEST

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

19 de Abril de 2025 à42 17:38:42 WEST

19 de Abril de 2025 à42 17:38:42 WEST

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

A utilização da IA pela China para aprimorar suas capacidades de censura alcançou um novo nível, conforme revelado por um banco de dados vazado contendo 133.000 exemplos de conteúdo sinalizado como sensível pelo governo chinês. Este modelo de linguagem de grande escala (LLM) sofisticado foi projetado para detectar e censurar automaticamente conteúdos relacionados a uma ampla gama de tópicos, desde pobreza em áreas rurais até corrupção dentro do Partido Comunista e até mesmo sátiras políticas sutis.

De acordo com Xiao Qiang, pesquisador da UC Berkeley especializado em censura chinesa, este banco de dados é uma "evidência clara" de que o governo chinês ou seus afiliados estão usando LLMs para reforçar seus esforços de repressão. Diferentemente dos métodos tradicionais que dependem de moderadores humanos e filtragem por palavras-chave, essa abordagem baseada em IA pode aumentar significativamente a eficiência e a precisão do gerenciamento de informações controlado pelo estado.

O conjunto de dados, descoberto pelo pesquisador de segurança NetAskari em um banco de dados Elasticsearch não seguro hospedado em um servidor Baidu!

, inclui entradas recentes de dezembro de 2024. Não está claro quem exatamente criou o conjunto de dados, mas seu propósito é evidente: treinar um LLM para identificar e sinalizar conteúdos relacionados a tópicos sensíveis, como poluição, segurança alimentar, fraudes financeiras, disputas trabalhistas e assuntos militares. A sátira política, especialmente quando envolve analogias históricas ou referências a Taiwan, também é um alvo de alta prioridade.

Os dados de treinamento incluem vários exemplos de conteúdos que poderiam potencialmente incitar agitação social, como reclamações sobre policiais corruptos, relatórios sobre pobreza rural e notícias sobre membros expulsos do Partido Comunista. O conjunto de dados também contém extensas referências a Taiwan e tópicos relacionados ao exército, com a palavra chinesa para Taiwan (台湾) aparecendo mais de 15.000 vezes.

O uso pretendido do conjunto de dados é descrito como "trabalho de opinião pública", um termo que Michael Caster, da Article 19, explica estar tipicamente associado à Administração do Ciberespaço da China (CAC) e envolve esforços de censura e propaganda. Isso está alinhado com a visão do presidente chinês Xi Jinping sobre a internet como a "linha de frente" do trabalho de opinião pública do Partido Comunista.

Esse desenvolvimento faz parte de uma tendência mais ampla de regimes autoritários adotando tecnologia de IA para propósitos repressivos. A OpenAI relatou recentemente que um ator não identificado, provavelmente da China, usou IA generativa para monitorar redes sociais e encaminhar postagens antigoverno ao governo chinês. A mesma tecnologia também foi usada para gerar comentários críticos sobre a proeminente dissidente chinesa, Cai Xia.

Embora os métodos tradicionais de censura da China dependam de algoritmos básicos para bloquear termos na lista negra, o uso de LLMs representa um avanço significativo. Esses sistemas de IA podem detectar críticas até mesmo sutis em uma escala massiva e melhorar continuamente à medida que processam mais dados.

"Acho crucial destacar como a censura impulsionada por IA está evoluindo, tornando o controle estatal sobre o discurso público ainda mais sofisticado, especialmente em um momento em que modelos de IA chineses, como o DeepSeek, estão fazendo ondas," disse Xiao Qiang ao TechCrunch.

ByteDance Revela o Modelo de IA Seed-Thinking-v1.5 para Impulsionar Capacidades de Raciocínio

A corrida por IA com raciocínio avançado começou com o modelo o1 da OpenAI em setembro de 2024, ganhando impulso com o lançamento do R1 da DeepSeek em janeiro de 2025.Os principais desenvolvedores de

ByteDance Revela o Modelo de IA Seed-Thinking-v1.5 para Impulsionar Capacidades de Raciocínio

A corrida por IA com raciocínio avançado começou com o modelo o1 da OpenAI em setembro de 2024, ganhando impulso com o lançamento do R1 da DeepSeek em janeiro de 2025.Os principais desenvolvedores de

Alibaba Revela Wan2.1-VACE: Solução de Vídeo de IA de Código Aberto

Alibaba apresentou o Wan2.1-VACE, um modelo de IA de código aberto pronto para transformar os processos de criação e edição de vídeos.VACE é um componente chave da família de modelos de IA de vídeo Wa

Alibaba Revela Wan2.1-VACE: Solução de Vídeo de IA de Código Aberto

Alibaba apresentou o Wan2.1-VACE, um modelo de IA de código aberto pronto para transformar os processos de criação e edição de vídeos.VACE é um componente chave da família de modelos de IA de vídeo Wa

11 de Agosto de 2025 à5 19:01:05 WEST

11 de Agosto de 2025 à5 19:01:05 WEST

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

1 de Agosto de 2025 à34 14:47:34 WEST

1 de Agosto de 2025 à34 14:47:34 WEST

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

22 de Julho de 2025 à51 08:35:51 WEST

22 de Julho de 2025 à51 08:35:51 WEST

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

21 de Abril de 2025 à3 09:06:03 WEST

21 de Abril de 2025 à3 09:06:03 WEST

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

19 de Abril de 2025 à56 23:25:56 WEST

19 de Abril de 2025 à56 23:25:56 WEST

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

19 de Abril de 2025 à42 17:38:42 WEST

19 de Abril de 2025 à42 17:38:42 WEST

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0