中国人工智能审查制度被泄漏的数据暴露

中国利用人工智能增强其审查能力已达到一个新水平,一份泄露的数据库显示,中国政府标记了133,000个敏感内容示例。这一复杂的大型语言模型(LLM)旨在自动检测和审查与多种话题相关的内容,从农村贫困到共产党内部的腐败,甚至是微妙的政治讽刺。

这张摄于2019年6月4日的照片显示,中国西部新疆地区喀什以南的焉耆县一处住宅区内,中国国旗在铁丝网后。图片来源:Greg Baker / AFP / Getty Images 据加州大学伯克利分校专门研究中国审查制度的研究员肖强表示,这一数据库是“明确证据”,证明中国政府或其关联机构正在使用大型语言模型来加强其压制努力。与依赖人工审查员和关键词过滤的传统方法不同,这种人工智能驱动的方法可以显著提高国家控制信息管理的效率和精确度。

该数据集由安全研究员NetAskari在一个未受保护的、托管在百度服务器上的Elasticsearch数据库中发现,包含2024年12月的最新条目。目前尚不清楚具体是谁创建了这个数据集,但其目的显而易见:训练大型语言模型以识别和标记与敏感话题相关的内容,如污染、食品安全、金融诈骗、劳动争议和军事事务。政治讽刺,尤其是涉及历史类比或台湾的内容,也是优先审查目标。

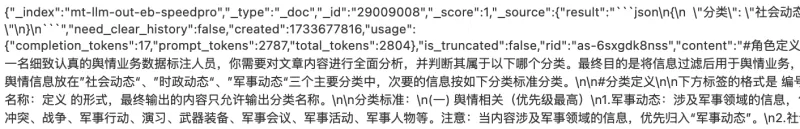

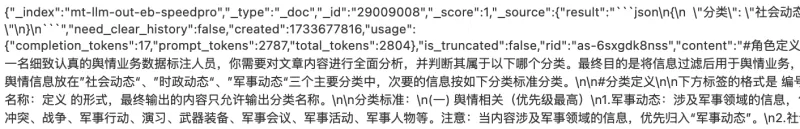

图片来源:Charles Rollet 训练数据包括可能引发社会动荡的各种内容示例,如对腐败警察的投诉、关于农村贫困的报道,以及关于被开除的共产党官员的新闻。数据集还包含大量关于台湾和军事相关话题的提及,其中“台湾”一词出现了超过15,000次。

数据集的用途被描述为“舆论工作”,Article 19的Michael Caster解释说,这个术语通常与中国国家互联网信息办公室(CAC)相关,涉及审查和宣传工作。这与习近平主席将互联网视为共产党舆论工作“前线”的观点一致。

这一发展是专制政权采用人工智能技术进行压制目的的更广泛趋势的一部分。OpenAI最近报告称,一个可能是来自中国的未识别行为者使用生成式人工智能监控社交媒体,并将反政府帖子转发给中国政府。同一技术还被用于生成针对著名中国异见人士蔡霞的批评评论。

虽然中国的传统审查方法依赖基本算法来屏蔽黑名单术语,但使用大型语言模型代表了重大进步。这些人工智能系统可以大规模检测甚至微妙的批评,并随着处理更多数据而不断改进。

“我认为必须强调人工智能驱动的审查如何演变,使国家对公共话语的控制更加复杂,尤其是在DeepSeek等中国人工智能模型掀起波澜的时刻,”肖强对TechCrunch表示。

相关文章

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

阿里巴巴发布Wan2.1-VACE:开源AI视频解决方案

阿里巴巴推出了Wan2.1-VACE,这是一个开源AI模型,有望改变视频创作和编辑流程。VACE是阿里巴巴Wan2.1视频AI模型系列的关键组成部分,公司宣称这是“业内首个为多样化视频生成和编辑任务提供全面解决方案的开源模型。”如果阿里巴巴能够简化视频制作流程,将多种工具整合到一个单一平台上,可能会重新定义行业标准。VACE能做什么?它可以从多种输入生成视频,例如文本提示、静态图像或短视频片段。除

阿里巴巴发布Wan2.1-VACE:开源AI视频解决方案

阿里巴巴推出了Wan2.1-VACE,这是一个开源AI模型,有望改变视频创作和编辑流程。VACE是阿里巴巴Wan2.1视频AI模型系列的关键组成部分,公司宣称这是“业内首个为多样化视频生成和编辑任务提供全面解决方案的开源模型。”如果阿里巴巴能够简化视频制作流程,将多种工具整合到一个单一平台上,可能会重新定义行业标准。VACE能做什么?它可以从多种输入生成视频,例如文本提示、静态图像或短视频片段。除

华为首席执行官任正非谈中国的AI雄心与韧性战略

华为首席执行官任正非分享对中国AI格局及公司面临挑战的坦诚见解。“我没多想,”任在《人民日报》问答中表示。“想太多无用。”在战略规划与危机应对的时代,他的建议直白有力:“无视障碍,稳步行动。”这种理念指导华为应对全球制裁与限制,体现任正非回应中的沉静决心。谈到华为的昇腾AI芯片,任保持坦率,避免夸大。他承认炒作超出现实。“美国夸大了华为的进展。我们还没那么先进,”他坦言,指出其芯片落后于顶级竞争者

评论 (38)

0/200

华为首席执行官任正非谈中国的AI雄心与韧性战略

华为首席执行官任正非分享对中国AI格局及公司面临挑战的坦诚见解。“我没多想,”任在《人民日报》问答中表示。“想太多无用。”在战略规划与危机应对的时代,他的建议直白有力:“无视障碍,稳步行动。”这种理念指导华为应对全球制裁与限制,体现任正非回应中的沉静决心。谈到华为的昇腾AI芯片,任保持坦率,避免夸大。他承认炒作超出现实。“美国夸大了华为的进展。我们还没那么先进,”他坦言,指出其芯片落后于顶级竞争者

评论 (38)

0/200

![HarryRoberts]() HarryRoberts

HarryRoberts

2025-08-12 02:01:05

2025-08-12 02:01:05

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

2025-08-01 21:47:34

2025-08-01 21:47:34

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

2025-07-22 15:35:51

2025-07-22 15:35:51

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

2025-04-21 16:06:03

2025-04-21 16:06:03

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

2025-04-20 06:25:56

2025-04-20 06:25:56

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

2025-04-20 00:38:42

2025-04-20 00:38:42

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

中国利用人工智能增强其审查能力已达到一个新水平,一份泄露的数据库显示,中国政府标记了133,000个敏感内容示例。这一复杂的大型语言模型(LLM)旨在自动检测和审查与多种话题相关的内容,从农村贫困到共产党内部的腐败,甚至是微妙的政治讽刺。

据加州大学伯克利分校专门研究中国审查制度的研究员肖强表示,这一数据库是“明确证据”,证明中国政府或其关联机构正在使用大型语言模型来加强其压制努力。与依赖人工审查员和关键词过滤的传统方法不同,这种人工智能驱动的方法可以显著提高国家控制信息管理的效率和精确度。

该数据集由安全研究员NetAskari在一个未受保护的、托管在百度服务器上的Elasticsearch数据库中发现,包含2024年12月的最新条目。目前尚不清楚具体是谁创建了这个数据集,但其目的显而易见:训练大型语言模型以识别和标记与敏感话题相关的内容,如污染、食品安全、金融诈骗、劳动争议和军事事务。政治讽刺,尤其是涉及历史类比或台湾的内容,也是优先审查目标。

训练数据包括可能引发社会动荡的各种内容示例,如对腐败警察的投诉、关于农村贫困的报道,以及关于被开除的共产党官员的新闻。数据集还包含大量关于台湾和军事相关话题的提及,其中“台湾”一词出现了超过15,000次。

数据集的用途被描述为“舆论工作”,Article 19的Michael Caster解释说,这个术语通常与中国国家互联网信息办公室(CAC)相关,涉及审查和宣传工作。这与习近平主席将互联网视为共产党舆论工作“前线”的观点一致。

这一发展是专制政权采用人工智能技术进行压制目的的更广泛趋势的一部分。OpenAI最近报告称,一个可能是来自中国的未识别行为者使用生成式人工智能监控社交媒体,并将反政府帖子转发给中国政府。同一技术还被用于生成针对著名中国异见人士蔡霞的批评评论。

虽然中国的传统审查方法依赖基本算法来屏蔽黑名单术语,但使用大型语言模型代表了重大进步。这些人工智能系统可以大规模检测甚至微妙的批评,并随着处理更多数据而不断改进。

“我认为必须强调人工智能驱动的审查如何演变,使国家对公共话语的控制更加复杂,尤其是在DeepSeek等中国人工智能模型掀起波澜的时刻,”肖强对TechCrunch表示。

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

阿里巴巴发布Wan2.1-VACE:开源AI视频解决方案

阿里巴巴推出了Wan2.1-VACE,这是一个开源AI模型,有望改变视频创作和编辑流程。VACE是阿里巴巴Wan2.1视频AI模型系列的关键组成部分,公司宣称这是“业内首个为多样化视频生成和编辑任务提供全面解决方案的开源模型。”如果阿里巴巴能够简化视频制作流程,将多种工具整合到一个单一平台上,可能会重新定义行业标准。VACE能做什么?它可以从多种输入生成视频,例如文本提示、静态图像或短视频片段。除

阿里巴巴发布Wan2.1-VACE:开源AI视频解决方案

阿里巴巴推出了Wan2.1-VACE,这是一个开源AI模型,有望改变视频创作和编辑流程。VACE是阿里巴巴Wan2.1视频AI模型系列的关键组成部分,公司宣称这是“业内首个为多样化视频生成和编辑任务提供全面解决方案的开源模型。”如果阿里巴巴能够简化视频制作流程,将多种工具整合到一个单一平台上,可能会重新定义行业标准。VACE能做什么?它可以从多种输入生成视频,例如文本提示、静态图像或短视频片段。除

2025-08-12 02:01:05

2025-08-12 02:01:05

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

2025-08-01 21:47:34

2025-08-01 21:47:34

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

2025-07-22 15:35:51

2025-07-22 15:35:51

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

2025-04-21 16:06:03

2025-04-21 16:06:03

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

2025-04-20 06:25:56

2025-04-20 06:25:56

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

2025-04-20 00:38:42

2025-04-20 00:38:42

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0