Китайская цензура ИИ, выявленная просочившимися данными

Использование Китаем искусственного интеллекта для усиления своих цензурных возможностей достигло нового уровня, как показывает утёкшая база данных, содержащая 133 000 примеров контента, помеченного как чувствительный китайским правительством. Эта сложная большая языковая модель (LLM) разработана для автоматического обнаружения и цензурирования контента, связанного с широким спектром тем, от бедности в сельских районах до коррупции в Коммунистической партии и даже тонкой политической сатиры.

Эта фотография, сделанная 4 июня 2019 года, показывает китайский флаг за колючей проволокой в жилом комплексе в Йенгисаре, к югу от Кашгара, в западном регионе Синьцзян в Китае. Источник изображения: Greg Baker / AFP / Getty Images По словам Сяо Цяна, исследователя из UC Berkeley, специализирующегося на китайской цензуре, эта база данных является "явным доказательством" того, что китайское правительство или его аффилированные структуры используют LLM для усиления своих репрессивных усилий. В отличие от традиционных методов, зависящих от модераторов-людей и фильтрации по ключевым словам, этот подход, основанный на искусственном интеллекте, значительно повышает эффективность и точность государственного управления информацией.

Набор данных, обнаруженный исследователем безопасности NetAskari в незащищённой базе данных Elasticsearch, размещённой на сервере Baidu, включает недавние записи от декабря 2024 года. Неясно, кто именно создал этот набор данных, но его цель очевидна: обучить LLM выявлять и помечать контент, связанный с чувствительными темами, такими как загрязнение окружающей среды, безопасность пищевых продуктов, финансовые махинации, трудовые споры и военные вопросы. Политическая сатира, особенно если она включает исторические аналогии или упоминания Тайваня, также является приоритетной целью.

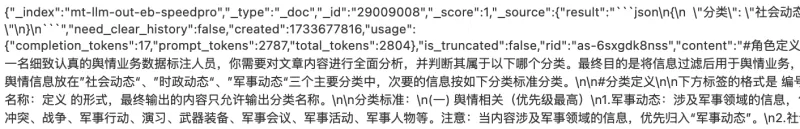

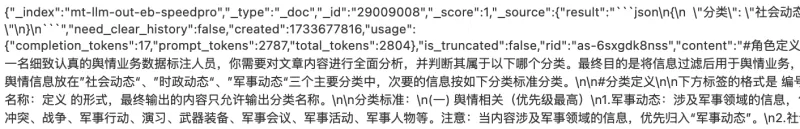

Источник изображения: Charles Rollet Обучающие данные включают различные примеры контента, который потенциально может вызвать социальные волнения, такие как жалобы на коррумпированных полицейских, сообщения о бедности в сельской местности и новости об исключённых из Коммунистической партии чиновниках. Набор данных также содержит множество ссылок на Тайвань и военные темы, при этом китайское слово для Тайваня (台湾) встречается более 15 000 раз.

Предполагаемое использование набора данных описывается как "работа с общественным мнением", термин, который, по словам Майкла Кастера из Article 19, обычно ассоциируется с Управлением киберпространства Китая (CAC) и включает усилия по цензуре и пропаганде. Это соответствует взглядам президента Китая Си Цзиньпина, который считает интернет "передовой линией" работы Коммунистической партии с общественным мнением.

Это развитие является частью более широкой тенденции, когда авторитарные режимы используют технологии искусственного интеллекта в репрессивных целях. OpenAI недавно сообщила, что неустановленный субъект, вероятно из Китая, использовал генеративный ИИ для мониторинга социальных сетей и пересылки антиправительственных постов китайскому правительству. Та же технология использовалась для генерации критических комментариев о известной китайской диссидентке Цай Ся.

Хотя традиционные методы цензуры в Китае полагаются на базовые алгоритмы для блокировки запрещённых терминов, использование LLM представляет значительный прогресс. Эти системы ИИ способны обнаруживать даже тонкую критику в массовом масштабе и постоянно совершенствуются по мере обработки большего объёма данных.

"Я считаю важным подчеркнуть, как развивается цензура, основанная на искусственном интеллекте, делая государственный контроль над общественным дискурсом ещё более изощрённым, особенно в то время, когда китайские модели ИИ, такие как DeepSeek, вызывают волну интереса", — сказал Сяо Цян в интервью TechCrunch.

Связанная статья

ByteDance представляет модель ИИ Seed-Thinking-v1.5 для усиления способностей к рассуждению

Гонка за продвинутыми ИИ с функцией рассуждения началась с модели o1 от OpenAI в сентябре 2024 года, набрав обороты с запуском R1 от DeepSeek в январе 2025 года.Крупные разработчики ИИ соревнуются в с

ByteDance представляет модель ИИ Seed-Thinking-v1.5 для усиления способностей к рассуждению

Гонка за продвинутыми ИИ с функцией рассуждения началась с модели o1 от OpenAI в сентябре 2024 года, набрав обороты с запуском R1 от DeepSeek в январе 2025 года.Крупные разработчики ИИ соревнуются в с

Alibaba представляет Wan2.1-VACE: Открытое решение для видео с ИИ

Alibaba представила Wan2.1-VACE, модель ИИ с открытым исходным кодом, которая призвана трансформировать процессы создания и редактирования видео.VACE является ключевым компонентом семейства видео моде

Alibaba представляет Wan2.1-VACE: Открытое решение для видео с ИИ

Alibaba представила Wan2.1-VACE, модель ИИ с открытым исходным кодом, которая призвана трансформировать процессы создания и редактирования видео.VACE является ключевым компонентом семейства видео моде

Генеральный директор Huawei Рен Чжэнфэй о амбициях Китая в области ИИ и стратегии устойчивости

Генеральный директор Huawei Рен Чжэнфэй делится откровенными взглядами на ландшафт ИИ в Китае и вызовы, с которыми сталкивается его компания.«Я не зацикливался на этом», — заявляет Рен в интервью Peop

Комментарии (38)

Генеральный директор Huawei Рен Чжэнфэй о амбициях Китая в области ИИ и стратегии устойчивости

Генеральный директор Huawei Рен Чжэнфэй делится откровенными взглядами на ландшафт ИИ в Китае и вызовы, с которыми сталкивается его компания.«Я не зацикливался на этом», — заявляет Рен в интервью Peop

Комментарии (38)

![HarryRoberts]() HarryRoberts

HarryRoberts

11 августа 2025 г., 21:01:05 GMT+03:00

11 августа 2025 г., 21:01:05 GMT+03:00

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

1 августа 2025 г., 16:47:34 GMT+03:00

1 августа 2025 г., 16:47:34 GMT+03:00

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

22 июля 2025 г., 10:35:51 GMT+03:00

22 июля 2025 г., 10:35:51 GMT+03:00

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

21 апреля 2025 г., 11:06:03 GMT+03:00

21 апреля 2025 г., 11:06:03 GMT+03:00

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

20 апреля 2025 г., 1:25:56 GMT+03:00

20 апреля 2025 г., 1:25:56 GMT+03:00

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

19 апреля 2025 г., 19:38:42 GMT+03:00

19 апреля 2025 г., 19:38:42 GMT+03:00

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

Использование Китаем искусственного интеллекта для усиления своих цензурных возможностей достигло нового уровня, как показывает утёкшая база данных, содержащая 133 000 примеров контента, помеченного как чувствительный китайским правительством. Эта сложная большая языковая модель (LLM) разработана для автоматического обнаружения и цензурирования контента, связанного с широким спектром тем, от бедности в сельских районах до коррупции в Коммунистической партии и даже тонкой политической сатиры.

По словам Сяо Цяна, исследователя из UC Berkeley, специализирующегося на китайской цензуре, эта база данных является "явным доказательством" того, что китайское правительство или его аффилированные структуры используют LLM для усиления своих репрессивных усилий. В отличие от традиционных методов, зависящих от модераторов-людей и фильтрации по ключевым словам, этот подход, основанный на искусственном интеллекте, значительно повышает эффективность и точность государственного управления информацией.

Набор данных, обнаруженный исследователем безопасности NetAskari в незащищённой базе данных Elasticsearch, размещённой на сервере Baidu, включает недавние записи от декабря 2024 года. Неясно, кто именно создал этот набор данных, но его цель очевидна: обучить LLM выявлять и помечать контент, связанный с чувствительными темами, такими как загрязнение окружающей среды, безопасность пищевых продуктов, финансовые махинации, трудовые споры и военные вопросы. Политическая сатира, особенно если она включает исторические аналогии или упоминания Тайваня, также является приоритетной целью.

Обучающие данные включают различные примеры контента, который потенциально может вызвать социальные волнения, такие как жалобы на коррумпированных полицейских, сообщения о бедности в сельской местности и новости об исключённых из Коммунистической партии чиновниках. Набор данных также содержит множество ссылок на Тайвань и военные темы, при этом китайское слово для Тайваня (台湾) встречается более 15 000 раз.

Предполагаемое использование набора данных описывается как "работа с общественным мнением", термин, который, по словам Майкла Кастера из Article 19, обычно ассоциируется с Управлением киберпространства Китая (CAC) и включает усилия по цензуре и пропаганде. Это соответствует взглядам президента Китая Си Цзиньпина, который считает интернет "передовой линией" работы Коммунистической партии с общественным мнением.

Это развитие является частью более широкой тенденции, когда авторитарные режимы используют технологии искусственного интеллекта в репрессивных целях. OpenAI недавно сообщила, что неустановленный субъект, вероятно из Китая, использовал генеративный ИИ для мониторинга социальных сетей и пересылки антиправительственных постов китайскому правительству. Та же технология использовалась для генерации критических комментариев о известной китайской диссидентке Цай Ся.

Хотя традиционные методы цензуры в Китае полагаются на базовые алгоритмы для блокировки запрещённых терминов, использование LLM представляет значительный прогресс. Эти системы ИИ способны обнаруживать даже тонкую критику в массовом масштабе и постоянно совершенствуются по мере обработки большего объёма данных.

"Я считаю важным подчеркнуть, как развивается цензура, основанная на искусственном интеллекте, делая государственный контроль над общественным дискурсом ещё более изощрённым, особенно в то время, когда китайские модели ИИ, такие как DeepSeek, вызывают волну интереса", — сказал Сяо Цян в интервью TechCrunch.

ByteDance представляет модель ИИ Seed-Thinking-v1.5 для усиления способностей к рассуждению

Гонка за продвинутыми ИИ с функцией рассуждения началась с модели o1 от OpenAI в сентябре 2024 года, набрав обороты с запуском R1 от DeepSeek в январе 2025 года.Крупные разработчики ИИ соревнуются в с

ByteDance представляет модель ИИ Seed-Thinking-v1.5 для усиления способностей к рассуждению

Гонка за продвинутыми ИИ с функцией рассуждения началась с модели o1 от OpenAI в сентябре 2024 года, набрав обороты с запуском R1 от DeepSeek в январе 2025 года.Крупные разработчики ИИ соревнуются в с

Alibaba представляет Wan2.1-VACE: Открытое решение для видео с ИИ

Alibaba представила Wan2.1-VACE, модель ИИ с открытым исходным кодом, которая призвана трансформировать процессы создания и редактирования видео.VACE является ключевым компонентом семейства видео моде

Alibaba представляет Wan2.1-VACE: Открытое решение для видео с ИИ

Alibaba представила Wan2.1-VACE, модель ИИ с открытым исходным кодом, которая призвана трансформировать процессы создания и редактирования видео.VACE является ключевым компонентом семейства видео моде

11 августа 2025 г., 21:01:05 GMT+03:00

11 августа 2025 г., 21:01:05 GMT+03:00

Whoa, 133,000 flagged posts? That's wild! China's AI censorship game is intense, but I'm curious—how do they even decide what's 'sensitive'? Sounds like a slippery slope. 😬

0

0

1 августа 2025 г., 16:47:34 GMT+03:00

1 августа 2025 г., 16:47:34 GMT+03:00

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

22 июля 2025 г., 10:35:51 GMT+03:00

22 июля 2025 г., 10:35:51 GMT+03:00

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

21 апреля 2025 г., 11:06:03 GMT+03:00

21 апреля 2025 г., 11:06:03 GMT+03:00

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

20 апреля 2025 г., 1:25:56 GMT+03:00

20 апреля 2025 г., 1:25:56 GMT+03:00

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

19 апреля 2025 г., 19:38:42 GMT+03:00

19 апреля 2025 г., 19:38:42 GMT+03:00

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0