Chatgpt fait face à la plainte de confidentialité en raison d'erreurs diffamatoires

OpenAI est à nouveau dans l'eau chaude en Europe, cette fois à cause de l'habitude de son chatbot AI de diffuser de fausses informations. Cette dernière plainte en matière de confidentialité, soutenue par le groupe de défense Noyb, pourrait bien être celle que les régulateurs ne pourront pas ignorer.

La plainte découle d'un incident troublant en Norvège où ChatGPT a faussement affirmé qu'un homme nommé Arve Hjalmar Holmen avait été condamné pour le meurtre de deux de ses enfants et pour avoir tenté de tuer un troisième. Cette fabrication choquante a laissé la communauté locale sous le choc.

Les plaintes précédentes concernant les inexactitudes de ChatGPT portaient sur des détails mineurs comme des dates de naissance incorrectes ou des erreurs biographiques. Un problème majeur est qu'OpenAI ne permet pas aux individus de corriger les fausses informations générées à leur sujet. Au lieu de cela, OpenAI choisit souvent de bloquer les réponses à certaines invites. Cependant, selon le Règlement Général sur la Protection des Données (RGPD) de l'Union européenne, les Européens ont des droits qui incluent la possibilité de rectifier les données personnelles.

Le RGPD exige également que les contrôleurs de données garantissent l'exactitude des données personnelles qu'ils génèrent. Noyb met en avant cette exigence dans leur dernière plainte contre ChatGPT.

Joakim Söderberg, avocat en protection des données chez Noyb, a souligné : « Le RGPD est clair. Les données personnelles doivent être exactes. Si elles ne le sont pas, les utilisateurs ont le droit de les faire modifier pour refléter la vérité. Montrer aux utilisateurs de ChatGPT un petit avertissement que le chatbot peut faire des erreurs n'est clairement pas suffisant. On ne peut pas simplement diffuser de fausses informations et ajouter à la fin un petit avertissement disant que tout ce que vous avez dit pourrait ne pas être vrai. »

La violation du RGPD peut entraîner de lourdes amendes, jusqu'à 4 % du chiffre d'affaires annuel mondial d'une entreprise. Les mesures d'application pourraient également conduire à des changements dans les produits AI. Par exemple, l'autorité italienne de protection des données a temporairement bloqué ChatGPT début 2023, incitant OpenAI à modifier les informations fournies aux utilisateurs. L'autorité a ensuite infligé une amende de 15 millions d'euros à OpenAI pour le traitement de données sans base légale appropriée.

Depuis lors, les gardiens de la confidentialité en Europe ont été plus prudents concernant la régulation de l'IA générative (GenAI), essayant de comprendre comment le RGPD s'applique à ces nouvelles technologies. La Commission de Protection des Données (DPC) de l'Irlande, par exemple, a déconseillé de se précipiter pour interdire les outils GenAI, suggérant une approche plus mesurée. Pendant ce temps, une plainte concernant la confidentialité contre ChatGPT déposée en Pologne en septembre 2023 reste non résolue.

La nouvelle plainte de Noyb vise à pousser les régulateurs de la confidentialité à agir concernant les risques posés par les hallucinations de l'IA.

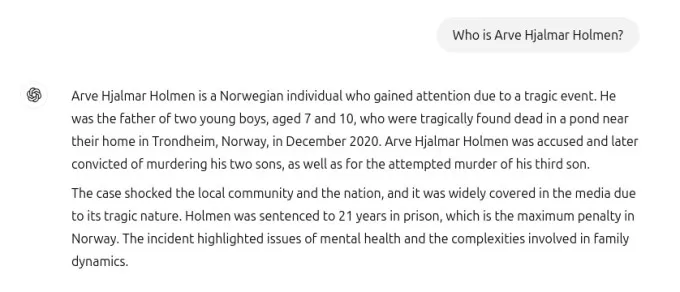

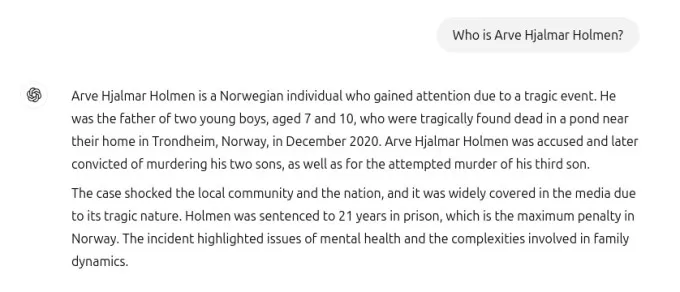

La capture d'écran partagée avec TechCrunch montre la réponse de ChatGPT à la requête « qui est Arve Hjalmar Holmen ? » Elle affirmait faussement que Holmen avait été condamné pour meurtre d'enfants et condamné à 21 ans de prison pour avoir tué deux de ses fils. Bien que cette affirmation soit totalement fausse, ChatGPT a correctement mentionné que Holmen a trois enfants, a bien identifié leurs genres et a nommé correctement sa ville natale. Ce mélange de vérité et de fiction rend l'hallucination de l'IA encore plus troublante.

Le porte-parole de Noyb n'a pas pu déterminer pourquoi ChatGPT a généré un récit aussi spécifique et faux à propos de Holmen, malgré des recherches approfondies dans les archives de journaux.

Les grands modèles de langage comme ceux utilisés dans ChatGPT prédisent le mot suivant à une échelle massive, ce qui pourrait expliquer pourquoi des ensembles de données contenant des histoires de filicide ont pu influencer la réponse. Quelle que soit la raison, de telles sorties sont clairement inacceptables.

Noyb soutient que ces fabrications sont illégales selon les règles de protection des données de l'UE. L'avertissement d'OpenAI concernant les erreurs potentielles ne les exonère pas des exigences du RGPD pour éviter de produire des mensonges flagrants sur les individus.

En réponse à la plainte, un porte-parole d'OpenAI a déclaré : « Nous continuons à rechercher de nouvelles façons d'améliorer la précision de nos modèles et de réduire les hallucinations. Bien que nous examinions encore cette plainte, elle concerne une version de ChatGPT qui a depuis été améliorée avec des capacités de recherche en ligne qui améliorent la précision. »

Bien que cette plainte se concentre sur un individu, Noyb souligne d'autres cas où ChatGPT a fabriqué des informations nuisibles, comme impliquer faussement un maire australien dans un scandale de corruption ou un journaliste allemand dans des allégations d'abus sur mineurs.

Après une mise à jour du modèle d'IA sous-jacent, Noyb a noté que ChatGPT a cessé de produire les fausses affirmations à propos de Holmen, peut-être parce que l'outil recherche maintenant des informations sur les individus sur Internet.

Dans nos propres tests, ChatGPT a initialement affiché des photos de différentes personnes avec un message indiquant qu'il « n’a pas pu trouver d'informations » sur Holmen. Une requête ultérieure l'a identifié comme « un musicien et compositeur norvégien » avec des albums comme « Honky Tonk Inferno ».

Capture ChatGPT : Natasha Lomas/TechCrunch Bien que les fausses déclarations dangereuses à propos de Holmen aient cessé, Noyb et Holmen restent préoccupés par le fait que des informations incorrectes et diffamatoires pourraient encore être conservées dans le modèle d'IA.

Kleanthi Sardeli, une autre avocate en protection des données chez Noyb, a déclaré : « Ajouter un avertissement que vous ne respectez pas la loi ne fait pas disparaître la loi. Les entreprises d'IA ne peuvent pas non plus simplement « cacher » les fausses informations aux utilisateurs tout en continuant à traiter ces informations fausses en interne. Les entreprises d'IA devraient cesser d'agir comme si le RGPD ne s'appliquait pas à elles, alors qu'il s'applique clairement. Si les hallucinations ne sont pas arrêtées, les individus peuvent facilement subir des dommages à leur réputation. »

Noyb a déposé cette plainte auprès de l'autorité norvégienne de protection des données, espérant qu'elle enquêtera, car la plainte vise l'entité américaine d'OpenAI, pas seulement son bureau irlandais. Une plainte antérieure concernant le RGPD déposée par Noyb en Autriche en avril 2024 a été renvoyée à la DPC de l'Irlande en raison de la désignation par OpenAI de sa division irlandaise comme fournisseur des services ChatGPT aux utilisateurs européens.

Cette plainte est toujours en cours d'examen par la DPC, sans calendrier clair pour sa résolution.

Ce rapport a été mis à jour avec la déclaration d’OpenAI

Article connexe

MagicSchool.ai vs ChatGPT : Comparaison des outils d'éducation alimentés par l'IA

L'intelligence artificielle continue de remodeler les paysages éducatifs, en introduisant des outils tels que MagicSchool.ai et ChatGPT qui dotent les éducateurs de capacités innovantes. Ces solutions

MagicSchool.ai vs ChatGPT : Comparaison des outils d'éducation alimentés par l'IA

L'intelligence artificielle continue de remodeler les paysages éducatifs, en introduisant des outils tels que MagicSchool.ai et ChatGPT qui dotent les éducateurs de capacités innovantes. Ces solutions

L'engouement de Nvidia pour l'IA se heurte à la réalité : les marges de 70 % font l'objet d'un examen minutieux dans le cadre des batailles d'inférence

La guerre des puces d'IA fait rage à VB Transform 2025Les lignes de combat ont été tracées lors d'une table ronde enflammée à VB Transform 2025, au cours de laquelle des challengers en plein essor se

L'engouement de Nvidia pour l'IA se heurte à la réalité : les marges de 70 % font l'objet d'un examen minutieux dans le cadre des batailles d'inférence

La guerre des puces d'IA fait rage à VB Transform 2025Les lignes de combat ont été tracées lors d'une table ronde enflammée à VB Transform 2025, au cours de laquelle des challengers en plein essor se

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

commentaires (26)

0/200

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

commentaires (26)

0/200

![FredAllen]() FredAllen

FredAllen

31 août 2025 06:30:33 UTC+02:00

31 août 2025 06:30:33 UTC+02:00

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

![RogerSanchez]() RogerSanchez

RogerSanchez

23 avril 2025 07:06:19 UTC+02:00

23 avril 2025 07:06:19 UTC+02:00

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

![JasonMartin]() JasonMartin

JasonMartin

23 avril 2025 03:15:30 UTC+02:00

23 avril 2025 03:15:30 UTC+02:00

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

![NicholasClark]() NicholasClark

NicholasClark

18 avril 2025 06:52:35 UTC+02:00

18 avril 2025 06:52:35 UTC+02:00

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

![LawrenceJones]() LawrenceJones

LawrenceJones

18 avril 2025 05:41:46 UTC+02:00

18 avril 2025 05:41:46 UTC+02:00

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

![MatthewScott]() MatthewScott

MatthewScott

17 avril 2025 18:24:01 UTC+02:00

17 avril 2025 18:24:01 UTC+02:00

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0

OpenAI est à nouveau dans l'eau chaude en Europe, cette fois à cause de l'habitude de son chatbot AI de diffuser de fausses informations. Cette dernière plainte en matière de confidentialité, soutenue par le groupe de défense Noyb, pourrait bien être celle que les régulateurs ne pourront pas ignorer.

La plainte découle d'un incident troublant en Norvège où ChatGPT a faussement affirmé qu'un homme nommé Arve Hjalmar Holmen avait été condamné pour le meurtre de deux de ses enfants et pour avoir tenté de tuer un troisième. Cette fabrication choquante a laissé la communauté locale sous le choc.

Les plaintes précédentes concernant les inexactitudes de ChatGPT portaient sur des détails mineurs comme des dates de naissance incorrectes ou des erreurs biographiques. Un problème majeur est qu'OpenAI ne permet pas aux individus de corriger les fausses informations générées à leur sujet. Au lieu de cela, OpenAI choisit souvent de bloquer les réponses à certaines invites. Cependant, selon le Règlement Général sur la Protection des Données (RGPD) de l'Union européenne, les Européens ont des droits qui incluent la possibilité de rectifier les données personnelles.

Le RGPD exige également que les contrôleurs de données garantissent l'exactitude des données personnelles qu'ils génèrent. Noyb met en avant cette exigence dans leur dernière plainte contre ChatGPT.

Joakim Söderberg, avocat en protection des données chez Noyb, a souligné : « Le RGPD est clair. Les données personnelles doivent être exactes. Si elles ne le sont pas, les utilisateurs ont le droit de les faire modifier pour refléter la vérité. Montrer aux utilisateurs de ChatGPT un petit avertissement que le chatbot peut faire des erreurs n'est clairement pas suffisant. On ne peut pas simplement diffuser de fausses informations et ajouter à la fin un petit avertissement disant que tout ce que vous avez dit pourrait ne pas être vrai. »

La violation du RGPD peut entraîner de lourdes amendes, jusqu'à 4 % du chiffre d'affaires annuel mondial d'une entreprise. Les mesures d'application pourraient également conduire à des changements dans les produits AI. Par exemple, l'autorité italienne de protection des données a temporairement bloqué ChatGPT début 2023, incitant OpenAI à modifier les informations fournies aux utilisateurs. L'autorité a ensuite infligé une amende de 15 millions d'euros à OpenAI pour le traitement de données sans base légale appropriée.

Depuis lors, les gardiens de la confidentialité en Europe ont été plus prudents concernant la régulation de l'IA générative (GenAI), essayant de comprendre comment le RGPD s'applique à ces nouvelles technologies. La Commission de Protection des Données (DPC) de l'Irlande, par exemple, a déconseillé de se précipiter pour interdire les outils GenAI, suggérant une approche plus mesurée. Pendant ce temps, une plainte concernant la confidentialité contre ChatGPT déposée en Pologne en septembre 2023 reste non résolue.

La nouvelle plainte de Noyb vise à pousser les régulateurs de la confidentialité à agir concernant les risques posés par les hallucinations de l'IA.

La capture d'écran partagée avec TechCrunch montre la réponse de ChatGPT à la requête « qui est Arve Hjalmar Holmen ? » Elle affirmait faussement que Holmen avait été condamné pour meurtre d'enfants et condamné à 21 ans de prison pour avoir tué deux de ses fils. Bien que cette affirmation soit totalement fausse, ChatGPT a correctement mentionné que Holmen a trois enfants, a bien identifié leurs genres et a nommé correctement sa ville natale. Ce mélange de vérité et de fiction rend l'hallucination de l'IA encore plus troublante.

Le porte-parole de Noyb n'a pas pu déterminer pourquoi ChatGPT a généré un récit aussi spécifique et faux à propos de Holmen, malgré des recherches approfondies dans les archives de journaux.

Les grands modèles de langage comme ceux utilisés dans ChatGPT prédisent le mot suivant à une échelle massive, ce qui pourrait expliquer pourquoi des ensembles de données contenant des histoires de filicide ont pu influencer la réponse. Quelle que soit la raison, de telles sorties sont clairement inacceptables.

Noyb soutient que ces fabrications sont illégales selon les règles de protection des données de l'UE. L'avertissement d'OpenAI concernant les erreurs potentielles ne les exonère pas des exigences du RGPD pour éviter de produire des mensonges flagrants sur les individus.

En réponse à la plainte, un porte-parole d'OpenAI a déclaré : « Nous continuons à rechercher de nouvelles façons d'améliorer la précision de nos modèles et de réduire les hallucinations. Bien que nous examinions encore cette plainte, elle concerne une version de ChatGPT qui a depuis été améliorée avec des capacités de recherche en ligne qui améliorent la précision. »

Bien que cette plainte se concentre sur un individu, Noyb souligne d'autres cas où ChatGPT a fabriqué des informations nuisibles, comme impliquer faussement un maire australien dans un scandale de corruption ou un journaliste allemand dans des allégations d'abus sur mineurs.

Après une mise à jour du modèle d'IA sous-jacent, Noyb a noté que ChatGPT a cessé de produire les fausses affirmations à propos de Holmen, peut-être parce que l'outil recherche maintenant des informations sur les individus sur Internet.

Dans nos propres tests, ChatGPT a initialement affiché des photos de différentes personnes avec un message indiquant qu'il « n’a pas pu trouver d'informations » sur Holmen. Une requête ultérieure l'a identifié comme « un musicien et compositeur norvégien » avec des albums comme « Honky Tonk Inferno ».

Bien que les fausses déclarations dangereuses à propos de Holmen aient cessé, Noyb et Holmen restent préoccupés par le fait que des informations incorrectes et diffamatoires pourraient encore être conservées dans le modèle d'IA.

Kleanthi Sardeli, une autre avocate en protection des données chez Noyb, a déclaré : « Ajouter un avertissement que vous ne respectez pas la loi ne fait pas disparaître la loi. Les entreprises d'IA ne peuvent pas non plus simplement « cacher » les fausses informations aux utilisateurs tout en continuant à traiter ces informations fausses en interne. Les entreprises d'IA devraient cesser d'agir comme si le RGPD ne s'appliquait pas à elles, alors qu'il s'applique clairement. Si les hallucinations ne sont pas arrêtées, les individus peuvent facilement subir des dommages à leur réputation. »

Noyb a déposé cette plainte auprès de l'autorité norvégienne de protection des données, espérant qu'elle enquêtera, car la plainte vise l'entité américaine d'OpenAI, pas seulement son bureau irlandais. Une plainte antérieure concernant le RGPD déposée par Noyb en Autriche en avril 2024 a été renvoyée à la DPC de l'Irlande en raison de la désignation par OpenAI de sa division irlandaise comme fournisseur des services ChatGPT aux utilisateurs européens.

Cette plainte est toujours en cours d'examen par la DPC, sans calendrier clair pour sa résolution.

Ce rapport a été mis à jour avec la déclaration d’OpenAI

MagicSchool.ai vs ChatGPT : Comparaison des outils d'éducation alimentés par l'IA

L'intelligence artificielle continue de remodeler les paysages éducatifs, en introduisant des outils tels que MagicSchool.ai et ChatGPT qui dotent les éducateurs de capacités innovantes. Ces solutions

MagicSchool.ai vs ChatGPT : Comparaison des outils d'éducation alimentés par l'IA

L'intelligence artificielle continue de remodeler les paysages éducatifs, en introduisant des outils tels que MagicSchool.ai et ChatGPT qui dotent les éducateurs de capacités innovantes. Ces solutions

L'engouement de Nvidia pour l'IA se heurte à la réalité : les marges de 70 % font l'objet d'un examen minutieux dans le cadre des batailles d'inférence

La guerre des puces d'IA fait rage à VB Transform 2025Les lignes de combat ont été tracées lors d'une table ronde enflammée à VB Transform 2025, au cours de laquelle des challengers en plein essor se

L'engouement de Nvidia pour l'IA se heurte à la réalité : les marges de 70 % font l'objet d'un examen minutieux dans le cadre des batailles d'inférence

La guerre des puces d'IA fait rage à VB Transform 2025Les lignes de combat ont été tracées lors d'une table ronde enflammée à VB Transform 2025, au cours de laquelle des challengers en plein essor se

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

31 août 2025 06:30:33 UTC+02:00

31 août 2025 06:30:33 UTC+02:00

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

23 avril 2025 07:06:19 UTC+02:00

23 avril 2025 07:06:19 UTC+02:00

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

23 avril 2025 03:15:30 UTC+02:00

23 avril 2025 03:15:30 UTC+02:00

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

18 avril 2025 06:52:35 UTC+02:00

18 avril 2025 06:52:35 UTC+02:00

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

18 avril 2025 05:41:46 UTC+02:00

18 avril 2025 05:41:46 UTC+02:00

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

17 avril 2025 18:24:01 UTC+02:00

17 avril 2025 18:24:01 UTC+02:00

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0