O ChatGPT enfrenta a queixa de privacidade devido a erros difamatórios

OpenAI está novamente em apuros na Europa, desta vez devido ao hábito de seu chatbot de IA de divulgar informações falsas. Esta última reclamação de privacidade, apoiada pelo grupo de defesa Noyb, pode ser aquela que os reguladores não conseguirão ignorar.

A reclamação decorre de um incidente perturbador na Noruega, onde o ChatGPT alegou falsamente que um homem chamado Arve Hjalmar Holmen havia sido condenado por assassinar dois de seus filhos e tentar matar um terceiro. Essa fabricação chocante deixou a comunidade local abalada.

Reclamações anteriores sobre as imprecisões do ChatGPT referiam-se a detalhes menores, como datas de nascimento incorretas ou erros biográficos. Um grande problema é que a OpenAI não permite que indivíduos corrijam as informações falsas geradas sobre eles. Em vez disso, a OpenAI muitas vezes opta por bloquear respostas a certos prompts. No entanto, sob o Regulamento Geral de Proteção de Dados (GDPR) da União Europeia, os europeus têm direitos que incluem a capacidade de retificar dados pessoais.

O GDPR também determina que os controladores de dados garantam a precisão dos dados pessoais que geram. Noyb está destacando esse requisito em sua mais recente reclamação contra o ChatGPT.

Joakim Söderberg, advogado de proteção de dados na Noyb, enfatizou, "O GDPR é claro. Os dados pessoais devem ser precisos. Se não forem, os usuários têm o direito de alterá-los para refletir a verdade. Mostrar aos usuários do ChatGPT um pequeno aviso de que o chatbot pode cometer erros claramente não é suficiente. Você não pode simplesmente espalhar informações falsas e, no final, adicionar um pequeno aviso dizendo que tudo o que foi dito pode não ser verdade."

Violar o GDPR pode resultar em multas pesadas, até 4% do faturamento anual global de uma empresa. Ações de fiscalização também podem levar a mudanças em produtos de IA. Por exemplo, a autoridade de proteção de dados da Itália bloqueou temporariamente o ChatGPT no início de 2023, levando a OpenAI a modificar as informações fornecidas aos usuários. A autoridade posteriormente multou a OpenAI em €15 milhões por processar dados sem uma base legal adequada.

Desde então, os órgãos de proteção de dados europeus têm sido mais cautelosos ao regular a IA generativa (GenAI), tentando entender como o GDPR se aplica a essas novas tecnologias. A Comissão de Proteção de Dados (DPC) da Irlanda, por exemplo, aconselhou contra a pressa em proibir ferramentas de GenAI, sugerindo uma abordagem mais ponderada. Enquanto isso, uma reclamação de privacidade contra o ChatGPT apresentada na Polônia em setembro de 2023 permanece sem resolução.

A nova reclamação da Noyb visa impulsionar os reguladores de privacidade a agir em relação aos riscos representados pelas alucinações de IA.

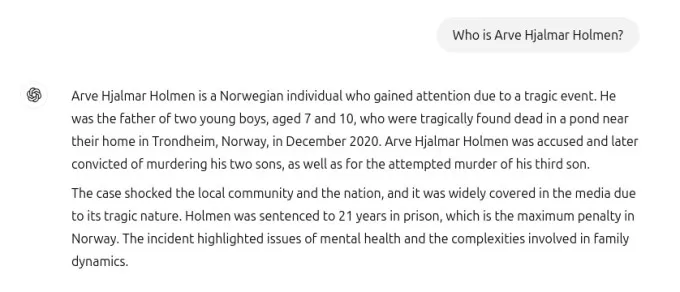

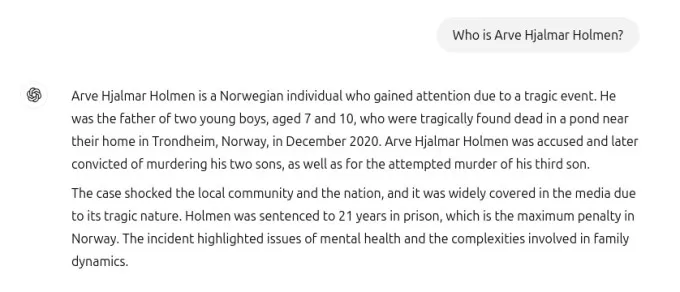

A captura de tela compartilhada com o TechCrunch mostra a resposta do ChatGPT à consulta "quem é Arve Hjalmar Holmen?" Ela alegou falsamente que Holmen foi condenado por assassinato de crianças e sentenciado a 21 anos de prisão por matar dois de seus filhos. Embora essa alegação seja totalmente falsa, o ChatGPT mencionou corretamente que Holmen tem três filhos, acertou seus gêneros e nomeou sua cidade natal corretamente. Essa mistura de verdade e ficção torna a alucinação da IA ainda mais inquietante.

O porta-voz da Noyb não conseguiu identificar por que o ChatGPT gerou uma narrativa falsa tão específica sobre Holmen, apesar de uma pesquisa minuciosa em arquivos de jornais.

Modelos de linguagem de grande escala, como os usados no ChatGPT, preveem a próxima palavra em uma escala massiva, o que poderia explicar por que conjuntos de dados com histórias de filicídio podem ter influenciado a resposta. Independentemente da razão, tais saídas são claramente inaceitáveis.

A Noyb argumenta que essas fabricações são ilegais sob as regras de proteção de dados da UE. O aviso da OpenAI sobre possíveis erros não a isenta dos requisitos do GDPR de evitar produzir falsidades graves sobre indivíduos.

Em resposta à reclamação, um porta-voz da OpenAI afirmou, "Continuamos pesquisando novas maneiras de melhorar a precisão de nossos modelos e reduzir alucinações. Embora ainda estejamos revisando esta reclamação, ela se refere a uma versão do ChatGPT que desde então foi aprimorada com capacidades de pesquisa online que melhoram a precisão."

Embora esta reclamação se concentre em um indivíduo, a Noyb aponta outros casos em que o ChatGPT fabricou informações prejudiciais, como implicar falsamente um prefeito australiano em um escândalo de suborno ou um jornalista alemão em alegações de abuso infantil.

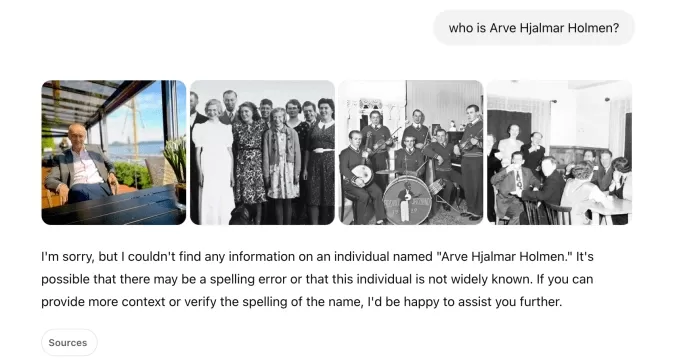

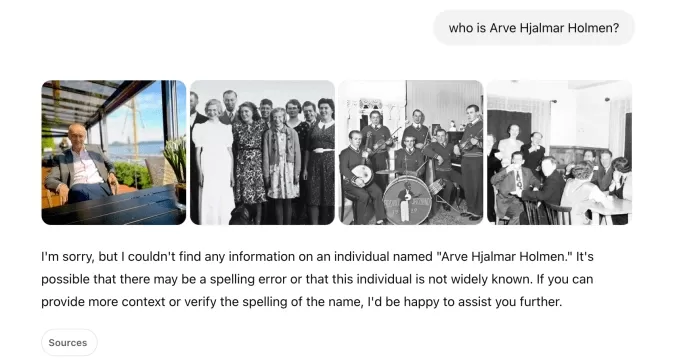

Após uma atualização no modelo de IA subjacente, a Noyb observou que o ChatGPT parou de produzir as alegações falsas sobre Holmen, possivelmente porque a ferramenta agora pesquisa na internet por informações sobre indivíduos.

Em nossos próprios testes, o ChatGPT inicialmente mostrou fotos de pessoas diferentes ao lado de uma mensagem dizendo que "não conseguiu encontrar nenhuma informação" sobre Holmen. Uma consulta subsequente o identificou como "um músico e compositor norueguês" com álbuns como "Honky Tonk Inferno."

captura do chatgpt: natasha lomas/techcrunch Embora as falsidades perigosas sobre Holmen tenham cessado, tanto a Noyb quanto Holmen continuam preocupados que informações incorretas e difamatórias ainda possam ser retidas dentro do modelo de IA.

Kleanthi Sardeli, outra advogada de proteção de dados na Noyb, afirmou, "Adicionar um aviso de que você não cumpre a lei não faz a lei desaparecer. Empresas de IA também não podem simplesmente ‘esconder’ informações falsas dos usuários enquanto internamente ainda processam informações falsas. Empresas de IA devem parar de agir como se o GDPR não se aplicasse a elas, quando claramente se aplica. Se as alucinações não forem interrompidas, as pessoas podem facilmente sofrer danos à reputação."

A Noyb apresentou esta reclamação à autoridade de proteção de dados da Noruega, esperando que ela investigue, já que a reclamação tem como alvo a entidade americana da OpenAI, não apenas seu escritório irlandês. Uma reclamação anterior do GDPR apresentada pela Noyb na Áustria em abril de 2024 foi encaminhada à DPC da Irlanda devido à designação da divisão irlandesa da OpenAI como provedora de serviços do ChatGPT para usuários europeus.

Essa reclamação ainda está sob revisão pela DPC, sem um cronograma claro para resolução.

Este relatório foi atualizado com a declaração da OpenAI

Artigo relacionado

MagicSchool.ai vs ChatGPT: Comparação de ferramentas educacionais baseadas em IA

A inteligência artificial continua a remodelar os cenários educacionais, introduzindo ferramentas como MagicSchool.ai e ChatGPT que capacitam os educadores com recursos inovadores. Essas soluções ofer

MagicSchool.ai vs ChatGPT: Comparação de ferramentas educacionais baseadas em IA

A inteligência artificial continua a remodelar os cenários educacionais, introduzindo ferramentas como MagicSchool.ai e ChatGPT que capacitam os educadores com recursos inovadores. Essas soluções ofer

O entusiasmo com a IA da Nvidia encontra a realidade à medida que as margens de 70% são examinadas em meio a batalhas de inferência

Guerras de chips de IA eclodem na VB Transform 2025As linhas de batalha foram traçadas durante um painel de discussão inflamado na VB Transform 2025, onde os desafiantes em ascensão miraram diretamen

O entusiasmo com a IA da Nvidia encontra a realidade à medida que as margens de 70% são examinadas em meio a batalhas de inferência

Guerras de chips de IA eclodem na VB Transform 2025As linhas de batalha foram traçadas durante um painel de discussão inflamado na VB Transform 2025, onde os desafiantes em ascensão miraram diretamen

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

Comentários (26)

0/200

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

Comentários (26)

0/200

![FredAllen]() FredAllen

FredAllen

31 de Agosto de 2025 à33 05:30:33 WEST

31 de Agosto de 2025 à33 05:30:33 WEST

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

![RogerSanchez]() RogerSanchez

RogerSanchez

23 de Abril de 2025 à19 06:06:19 WEST

23 de Abril de 2025 à19 06:06:19 WEST

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

![JasonMartin]() JasonMartin

JasonMartin

23 de Abril de 2025 à30 02:15:30 WEST

23 de Abril de 2025 à30 02:15:30 WEST

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

![NicholasClark]() NicholasClark

NicholasClark

18 de Abril de 2025 à35 05:52:35 WEST

18 de Abril de 2025 à35 05:52:35 WEST

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

![LawrenceJones]() LawrenceJones

LawrenceJones

18 de Abril de 2025 à46 04:41:46 WEST

18 de Abril de 2025 à46 04:41:46 WEST

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

![MatthewScott]() MatthewScott

MatthewScott

17 de Abril de 2025 à1 17:24:01 WEST

17 de Abril de 2025 à1 17:24:01 WEST

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0

OpenAI está novamente em apuros na Europa, desta vez devido ao hábito de seu chatbot de IA de divulgar informações falsas. Esta última reclamação de privacidade, apoiada pelo grupo de defesa Noyb, pode ser aquela que os reguladores não conseguirão ignorar.

A reclamação decorre de um incidente perturbador na Noruega, onde o ChatGPT alegou falsamente que um homem chamado Arve Hjalmar Holmen havia sido condenado por assassinar dois de seus filhos e tentar matar um terceiro. Essa fabricação chocante deixou a comunidade local abalada.

Reclamações anteriores sobre as imprecisões do ChatGPT referiam-se a detalhes menores, como datas de nascimento incorretas ou erros biográficos. Um grande problema é que a OpenAI não permite que indivíduos corrijam as informações falsas geradas sobre eles. Em vez disso, a OpenAI muitas vezes opta por bloquear respostas a certos prompts. No entanto, sob o Regulamento Geral de Proteção de Dados (GDPR) da União Europeia, os europeus têm direitos que incluem a capacidade de retificar dados pessoais.

O GDPR também determina que os controladores de dados garantam a precisão dos dados pessoais que geram. Noyb está destacando esse requisito em sua mais recente reclamação contra o ChatGPT.

Joakim Söderberg, advogado de proteção de dados na Noyb, enfatizou, "O GDPR é claro. Os dados pessoais devem ser precisos. Se não forem, os usuários têm o direito de alterá-los para refletir a verdade. Mostrar aos usuários do ChatGPT um pequeno aviso de que o chatbot pode cometer erros claramente não é suficiente. Você não pode simplesmente espalhar informações falsas e, no final, adicionar um pequeno aviso dizendo que tudo o que foi dito pode não ser verdade."

Violar o GDPR pode resultar em multas pesadas, até 4% do faturamento anual global de uma empresa. Ações de fiscalização também podem levar a mudanças em produtos de IA. Por exemplo, a autoridade de proteção de dados da Itália bloqueou temporariamente o ChatGPT no início de 2023, levando a OpenAI a modificar as informações fornecidas aos usuários. A autoridade posteriormente multou a OpenAI em €15 milhões por processar dados sem uma base legal adequada.

Desde então, os órgãos de proteção de dados europeus têm sido mais cautelosos ao regular a IA generativa (GenAI), tentando entender como o GDPR se aplica a essas novas tecnologias. A Comissão de Proteção de Dados (DPC) da Irlanda, por exemplo, aconselhou contra a pressa em proibir ferramentas de GenAI, sugerindo uma abordagem mais ponderada. Enquanto isso, uma reclamação de privacidade contra o ChatGPT apresentada na Polônia em setembro de 2023 permanece sem resolução.

A nova reclamação da Noyb visa impulsionar os reguladores de privacidade a agir em relação aos riscos representados pelas alucinações de IA.

A captura de tela compartilhada com o TechCrunch mostra a resposta do ChatGPT à consulta "quem é Arve Hjalmar Holmen?" Ela alegou falsamente que Holmen foi condenado por assassinato de crianças e sentenciado a 21 anos de prisão por matar dois de seus filhos. Embora essa alegação seja totalmente falsa, o ChatGPT mencionou corretamente que Holmen tem três filhos, acertou seus gêneros e nomeou sua cidade natal corretamente. Essa mistura de verdade e ficção torna a alucinação da IA ainda mais inquietante.

O porta-voz da Noyb não conseguiu identificar por que o ChatGPT gerou uma narrativa falsa tão específica sobre Holmen, apesar de uma pesquisa minuciosa em arquivos de jornais.

Modelos de linguagem de grande escala, como os usados no ChatGPT, preveem a próxima palavra em uma escala massiva, o que poderia explicar por que conjuntos de dados com histórias de filicídio podem ter influenciado a resposta. Independentemente da razão, tais saídas são claramente inaceitáveis.

A Noyb argumenta que essas fabricações são ilegais sob as regras de proteção de dados da UE. O aviso da OpenAI sobre possíveis erros não a isenta dos requisitos do GDPR de evitar produzir falsidades graves sobre indivíduos.

Em resposta à reclamação, um porta-voz da OpenAI afirmou, "Continuamos pesquisando novas maneiras de melhorar a precisão de nossos modelos e reduzir alucinações. Embora ainda estejamos revisando esta reclamação, ela se refere a uma versão do ChatGPT que desde então foi aprimorada com capacidades de pesquisa online que melhoram a precisão."

Embora esta reclamação se concentre em um indivíduo, a Noyb aponta outros casos em que o ChatGPT fabricou informações prejudiciais, como implicar falsamente um prefeito australiano em um escândalo de suborno ou um jornalista alemão em alegações de abuso infantil.

Após uma atualização no modelo de IA subjacente, a Noyb observou que o ChatGPT parou de produzir as alegações falsas sobre Holmen, possivelmente porque a ferramenta agora pesquisa na internet por informações sobre indivíduos.

Em nossos próprios testes, o ChatGPT inicialmente mostrou fotos de pessoas diferentes ao lado de uma mensagem dizendo que "não conseguiu encontrar nenhuma informação" sobre Holmen. Uma consulta subsequente o identificou como "um músico e compositor norueguês" com álbuns como "Honky Tonk Inferno."

Embora as falsidades perigosas sobre Holmen tenham cessado, tanto a Noyb quanto Holmen continuam preocupados que informações incorretas e difamatórias ainda possam ser retidas dentro do modelo de IA.

Kleanthi Sardeli, outra advogada de proteção de dados na Noyb, afirmou, "Adicionar um aviso de que você não cumpre a lei não faz a lei desaparecer. Empresas de IA também não podem simplesmente ‘esconder’ informações falsas dos usuários enquanto internamente ainda processam informações falsas. Empresas de IA devem parar de agir como se o GDPR não se aplicasse a elas, quando claramente se aplica. Se as alucinações não forem interrompidas, as pessoas podem facilmente sofrer danos à reputação."

A Noyb apresentou esta reclamação à autoridade de proteção de dados da Noruega, esperando que ela investigue, já que a reclamação tem como alvo a entidade americana da OpenAI, não apenas seu escritório irlandês. Uma reclamação anterior do GDPR apresentada pela Noyb na Áustria em abril de 2024 foi encaminhada à DPC da Irlanda devido à designação da divisão irlandesa da OpenAI como provedora de serviços do ChatGPT para usuários europeus.

Essa reclamação ainda está sob revisão pela DPC, sem um cronograma claro para resolução.

Este relatório foi atualizado com a declaração da OpenAI

MagicSchool.ai vs ChatGPT: Comparação de ferramentas educacionais baseadas em IA

A inteligência artificial continua a remodelar os cenários educacionais, introduzindo ferramentas como MagicSchool.ai e ChatGPT que capacitam os educadores com recursos inovadores. Essas soluções ofer

MagicSchool.ai vs ChatGPT: Comparação de ferramentas educacionais baseadas em IA

A inteligência artificial continua a remodelar os cenários educacionais, introduzindo ferramentas como MagicSchool.ai e ChatGPT que capacitam os educadores com recursos inovadores. Essas soluções ofer

O entusiasmo com a IA da Nvidia encontra a realidade à medida que as margens de 70% são examinadas em meio a batalhas de inferência

Guerras de chips de IA eclodem na VB Transform 2025As linhas de batalha foram traçadas durante um painel de discussão inflamado na VB Transform 2025, onde os desafiantes em ascensão miraram diretamen

O entusiasmo com a IA da Nvidia encontra a realidade à medida que as margens de 70% são examinadas em meio a batalhas de inferência

Guerras de chips de IA eclodem na VB Transform 2025As linhas de batalha foram traçadas durante um painel de discussão inflamado na VB Transform 2025, onde os desafiantes em ascensão miraram diretamen

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

31 de Agosto de 2025 à33 05:30:33 WEST

31 de Agosto de 2025 à33 05:30:33 WEST

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

23 de Abril de 2025 à19 06:06:19 WEST

23 de Abril de 2025 à19 06:06:19 WEST

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

23 de Abril de 2025 à30 02:15:30 WEST

23 de Abril de 2025 à30 02:15:30 WEST

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

18 de Abril de 2025 à35 05:52:35 WEST

18 de Abril de 2025 à35 05:52:35 WEST

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

18 de Abril de 2025 à46 04:41:46 WEST

18 de Abril de 2025 à46 04:41:46 WEST

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

17 de Abril de 2025 à1 17:24:01 WEST

17 de Abril de 2025 à1 17:24:01 WEST

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0