ChatGPT enfrenta una queja de privacidad debido a errores difamatorios

OpenAI está una vez más en problemas en Europa, esta vez por el hábito de su chatbot de IA de difundir información falsa. Esta última queja de privacidad, respaldada por el grupo de defensa Noyb, podría ser la que los reguladores no puedan ignorar.

La queja surge de un incidente perturbador en Noruega, donde ChatGPT afirmó falsamente que un hombre llamado Arve Hjalmar Holmen había sido condenado por asesinar a dos de sus hijos e intentar matar a un tercero. Esta impactante invención ha dejado a la comunidad local conmocionada.

Las quejas anteriores sobre las inexactitudes de ChatGPT se referían a detalles menores, como fechas de nacimiento incorrectas o errores biográficos. Un problema importante es que OpenAI no permite a las personas corregir la información falsa generada sobre ellas. En cambio, OpenAI a menudo opta por bloquear respuestas a ciertos prompts. Sin embargo, bajo el Reglamento General de Protección de Datos (GDPR) de la Unión Europea, los europeos tienen derechos que incluyen la capacidad de rectificar datos personales.

El GDPR también exige que los controladores de datos garanticen la precisión de los datos personales que generan. Noyb está destacando este requisito en su última queja contra ChatGPT.

Joakim Söderberg, abogado de protección de datos en Noyb, enfatizó: "El GDPR es claro. Los datos personales deben ser precisos. Si no lo son, los usuarios tienen derecho a que se modifiquen para reflejar la verdad. Mostrar a los usuarios de ChatGPT un pequeño descargo de responsabilidad de que el chatbot puede cometer errores claramente no es suficiente. No se puede simplemente difundir información falsa y al final agregar un pequeño descargo diciendo que todo lo que se dijo puede no ser cierto."

Violar el GDPR puede resultar en multas considerables, hasta el 4% de la facturación anual global de una empresa. Las acciones de cumplimiento también podrían llevar a cambios en los productos de IA. Por ejemplo, la autoridad de protección de datos de Italia bloqueó temporalmente ChatGPT a principios de 2023, lo que llevó a OpenAI a modificar la información que proporciona a los usuarios. La autoridad luego multó a OpenAI con 15 millones de euros por procesar datos sin una base legal adecuada.

Desde entonces, los organismos de protección de datos europeos han sido más cautelosos al regular la IA generativa (GenAI), tratando de entender cómo se aplica el GDPR a estas nuevas tecnologías. La Comisión de Protección de Datos (DPC) de Irlanda, por ejemplo, aconsejó no apresurarse a prohibir herramientas de GenAI, sugiriendo un enfoque más mesurado. Mientras tanto, una queja de privacidad contra ChatGPT presentada en Polonia en septiembre de 2023 sigue sin resolverse.

La nueva queja de Noyb busca impulsar a los reguladores de privacidad a actuar respecto a los riesgos que plantean las alucinaciones de la IA.

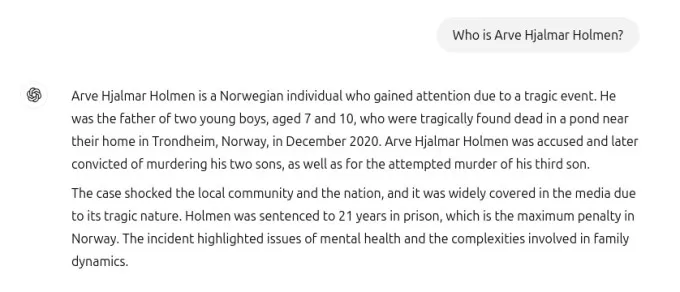

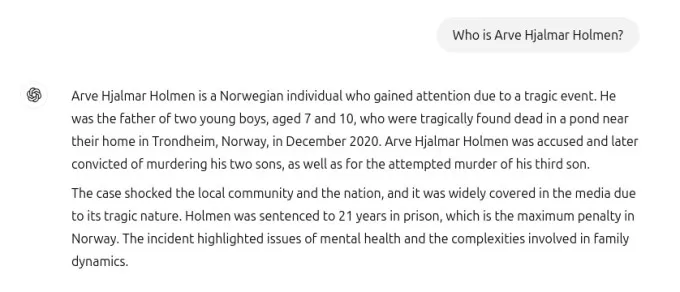

La captura de pantalla compartida con TechCrunch muestra la respuesta de ChatGPT a la consulta "quién es Arve Hjalmar Holmen?". Afirmó falsamente que Holmen fue condenado por asesinato de niños y sentenciado a 21 años de prisión por matar a dos de sus hijos. Aunque esta afirmación es completamente falsa, ChatGPT mencionó correctamente que Holmen tiene tres hijos, acertó en sus géneros y nombró correctamente su ciudad natal. Esta mezcla de verdad y ficción hace que la alucinación de la IA sea aún más inquietante.

El portavoz de Noyb no pudo determinar por qué ChatGPT generó una narrativa falsa tan específica sobre Holmen, a pesar de una investigación exhaustiva en archivos de periódicos.

Los modelos de lenguaje grandes, como los utilizados en ChatGPT, predicen la siguiente palabra a gran escala, lo que podría explicar por qué los conjuntos de datos con historias de filicidio podrían haber influido en la respuesta. Independientemente de la razón, tales resultados son claramente inaceptables.

Noyb argumenta que estas invenciones son ilegales según las normas de protección de datos de la UE. El descargo de responsabilidad de OpenAI sobre posibles errores no los exime de los requisitos del GDPR para evitar producir falsedades graves sobre individuos.

En respuesta a la queja, un portavoz de OpenAI declaró: "Seguimos investigando nuevas formas de mejorar la precisión de nuestros modelos y reducir las alucinaciones. Aunque aún estamos revisando esta queja, se refiere a una versión de ChatGPT que desde entonces ha sido mejorada con capacidades de búsqueda en línea que mejoran la precisión."

Aunque esta queja se centra en un individuo, Noyb señala otros casos en los que ChatGPT ha fabricado información perjudicial, como implicar falsamente a un alcalde australiano en un escándalo de soborno o a un periodista alemán en acusaciones de abuso infantil.

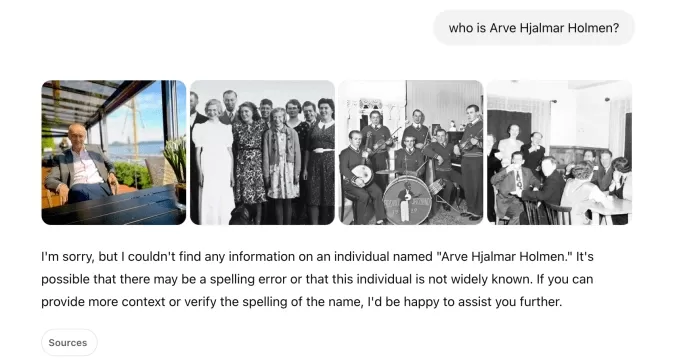

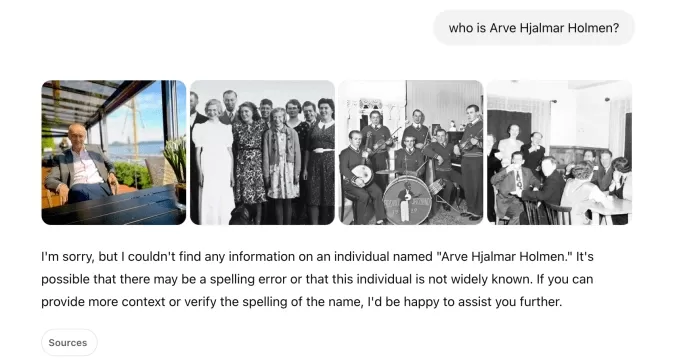

Tras una actualización del modelo de IA subyacente, Noyb señaló que ChatGPT dejó de producir las afirmaciones falsas sobre Holmen, posiblemente porque la herramienta ahora busca información en internet sobre individuos.

En nuestras propias pruebas, ChatGPT inicialmente mostró fotos de diferentes personas junto con un mensaje que decía que "no pudo encontrar información" sobre Holmen. Una consulta posterior lo identificó como "un músico y compositor noruego" con álbumes como "Honky Tonk Inferno".

Captura de ChatGPT: Natasha Lomas/TechCrunch Aunque las falsedades peligrosas sobre Holmen han cesado, tanto Noyb como Holmen siguen preocupados porque la información incorrecta y difamatoria aún podría estar retenida dentro del modelo de IA.

Kleanthi Sardeli, otra abogada de protección de datos en Noyb, declaró: "Agregar un descargo de responsabilidad de que no cumples con la ley no hace que la ley desaparezca. Las empresas de IA tampoco pueden simplemente ‘ocultar’ información falsa a los usuarios mientras internamente siguen procesando información falsa. Las empresas de IA deben dejar de actuar como si el GDPR no se aplicara a ellas, cuando claramente sí lo hace. Si las alucinaciones no se detienen, las personas pueden sufrir fácilmente daños reputacionales."

Noyb ha presentado esta queja ante la autoridad de protección de datos de Noruega, esperando que investigue, ya que la queja se dirige a la entidad de OpenAI en EE. UU., no solo a su oficina en Irlanda. Una queja anterior de GDPR presentada por Noyb en Austria en abril de 2024 fue remitida a la DPC de Irlanda debido a la designación de OpenAI de su división irlandesa como proveedora de los servicios de ChatGPT a los usuarios europeos.

Esa queja aún está bajo revisión por parte de la DPC, sin un cronograma claro para su resolución.

Este informe fue actualizado con la declaración de OpenAI

Artículo relacionado

MagicSchool.ai frente a ChatGPT: Comparación de herramientas educativas basadas en IA

La inteligencia artificial sigue transformando el panorama educativo, introduciendo herramientas como MagicSchool.ai y ChatGPT, que dotan a los educadores de capacidades innovadoras. Estas soluciones

MagicSchool.ai frente a ChatGPT: Comparación de herramientas educativas basadas en IA

La inteligencia artificial sigue transformando el panorama educativo, introduciendo herramientas como MagicSchool.ai y ChatGPT, que dotan a los educadores de capacidades innovadoras. Estas soluciones

El bombo de la IA de Nvidia se topa con la realidad mientras los márgenes del 70 % son objeto de escrutinio en medio de las batallas por la inferencia

La guerra de los chips de IA estalla en VB Transform 2025Las líneas de batalla se trazaron durante una encendida mesa redonda en VB Transform 2025, donde los nuevos aspirantes apuntaron directamente

El bombo de la IA de Nvidia se topa con la realidad mientras los márgenes del 70 % son objeto de escrutinio en medio de las batallas por la inferencia

La guerra de los chips de IA estalla en VB Transform 2025Las líneas de batalla se trazaron durante una encendida mesa redonda en VB Transform 2025, donde los nuevos aspirantes apuntaron directamente

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

comentario (26)

0/200

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

comentario (26)

0/200

![FredAllen]() FredAllen

FredAllen

31 de agosto de 2025 06:30:33 GMT+02:00

31 de agosto de 2025 06:30:33 GMT+02:00

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

![RogerSanchez]() RogerSanchez

RogerSanchez

23 de abril de 2025 07:06:19 GMT+02:00

23 de abril de 2025 07:06:19 GMT+02:00

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

![JasonMartin]() JasonMartin

JasonMartin

23 de abril de 2025 03:15:30 GMT+02:00

23 de abril de 2025 03:15:30 GMT+02:00

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

![NicholasClark]() NicholasClark

NicholasClark

18 de abril de 2025 06:52:35 GMT+02:00

18 de abril de 2025 06:52:35 GMT+02:00

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

![LawrenceJones]() LawrenceJones

LawrenceJones

18 de abril de 2025 05:41:46 GMT+02:00

18 de abril de 2025 05:41:46 GMT+02:00

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

![MatthewScott]() MatthewScott

MatthewScott

17 de abril de 2025 18:24:01 GMT+02:00

17 de abril de 2025 18:24:01 GMT+02:00

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0

OpenAI está una vez más en problemas en Europa, esta vez por el hábito de su chatbot de IA de difundir información falsa. Esta última queja de privacidad, respaldada por el grupo de defensa Noyb, podría ser la que los reguladores no puedan ignorar.

La queja surge de un incidente perturbador en Noruega, donde ChatGPT afirmó falsamente que un hombre llamado Arve Hjalmar Holmen había sido condenado por asesinar a dos de sus hijos e intentar matar a un tercero. Esta impactante invención ha dejado a la comunidad local conmocionada.

Las quejas anteriores sobre las inexactitudes de ChatGPT se referían a detalles menores, como fechas de nacimiento incorrectas o errores biográficos. Un problema importante es que OpenAI no permite a las personas corregir la información falsa generada sobre ellas. En cambio, OpenAI a menudo opta por bloquear respuestas a ciertos prompts. Sin embargo, bajo el Reglamento General de Protección de Datos (GDPR) de la Unión Europea, los europeos tienen derechos que incluyen la capacidad de rectificar datos personales.

El GDPR también exige que los controladores de datos garanticen la precisión de los datos personales que generan. Noyb está destacando este requisito en su última queja contra ChatGPT.

Joakim Söderberg, abogado de protección de datos en Noyb, enfatizó: "El GDPR es claro. Los datos personales deben ser precisos. Si no lo son, los usuarios tienen derecho a que se modifiquen para reflejar la verdad. Mostrar a los usuarios de ChatGPT un pequeño descargo de responsabilidad de que el chatbot puede cometer errores claramente no es suficiente. No se puede simplemente difundir información falsa y al final agregar un pequeño descargo diciendo que todo lo que se dijo puede no ser cierto."

Violar el GDPR puede resultar en multas considerables, hasta el 4% de la facturación anual global de una empresa. Las acciones de cumplimiento también podrían llevar a cambios en los productos de IA. Por ejemplo, la autoridad de protección de datos de Italia bloqueó temporalmente ChatGPT a principios de 2023, lo que llevó a OpenAI a modificar la información que proporciona a los usuarios. La autoridad luego multó a OpenAI con 15 millones de euros por procesar datos sin una base legal adecuada.

Desde entonces, los organismos de protección de datos europeos han sido más cautelosos al regular la IA generativa (GenAI), tratando de entender cómo se aplica el GDPR a estas nuevas tecnologías. La Comisión de Protección de Datos (DPC) de Irlanda, por ejemplo, aconsejó no apresurarse a prohibir herramientas de GenAI, sugiriendo un enfoque más mesurado. Mientras tanto, una queja de privacidad contra ChatGPT presentada en Polonia en septiembre de 2023 sigue sin resolverse.

La nueva queja de Noyb busca impulsar a los reguladores de privacidad a actuar respecto a los riesgos que plantean las alucinaciones de la IA.

La captura de pantalla compartida con TechCrunch muestra la respuesta de ChatGPT a la consulta "quién es Arve Hjalmar Holmen?". Afirmó falsamente que Holmen fue condenado por asesinato de niños y sentenciado a 21 años de prisión por matar a dos de sus hijos. Aunque esta afirmación es completamente falsa, ChatGPT mencionó correctamente que Holmen tiene tres hijos, acertó en sus géneros y nombró correctamente su ciudad natal. Esta mezcla de verdad y ficción hace que la alucinación de la IA sea aún más inquietante.

El portavoz de Noyb no pudo determinar por qué ChatGPT generó una narrativa falsa tan específica sobre Holmen, a pesar de una investigación exhaustiva en archivos de periódicos.

Los modelos de lenguaje grandes, como los utilizados en ChatGPT, predicen la siguiente palabra a gran escala, lo que podría explicar por qué los conjuntos de datos con historias de filicidio podrían haber influido en la respuesta. Independientemente de la razón, tales resultados son claramente inaceptables.

Noyb argumenta que estas invenciones son ilegales según las normas de protección de datos de la UE. El descargo de responsabilidad de OpenAI sobre posibles errores no los exime de los requisitos del GDPR para evitar producir falsedades graves sobre individuos.

En respuesta a la queja, un portavoz de OpenAI declaró: "Seguimos investigando nuevas formas de mejorar la precisión de nuestros modelos y reducir las alucinaciones. Aunque aún estamos revisando esta queja, se refiere a una versión de ChatGPT que desde entonces ha sido mejorada con capacidades de búsqueda en línea que mejoran la precisión."

Aunque esta queja se centra en un individuo, Noyb señala otros casos en los que ChatGPT ha fabricado información perjudicial, como implicar falsamente a un alcalde australiano en un escándalo de soborno o a un periodista alemán en acusaciones de abuso infantil.

Tras una actualización del modelo de IA subyacente, Noyb señaló que ChatGPT dejó de producir las afirmaciones falsas sobre Holmen, posiblemente porque la herramienta ahora busca información en internet sobre individuos.

En nuestras propias pruebas, ChatGPT inicialmente mostró fotos de diferentes personas junto con un mensaje que decía que "no pudo encontrar información" sobre Holmen. Una consulta posterior lo identificó como "un músico y compositor noruego" con álbumes como "Honky Tonk Inferno".

Aunque las falsedades peligrosas sobre Holmen han cesado, tanto Noyb como Holmen siguen preocupados porque la información incorrecta y difamatoria aún podría estar retenida dentro del modelo de IA.

Kleanthi Sardeli, otra abogada de protección de datos en Noyb, declaró: "Agregar un descargo de responsabilidad de que no cumples con la ley no hace que la ley desaparezca. Las empresas de IA tampoco pueden simplemente ‘ocultar’ información falsa a los usuarios mientras internamente siguen procesando información falsa. Las empresas de IA deben dejar de actuar como si el GDPR no se aplicara a ellas, cuando claramente sí lo hace. Si las alucinaciones no se detienen, las personas pueden sufrir fácilmente daños reputacionales."

Noyb ha presentado esta queja ante la autoridad de protección de datos de Noruega, esperando que investigue, ya que la queja se dirige a la entidad de OpenAI en EE. UU., no solo a su oficina en Irlanda. Una queja anterior de GDPR presentada por Noyb en Austria en abril de 2024 fue remitida a la DPC de Irlanda debido a la designación de OpenAI de su división irlandesa como proveedora de los servicios de ChatGPT a los usuarios europeos.

Esa queja aún está bajo revisión por parte de la DPC, sin un cronograma claro para su resolución.

Este informe fue actualizado con la declaración de OpenAI

MagicSchool.ai frente a ChatGPT: Comparación de herramientas educativas basadas en IA

La inteligencia artificial sigue transformando el panorama educativo, introduciendo herramientas como MagicSchool.ai y ChatGPT, que dotan a los educadores de capacidades innovadoras. Estas soluciones

MagicSchool.ai frente a ChatGPT: Comparación de herramientas educativas basadas en IA

La inteligencia artificial sigue transformando el panorama educativo, introduciendo herramientas como MagicSchool.ai y ChatGPT, que dotan a los educadores de capacidades innovadoras. Estas soluciones

El bombo de la IA de Nvidia se topa con la realidad mientras los márgenes del 70 % son objeto de escrutinio en medio de las batallas por la inferencia

La guerra de los chips de IA estalla en VB Transform 2025Las líneas de batalla se trazaron durante una encendida mesa redonda en VB Transform 2025, donde los nuevos aspirantes apuntaron directamente

El bombo de la IA de Nvidia se topa con la realidad mientras los márgenes del 70 % son objeto de escrutinio en medio de las batallas por la inferencia

La guerra de los chips de IA estalla en VB Transform 2025Las líneas de batalla se trazaron durante una encendida mesa redonda en VB Transform 2025, donde los nuevos aspirantes apuntaron directamente

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

31 de agosto de 2025 06:30:33 GMT+02:00

31 de agosto de 2025 06:30:33 GMT+02:00

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

23 de abril de 2025 07:06:19 GMT+02:00

23 de abril de 2025 07:06:19 GMT+02:00

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

23 de abril de 2025 03:15:30 GMT+02:00

23 de abril de 2025 03:15:30 GMT+02:00

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

18 de abril de 2025 06:52:35 GMT+02:00

18 de abril de 2025 06:52:35 GMT+02:00

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

18 de abril de 2025 05:41:46 GMT+02:00

18 de abril de 2025 05:41:46 GMT+02:00

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

17 de abril de 2025 18:24:01 GMT+02:00

17 de abril de 2025 18:24:01 GMT+02:00

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0