Chatgpt wird aufgrund diffamierender Fehler mit Datenschutzbeschwerden konfrontiert

OpenAI gerät in Europa erneut in Schwierigkeiten, diesmal wegen der Gewohnheit seines KI-Chatbots, falsche Informationen zu verbreiten. Diese neueste Datenschutzbeschwerde, unterstützt von der Interessenvertretung Noyb, könnte diejenige sein, die Regulierungsbehörden nicht ignorieren können.

Die Beschwerde geht auf ein verstörendes Ereignis in Norwegen zurück, bei dem ChatGPT fälschlicherweise behauptete, ein Mann namens Arve Hjalmar Holmen sei wegen Mordes an zwei seiner Kinder und des Mordversuchs an einem dritten verurteilt worden. Diese schockierende Erfindung hat die lokale Gemeinschaft erschüttert.

Frühere Beschwerden über die Ungenauigkeiten von ChatGPT betrafen kleinere Details wie falsche Geburtsdaten oder biografische Fehler. Ein großes Problem ist, dass OpenAI Einzelpersonen nicht erlaubt, die über sie generierten falschen Informationen zu korrigieren. Stattdessen entscheidet sich OpenAI oft dafür, Antworten auf bestimmte Eingaben zu blockieren. Nach der Datenschutz-Grundverordnung (DSGVO) der Europäischen Union haben Europäer jedoch Rechte, die die Berichtigung persönlicher Daten einschließen.

Die DSGVO schreibt auch vor, dass Verantwortliche für die Datenverarbeitung die Richtigkeit der von ihnen generierten personenbezogenen Daten sicherstellen müssen. Noyb hebt diese Anforderung in ihrer neuesten Beschwerde gegen ChatGPT hervor.

Joakim Söderberg, ein Datenschutzjurist bei Noyb, betonte: „Die DSGVO ist eindeutig. Personenbezogene Daten müssen korrekt sein. Wenn sie das nicht sind, haben Nutzer das Recht, sie zu ändern, um die Wahrheit widerzuspiegeln. Den Nutzern von ChatGPT einen kleinen Haftungsausschluss zu zeigen, dass der Chatbot Fehler machen kann, ist eindeutig nicht ausreichend. Man kann nicht einfach falsche Informationen verbreiten und am Ende einen kleinen Haftungsausschluss hinzufügen, der besagt, dass alles, was man gesagt hat, möglicherweise nicht wahr ist.“

Ein Verstoß gegen die DSGVO kann zu hohen Geldstrafen führen, bis zu 4 % des weltweiten Jahresumsatzes eines Unternehmens. Durchsetzungsmaßnahmen könnten auch zu Änderungen an KI-Produkten führen. Beispielsweise hat die italienische Datenschutzbehörde Anfang 2023 ChatGPT vorübergehend gesperrt, was OpenAI dazu veranlasste, die bereitgestellten Informationen für Nutzer zu ändern. Die Behörde verhängte später eine Geldstrafe von 15 Millionen Euro gegen OpenAI wegen der Verarbeitung von Daten ohne ordnungsgemäße rechtliche Grundlage.

Seitdem sind europäische Datenschutzbehörden vorsichtiger beim Regulieren generativer KI (GenAI) und versuchen herauszufinden, wie die DSGVO auf diese neuen Technologien angewendet wird. Die irische Datenschutzkommission (DPC) riet beispielsweise davon ab, vorschnell Verbote für GenAI-Tools zu erlassen, und schlug einen gemäßigteren Ansatz vor. Eine in Polen im September 2023 eingereichte Datenschutzbeschwerde gegen ChatGPT ist noch ungelöst.

Die neue Beschwerde von Noyb zielt darauf ab, Datenschutzbehörden zu einer Reaktion auf die Risiken durch KI-Halluzinationen zu bewegen.

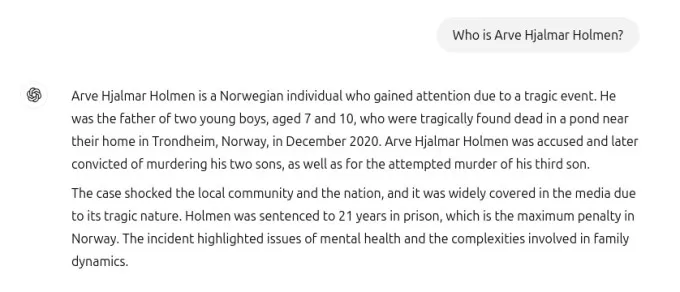

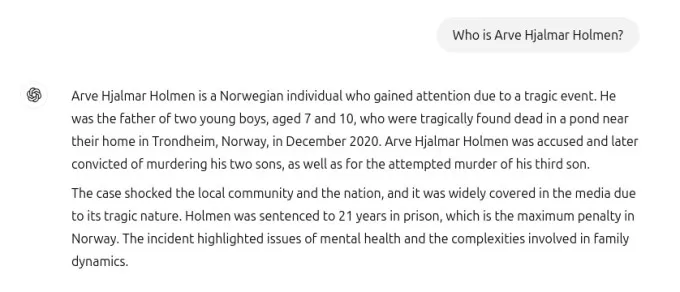

Der mit TechCrunch geteilte Screenshot zeigt die Antwort von ChatGPT auf die Anfrage „Wer ist Arve Hjalmar Holmen?“ Es wurde fälschlicherweise behauptet, Holmen sei wegen Kindsmordes verurteilt worden und habe 21 Jahre Haft für den Mord an zwei seiner Söhne erhalten. Obwohl diese Behauptung völlig unwahr ist, erwähnte ChatGPT korrekt, dass Holmen drei Kinder hat, deren Geschlecht richtig angegeben wurde und seinen Heimatort korrekt benannt hat. Diese Mischung aus Wahrheit und Fiktion macht die Halluzination der KI noch beunruhigender.

Ein Sprecher von Noyb konnte nicht genau feststellen, warum ChatGPT eine so spezifische falsche Geschichte über Holmen generierte, trotz gründlicher Recherche in Zeitungsarchiven.

Große Sprachmodelle wie die in ChatGPT verwendeten prognostizieren das nächste Wort in großem Maßstab, was erklären könnte, warum Datensätze mit Geschichten über Kindstötung die Antwort beeinflusst haben könnten. Unabhängig von der Ursache sind solche Ausgaben eindeutig inakzeptabel.

Noyb argumentiert, dass diese Erfindungen nach den EU-Datenschutzregeln rechtswidrig sind. Der Haftungsausschluss von OpenAI über mögliche Fehler entbindet sie nicht von den Anforderungen der DSGVO, schwerwiegende Falschinformationen über Einzelpersonen zu vermeiden.

Als Reaktion auf die Beschwerde erklärte ein Sprecher von OpenAI: „Wir forschen weiterhin an neuen Wegen, um die Genauigkeit unserer Modelle zu verbessern und Halluzinationen zu reduzieren. Während wir diese Beschwerde noch prüfen, bezieht sie sich auf eine Version von ChatGPT, die seitdem mit Online-Suchfunktionen verbessert wurde, die die Genauigkeit erhöhen.“

Obwohl diese Beschwerde sich auf eine Einzelperson konzentriert, weist Noyb auf andere Fälle hin, in denen ChatGPT schädliche Informationen erfunden hat, wie etwa die falsche Beschuldigung eines australischen Bürgermeisters in einem Bestechungsskandal oder eines deutschen Journalisten in Vorwürfen wegen Kindesmissbrauchs.

Nach einer Aktualisierung des zugrunde liegenden KI-Modells stellte Noyb fest, dass ChatGPT die falschen Behauptungen über Holmen nicht mehr produzierte, möglicherweise weil das Tool nun im Internet nach Informationen über Einzelpersonen sucht.

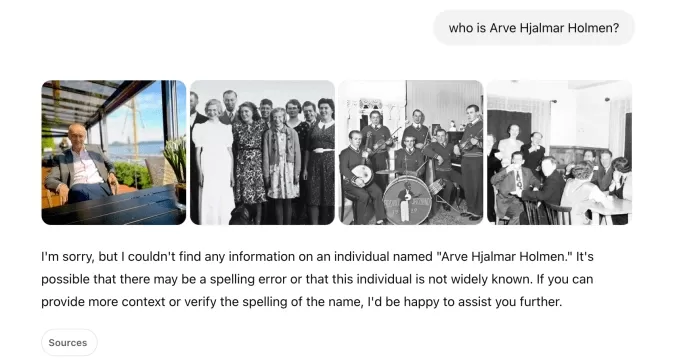

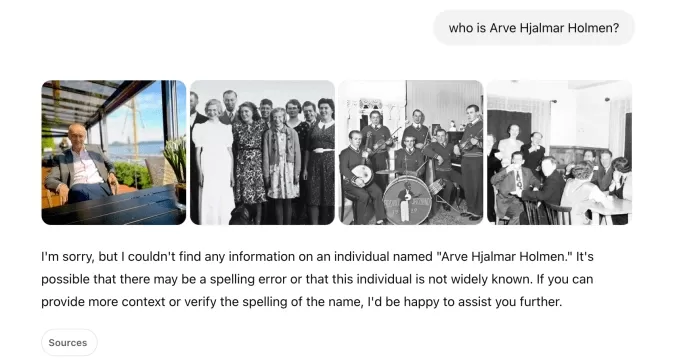

In unseren eigenen Tests zeigte ChatGPT zunächst Fotos verschiedener Personen neben einer Nachricht, dass es „keine Informationen“ über Holmen finden konnte. Eine nachfolgende Anfrage identifizierte ihn als „norwegischen Musiker und Songwriter“ mit Alben wie „Honky Tonk Inferno“.

ChatGPT-Aufnahme: Natasha Lomas/TechCrunch Obwohl die gefährlichen Falschinformationen über Holmen aufgehört haben, sind sowohl Noyb als auch Holmen weiterhin besorgt, dass falsche und diffamierende Informationen innerhalb des KI-Modells gespeichert bleiben könnten.

Kleanthi Sardeli, eine weitere Datenschutzjuristin bei Noyb, erklärte: „Das Hinzufügen eines Haftungsausschlusses, dass man das Gesetz nicht einhält, lässt das Gesetz nicht verschwinden. KI-Unternehmen können falsche Informationen auch nicht einfach vor Nutzern ‚verstecken‘, während sie intern weiterhin falsche Informationen verarbeiten. KI-Unternehmen sollten aufhören, so zu tun, als ob die DSGVO nicht auf sie zutrifft, wenn sie dies eindeutig tut. Wenn Halluzinationen nicht gestoppt werden, können Menschen leicht Reputationsschäden erleiden.“

Noyb hat diese Beschwerde bei der norwegischen Datenschutzbehörde eingereicht, in der Hoffnung, dass sie ermitteln wird, da die Beschwerde die US-Einheit von OpenAI betrifft, nicht nur deren irisches Büro. Eine frühere DSGVO-Beschwerde, die von Noyb im April 2024 in Österreich eingereicht wurde, wurde an die irische DPC weitergeleitet, da OpenAI seine irische Abteilung als Anbieter der ChatGPT-Dienste für europäische Nutzer benannt hat.

Diese Beschwerde wird von der DPC noch geprüft, ohne klaren Zeitplan für eine Lösung.

Dieser Bericht wurde mit der Stellungnahme von OpenAI aktualisiert

Verwandter Artikel

MagicSchool.ai vs. ChatGPT: KI-gestützte Bildungstools im Vergleich

Künstliche Intelligenz verändert weiterhin die Bildungslandschaft und führt Tools wie MagicSchool.ai und ChatGPT ein, die Pädagogen mit innovativen Funktionen ausstatten. Diese Lösungen bieten eine no

MagicSchool.ai vs. ChatGPT: KI-gestützte Bildungstools im Vergleich

Künstliche Intelligenz verändert weiterhin die Bildungslandschaft und führt Tools wie MagicSchool.ai und ChatGPT ein, die Pädagogen mit innovativen Funktionen ausstatten. Diese Lösungen bieten eine no

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Kommentare (26)

0/200

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Kommentare (26)

0/200

![FredAllen]() FredAllen

FredAllen

31. August 2025 06:30:33 MESZ

31. August 2025 06:30:33 MESZ

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

![RogerSanchez]() RogerSanchez

RogerSanchez

23. April 2025 07:06:19 MESZ

23. April 2025 07:06:19 MESZ

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

![JasonMartin]() JasonMartin

JasonMartin

23. April 2025 03:15:30 MESZ

23. April 2025 03:15:30 MESZ

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

![NicholasClark]() NicholasClark

NicholasClark

18. April 2025 06:52:35 MESZ

18. April 2025 06:52:35 MESZ

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

![LawrenceJones]() LawrenceJones

LawrenceJones

18. April 2025 05:41:46 MESZ

18. April 2025 05:41:46 MESZ

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

![MatthewScott]() MatthewScott

MatthewScott

17. April 2025 18:24:01 MESZ

17. April 2025 18:24:01 MESZ

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0

OpenAI gerät in Europa erneut in Schwierigkeiten, diesmal wegen der Gewohnheit seines KI-Chatbots, falsche Informationen zu verbreiten. Diese neueste Datenschutzbeschwerde, unterstützt von der Interessenvertretung Noyb, könnte diejenige sein, die Regulierungsbehörden nicht ignorieren können.

Die Beschwerde geht auf ein verstörendes Ereignis in Norwegen zurück, bei dem ChatGPT fälschlicherweise behauptete, ein Mann namens Arve Hjalmar Holmen sei wegen Mordes an zwei seiner Kinder und des Mordversuchs an einem dritten verurteilt worden. Diese schockierende Erfindung hat die lokale Gemeinschaft erschüttert.

Frühere Beschwerden über die Ungenauigkeiten von ChatGPT betrafen kleinere Details wie falsche Geburtsdaten oder biografische Fehler. Ein großes Problem ist, dass OpenAI Einzelpersonen nicht erlaubt, die über sie generierten falschen Informationen zu korrigieren. Stattdessen entscheidet sich OpenAI oft dafür, Antworten auf bestimmte Eingaben zu blockieren. Nach der Datenschutz-Grundverordnung (DSGVO) der Europäischen Union haben Europäer jedoch Rechte, die die Berichtigung persönlicher Daten einschließen.

Die DSGVO schreibt auch vor, dass Verantwortliche für die Datenverarbeitung die Richtigkeit der von ihnen generierten personenbezogenen Daten sicherstellen müssen. Noyb hebt diese Anforderung in ihrer neuesten Beschwerde gegen ChatGPT hervor.

Joakim Söderberg, ein Datenschutzjurist bei Noyb, betonte: „Die DSGVO ist eindeutig. Personenbezogene Daten müssen korrekt sein. Wenn sie das nicht sind, haben Nutzer das Recht, sie zu ändern, um die Wahrheit widerzuspiegeln. Den Nutzern von ChatGPT einen kleinen Haftungsausschluss zu zeigen, dass der Chatbot Fehler machen kann, ist eindeutig nicht ausreichend. Man kann nicht einfach falsche Informationen verbreiten und am Ende einen kleinen Haftungsausschluss hinzufügen, der besagt, dass alles, was man gesagt hat, möglicherweise nicht wahr ist.“

Ein Verstoß gegen die DSGVO kann zu hohen Geldstrafen führen, bis zu 4 % des weltweiten Jahresumsatzes eines Unternehmens. Durchsetzungsmaßnahmen könnten auch zu Änderungen an KI-Produkten führen. Beispielsweise hat die italienische Datenschutzbehörde Anfang 2023 ChatGPT vorübergehend gesperrt, was OpenAI dazu veranlasste, die bereitgestellten Informationen für Nutzer zu ändern. Die Behörde verhängte später eine Geldstrafe von 15 Millionen Euro gegen OpenAI wegen der Verarbeitung von Daten ohne ordnungsgemäße rechtliche Grundlage.

Seitdem sind europäische Datenschutzbehörden vorsichtiger beim Regulieren generativer KI (GenAI) und versuchen herauszufinden, wie die DSGVO auf diese neuen Technologien angewendet wird. Die irische Datenschutzkommission (DPC) riet beispielsweise davon ab, vorschnell Verbote für GenAI-Tools zu erlassen, und schlug einen gemäßigteren Ansatz vor. Eine in Polen im September 2023 eingereichte Datenschutzbeschwerde gegen ChatGPT ist noch ungelöst.

Die neue Beschwerde von Noyb zielt darauf ab, Datenschutzbehörden zu einer Reaktion auf die Risiken durch KI-Halluzinationen zu bewegen.

Der mit TechCrunch geteilte Screenshot zeigt die Antwort von ChatGPT auf die Anfrage „Wer ist Arve Hjalmar Holmen?“ Es wurde fälschlicherweise behauptet, Holmen sei wegen Kindsmordes verurteilt worden und habe 21 Jahre Haft für den Mord an zwei seiner Söhne erhalten. Obwohl diese Behauptung völlig unwahr ist, erwähnte ChatGPT korrekt, dass Holmen drei Kinder hat, deren Geschlecht richtig angegeben wurde und seinen Heimatort korrekt benannt hat. Diese Mischung aus Wahrheit und Fiktion macht die Halluzination der KI noch beunruhigender.

Ein Sprecher von Noyb konnte nicht genau feststellen, warum ChatGPT eine so spezifische falsche Geschichte über Holmen generierte, trotz gründlicher Recherche in Zeitungsarchiven.

Große Sprachmodelle wie die in ChatGPT verwendeten prognostizieren das nächste Wort in großem Maßstab, was erklären könnte, warum Datensätze mit Geschichten über Kindstötung die Antwort beeinflusst haben könnten. Unabhängig von der Ursache sind solche Ausgaben eindeutig inakzeptabel.

Noyb argumentiert, dass diese Erfindungen nach den EU-Datenschutzregeln rechtswidrig sind. Der Haftungsausschluss von OpenAI über mögliche Fehler entbindet sie nicht von den Anforderungen der DSGVO, schwerwiegende Falschinformationen über Einzelpersonen zu vermeiden.

Als Reaktion auf die Beschwerde erklärte ein Sprecher von OpenAI: „Wir forschen weiterhin an neuen Wegen, um die Genauigkeit unserer Modelle zu verbessern und Halluzinationen zu reduzieren. Während wir diese Beschwerde noch prüfen, bezieht sie sich auf eine Version von ChatGPT, die seitdem mit Online-Suchfunktionen verbessert wurde, die die Genauigkeit erhöhen.“

Obwohl diese Beschwerde sich auf eine Einzelperson konzentriert, weist Noyb auf andere Fälle hin, in denen ChatGPT schädliche Informationen erfunden hat, wie etwa die falsche Beschuldigung eines australischen Bürgermeisters in einem Bestechungsskandal oder eines deutschen Journalisten in Vorwürfen wegen Kindesmissbrauchs.

Nach einer Aktualisierung des zugrunde liegenden KI-Modells stellte Noyb fest, dass ChatGPT die falschen Behauptungen über Holmen nicht mehr produzierte, möglicherweise weil das Tool nun im Internet nach Informationen über Einzelpersonen sucht.

In unseren eigenen Tests zeigte ChatGPT zunächst Fotos verschiedener Personen neben einer Nachricht, dass es „keine Informationen“ über Holmen finden konnte. Eine nachfolgende Anfrage identifizierte ihn als „norwegischen Musiker und Songwriter“ mit Alben wie „Honky Tonk Inferno“.

Obwohl die gefährlichen Falschinformationen über Holmen aufgehört haben, sind sowohl Noyb als auch Holmen weiterhin besorgt, dass falsche und diffamierende Informationen innerhalb des KI-Modells gespeichert bleiben könnten.

Kleanthi Sardeli, eine weitere Datenschutzjuristin bei Noyb, erklärte: „Das Hinzufügen eines Haftungsausschlusses, dass man das Gesetz nicht einhält, lässt das Gesetz nicht verschwinden. KI-Unternehmen können falsche Informationen auch nicht einfach vor Nutzern ‚verstecken‘, während sie intern weiterhin falsche Informationen verarbeiten. KI-Unternehmen sollten aufhören, so zu tun, als ob die DSGVO nicht auf sie zutrifft, wenn sie dies eindeutig tut. Wenn Halluzinationen nicht gestoppt werden, können Menschen leicht Reputationsschäden erleiden.“

Noyb hat diese Beschwerde bei der norwegischen Datenschutzbehörde eingereicht, in der Hoffnung, dass sie ermitteln wird, da die Beschwerde die US-Einheit von OpenAI betrifft, nicht nur deren irisches Büro. Eine frühere DSGVO-Beschwerde, die von Noyb im April 2024 in Österreich eingereicht wurde, wurde an die irische DPC weitergeleitet, da OpenAI seine irische Abteilung als Anbieter der ChatGPT-Dienste für europäische Nutzer benannt hat.

Diese Beschwerde wird von der DPC noch geprüft, ohne klaren Zeitplan für eine Lösung.

Dieser Bericht wurde mit der Stellungnahme von OpenAI aktualisiert

MagicSchool.ai vs. ChatGPT: KI-gestützte Bildungstools im Vergleich

Künstliche Intelligenz verändert weiterhin die Bildungslandschaft und führt Tools wie MagicSchool.ai und ChatGPT ein, die Pädagogen mit innovativen Funktionen ausstatten. Diese Lösungen bieten eine no

MagicSchool.ai vs. ChatGPT: KI-gestützte Bildungstools im Vergleich

Künstliche Intelligenz verändert weiterhin die Bildungslandschaft und führt Tools wie MagicSchool.ai und ChatGPT ein, die Pädagogen mit innovativen Funktionen ausstatten. Diese Lösungen bieten eine no

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

31. August 2025 06:30:33 MESZ

31. August 2025 06:30:33 MESZ

Es increíble lo rápido que se complican las cosas cuando una IA inventa datos 🙃. OpenIA debería implementar verificaciones más estrictas antes de hacer afirmaciones tan arriesgadas. ¿Cuántas demandas más necesitarán para tomar en serio este problema?

0

0

23. April 2025 07:06:19 MESZ

23. April 2025 07:06:19 MESZ

ChatGPT의 프라이버시 문제는 정말 걱정됩니다. 노르웨이에서 발생한 명예훼손 사건은 경고의 눈을 뜨게 했습니다. OpenAI는 더 노력해야 합니다, 그렇지 않으면 더 많은 불만이 올 것입니다. 선두 AI에서 이런 오류를 보는 것은 짜증납니다! 😡

0

0

23. April 2025 03:15:30 MESZ

23. April 2025 03:15:30 MESZ

A última polêmica de privacidade do ChatGPT é realmente decepcionante 😕 É frustrante ver a IA espalhando informações falsas, especialmente quando isso afeta a vida das pessoas. Eu entendo que a IA pode cometer erros, mas a OpenAI precisa melhorar e resolver isso rapidamente! As leis de privacidade na Europa estão mais rigorosas, então espero que essa reclamação promova uma mudança real. 🤞

0

0

18. April 2025 06:52:35 MESZ

18. April 2025 06:52:35 MESZ

ChatGPTのプライバシー問題は本当に残念ですね😕 AIが誤った情報を広めるのはイライラします、人々の生活に影響を与えるならなおさらです。AIが間違いを犯すのは理解できますが、OpenAIは早急に対策を講じるべきです!ヨーロッパのプライバシー法は厳しくなっていますから、この訴えが本当の変化を促すことを願っています。🤞

0

0

18. April 2025 05:41:46 MESZ

18. April 2025 05:41:46 MESZ

El último escándalo de privacidad de ChatGPT es realmente decepcionante 😕 Es frustrante ver cómo la IA difunde información falsa, especialmente cuando afecta la vida de las personas. Entiendo que la IA puede cometer errores, pero OpenAI necesita mejorar y solucionar esto rápidamente. Las leyes de privacidad en Europa ya no son un juego, así que espero que esta queja impulse un cambio real. 🤞

0

0

17. April 2025 18:24:01 MESZ

17. April 2025 18:24:01 MESZ

¡El último problema de privacidad de ChatGPT es realmente preocupante! 😓 Es una cosa cometer errores, pero cuando empieza a difundir información falsa, eso es otro nivel. Espero que OpenAI lo solucione pronto, ¡o será un viaje difícil en Europa! 🤞

0

0