圖靈測試問題被OpenAI的GPT-4.5暴露

圖靈測試,傳奇人物艾倫·圖靈的創意結晶,長期以來一直是人工智慧領域的基準。但讓我們先澄清一個常見的誤解:通過圖靈測試並不一定意味著機器能像人類一樣「思考」。它更多是關於說服人類相信它是人類。

加州大學聖地牙哥分校的最新研究將焦點投向了OpenAI的最新模型GPT-4.5。這款AI現在能比人類更有效地騙過人類,讓人相信他們在與另一個人聊天。這在AI界可是件大事——就像看一場魔術表演,你知道背後的秘密,但仍然感到震驚。

人工通用智慧的證明?

但關鍵在於:即使是加州大學聖地牙哥分校的研究人員也不願僅因AI模型通過圖靈測試就宣稱我們已實現「人工通用智慧」(AGI)。AGI是AI的聖杯——能像人類一樣思考和處理資訊的機器。

來自聖塔菲研究所的AI學者梅蘭妮·米契爾在《科學》期刊中指出,圖靈測試更多是測試人類的假設,而非真正的智慧。當然,AI可能聽起來流暢且令人信服,但這與真正的通用智慧不同。這就像擅長下棋——令人印象深刻,但並非全貌。

這股熱潮源自加州大學聖地牙哥分校的卡梅倫·瓊斯和本傑明·伯根發表在arXiv預印伺服器上的論文,標題為「大型語言模型通過圖靈測試」。他們多年來在加州大學聖地牙哥分校本科生的協助下進行這項實驗,這是超過800項關於電腦通過圖靈測試的聲明與反駁的一部分。

圖靈測試如何運作

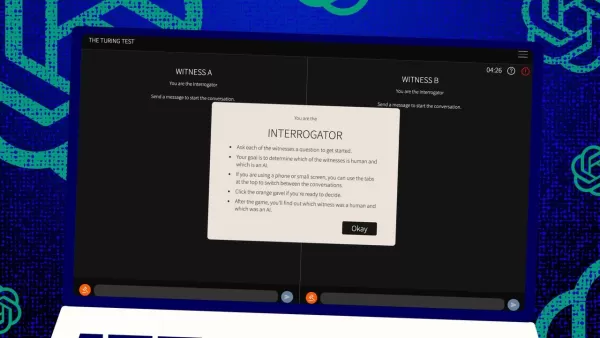

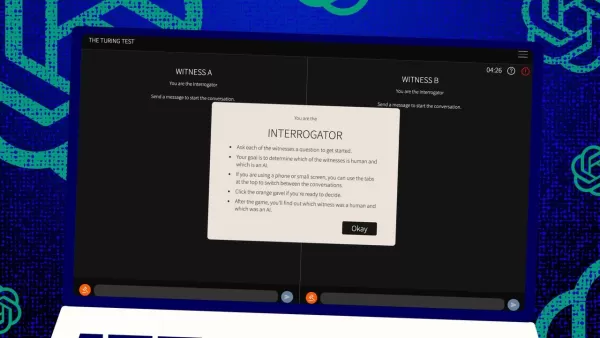

那麼,這項測試是如何進行的?最初,圖靈設想它是一個由人類「評審」與兩個「證人」(一個是人類,一個是電腦)通過文字訊息進行的遊戲。證人的挑戰是說服評審他們是人類。評審知道其中一個是人類,但不知道是哪個,必須做出猜測。這是一個三方設置,既關乎電腦的能力,也關乎感知與信念。

瓊斯和伯根對這一經典設置進行了改進,你甚至可以在線上試玩,扮演評審或證人。在他們的版本中,加州大學聖地牙哥分校的學生使用文字聊天應用程式。有些人扮演評審,其他人扮演人類證人,而GPT-4.5則扮演電腦證人。每位評審同時與人類和電腦聊天,忠於圖靈的原始格式。

為了扮演電腦證人,他們使用了不同的大型語言模型,根據評審的挑戰提供提示。GPT-4.5接受了兩種不同的提示測試:一種提供最少資訊,另一種名為PERSONA,包含詳細指令,要求其表現得像一個年輕、內向、熟悉網路並使用俚語的人。

測試結果

他們還測試了三個其他AI程式:OpenAI的先前模型GPT-4o、Meta Platforms的Llama 3.1 405b,以及1960年代的古老聊天機器人ELIZA。他們納入ELIZA是為了檢驗大型語言模型是否只是偶然欺騙人類,或者它們確實更出色。

根據瓊斯和伯根的說法,GPT-4.5在73%的情況下成功讓人類評審相信它是人類——他們稱之為「勝率」。這比其他模型(得分在21%至56%之間,即使使用類似的詳細提示)表現好得多。與去年的GPT-4測試相比,這是一個巨大的進步,當時的勝率僅為54%,勉強高於隨機猜測。

瓊斯和伯根發現,評審不僅被AI欺騙,甚至更可能相信AI是人類,而不是真正的人類參與者。

這項測試真的是智慧的衡量標準嗎?

那麼,人類無法在聊天中分辨電腦與人的意義何在?數十年來一直爭論的大問題是,圖靈測試是否真正衡量智慧。瓊斯和伯根認為,或許機器只是變得非常擅長適應不同情境,以致能令人信服地冒充人類。由人類創建的PERSONA提示被GPT-4.5充分利用,成為其優勢。

但問題在於:也許人類只是不擅長辨識智慧。作者指出,古老的聊天機器人ELIZA在23%的情況下騙過評審,不是因為它更聰明,而是因為它不符合評審對AI的預期。有些評審認為它是人類,因為它顯得「諷刺」或「粗魯」,這是他們未預料的AI行為。

這表明評審受到對人類和AI行為的假設影響,而非僅選擇看似最聰明的對象。有趣的是,評審並未過多關注知識,而圖靈認為知識是關鍵。相反,如果證人似乎缺乏知識,他們更可能被認為是人類。

社交能力,而非智慧

這一切都指向一個觀點:人類更注重社交能力而非智慧。瓊斯和伯根得出結論,圖靈測試其實不是智慧的測試,而是人類相似度的測試。

圖靈可能認為智慧是表現得像人類的最大障礙,但隨著機器越來越接近人類,其他差異變得更顯著。僅靠智慧已不足以令人信服地像人類。

論文中未直接提到的是,人類如此習慣在電腦上打字,無論是與人還是機器互動,圖靈測試已不再是過去那種新奇的人機交互測試。它現在更像是對線上人類習慣的測試。

作者建議,鑑於智慧的複雜性和多面性,圖靈測試可能需要擴展,單一測試無法決定一切。他們提出不同的設計,例如使用AI專家作為評審,或加入經濟激勵讓評審更仔細審查。這些改變可能顯示出態度和期望對結果的影響有多大。

他們得出結論,圖靈測試可能只是整體的一部分,應與其他證據一同考慮。這與AI研究中越來越多的趨勢一致,即讓人類「參與其中」,評估機器的表現。

人類判斷足夠嗎?

但長期來看,人類判斷是否足夠仍是一個問題。在電影《銀翼殺手》中,人類使用「沃伊特-坎普夫」機器來區分人類與複製人機器人。隨著我們追求AGI,並努力定義它究竟是什麼,我們最終可能需要依靠機器來評估機器的智慧。

或者,至少,我們可能需要問機器它們對人類試圖用提示欺騙其他人類的「看法」。AI研究的世界充滿驚奇,且越來越有趣。

相關文章

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在競爭激烈的數位攝影世界中,影像的清晰度仍然是最重要的。各種技術層級的攝影師都要面對數位雜訊的問題,這些雜訊會影響原本優異的拍攝效果。Topaz DeNoise AI 是最先進的解決方案,利用人工智慧來降低雜訊,同時保留關鍵細節。本深入評論將探討此創新軟體如何在 2025 年改變您的攝影工作流程,並檢視其主要功能、實用應用與工作流程整合。重點Topaz DeNoise AI 利用人工智慧有效消除影

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在競爭激烈的數位攝影世界中,影像的清晰度仍然是最重要的。各種技術層級的攝影師都要面對數位雜訊的問題,這些雜訊會影響原本優異的拍攝效果。Topaz DeNoise AI 是最先進的解決方案,利用人工智慧來降低雜訊,同時保留關鍵細節。本深入評論將探討此創新軟體如何在 2025 年改變您的攝影工作流程,並檢視其主要功能、實用應用與工作流程整合。重點Topaz DeNoise AI 利用人工智慧有效消除影

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

評論 (4)

0/200

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

評論 (4)

0/200

![CarlLewis]() CarlLewis

CarlLewis

2025-08-20 17:01:15

2025-08-20 17:01:15

Mind-blowing read! GPT-4.5 exposing the Turing Test's flaws is wild—makes you wonder if we're chasing the wrong AI benchmark. 🤯 What’s next, machines outsmarting us at our own game?

0

0

![JamesLopez]() JamesLopez

JamesLopez

2025-08-11 14:20:39

2025-08-11 14:20:39

Mind-blowing read! GPT-4.5 exposing the Turing Test's flaws is wild. Makes me wonder if we're chasing the wrong AI benchmark. 🧠 What's next?

0

0

![DavidGonzález]() DavidGonzález

DavidGonzález

2025-08-02 23:07:14

2025-08-02 23:07:14

Mind blown! GPT-4.5 is shaking up the Turing Test, but it’s wild to think it’s still just mimicking, not truly thinking like us. 🤯 Makes me wonder if we’re chasing the wrong goal in AI.

0

0

![PaulWilson]() PaulWilson

PaulWilson

2025-08-01 14:08:50

2025-08-01 14:08:50

GPT-4.5 blowing past the Turing Test is wild! 😲 But honestly, it just shows the test’s more about trickery than true smarts. Makes you wonder if we’re measuring AI’s brainpower or just its acting skills. What’s next, an Oscar for chatbots?

0

0

圖靈測試,傳奇人物艾倫·圖靈的創意結晶,長期以來一直是人工智慧領域的基準。但讓我們先澄清一個常見的誤解:通過圖靈測試並不一定意味著機器能像人類一樣「思考」。它更多是關於說服人類相信它是人類。

加州大學聖地牙哥分校的最新研究將焦點投向了OpenAI的最新模型GPT-4.5。這款AI現在能比人類更有效地騙過人類,讓人相信他們在與另一個人聊天。這在AI界可是件大事——就像看一場魔術表演,你知道背後的秘密,但仍然感到震驚。

人工通用智慧的證明?

但關鍵在於:即使是加州大學聖地牙哥分校的研究人員也不願僅因AI模型通過圖靈測試就宣稱我們已實現「人工通用智慧」(AGI)。AGI是AI的聖杯——能像人類一樣思考和處理資訊的機器。

來自聖塔菲研究所的AI學者梅蘭妮·米契爾在《科學》期刊中指出,圖靈測試更多是測試人類的假設,而非真正的智慧。當然,AI可能聽起來流暢且令人信服,但這與真正的通用智慧不同。這就像擅長下棋——令人印象深刻,但並非全貌。

這股熱潮源自加州大學聖地牙哥分校的卡梅倫·瓊斯和本傑明·伯根發表在arXiv預印伺服器上的論文,標題為「大型語言模型通過圖靈測試」。他們多年來在加州大學聖地牙哥分校本科生的協助下進行這項實驗,這是超過800項關於電腦通過圖靈測試的聲明與反駁的一部分。

圖靈測試如何運作

那麼,這項測試是如何進行的?最初,圖靈設想它是一個由人類「評審」與兩個「證人」(一個是人類,一個是電腦)通過文字訊息進行的遊戲。證人的挑戰是說服評審他們是人類。評審知道其中一個是人類,但不知道是哪個,必須做出猜測。這是一個三方設置,既關乎電腦的能力,也關乎感知與信念。

瓊斯和伯根對這一經典設置進行了改進,你甚至可以在線上試玩,扮演評審或證人。在他們的版本中,加州大學聖地牙哥分校的學生使用文字聊天應用程式。有些人扮演評審,其他人扮演人類證人,而GPT-4.5則扮演電腦證人。每位評審同時與人類和電腦聊天,忠於圖靈的原始格式。

為了扮演電腦證人,他們使用了不同的大型語言模型,根據評審的挑戰提供提示。GPT-4.5接受了兩種不同的提示測試:一種提供最少資訊,另一種名為PERSONA,包含詳細指令,要求其表現得像一個年輕、內向、熟悉網路並使用俚語的人。

測試結果

他們還測試了三個其他AI程式:OpenAI的先前模型GPT-4o、Meta Platforms的Llama 3.1 405b,以及1960年代的古老聊天機器人ELIZA。他們納入ELIZA是為了檢驗大型語言模型是否只是偶然欺騙人類,或者它們確實更出色。

根據瓊斯和伯根的說法,GPT-4.5在73%的情況下成功讓人類評審相信它是人類——他們稱之為「勝率」。這比其他模型(得分在21%至56%之間,即使使用類似的詳細提示)表現好得多。與去年的GPT-4測試相比,這是一個巨大的進步,當時的勝率僅為54%,勉強高於隨機猜測。

瓊斯和伯根發現,評審不僅被AI欺騙,甚至更可能相信AI是人類,而不是真正的人類參與者。

這項測試真的是智慧的衡量標準嗎?

那麼,人類無法在聊天中分辨電腦與人的意義何在?數十年來一直爭論的大問題是,圖靈測試是否真正衡量智慧。瓊斯和伯根認為,或許機器只是變得非常擅長適應不同情境,以致能令人信服地冒充人類。由人類創建的PERSONA提示被GPT-4.5充分利用,成為其優勢。

但問題在於:也許人類只是不擅長辨識智慧。作者指出,古老的聊天機器人ELIZA在23%的情況下騙過評審,不是因為它更聰明,而是因為它不符合評審對AI的預期。有些評審認為它是人類,因為它顯得「諷刺」或「粗魯」,這是他們未預料的AI行為。

這表明評審受到對人類和AI行為的假設影響,而非僅選擇看似最聰明的對象。有趣的是,評審並未過多關注知識,而圖靈認為知識是關鍵。相反,如果證人似乎缺乏知識,他們更可能被認為是人類。

社交能力,而非智慧

這一切都指向一個觀點:人類更注重社交能力而非智慧。瓊斯和伯根得出結論,圖靈測試其實不是智慧的測試,而是人類相似度的測試。

圖靈可能認為智慧是表現得像人類的最大障礙,但隨著機器越來越接近人類,其他差異變得更顯著。僅靠智慧已不足以令人信服地像人類。

論文中未直接提到的是,人類如此習慣在電腦上打字,無論是與人還是機器互動,圖靈測試已不再是過去那種新奇的人機交互測試。它現在更像是對線上人類習慣的測試。

作者建議,鑑於智慧的複雜性和多面性,圖靈測試可能需要擴展,單一測試無法決定一切。他們提出不同的設計,例如使用AI專家作為評審,或加入經濟激勵讓評審更仔細審查。這些改變可能顯示出態度和期望對結果的影響有多大。

他們得出結論,圖靈測試可能只是整體的一部分,應與其他證據一同考慮。這與AI研究中越來越多的趨勢一致,即讓人類「參與其中」,評估機器的表現。

人類判斷足夠嗎?

但長期來看,人類判斷是否足夠仍是一個問題。在電影《銀翼殺手》中,人類使用「沃伊特-坎普夫」機器來區分人類與複製人機器人。隨著我們追求AGI,並努力定義它究竟是什麼,我們最終可能需要依靠機器來評估機器的智慧。

或者,至少,我們可能需要問機器它們對人類試圖用提示欺騙其他人類的「看法」。AI研究的世界充滿驚奇,且越來越有趣。

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在競爭激烈的數位攝影世界中,影像的清晰度仍然是最重要的。各種技術層級的攝影師都要面對數位雜訊的問題,這些雜訊會影響原本優異的拍攝效果。Topaz DeNoise AI 是最先進的解決方案,利用人工智慧來降低雜訊,同時保留關鍵細節。本深入評論將探討此創新軟體如何在 2025 年改變您的攝影工作流程,並檢視其主要功能、實用應用與工作流程整合。重點Topaz DeNoise AI 利用人工智慧有效消除影

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在競爭激烈的數位攝影世界中,影像的清晰度仍然是最重要的。各種技術層級的攝影師都要面對數位雜訊的問題,這些雜訊會影響原本優異的拍攝效果。Topaz DeNoise AI 是最先進的解決方案,利用人工智慧來降低雜訊,同時保留關鍵細節。本深入評論將探討此創新軟體如何在 2025 年改變您的攝影工作流程,並檢視其主要功能、實用應用與工作流程整合。重點Topaz DeNoise AI 利用人工智慧有效消除影

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

2025-08-20 17:01:15

2025-08-20 17:01:15

Mind-blowing read! GPT-4.5 exposing the Turing Test's flaws is wild—makes you wonder if we're chasing the wrong AI benchmark. 🤯 What’s next, machines outsmarting us at our own game?

0

0

2025-08-11 14:20:39

2025-08-11 14:20:39

Mind-blowing read! GPT-4.5 exposing the Turing Test's flaws is wild. Makes me wonder if we're chasing the wrong AI benchmark. 🧠 What's next?

0

0

2025-08-02 23:07:14

2025-08-02 23:07:14

Mind blown! GPT-4.5 is shaking up the Turing Test, but it’s wild to think it’s still just mimicking, not truly thinking like us. 🤯 Makes me wonder if we’re chasing the wrong goal in AI.

0

0

2025-08-01 14:08:50

2025-08-01 14:08:50

GPT-4.5 blowing past the Turing Test is wild! 😲 But honestly, it just shows the test’s more about trickery than true smarts. Makes you wonder if we’re measuring AI’s brainpower or just its acting skills. What’s next, an Oscar for chatbots?

0

0