O TreeQuest da Sakana AI aumenta o desempenho da IA com a colaboração de vários modelos

O laboratório japonês de IA Sakana AI revelou uma técnica que permite que vários modelos de linguagem de grande porte (LLMs) trabalhem juntos, formando uma equipe de IA altamente eficaz. Denominado Multi-LLM AB-MCTS, esse método permite que os modelos se envolvam em tentativas e erros, aproveitando seus pontos fortes exclusivos para lidar com tarefas complexas além do alcance de qualquer modelo individual.

Para as empresas, essa abordagem oferece uma maneira de criar sistemas de IA mais avançados. Em vez de depender de um único provedor ou modelo, as empresas podem aproveitar dinamicamente os pontos fortes de vários modelos de fronteira, atribuindo a melhor IA para cada segmento de tarefa a fim de obter resultados ideais.

Aproveitamento da inteligência coletiva

Os modelos de IA de fronteira estão avançando rapidamente, cada um com pontos fortes e fracos distintos com base em seus dados de treinamento e design. Um modelo pode se destacar em codificação, outro em redação criativa. A equipe da Sakana AI vê essas diferenças como ativos, não como falhas.

"Consideramos esses recursos exclusivos como ferramentas valiosas para a construção da inteligência coletiva", observam os pesquisadores em seu blog. Eles argumentam que, assim como as equipes humanas que alcançam avanços por meio da diversidade, os sistemas de IA podem realizar mais por meio da colaboração. "Combinando seus pontos fortes, os sistemas de IA podem resolver desafios que nenhum modelo isolado poderia superar."

Aprimorando o desempenho na inferência

O algoritmo do Sakana AI, uma técnica de "escalonamento em tempo de inferência" (também chamada de "escalonamento em tempo de teste"), está ganhando força na pesquisa de IA. Diferentemente do "escalonamento em tempo de treinamento", que se concentra em modelos e conjuntos de dados maiores, o escalonamento em tempo de inferência aumenta o desempenho otimizando os recursos computacionais após o treinamento.

Um método usa o aprendizado por reforço para incentivar os modelos a produzir sequências detalhadas de cadeia de raciocínio (CoT), como visto em modelos como o OpenAI o3 e o DeepSeek-R1. Outra abordagem, a amostragem repetida, solicita ao modelo várias vezes que gere diversas soluções, semelhante a um brainstorming. O método da Sakana AI refina esses conceitos.

"Nossa estrutura aprimora a amostragem Best-of-N", disse Takuya Akiba, cientista de pesquisa da Sakana AI e coautor do artigo, em uma entrevista à VentureBeat. "Ela aprimora técnicas de raciocínio como a CoT estendida por meio do aprendizado por reforço. Ao escolher estrategicamente a abordagem de pesquisa e o LLM correto, ele otimiza o desempenho em chamadas limitadas, destacando-se em tarefas complexas."

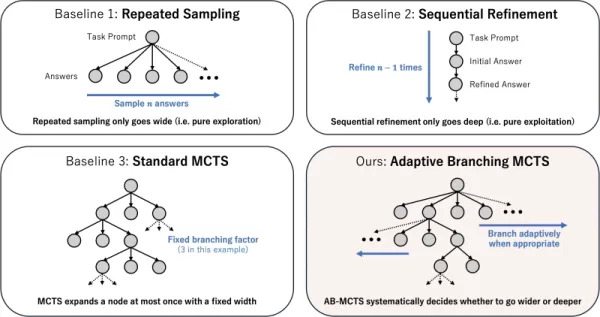

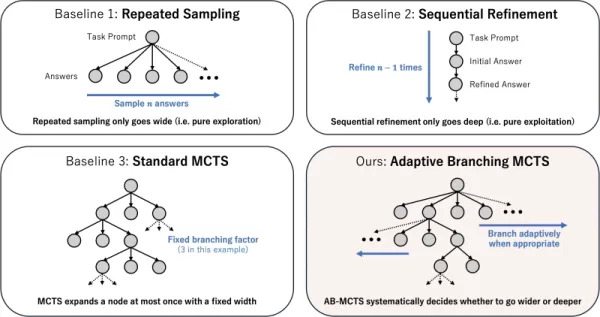

Como funciona a Adaptive Branching Search

O núcleo da técnica é o algoritmo AB-MCTS (Adaptive Branching Monte Carlo Tree Search). Ele permite que os LLMs realizem uma tentativa e erro inteligente, equilibrando a "busca mais profunda" (refinando uma solução promissora) e a "busca mais ampla" (gerando novas soluções). O AB-MCTS combina essas estratégias, permitindo que o sistema refine ideias ou passe para novas ideias quando necessário.

Isso é feito com o Monte Carlo Tree Search (MCTS), um algoritmo de tomada de decisão usado no AlphaGo da DeepMind. O AB-MCTS emprega modelos de probabilidade para decidir se deve refinar ou reiniciar em cada etapa.

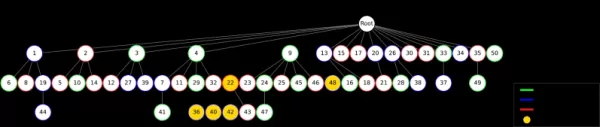

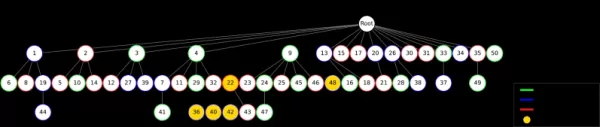

Diferentes estratégias de escalonamento de tempo de teste Fonte: Sakana AI Multi-LLM O AB-MCTS vai além, decidindo não apenas "o que" fazer (refinar ou gerar), mas também "qual" LLM usar. Inicialmente, sem saber qual é o melhor modelo para uma tarefa, o sistema testa uma combinação de LLMs, aprendendo com o tempo quais têm melhor desempenho e atribuindo-lhes mais trabalho.

Testando a equipe de IA

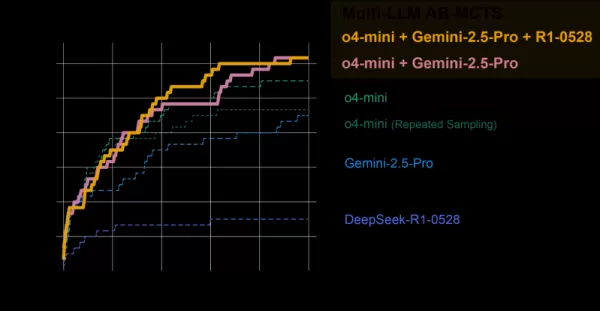

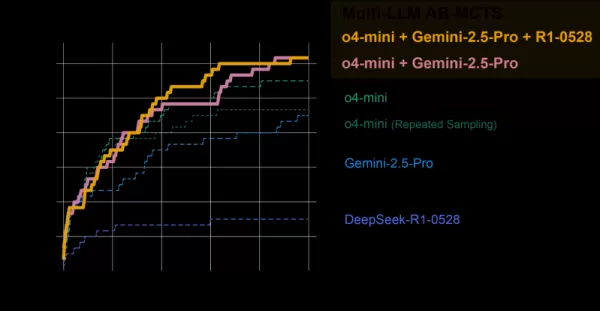

O sistema Multi-LLM AB-MCTS foi avaliado no benchmark ARC-AGI-2, que testa o raciocínio visual semelhante ao humano em problemas novos, um desafio difícil para a IA.

A equipe combinou modelos de ponta como o4-mini, Gemini 2.5 Pro e DeepSeek-R1.

O modelo coletivo resolveu mais de 30% dos 120 problemas de teste, superando em muito o desempenho de qualquer modelo individual. O sistema atribuiu dinamicamente o melhor modelo para cada tarefa, identificando rapidamente o LLM mais eficaz quando havia um caminho claro para a solução.

AB-MCTS vs. modelos individuais Fonte: Sakana AI Notavelmente, o sistema resolveu problemas que antes não podiam ser resolvidos por nenhum modelo individual. Em um exemplo, uma solução incorreta do o4-mini foi refinada pelo DeepSeek-R1 e pelo Gemini-2.5 Pro, que corrigiu o erro e forneceu a resposta correta.

"Isso mostra que o Multi-LLM AB-MCTS pode combinar modelos de fronteira para enfrentar desafios anteriormente insolúveis, expandindo os limites da inteligência coletiva de IA", afirmam os pesquisadores.

O AB-MTCS pode selecionar diferentes modelos em diferentes estágios da solução de um problema Fonte: Sakana AI "Os pontos fortes e as tendências de alucinação de cada modelo variam", observou Akiba. "Ao combinar modelos com menores riscos de alucinação, podemos obter raciocínio poderoso e confiabilidade, abordando uma importante preocupação comercial."

Da pesquisa ao uso prático

A Sakana AI lançou o TreeQuest, uma estrutura de código aberto sob a licença Apache 2.0, que permite que desenvolvedores e empresas implementem o Multi-LLM AB-MCTS. Sua API flexível suporta pontuação e lógica personalizadas para diversas tarefas.

"Ainda estamos explorando o AB-MCTS para desafios comerciais específicos, mas seu potencial é claro", disse Akiba.

Além do benchmark ARC-AGI-2, o AB-MCTS foi bem-sucedido em tarefas como codificação complexa e aprimoramento da precisão do modelo de aprendizado de máquina.

"O AB-MCTS se destaca em tarefas iterativas de tentativa e erro, como a otimização de métricas de desempenho de software", acrescentou Akiba. "Por exemplo, ele pode reduzir automaticamente a latência de resposta do serviço da Web."

Essa ferramenta de código aberto pode possibilitar uma nova geração de aplicativos de IA corporativos robustos e confiáveis.

Artigo relacionado

Microsoft reduz equipe apesar do forte desempenho financeiro

Microsoft anuncia realinhamento estratégico da força de trabalhoA Microsoft iniciou reduções de pessoal que afetam aproximadamente 7.000 funcionários, representando 3% do seu quadro global. É importante notar que essas mudanças refletem prioridades e

Microsoft reduz equipe apesar do forte desempenho financeiro

Microsoft anuncia realinhamento estratégico da força de trabalhoA Microsoft iniciou reduções de pessoal que afetam aproximadamente 7.000 funcionários, representando 3% do seu quadro global. É importante notar que essas mudanças refletem prioridades e

MIT revela estrutura de IA de autoaprendizagem que vai além dos modelos estáticos

Pesquisadores do MIT são pioneiros na estrutura de IA de autoaprendizagemUma equipe do MIT desenvolveu um sistema inovador chamado SEAL (Self-Adapting Language Models) que permite que grandes modelos

MIT revela estrutura de IA de autoaprendizagem que vai além dos modelos estáticos

Pesquisadores do MIT são pioneiros na estrutura de IA de autoaprendizagemUma equipe do MIT desenvolveu um sistema inovador chamado SEAL (Self-Adapting Language Models) que permite que grandes modelos

Multiverse AI lança modelos inovadores de alto desempenho em miniatura

Uma startup europeia pioneira em IA revelou modelos inovadores de IA de tamanho micro, batizados com nomes de cérebros de aves e insetos, demonstrando que a inteligência artificial avançada não exige

Comentários (0)

0/200

Multiverse AI lança modelos inovadores de alto desempenho em miniatura

Uma startup europeia pioneira em IA revelou modelos inovadores de IA de tamanho micro, batizados com nomes de cérebros de aves e insetos, demonstrando que a inteligência artificial avançada não exige

Comentários (0)

0/200

O laboratório japonês de IA Sakana AI revelou uma técnica que permite que vários modelos de linguagem de grande porte (LLMs) trabalhem juntos, formando uma equipe de IA altamente eficaz. Denominado Multi-LLM AB-MCTS, esse método permite que os modelos se envolvam em tentativas e erros, aproveitando seus pontos fortes exclusivos para lidar com tarefas complexas além do alcance de qualquer modelo individual.

Para as empresas, essa abordagem oferece uma maneira de criar sistemas de IA mais avançados. Em vez de depender de um único provedor ou modelo, as empresas podem aproveitar dinamicamente os pontos fortes de vários modelos de fronteira, atribuindo a melhor IA para cada segmento de tarefa a fim de obter resultados ideais.

Aproveitamento da inteligência coletiva

Os modelos de IA de fronteira estão avançando rapidamente, cada um com pontos fortes e fracos distintos com base em seus dados de treinamento e design. Um modelo pode se destacar em codificação, outro em redação criativa. A equipe da Sakana AI vê essas diferenças como ativos, não como falhas.

"Consideramos esses recursos exclusivos como ferramentas valiosas para a construção da inteligência coletiva", observam os pesquisadores em seu blog. Eles argumentam que, assim como as equipes humanas que alcançam avanços por meio da diversidade, os sistemas de IA podem realizar mais por meio da colaboração. "Combinando seus pontos fortes, os sistemas de IA podem resolver desafios que nenhum modelo isolado poderia superar."

Aprimorando o desempenho na inferência

O algoritmo do Sakana AI, uma técnica de "escalonamento em tempo de inferência" (também chamada de "escalonamento em tempo de teste"), está ganhando força na pesquisa de IA. Diferentemente do "escalonamento em tempo de treinamento", que se concentra em modelos e conjuntos de dados maiores, o escalonamento em tempo de inferência aumenta o desempenho otimizando os recursos computacionais após o treinamento.

Um método usa o aprendizado por reforço para incentivar os modelos a produzir sequências detalhadas de cadeia de raciocínio (CoT), como visto em modelos como o OpenAI o3 e o DeepSeek-R1. Outra abordagem, a amostragem repetida, solicita ao modelo várias vezes que gere diversas soluções, semelhante a um brainstorming. O método da Sakana AI refina esses conceitos.

"Nossa estrutura aprimora a amostragem Best-of-N", disse Takuya Akiba, cientista de pesquisa da Sakana AI e coautor do artigo, em uma entrevista à VentureBeat. "Ela aprimora técnicas de raciocínio como a CoT estendida por meio do aprendizado por reforço. Ao escolher estrategicamente a abordagem de pesquisa e o LLM correto, ele otimiza o desempenho em chamadas limitadas, destacando-se em tarefas complexas."

Como funciona a Adaptive Branching Search

O núcleo da técnica é o algoritmo AB-MCTS (Adaptive Branching Monte Carlo Tree Search). Ele permite que os LLMs realizem uma tentativa e erro inteligente, equilibrando a "busca mais profunda" (refinando uma solução promissora) e a "busca mais ampla" (gerando novas soluções). O AB-MCTS combina essas estratégias, permitindo que o sistema refine ideias ou passe para novas ideias quando necessário.

Isso é feito com o Monte Carlo Tree Search (MCTS), um algoritmo de tomada de decisão usado no AlphaGo da DeepMind. O AB-MCTS emprega modelos de probabilidade para decidir se deve refinar ou reiniciar em cada etapa.

Multi-LLM O AB-MCTS vai além, decidindo não apenas "o que" fazer (refinar ou gerar), mas também "qual" LLM usar. Inicialmente, sem saber qual é o melhor modelo para uma tarefa, o sistema testa uma combinação de LLMs, aprendendo com o tempo quais têm melhor desempenho e atribuindo-lhes mais trabalho.

Testando a equipe de IA

O sistema Multi-LLM AB-MCTS foi avaliado no benchmark ARC-AGI-2, que testa o raciocínio visual semelhante ao humano em problemas novos, um desafio difícil para a IA.

A equipe combinou modelos de ponta como o4-mini, Gemini 2.5 Pro e DeepSeek-R1.

O modelo coletivo resolveu mais de 30% dos 120 problemas de teste, superando em muito o desempenho de qualquer modelo individual. O sistema atribuiu dinamicamente o melhor modelo para cada tarefa, identificando rapidamente o LLM mais eficaz quando havia um caminho claro para a solução.

Notavelmente, o sistema resolveu problemas que antes não podiam ser resolvidos por nenhum modelo individual. Em um exemplo, uma solução incorreta do o4-mini foi refinada pelo DeepSeek-R1 e pelo Gemini-2.5 Pro, que corrigiu o erro e forneceu a resposta correta.

"Isso mostra que o Multi-LLM AB-MCTS pode combinar modelos de fronteira para enfrentar desafios anteriormente insolúveis, expandindo os limites da inteligência coletiva de IA", afirmam os pesquisadores.

"Os pontos fortes e as tendências de alucinação de cada modelo variam", observou Akiba. "Ao combinar modelos com menores riscos de alucinação, podemos obter raciocínio poderoso e confiabilidade, abordando uma importante preocupação comercial."

Da pesquisa ao uso prático

A Sakana AI lançou o TreeQuest, uma estrutura de código aberto sob a licença Apache 2.0, que permite que desenvolvedores e empresas implementem o Multi-LLM AB-MCTS. Sua API flexível suporta pontuação e lógica personalizadas para diversas tarefas.

"Ainda estamos explorando o AB-MCTS para desafios comerciais específicos, mas seu potencial é claro", disse Akiba.

Além do benchmark ARC-AGI-2, o AB-MCTS foi bem-sucedido em tarefas como codificação complexa e aprimoramento da precisão do modelo de aprendizado de máquina.

"O AB-MCTS se destaca em tarefas iterativas de tentativa e erro, como a otimização de métricas de desempenho de software", acrescentou Akiba. "Por exemplo, ele pode reduzir automaticamente a latência de resposta do serviço da Web."

Essa ferramenta de código aberto pode possibilitar uma nova geração de aplicativos de IA corporativos robustos e confiáveis.

MIT revela estrutura de IA de autoaprendizagem que vai além dos modelos estáticos

Pesquisadores do MIT são pioneiros na estrutura de IA de autoaprendizagemUma equipe do MIT desenvolveu um sistema inovador chamado SEAL (Self-Adapting Language Models) que permite que grandes modelos

MIT revela estrutura de IA de autoaprendizagem que vai além dos modelos estáticos

Pesquisadores do MIT são pioneiros na estrutura de IA de autoaprendizagemUma equipe do MIT desenvolveu um sistema inovador chamado SEAL (Self-Adapting Language Models) que permite que grandes modelos

Multiverse AI lança modelos inovadores de alto desempenho em miniatura

Uma startup europeia pioneira em IA revelou modelos inovadores de IA de tamanho micro, batizados com nomes de cérebros de aves e insetos, demonstrando que a inteligência artificial avançada não exige

Multiverse AI lança modelos inovadores de alto desempenho em miniatura

Uma startup europeia pioneira em IA revelou modelos inovadores de IA de tamanho micro, batizados com nomes de cérebros de aves e insetos, demonstrando que a inteligência artificial avançada não exige