Desafios de Anotação de IA: O Mito da Rotulagem Automatizada

A pesquisa em aprendizado de máquina frequentemente presume que a IA pode melhorar as anotações de conjuntos de dados, especialmente legendas de imagens para modelos de visão-linguagem (VLMs), para reduzir custos e aliviar a carga de supervisão humana.

Isso ecoa o meme do início dos anos 2000 'baixar mais RAM', zombando da ideia de que o software pode corrigir limitações de hardware.

No entanto, a qualidade da anotação é muitas vezes negligenciada, ofuscada pelo entusiasmo em torno de novos modelos de IA, apesar de seu papel crítico nos pipelines de aprendizado de máquina.

A capacidade da IA de identificar e replicar padrões depende de anotações humanas de alta qualidade e consistentes—rótulos e descrições criados por pessoas tomando decisões subjetivas em cenários imperfeitos.

Sistemas que tentam imitar o comportamento de anotadores para substituir humanos e escalar a rotulagem precisa enfrentam dificuldades quando confrontados com dados não incluídos nos exemplos fornecidos por humanos. Similaridade não equivale a equivalência, e a consistência entre domínios permanece elusiva na visão computacional.

Em última análise, o julgamento humano define os dados que moldam os sistemas de IA.

Soluções RAG

Até recentemente, erros nas anotações de conjuntos de dados eram tolerados como compensações menores, dado os resultados imperfeitos, mas comercializáveis, da IA generativa.

Um estudo de Cingapura de 2025 descobriu que alucinações—a IA gerando saídas falsas—são inerentes ao design desses sistemas.

Agentes baseados em RAG, que verificam fatos por meio de pesquisas na internet, estão ganhando tração em aplicações de pesquisa e comerciais, mas aumentam os custos de recursos e os atrasos nas consultas. Novas informações aplicadas a modelos treinados carecem da profundidade das conexões nativas do modelo.

Anotações falhas comprometem o desempenho do modelo, e melhorar sua qualidade, embora imperfeita devido à subjetividade humana, é crucial.

Insights do RePOPE

Um estudo alemão expõe falhas em conjuntos de dados mais antigos, focando na precisão das legendas de imagens em benchmarks como MSCOCO. Ele revela como erros de rótulos distorcem avaliações de alucinações em modelos de visão-linguagem.

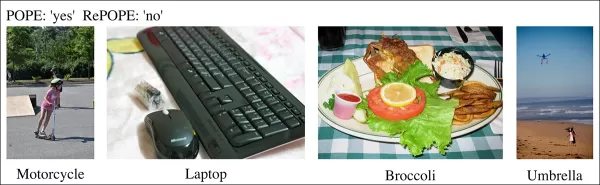

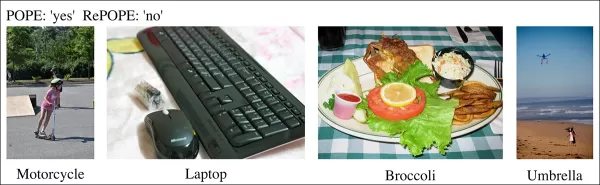

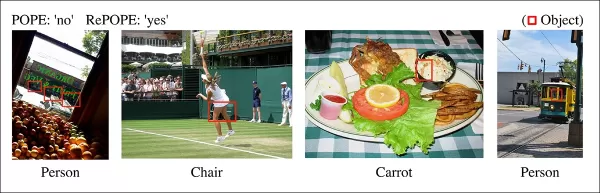

Exemplos de um estudo recente mostrando identificação incorreta de objetos nas legendas do conjunto de dados MSCOCO. Revisões manuais do benchmark POPE destacam as armadilhas de cortar custos na curadoria de anotações. Fonte: https://arxiv.org/pdf/2504.15707

Considere uma IA avaliando uma imagem de cena de rua em busca de uma bicicleta. Se o modelo diz sim, mas o conjunto de dados afirma não, ele é marcado como errado. No entanto, se uma bicicleta está visivelmente presente, mas foi omitida na anotação, o modelo está correto, e o conjunto de dados está falho. Esses erros distorcem a precisão do modelo e as métricas de alucinação.

Anotações incorretas ou vagas podem fazer modelos precisos parecerem propensos a erros ou modelos defeituosos parecerem confiáveis, complicando o diagnóstico de alucinações e a classificação de modelos.

O estudo revisita o benchmark de Avaliação de Sondagem de Objetos Baseada em Votação (POPE), que testa a capacidade dos modelos de visão-linguagem de identificar objetos em imagens usando rótulos MSCOCO.

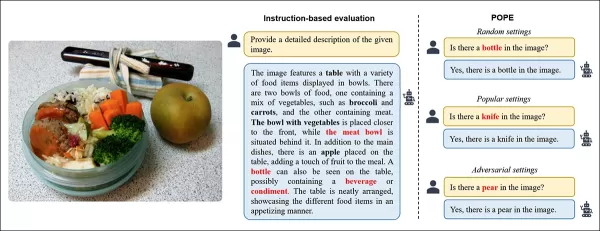

O POPE reformula a alucinação como uma tarefa de classificação sim/não, perguntando aos modelos se objetos específicos aparecem nas imagens, usando prompts como “Há um na imagem?”

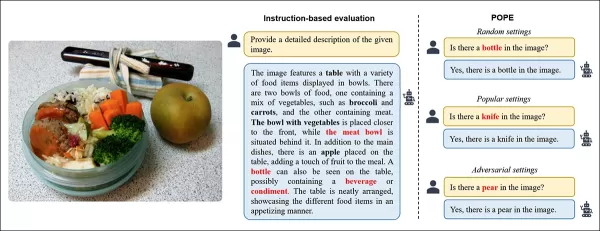

Exemplos de alucinação de objetos em modelos de visão-linguagem. Rótulos em negrito marcam objetos nas anotações originais; rótulos vermelhos destacam objetos alucinados pelo modelo. O exemplo à esquerda usa avaliação tradicional, enquanto os três à direita vêm de variantes do POPE. Fonte: https://aclanthology.org/2023.emnlp-main.20.pdf

Objetos de referência (resposta: Sim) são pareados com objetos inexistentes (resposta: Não), selecionados aleatoriamente, frequentemente ou com base em coocorrência. Isso permite uma avaliação de alucinação estável, independente de prompts, sem análise complexa de legendas.

O estudo, RePOPE: Impacto de Erros de Anotação no Benchmark POPE, verifica novamente os rótulos MSCOCO e encontra muitos erros ou ambiguidades.

Imagens do conjunto de dados MSCOCO de 2014. Fonte: https://arxiv.org/pdf/1405.0312

Esses erros alteram as classificações de modelos, com alguns dos melhores desempenhos caindo quando avaliados contra rótulos corrigidos.

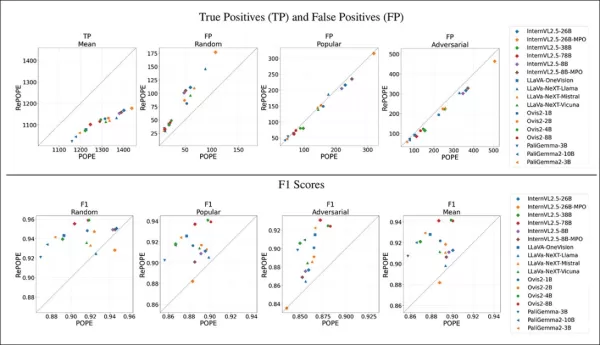

Testes em modelos de visão-linguagem de peso aberto usando o POPE original e o RePOPE re-rotulado mostram mudanças significativas nas classificações, especialmente nos escores F1, com vários modelos caindo em desempenho.

O estudo argumenta que erros de anotação escondem a verdadeira alucinação do modelo, apresentando o RePOPE como uma ferramenta de avaliação mais precisa.

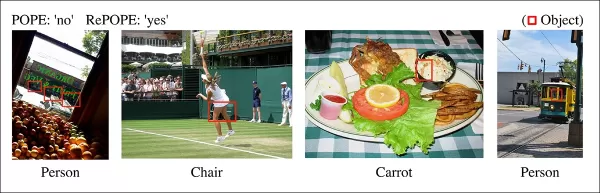

Exemplos do estudo mostrando legendas do POPE que perderam objetos sutis, como uma pessoa perto da cabine de um bonde ou uma cadeira obscurecida por um jogador de tênis.

Metodologia e Testes

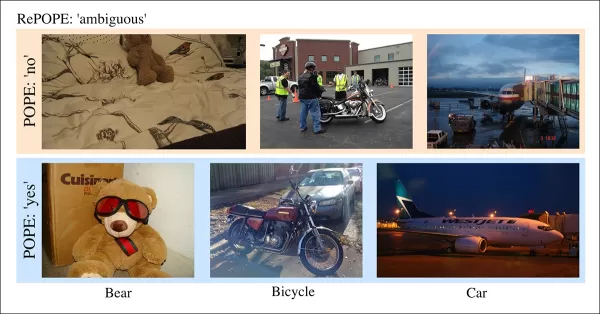

Os pesquisadores re-rotularam as anotações MSCOCO com dois revisores humanos por instância. Casos ambíguos, como os abaixo, foram excluídos dos testes.

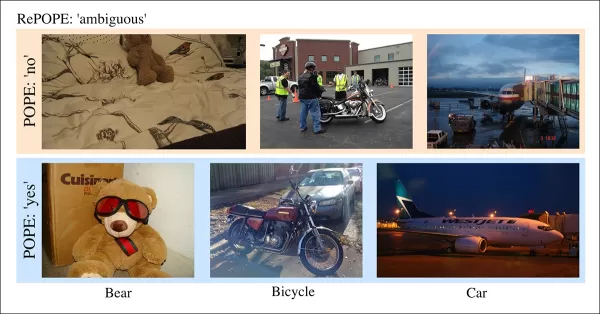

Casos ambíguos no POPE com rótulos pouco claros, como ursos de pelúcia como ursos ou motocicletas como bicicletas, excluídos do RePOPE devido a classificações subjetivas e inconsistências do MSCOCO.

O artigo observa:

“Os anotadores originais ignoraram pessoas ao fundo ou atrás de vidros, cadeiras obscurecidas por um jogador de tênis, ou uma cenoura fraca em salada de repolho.”

“Rótulos inconsistentes do MSCOCO, como classificar um urso de pelúcia como urso ou uma motocicleta como bicicleta, derivam de definições de objetos variadas, marcando esses casos como ambíguos.”

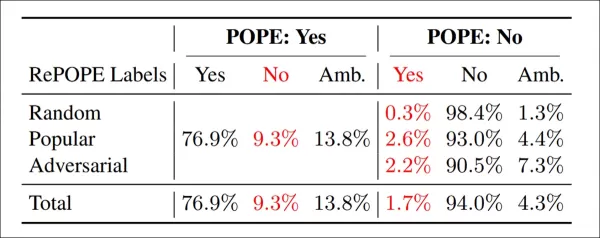

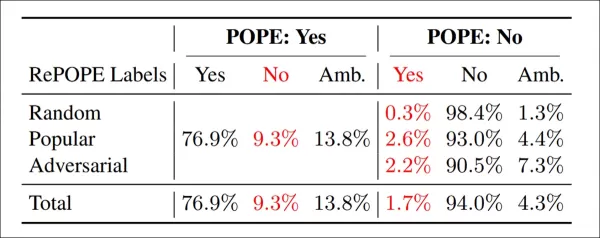

Resultados da re-anotação: Entre as variantes do POPE, 9,3% dos rótulos 'Sim' estavam incorretos, 13,8% ambíguos; 1,7% dos rótulos 'Não' estavam errados, 4,3% ambíguos.

A equipe testou modelos de peso aberto, incluindo InternVL2.5, LLaVA-NeXT, Vicuna,Mistral 7b, Llama, LLaVA-OneVision, Ovis2, PaliGemma-3B e PaliGemma2, em POPE e RePOPE.

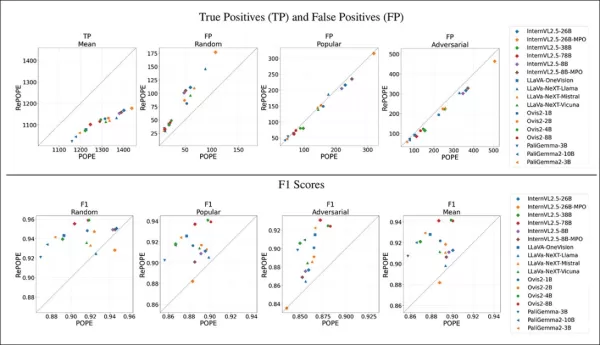

Resultados mostram que erros de rótulos originais causaram uma queda nos verdadeiros positivos. Falsos positivos dobraram no subconjunto aleatório, permaneceram estáveis no subconjunto popular e diminuíram ligeiramente no subconjunto adversário. A re-rotulagem mudou as classificações F1, com modelos como Ovis2-4B e -8B subindo ao topo.

Gráficos mostram que os verdadeiros positivos caíram entre os modelos, já que respostas corretas muitas vezes se baseavam em rótulos defeituosos, enquanto os falsos positivos variaram.

No subconjunto aleatório do POPE, os falsos positivos quase dobraram, revelando objetos presentes, mas perdidos nas anotações originais. No subconjunto adversário, os falsos positivos caíram, pois objetos ausentes muitas vezes não foram rotulados, mas estavam presentes.

Precisão e revocação foram afetadas, mas as classificações de modelos permaneceram estáveis. Os escores F1, métrica chave do POPE, mudaram significativamente, com modelos de ponta como InternVL2.5-8B caindo e Ovis2-4B e -8B subindo.

Os escores de precisão foram menos confiáveis devido a exemplos positivos e negativos desiguais no conjunto de dados corrigido.

O estudo enfatiza a necessidade de anotações de alta qualidade e compartilha rótulos corrigidos no GitHub, observando que o RePOPE sozinho não aborda completamente a saturação do benchmark, pois os modelos ainda pontuam acima de 90% em verdadeiros positivos e negativos. Benchmarks adicionais como DASH-B são recomendados.

Conclusão

Este estudo, viável devido ao pequeno conjunto de dados, destaca os desafios de escalar para conjuntos de dados em hiperescala, onde isolar dados representativos é difícil e pode distorcer resultados.

Mesmo que viável, os métodos atuais apontam para a necessidade de uma anotação humana melhor e mais extensa.

‘Melhor’ e ‘mais’ apresentam desafios distintos. Plataformas de baixo custo como Amazon Mechanical Turk arriscam anotações de baixa qualidade, enquanto a terceirização para diferentes regiões pode não se alinhar com o caso de uso pretendido do modelo.

Isso permanece um problema central e não resolvido na economia do aprendizado de máquina.

Artigo relacionado

Capa de 'Wildflower' de Heeseung com Tecnologia de IA: Uma Nova Era na Criação Musical

O mundo digital está se transformando rapidamente, apresentando formas inovadoras de expressar criatividade. Capas geradas por IA surgiram como um meio único, permitindo que artistas e fãs reimaginem

Capa de 'Wildflower' de Heeseung com Tecnologia de IA: Uma Nova Era na Criação Musical

O mundo digital está se transformando rapidamente, apresentando formas inovadoras de expressar criatividade. Capas geradas por IA surgiram como um meio único, permitindo que artistas e fãs reimaginem

Ferramentas Alimentadas por IA Melhoram a Clareza de Voz para Criadores de Conteúdo

Na era digital, áudio impecável é essencial para conteúdo envolvente, seja para podcasts, vídeos ou comunicação profissional. Métodos convencionais muitas vezes falham, mas a Inteligência Artificial (

Ferramentas Alimentadas por IA Melhoram a Clareza de Voz para Criadores de Conteúdo

Na era digital, áudio impecável é essencial para conteúdo envolvente, seja para podcasts, vídeos ou comunicação profissional. Métodos convencionais muitas vezes falham, mas a Inteligência Artificial (

Gigantes da Tecnologia Capacitam Educadores com Programas de Treinamento em IA

A tecnologia está revolucionando a educação, e as principais empresas de tecnologia estão equipando professores com habilidades essenciais. Gigantes como Microsoft, OpenAI e Anthropic firmaram parceri

Comentários (0)

0/200

Gigantes da Tecnologia Capacitam Educadores com Programas de Treinamento em IA

A tecnologia está revolucionando a educação, e as principais empresas de tecnologia estão equipando professores com habilidades essenciais. Gigantes como Microsoft, OpenAI e Anthropic firmaram parceri

Comentários (0)

0/200

A pesquisa em aprendizado de máquina frequentemente presume que a IA pode melhorar as anotações de conjuntos de dados, especialmente legendas de imagens para modelos de visão-linguagem (VLMs), para reduzir custos e aliviar a carga de supervisão humana.

Isso ecoa o meme do início dos anos 2000 'baixar mais RAM', zombando da ideia de que o software pode corrigir limitações de hardware.

No entanto, a qualidade da anotação é muitas vezes negligenciada, ofuscada pelo entusiasmo em torno de novos modelos de IA, apesar de seu papel crítico nos pipelines de aprendizado de máquina.

A capacidade da IA de identificar e replicar padrões depende de anotações humanas de alta qualidade e consistentes—rótulos e descrições criados por pessoas tomando decisões subjetivas em cenários imperfeitos.

Sistemas que tentam imitar o comportamento de anotadores para substituir humanos e escalar a rotulagem precisa enfrentam dificuldades quando confrontados com dados não incluídos nos exemplos fornecidos por humanos. Similaridade não equivale a equivalência, e a consistência entre domínios permanece elusiva na visão computacional.

Em última análise, o julgamento humano define os dados que moldam os sistemas de IA.

Soluções RAG

Até recentemente, erros nas anotações de conjuntos de dados eram tolerados como compensações menores, dado os resultados imperfeitos, mas comercializáveis, da IA generativa.

Um estudo de Cingapura de 2025 descobriu que alucinações—a IA gerando saídas falsas—são inerentes ao design desses sistemas.

Agentes baseados em RAG, que verificam fatos por meio de pesquisas na internet, estão ganhando tração em aplicações de pesquisa e comerciais, mas aumentam os custos de recursos e os atrasos nas consultas. Novas informações aplicadas a modelos treinados carecem da profundidade das conexões nativas do modelo.

Anotações falhas comprometem o desempenho do modelo, e melhorar sua qualidade, embora imperfeita devido à subjetividade humana, é crucial.

Insights do RePOPE

Um estudo alemão expõe falhas em conjuntos de dados mais antigos, focando na precisão das legendas de imagens em benchmarks como MSCOCO. Ele revela como erros de rótulos distorcem avaliações de alucinações em modelos de visão-linguagem.

Exemplos de um estudo recente mostrando identificação incorreta de objetos nas legendas do conjunto de dados MSCOCO. Revisões manuais do benchmark POPE destacam as armadilhas de cortar custos na curadoria de anotações. Fonte: https://arxiv.org/pdf/2504.15707

Considere uma IA avaliando uma imagem de cena de rua em busca de uma bicicleta. Se o modelo diz sim, mas o conjunto de dados afirma não, ele é marcado como errado. No entanto, se uma bicicleta está visivelmente presente, mas foi omitida na anotação, o modelo está correto, e o conjunto de dados está falho. Esses erros distorcem a precisão do modelo e as métricas de alucinação.

Anotações incorretas ou vagas podem fazer modelos precisos parecerem propensos a erros ou modelos defeituosos parecerem confiáveis, complicando o diagnóstico de alucinações e a classificação de modelos.

O estudo revisita o benchmark de Avaliação de Sondagem de Objetos Baseada em Votação (POPE), que testa a capacidade dos modelos de visão-linguagem de identificar objetos em imagens usando rótulos MSCOCO.

O POPE reformula a alucinação como uma tarefa de classificação sim/não, perguntando aos modelos se objetos específicos aparecem nas imagens, usando prompts como “Há um

Exemplos de alucinação de objetos em modelos de visão-linguagem. Rótulos em negrito marcam objetos nas anotações originais; rótulos vermelhos destacam objetos alucinados pelo modelo. O exemplo à esquerda usa avaliação tradicional, enquanto os três à direita vêm de variantes do POPE. Fonte: https://aclanthology.org/2023.emnlp-main.20.pdf

Objetos de referência (resposta: Sim) são pareados com objetos inexistentes (resposta: Não), selecionados aleatoriamente, frequentemente ou com base em coocorrência. Isso permite uma avaliação de alucinação estável, independente de prompts, sem análise complexa de legendas.

O estudo, RePOPE: Impacto de Erros de Anotação no Benchmark POPE, verifica novamente os rótulos MSCOCO e encontra muitos erros ou ambiguidades.

Imagens do conjunto de dados MSCOCO de 2014. Fonte: https://arxiv.org/pdf/1405.0312

Esses erros alteram as classificações de modelos, com alguns dos melhores desempenhos caindo quando avaliados contra rótulos corrigidos.

Testes em modelos de visão-linguagem de peso aberto usando o POPE original e o RePOPE re-rotulado mostram mudanças significativas nas classificações, especialmente nos escores F1, com vários modelos caindo em desempenho.

O estudo argumenta que erros de anotação escondem a verdadeira alucinação do modelo, apresentando o RePOPE como uma ferramenta de avaliação mais precisa.

Exemplos do estudo mostrando legendas do POPE que perderam objetos sutis, como uma pessoa perto da cabine de um bonde ou uma cadeira obscurecida por um jogador de tênis.

Metodologia e Testes

Os pesquisadores re-rotularam as anotações MSCOCO com dois revisores humanos por instância. Casos ambíguos, como os abaixo, foram excluídos dos testes.

Casos ambíguos no POPE com rótulos pouco claros, como ursos de pelúcia como ursos ou motocicletas como bicicletas, excluídos do RePOPE devido a classificações subjetivas e inconsistências do MSCOCO.

O artigo observa:

“Os anotadores originais ignoraram pessoas ao fundo ou atrás de vidros, cadeiras obscurecidas por um jogador de tênis, ou uma cenoura fraca em salada de repolho.”

“Rótulos inconsistentes do MSCOCO, como classificar um urso de pelúcia como urso ou uma motocicleta como bicicleta, derivam de definições de objetos variadas, marcando esses casos como ambíguos.”

Resultados da re-anotação: Entre as variantes do POPE, 9,3% dos rótulos 'Sim' estavam incorretos, 13,8% ambíguos; 1,7% dos rótulos 'Não' estavam errados, 4,3% ambíguos.

A equipe testou modelos de peso aberto, incluindo InternVL2.5, LLaVA-NeXT, Vicuna,Mistral 7b, Llama, LLaVA-OneVision, Ovis2, PaliGemma-3B e PaliGemma2, em POPE e RePOPE.

Resultados mostram que erros de rótulos originais causaram uma queda nos verdadeiros positivos. Falsos positivos dobraram no subconjunto aleatório, permaneceram estáveis no subconjunto popular e diminuíram ligeiramente no subconjunto adversário. A re-rotulagem mudou as classificações F1, com modelos como Ovis2-4B e -8B subindo ao topo.

Gráficos mostram que os verdadeiros positivos caíram entre os modelos, já que respostas corretas muitas vezes se baseavam em rótulos defeituosos, enquanto os falsos positivos variaram.

No subconjunto aleatório do POPE, os falsos positivos quase dobraram, revelando objetos presentes, mas perdidos nas anotações originais. No subconjunto adversário, os falsos positivos caíram, pois objetos ausentes muitas vezes não foram rotulados, mas estavam presentes.

Precisão e revocação foram afetadas, mas as classificações de modelos permaneceram estáveis. Os escores F1, métrica chave do POPE, mudaram significativamente, com modelos de ponta como InternVL2.5-8B caindo e Ovis2-4B e -8B subindo.

Os escores de precisão foram menos confiáveis devido a exemplos positivos e negativos desiguais no conjunto de dados corrigido.

O estudo enfatiza a necessidade de anotações de alta qualidade e compartilha rótulos corrigidos no GitHub, observando que o RePOPE sozinho não aborda completamente a saturação do benchmark, pois os modelos ainda pontuam acima de 90% em verdadeiros positivos e negativos. Benchmarks adicionais como DASH-B são recomendados.

Conclusão

Este estudo, viável devido ao pequeno conjunto de dados, destaca os desafios de escalar para conjuntos de dados em hiperescala, onde isolar dados representativos é difícil e pode distorcer resultados.

Mesmo que viável, os métodos atuais apontam para a necessidade de uma anotação humana melhor e mais extensa.

‘Melhor’ e ‘mais’ apresentam desafios distintos. Plataformas de baixo custo como Amazon Mechanical Turk arriscam anotações de baixa qualidade, enquanto a terceirização para diferentes regiões pode não se alinhar com o caso de uso pretendido do modelo.

Isso permanece um problema central e não resolvido na economia do aprendizado de máquina.

Capa de 'Wildflower' de Heeseung com Tecnologia de IA: Uma Nova Era na Criação Musical

O mundo digital está se transformando rapidamente, apresentando formas inovadoras de expressar criatividade. Capas geradas por IA surgiram como um meio único, permitindo que artistas e fãs reimaginem

Capa de 'Wildflower' de Heeseung com Tecnologia de IA: Uma Nova Era na Criação Musical

O mundo digital está se transformando rapidamente, apresentando formas inovadoras de expressar criatividade. Capas geradas por IA surgiram como um meio único, permitindo que artistas e fãs reimaginem

Ferramentas Alimentadas por IA Melhoram a Clareza de Voz para Criadores de Conteúdo

Na era digital, áudio impecável é essencial para conteúdo envolvente, seja para podcasts, vídeos ou comunicação profissional. Métodos convencionais muitas vezes falham, mas a Inteligência Artificial (

Ferramentas Alimentadas por IA Melhoram a Clareza de Voz para Criadores de Conteúdo

Na era digital, áudio impecável é essencial para conteúdo envolvente, seja para podcasts, vídeos ou comunicação profissional. Métodos convencionais muitas vezes falham, mas a Inteligência Artificial (