AIアノテーションの課題:自動ラベリングの神話

機械学習研究では、AIがデータセットのアノテーション、特に視覚言語モデル(VLM)の画像キャプションを強化し、コスト削減や人間の監督負担軽減が可能とされることが多い。

これは2000年代初頭の「RAMを増やす」ミームを彷彿とさせ、ソフトウェアがハードウェアの限界を解決できるという考えを嘲笑する。

しかし、アノテーションの品質は、機械学習パイプラインで重要な役割を果たすにもかかわらず、新しいAIモデルの話題性に埋もれて見過ごされることが多い。

AIがパターンを識別し再現する能力は、高品質で一貫性のある人間のアノテーション(ラベルや説明)に依存し、それは不完全な環境で主観的な判断を行う人々によって作成される。

人間の行動を模倣して正確なラベリングをスケールアップしようとするシステムは、人間が提供した例に含まれないデータに直面すると苦戦する。類似性は同等性を意味せず、コンピュータビジョンでのクロスドメインの一貫性は依然として困難である。

最終的に、AIシステムを形成するデータは人間の判断によって定義される。

RAGソリューション

最近まで、データセットのアノテーションエラーは、生成AIの不完全だが市場性のある出力に対して、許容可能な小さなトレードオフとして扱われてきた。

2025年のシンガポール研究では、幻覚(AIが誤った出力を生成すること)がこれらのシステムの設計に内在していることがわかった。

インターネット検索を通じて事実を検証するRAGベースのエージェントは、研究や商用アプリケーションで注目を集めているが、リソースコストやクエリ遅延が増加する。訓練済みモデルに適用される新しい情報は、ネイティブモデルの接続の深さに欠ける。

欠陥のあるアノテーションはモデルの性能を損ない、その品質を改善することは、人間の主観性により不完全ではあるが、極めて重要である。

RePOPEの洞察

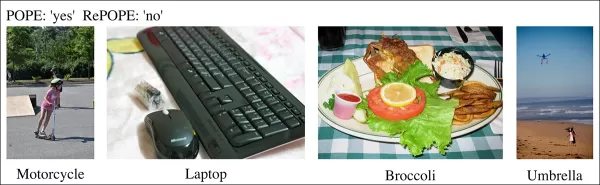

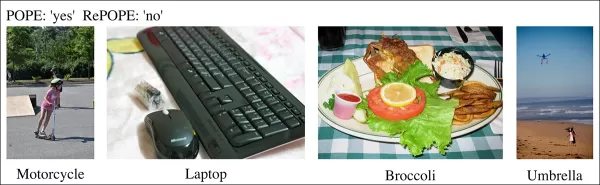

ドイツの研究では、古いデータセットの欠陥、特にMSCOCOのようなベンチマークでの画像キャプションの正確性に焦点を当て、ラベルエラーが視覚言語モデルの幻覚評価を歪めることを明らかにした。

https://arxiv.org/pdf/2504.15707" aria-label="https://arxiv.org/pdf/2504.15707">https://arxiv.org/pdf/2504.15707

自転車を評価するAIが街のシーン画像を分析し、モデルが「はい」と答えたがデータセットが「いいえ」と主張する場合、誤りとされる。しかし、画像に自転車が明確に存在するのにアノテーションが見逃した場合、モデルが正しく、データセットが欠陥となる。このようなエラーは、モデルの精度や幻覚メトリクスを歪める。

不正確または曖昧なアノテーションは、正確なモデルをエラーがあるように見せたり、欠陥のあるモデルを信頼できるように見せたりし、幻覚の診断やモデルランキングを複雑にする。

この研究は、MSCOCOラベルを使用し、視覚言語モデルの画像内オブジェクト識別能力をテストするPolling-based Object Probing Evaluation(POPE)ベンチマークを再検討する。

POPEは、幻覚をはい/いいえの分類タスクとして再構成し、モデルに「画像に

関連記事

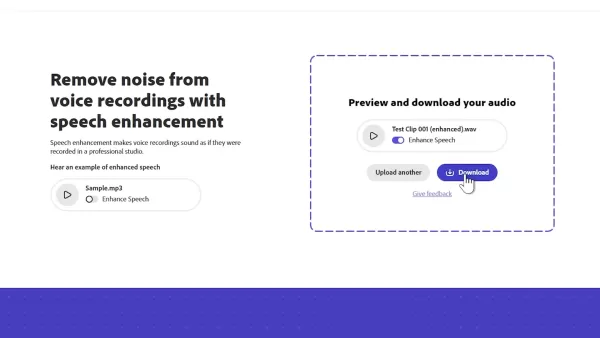

AI駆動のツールがコンテンツクリエイターの音声清晰度を向上

デジタル時代において、クリアな音声は、ポッドキャスト、ビデオ、またはプロフェッショナルなコミュニケーションにおいて魅力的なコンテンツに不可欠です。従来の方法では十分な結果が得られないことが多いですが、人工知能(AI)は音声強化を革新しています。この記事では、音声の清晰度を高め、背景ノイズを最小限に抑え、コストのかかる機材なしでプロフェッショナルな音質を実現する最先端のAIツールを紹介します。主なハ

AI駆動のツールがコンテンツクリエイターの音声清晰度を向上

デジタル時代において、クリアな音声は、ポッドキャスト、ビデオ、またはプロフェッショナルなコミュニケーションにおいて魅力的なコンテンツに不可欠です。従来の方法では十分な結果が得られないことが多いですが、人工知能(AI)は音声強化を革新しています。この記事では、音声の清晰度を高め、背景ノイズを最小限に抑え、コストのかかる機材なしでプロフェッショナルな音質を実現する最先端のAIツールを紹介します。主なハ

テックジャイアントがAIトレーニングプログラムで教育者を強化

テクノロジーは教育を革新しており、主要なテック企業は教師に重要なスキルを身につけさせています。Microsoft、OpenAI、Anthropicなどの大手企業は、教師組合と提携して全米AI教育アカデミーを設立し、数十万人の米国教育者を訓練する大胆な取り組みを進めています。人工知能は教育を変革し、教室でのイノベーションを高め、ダイナミックな学習体験を可能にしています。テックリーダーが教育者向けAI

テックジャイアントがAIトレーニングプログラムで教育者を強化

テクノロジーは教育を革新しており、主要なテック企業は教師に重要なスキルを身につけさせています。Microsoft、OpenAI、Anthropicなどの大手企業は、教師組合と提携して全米AI教育アカデミーを設立し、数十万人の米国教育者を訓練する大胆な取り組みを進めています。人工知能は教育を変革し、教室でのイノベーションを高め、ダイナミックな学習体験を可能にしています。テックリーダーが教育者向けAI

Creative FabricaがAIフォントジェネレーターを発表、デザインの創造性を高める

こんにちは、デザイン愛好者の皆さん!Creative Fabricaからの画期的なアップデートをご紹介し、あなたのクリエイティブプロセスを変革する準備ができています。アーティストやクリエイティブな起業家として、オンラインで収入を得るには、独自のビジュアルを作成することが重要です。新しいAIフォントジェネレーターは、ユニークなグラフィックを販売したり、Creative Fabricaの製品を活用した

コメント (0)

0/200

Creative FabricaがAIフォントジェネレーターを発表、デザインの創造性を高める

こんにちは、デザイン愛好者の皆さん!Creative Fabricaからの画期的なアップデートをご紹介し、あなたのクリエイティブプロセスを変革する準備ができています。アーティストやクリエイティブな起業家として、オンラインで収入を得るには、独自のビジュアルを作成することが重要です。新しいAIフォントジェネレーターは、ユニークなグラフィックを販売したり、Creative Fabricaの製品を活用した

コメント (0)

0/200

機械学習研究では、AIがデータセットのアノテーション、特に視覚言語モデル(VLM)の画像キャプションを強化し、コスト削減や人間の監督負担軽減が可能とされることが多い。

これは2000年代初頭の「RAMを増やす」ミームを彷彿とさせ、ソフトウェアがハードウェアの限界を解決できるという考えを嘲笑する。

しかし、アノテーションの品質は、機械学習パイプラインで重要な役割を果たすにもかかわらず、新しいAIモデルの話題性に埋もれて見過ごされることが多い。

AIがパターンを識別し再現する能力は、高品質で一貫性のある人間のアノテーション(ラベルや説明)に依存し、それは不完全な環境で主観的な判断を行う人々によって作成される。

人間の行動を模倣して正確なラベリングをスケールアップしようとするシステムは、人間が提供した例に含まれないデータに直面すると苦戦する。類似性は同等性を意味せず、コンピュータビジョンでのクロスドメインの一貫性は依然として困難である。

最終的に、AIシステムを形成するデータは人間の判断によって定義される。

RAGソリューション

最近まで、データセットのアノテーションエラーは、生成AIの不完全だが市場性のある出力に対して、許容可能な小さなトレードオフとして扱われてきた。

2025年のシンガポール研究では、幻覚(AIが誤った出力を生成すること)がこれらのシステムの設計に内在していることがわかった。

インターネット検索を通じて事実を検証するRAGベースのエージェントは、研究や商用アプリケーションで注目を集めているが、リソースコストやクエリ遅延が増加する。訓練済みモデルに適用される新しい情報は、ネイティブモデルの接続の深さに欠ける。

欠陥のあるアノテーションはモデルの性能を損ない、その品質を改善することは、人間の主観性により不完全ではあるが、極めて重要である。

RePOPEの洞察

ドイツの研究では、古いデータセットの欠陥、特にMSCOCOのようなベンチマークでの画像キャプションの正確性に焦点を当て、ラベルエラーが視覚言語モデルの幻覚評価を歪めることを明らかにした。

https://arxiv.org/pdf/2504.15707" aria-label="https://arxiv.org/pdf/2504.15707">https://arxiv.org/pdf/2504.15707

自転車を評価するAIが街のシーン画像を分析し、モデルが「はい」と答えたがデータセットが「いいえ」と主張する場合、誤りとされる。しかし、画像に自転車が明確に存在するのにアノテーションが見逃した場合、モデルが正しく、データセットが欠陥となる。このようなエラーは、モデルの精度や幻覚メトリクスを歪める。

不正確または曖昧なアノテーションは、正確なモデルをエラーがあるように見せたり、欠陥のあるモデルを信頼できるように見せたりし、幻覚の診断やモデルランキングを複雑にする。

この研究は、MSCOCOラベルを使用し、視覚言語モデルの画像内オブジェクト識別能力をテストするPolling-based Object Probing Evaluation(POPE)ベンチマークを再検討する。

POPEは、幻覚をはい/いいえの分類タスクとして再構成し、モデルに「画像に

AI駆動のツールがコンテンツクリエイターの音声清晰度を向上

デジタル時代において、クリアな音声は、ポッドキャスト、ビデオ、またはプロフェッショナルなコミュニケーションにおいて魅力的なコンテンツに不可欠です。従来の方法では十分な結果が得られないことが多いですが、人工知能(AI)は音声強化を革新しています。この記事では、音声の清晰度を高め、背景ノイズを最小限に抑え、コストのかかる機材なしでプロフェッショナルな音質を実現する最先端のAIツールを紹介します。主なハ

AI駆動のツールがコンテンツクリエイターの音声清晰度を向上

デジタル時代において、クリアな音声は、ポッドキャスト、ビデオ、またはプロフェッショナルなコミュニケーションにおいて魅力的なコンテンツに不可欠です。従来の方法では十分な結果が得られないことが多いですが、人工知能(AI)は音声強化を革新しています。この記事では、音声の清晰度を高め、背景ノイズを最小限に抑え、コストのかかる機材なしでプロフェッショナルな音質を実現する最先端のAIツールを紹介します。主なハ

Creative FabricaがAIフォントジェネレーターを発表、デザインの創造性を高める

こんにちは、デザイン愛好者の皆さん!Creative Fabricaからの画期的なアップデートをご紹介し、あなたのクリエイティブプロセスを変革する準備ができています。アーティストやクリエイティブな起業家として、オンラインで収入を得るには、独自のビジュアルを作成することが重要です。新しいAIフォントジェネレーターは、ユニークなグラフィックを販売したり、Creative Fabricaの製品を活用した

Creative FabricaがAIフォントジェネレーターを発表、デザインの創造性を高める

こんにちは、デザイン愛好者の皆さん!Creative Fabricaからの画期的なアップデートをご紹介し、あなたのクリエイティブプロセスを変革する準備ができています。アーティストやクリエイティブな起業家として、オンラインで収入を得るには、独自のビジュアルを作成することが重要です。新しいAIフォントジェネレーターは、ユニークなグラフィックを販売したり、Creative Fabricaの製品を活用した