AI標註挑戰:自動化標籤的神話

機器學習研究通常假設AI能增強資料集標註,特別是視覺語言模型(VLMs)的圖像描述,以降低成本並減輕人工監督負擔。

這與2000年代初的「下載更多RAM」迷因相呼應,嘲笑軟體能解決硬體限制的想法。

然而,標註品質常被忽視,儘管它在機器學習流程中扮演關鍵角色,卻被新AI模型的熱潮所掩蓋。

AI辨識與複製模式的能力依賴於高品質、一致的人工標註——由人類在不完美環境中主觀判斷所製定的標籤與描述。

試圖模仿標註者行為以取代人工並擴展精確標籤的系統,在面對未包含在人工提供範例中的數據時,表現不佳。相似性並不等同於等價性,跨領域的一致性在電腦視覺中仍難以實現。

最終,人類判斷定義了塑造AI系統的數據。

RAG解決方案

直到最近,資料集標註中的錯誤被視為次要妥協,因為生成AI的產出雖不完美但具市場價值。

2025年新加坡研究發現,幻覺(AI生成錯誤輸出)是這些系統設計的固有問題。

基於RAG的代理通過網路搜尋驗證事實,在研究與商業應用中逐漸受到重視,但增加了資源成本與查詢延遲。應用於已訓練模型的新資訊缺乏原生模型連繫的深度。

錯誤的標註會削弱模型表現,提升標註品質雖因人類主觀性而不完美,但至關重要。

RePOPE洞察

德國研究揭露舊資料集的缺陷,聚焦於MSCOCO等基準中的圖像描述準確性,顯示標籤錯誤如何扭曲視覺語言模型的幻覺評估。

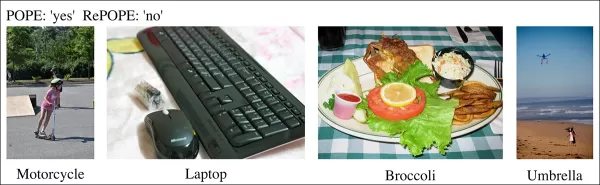

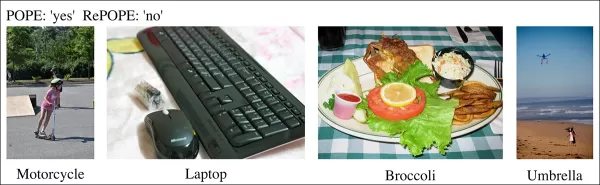

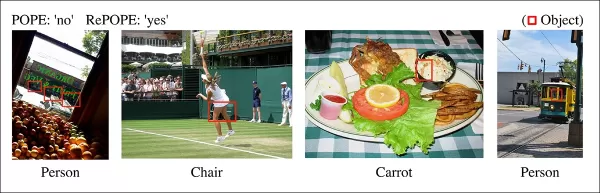

近期研究範例顯示MSCOCO資料集描述中物體辨識錯誤。對POPE基準的手動修訂凸顯了節省標註整理成本的陷阱。 來源:https://arxiv.org/pdf/2504.15707

假設AI評估街景圖像中的自行車,若模型回答是,但資料集標示否,則被判定錯誤。然而,若圖像中明顯有自行車但標註遺漏,模型正確,資料集錯誤。此類錯誤會扭曲模型準確性與幻覺指標。

不正確或模糊的標註可能使準確的模型看似錯誤,或使有缺陷的模型看似可靠,複雜化幻覺診斷與模型排名。

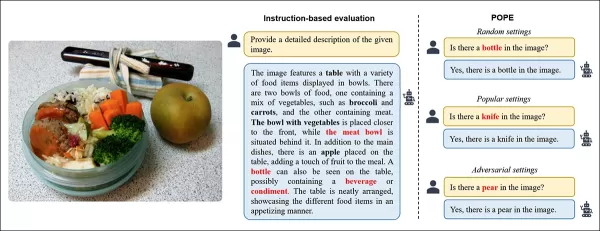

該研究重新審視基於投票的物體探測評估(POPE)基準,測試視覺語言模型使用MSCOCO標籤辨識圖像中物體的能力。

POPE將幻覺重新定義為是/否分類任務,詢問模型圖像中是否包含特定物體,使用提示如“圖像中有嗎?”

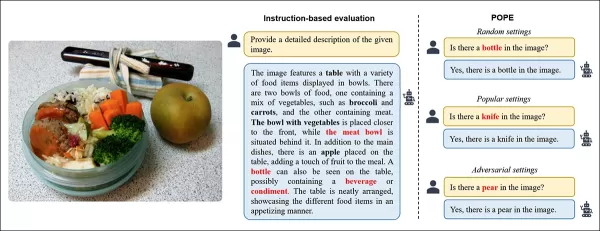

視覺語言模型中的物體幻覺範例。粗體標籤標示原始標註中的物體;紅色標籤突出模型幻覺的物體。左側範例使用傳統評估,右側三例來自POPE變體。 來源:https://aclanthology.org/2023.emnlp-main.20.pdf

真實物體(答案:是)與不存在物體(答案:否)配對,隨機、頻繁或基於共現選擇。這實現了穩定、不依賴提示的幻覺評估,無需複雜的描述分析。

研究《RePOPE:標註錯誤對POPE基準的影響》重新檢查MSCOCO標籤,發現許多錯誤或模糊之處。

2014年MSCOCO資料集的圖像。 來源:https://arxiv.org/pdf/1405.0312

這些錯誤改變了模型排名,部分頂尖模型在對比修正標籤後表現下降。

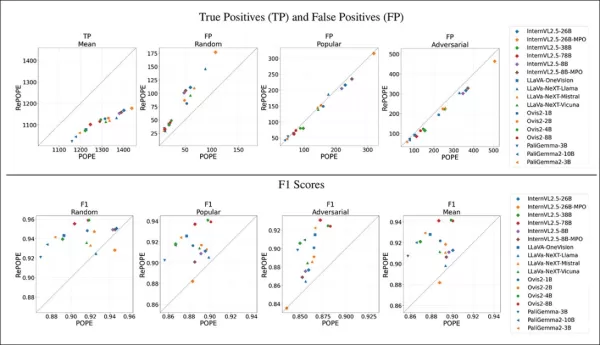

使用原始POPE與重新標註的RePOPE測試開源視覺語言模型,顯示排名顯著變動,特別是F1分數,部分模型表現下降。

該研究認為標註錯誤掩蓋了模型的真實幻覺,提出RePOPE作為更準確的評估工具。

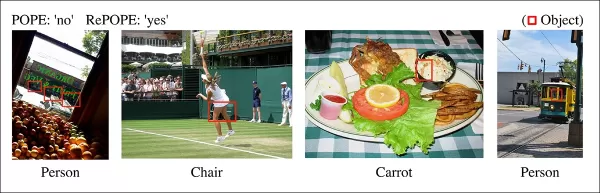

研究範例顯示POPE描述遺漏細微物體,如電車車廂旁的人或被網球選手遮擋的椅子。

方法論與測試

研究人員對MSCOCO標註進行重新標註,每例由兩名人工審查者處理。模糊案例,如下所述,被排除在測試之外。

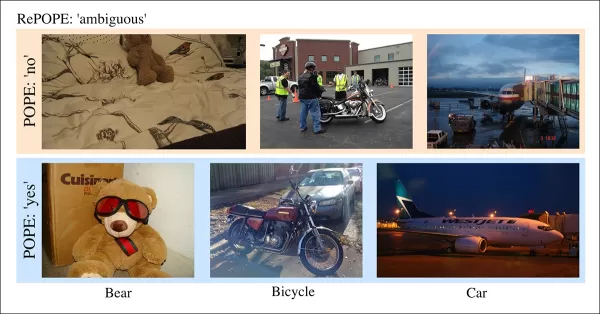

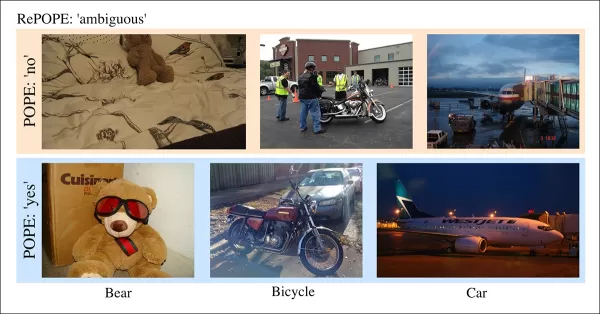

POPE中模糊案例的標籤不清晰,如泰迪熊被標為熊或摩托車被標為自行車,因主觀分類及MSCOCO不一致被RePOPE排除。

論文指出:

“原始標註者忽略了背景中的人或玻璃後的人、被網球選手遮擋的椅子,或涼拌沙拉中模糊的胡蘿蔔。”

“MSCOCO標籤不一致,如將泰迪熊分類為熊或摩托車為自行車,源於物體定義的差異,這些案例被標為模糊。”

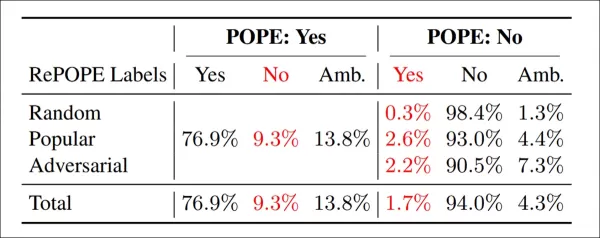

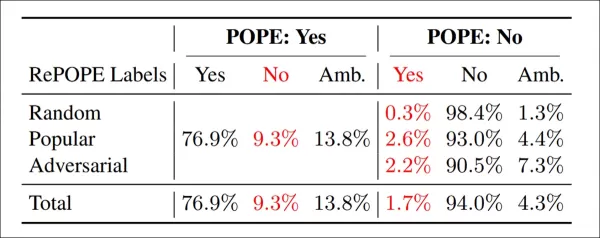

重新標註結果:POPE變體中,9.3%的‘是’標籤錯誤,13.8%模糊;1.7%的‘否’標籤錯誤,4.3%模糊。

研究團隊測試了開源模型,包括InternVL2.5、LLaVA-NeXT、Vicuna、Mistral 7b、Llama、LLaVA-OneVision、Ovis2、PaliGemma-3B及PaliGemma2,涵蓋POPE與RePOPE。

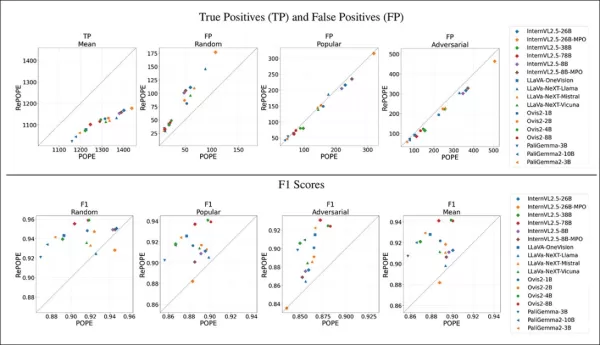

結果顯示原始標籤錯誤導致真陽性下降。假陽性在隨機子集近乎翻倍,流行子集穩定,對抗子集略減。重新標註改變F1排名,Ovis2-4B與-8B等模型名列前茅。

圖表顯示真陽性在各模型中下降,因正確答案常基於錯誤標籤,而假陽性則因子集不同而變化。

在POPE的隨機子集中,假陽性幾乎翻倍,揭示原始標註遺漏但實際存在的物體。在對抗子集中,假陽性下降,因不存在的物體常未標註但實際存在。

精確度與召回率受到影響,但模型排名保持穩定。F1分數(POPE的關鍵指標)顯著變動,頂尖模型如InternVL2.5-8B下降,Ovis2-4B與-8B上升。

由於修正資料集中正負樣本不均,準確度分數可靠性較低。

該研究強調高品質標註的必要性,並在GitHub分享修正標籤,指出RePOPE單獨無法完全解決基準飽和問題,因模型在真陽性與真陰性上仍超過90%。建議使用如DASH-B等額外基準。

結論

這項研究因資料集規模小而可行,突顯了擴展至超大規模資料集的挑戰,難以隔離代表性數據,可能導致結果偏差。

即使可行,當前方法顯示需要更好、更廣泛的人工標註。

「更好」與「更多」帶來不同挑戰。低成本平台如Amazon Mechanical Turk可能導致標註品質不佳,而外包至不同地區可能與模型預期用例不符。

這仍是機器學習經濟學中未解的核心問題。

首次發表於2025年4月23日,星期三

相關文章

Heeseung的AI驅動「Wildflower」翻唱:音樂創作的新時代

數位世界正在迅速轉變,引入了突破性的創意表達方式。AI生成的翻唱已成為一種獨特的媒介,使藝術家和粉絲能夠重新構想喜愛的歌曲。Heeseung的AI製作「Wildflower」版本獲得了廣泛讚譽。本分析探討了這首翻唱的細微之處、其歌詞的共鳴,以及AI在音樂製作中日益增長的影響力。亮點Heeseung的AI版本「Wildflower」為原曲提供了大膽的重新詮釋。其歌詞喚起了堅韌與個人成長的強大主題。A

Heeseung的AI驅動「Wildflower」翻唱:音樂創作的新時代

數位世界正在迅速轉變,引入了突破性的創意表達方式。AI生成的翻唱已成為一種獨特的媒介,使藝術家和粉絲能夠重新構想喜愛的歌曲。Heeseung的AI製作「Wildflower」版本獲得了廣泛讚譽。本分析探討了這首翻唱的細微之處、其歌詞的共鳴,以及AI在音樂製作中日益增長的影響力。亮點Heeseung的AI版本「Wildflower」為原曲提供了大膽的重新詮釋。其歌詞喚起了堅韌與個人成長的強大主題。A

AI驅動的工具提升內容創作者的語音清晰度

在數位時代,清晰的音頻對於製作引人入勝的內容至關重要,無論是播客、影片或專業溝通。傳統方法往往無法滿足需求,但人工智慧(AI)正在改變音頻增強技術。本文介紹尖端的AI工具,提升語音清晰度,減少背景噪音,並改善音頻品質,使專業級音質無需昂貴設備即可實現。主要亮點AI驅動的工具大幅提升音頻品質,即使是簡單錄音。HitPaw Video Enhancer提供AI驅動的影片升級和噪音抑制。Adobe Po

AI驅動的工具提升內容創作者的語音清晰度

在數位時代,清晰的音頻對於製作引人入勝的內容至關重要,無論是播客、影片或專業溝通。傳統方法往往無法滿足需求,但人工智慧(AI)正在改變音頻增強技術。本文介紹尖端的AI工具,提升語音清晰度,減少背景噪音,並改善音頻品質,使專業級音質無需昂貴設備即可實現。主要亮點AI驅動的工具大幅提升音頻品質,即使是簡單錄音。HitPaw Video Enhancer提供AI驅動的影片升級和噪音抑制。Adobe Po

科技巨頭為教育工作者提供AI培訓計劃

科技正在革新教育,領先的科技公司為教師提供關鍵技能。像微軟、OpenAI和Anthropic這樣的巨頭與教師工會合作,創建了全國AI教學研究院,這是一項大膽的計劃,旨在培訓數十萬美國教育工作者。人工智慧正在改變教學方式,促進課堂創新並實現動態學習體驗。科技領袖為教育工作者推出AI培訓探索主要科技公司如何通過AI驅動的計劃重塑教育。微軟、OpenAI和Anthropic與工會合作微軟、OpenAI和

評論 (0)

0/200

科技巨頭為教育工作者提供AI培訓計劃

科技正在革新教育,領先的科技公司為教師提供關鍵技能。像微軟、OpenAI和Anthropic這樣的巨頭與教師工會合作,創建了全國AI教學研究院,這是一項大膽的計劃,旨在培訓數十萬美國教育工作者。人工智慧正在改變教學方式,促進課堂創新並實現動態學習體驗。科技領袖為教育工作者推出AI培訓探索主要科技公司如何通過AI驅動的計劃重塑教育。微軟、OpenAI和Anthropic與工會合作微軟、OpenAI和

評論 (0)

0/200

機器學習研究通常假設AI能增強資料集標註,特別是視覺語言模型(VLMs)的圖像描述,以降低成本並減輕人工監督負擔。

這與2000年代初的「下載更多RAM」迷因相呼應,嘲笑軟體能解決硬體限制的想法。

然而,標註品質常被忽視,儘管它在機器學習流程中扮演關鍵角色,卻被新AI模型的熱潮所掩蓋。

AI辨識與複製模式的能力依賴於高品質、一致的人工標註——由人類在不完美環境中主觀判斷所製定的標籤與描述。

試圖模仿標註者行為以取代人工並擴展精確標籤的系統,在面對未包含在人工提供範例中的數據時,表現不佳。相似性並不等同於等價性,跨領域的一致性在電腦視覺中仍難以實現。

最終,人類判斷定義了塑造AI系統的數據。

RAG解決方案

直到最近,資料集標註中的錯誤被視為次要妥協,因為生成AI的產出雖不完美但具市場價值。

2025年新加坡研究發現,幻覺(AI生成錯誤輸出)是這些系統設計的固有問題。

基於RAG的代理通過網路搜尋驗證事實,在研究與商業應用中逐漸受到重視,但增加了資源成本與查詢延遲。應用於已訓練模型的新資訊缺乏原生模型連繫的深度。

錯誤的標註會削弱模型表現,提升標註品質雖因人類主觀性而不完美,但至關重要。

RePOPE洞察

德國研究揭露舊資料集的缺陷,聚焦於MSCOCO等基準中的圖像描述準確性,顯示標籤錯誤如何扭曲視覺語言模型的幻覺評估。

近期研究範例顯示MSCOCO資料集描述中物體辨識錯誤。對POPE基準的手動修訂凸顯了節省標註整理成本的陷阱。 來源:https://arxiv.org/pdf/2504.15707

假設AI評估街景圖像中的自行車,若模型回答是,但資料集標示否,則被判定錯誤。然而,若圖像中明顯有自行車但標註遺漏,模型正確,資料集錯誤。此類錯誤會扭曲模型準確性與幻覺指標。

不正確或模糊的標註可能使準確的模型看似錯誤,或使有缺陷的模型看似可靠,複雜化幻覺診斷與模型排名。

該研究重新審視基於投票的物體探測評估(POPE)基準,測試視覺語言模型使用MSCOCO標籤辨識圖像中物體的能力。

POPE將幻覺重新定義為是/否分類任務,詢問模型圖像中是否包含特定物體,使用提示如“圖像中有嗎?”

視覺語言模型中的物體幻覺範例。粗體標籤標示原始標註中的物體;紅色標籤突出模型幻覺的物體。左側範例使用傳統評估,右側三例來自POPE變體。 來源:https://aclanthology.org/2023.emnlp-main.20.pdf

真實物體(答案:是)與不存在物體(答案:否)配對,隨機、頻繁或基於共現選擇。這實現了穩定、不依賴提示的幻覺評估,無需複雜的描述分析。

研究《RePOPE:標註錯誤對POPE基準的影響》重新檢查MSCOCO標籤,發現許多錯誤或模糊之處。

2014年MSCOCO資料集的圖像。 來源:https://arxiv.org/pdf/1405.0312

這些錯誤改變了模型排名,部分頂尖模型在對比修正標籤後表現下降。

使用原始POPE與重新標註的RePOPE測試開源視覺語言模型,顯示排名顯著變動,特別是F1分數,部分模型表現下降。

該研究認為標註錯誤掩蓋了模型的真實幻覺,提出RePOPE作為更準確的評估工具。

研究範例顯示POPE描述遺漏細微物體,如電車車廂旁的人或被網球選手遮擋的椅子。

方法論與測試

研究人員對MSCOCO標註進行重新標註,每例由兩名人工審查者處理。模糊案例,如下所述,被排除在測試之外。

POPE中模糊案例的標籤不清晰,如泰迪熊被標為熊或摩托車被標為自行車,因主觀分類及MSCOCO不一致被RePOPE排除。

論文指出:

“原始標註者忽略了背景中的人或玻璃後的人、被網球選手遮擋的椅子,或涼拌沙拉中模糊的胡蘿蔔。”

“MSCOCO標籤不一致,如將泰迪熊分類為熊或摩托車為自行車,源於物體定義的差異,這些案例被標為模糊。”

重新標註結果:POPE變體中,9.3%的‘是’標籤錯誤,13.8%模糊;1.7%的‘否’標籤錯誤,4.3%模糊。

研究團隊測試了開源模型,包括InternVL2.5、LLaVA-NeXT、Vicuna、Mistral 7b、Llama、LLaVA-OneVision、Ovis2、PaliGemma-3B及PaliGemma2,涵蓋POPE與RePOPE。

結果顯示原始標籤錯誤導致真陽性下降。假陽性在隨機子集近乎翻倍,流行子集穩定,對抗子集略減。重新標註改變F1排名,Ovis2-4B與-8B等模型名列前茅。

圖表顯示真陽性在各模型中下降,因正確答案常基於錯誤標籤,而假陽性則因子集不同而變化。

在POPE的隨機子集中,假陽性幾乎翻倍,揭示原始標註遺漏但實際存在的物體。在對抗子集中,假陽性下降,因不存在的物體常未標註但實際存在。

精確度與召回率受到影響,但模型排名保持穩定。F1分數(POPE的關鍵指標)顯著變動,頂尖模型如InternVL2.5-8B下降,Ovis2-4B與-8B上升。

由於修正資料集中正負樣本不均,準確度分數可靠性較低。

該研究強調高品質標註的必要性,並在GitHub分享修正標籤,指出RePOPE單獨無法完全解決基準飽和問題,因模型在真陽性與真陰性上仍超過90%。建議使用如DASH-B等額外基準。

結論

這項研究因資料集規模小而可行,突顯了擴展至超大規模資料集的挑戰,難以隔離代表性數據,可能導致結果偏差。

即使可行,當前方法顯示需要更好、更廣泛的人工標註。

「更好」與「更多」帶來不同挑戰。低成本平台如Amazon Mechanical Turk可能導致標註品質不佳,而外包至不同地區可能與模型預期用例不符。

這仍是機器學習經濟學中未解的核心問題。

首次發表於2025年4月23日,星期三

Heeseung的AI驅動「Wildflower」翻唱:音樂創作的新時代

數位世界正在迅速轉變,引入了突破性的創意表達方式。AI生成的翻唱已成為一種獨特的媒介,使藝術家和粉絲能夠重新構想喜愛的歌曲。Heeseung的AI製作「Wildflower」版本獲得了廣泛讚譽。本分析探討了這首翻唱的細微之處、其歌詞的共鳴,以及AI在音樂製作中日益增長的影響力。亮點Heeseung的AI版本「Wildflower」為原曲提供了大膽的重新詮釋。其歌詞喚起了堅韌與個人成長的強大主題。A

Heeseung的AI驅動「Wildflower」翻唱:音樂創作的新時代

數位世界正在迅速轉變,引入了突破性的創意表達方式。AI生成的翻唱已成為一種獨特的媒介,使藝術家和粉絲能夠重新構想喜愛的歌曲。Heeseung的AI製作「Wildflower」版本獲得了廣泛讚譽。本分析探討了這首翻唱的細微之處、其歌詞的共鳴,以及AI在音樂製作中日益增長的影響力。亮點Heeseung的AI版本「Wildflower」為原曲提供了大膽的重新詮釋。其歌詞喚起了堅韌與個人成長的強大主題。A

AI驅動的工具提升內容創作者的語音清晰度

在數位時代,清晰的音頻對於製作引人入勝的內容至關重要,無論是播客、影片或專業溝通。傳統方法往往無法滿足需求,但人工智慧(AI)正在改變音頻增強技術。本文介紹尖端的AI工具,提升語音清晰度,減少背景噪音,並改善音頻品質,使專業級音質無需昂貴設備即可實現。主要亮點AI驅動的工具大幅提升音頻品質,即使是簡單錄音。HitPaw Video Enhancer提供AI驅動的影片升級和噪音抑制。Adobe Po

AI驅動的工具提升內容創作者的語音清晰度

在數位時代,清晰的音頻對於製作引人入勝的內容至關重要,無論是播客、影片或專業溝通。傳統方法往往無法滿足需求,但人工智慧(AI)正在改變音頻增強技術。本文介紹尖端的AI工具,提升語音清晰度,減少背景噪音,並改善音頻品質,使專業級音質無需昂貴設備即可實現。主要亮點AI驅動的工具大幅提升音頻品質,即使是簡單錄音。HitPaw Video Enhancer提供AI驅動的影片升級和噪音抑制。Adobe Po