AI标注挑战:自动化标注的神话

机器学习研究常常假设AI可以增强数据集标注,特别是视觉-语言模型(VLM)的图像描述,以降低成本和减少人工监督负担。

这让人想起2000年代初的“下载更多RAM”迷因,嘲笑软件可以解决硬件限制的想法。

然而,标注质量常常被忽视,被新AI模型的热潮所掩盖,尽管它在机器学习流程中扮演着关键角色。

AI识别和复制模式的能力依赖于高质量、一致的人工标注——由人在不完美环境中做出的主观判断所创建的标签和描述。

旨在模仿标注者行为以取代人工并扩展准确标注的系统,在面对未包含在人工提供示例中的数据时会遇到困难。相似性并不等同于等价性,跨领域一致性在计算机视觉中仍难以实现。

最终,人类判断定义了塑造AI系统的数据。

RAG解决方案

直到最近,数据集标注中的错误被视为次要权衡,因为生成式AI的输出虽不完美但具有市场价值。

2025年新加坡的一项研究发现,幻觉——AI生成虚假输出——是这些系统设计中固有的问题。

基于RAG的代理通过网络搜索验证事实,在研究和商业应用中逐渐受到关注,但增加了资源成本和查询延迟。新信息应用于训练模型时缺乏原生模型连接的深度。

有缺陷的标注会削弱模型性能,提高标注质量虽然因人类主观性而不完美,但至关重要。

RePOPE洞察

德国的一项研究揭示了旧数据集的缺陷,重点关注MSCOCO等基准测试中的图像描述准确性。它展示了标签错误如何扭曲视觉-语言模型的幻觉评估。

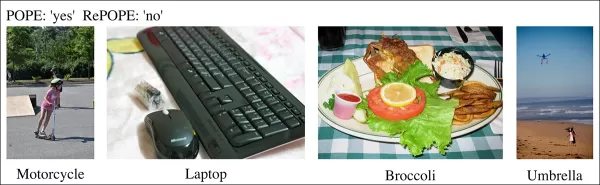

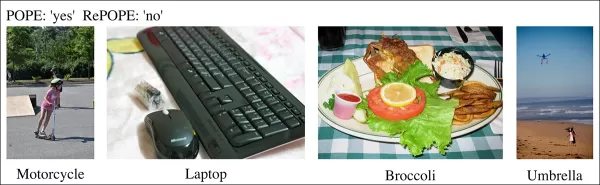

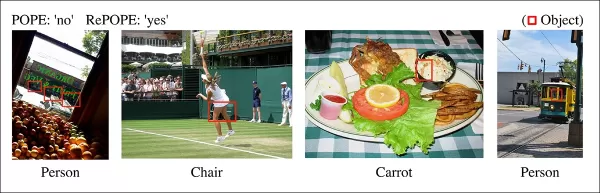

近期研究中的示例,显示MSCOCO数据集描述中物体识别错误。对POPE基准的手动修订凸显了在标注管理上节省成本的弊端。 来源:https://arxiv.org/pdf/2504.15707

考虑一个AI评估街景图像是否存在自行车。如果模型说是,但数据集声称否,则被标记为错误。然而,如果图像中明显存在自行车但标注遗漏,模型是正确的,而数据集有缺陷。此类错误会扭曲模型准确性和幻觉指标。

不正确或模糊的标注可能使准确的模型看似错误,或使有缺陷的模型看似可靠,复杂化幻觉诊断和模型排名。

该研究重新审视了基于投票的对象探测评估(POPE)基准,测试视觉-语言模型使用MSCOCO标签识别图像中物体的能力。

POPE将幻觉重新定义为是/否分类任务,通过提示如“图像中有吗?”询问模型特定物体是否出现在图像中。

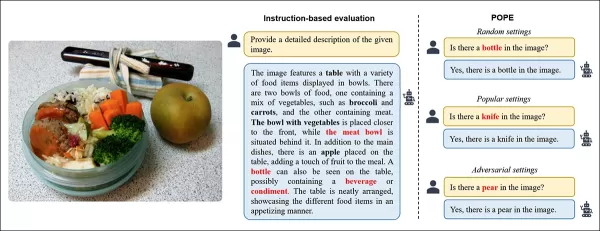

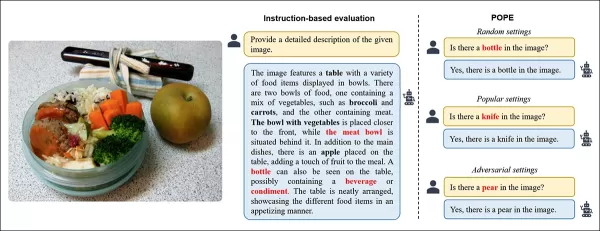

视觉-语言模型中的物体幻觉示例。加粗标签标记原始标注中的物体;红色标签高亮模型产生的幻觉物体。左侧示例使用传统评估,右侧三个示例来自POPE变体。 来源:https://aclanthology.org/2023.emnlp-main.20.pdf

真实物体(答案:是)与不存在的物体(答案:否)配对,随机、频繁或基于共现选择。这实现了无需复杂描述分析的稳定、与提示无关的幻觉评估。

该研究,RePOPE:标注错误对POPE基准的影响,重新检查MSCOCO标签,发现许多错误或模糊之处。

2014年MSCOCO数据集中的图像。 来源:https://arxiv.org/pdf/1405.0312

这些错误改变了模型排名,一些高性能模型在针对修正标签评估时排名下降。

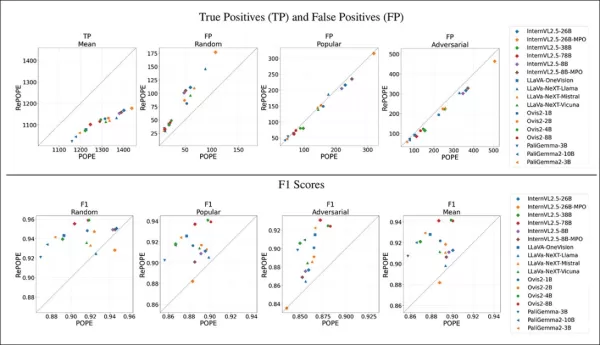

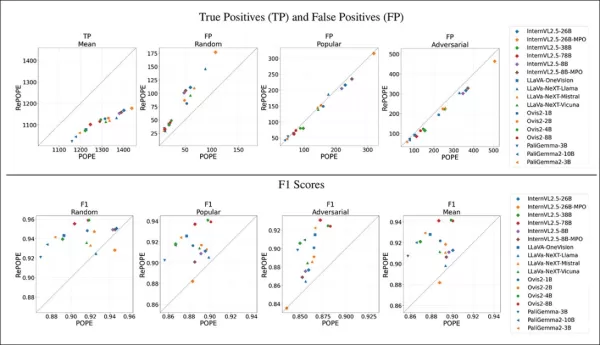

在原始POPE和重新标注的RePOPE上测试开源视觉-语言模型,显示排名显著变化,特别是在F1分数上,几个模型性能下降。

该研究认为,标注错误掩盖了模型的真实幻觉,提出RePOPE作为更准确的评估工具。

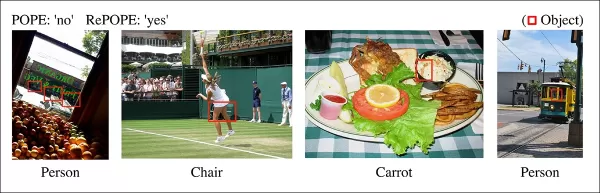

研究中的示例显示POPE描述遗漏了细微物体,如有轨电车车厢旁的人或被网球选手遮挡的椅子。

方法与测试

研究人员为MSCOCO标注重新标注,每实例由两名人工审查员处理。模糊案例,如下所述,被排除在测试之外。

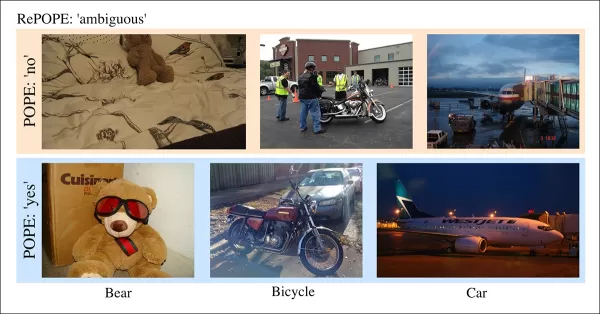

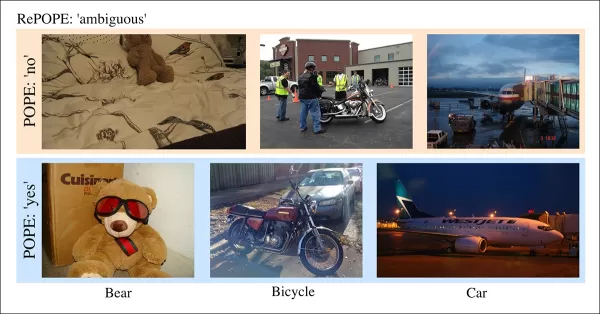

POPE中的模糊案例,如泰迪熊被标注为熊或摩托车被标注为自行车,因主观分类和MSCOCO不一致而被RePOPE排除。

论文指出:

“原始标注者忽略了背景中的人或玻璃后的人,被网球选手遮挡的椅子,或凉拌卷心菜中模糊的胡萝卜。”

“MSCOCO标签不一致,如将泰迪熊分类为熊或摩托车分类为自行车,源于不同的物体定义,使此类案例被标记为模糊。”

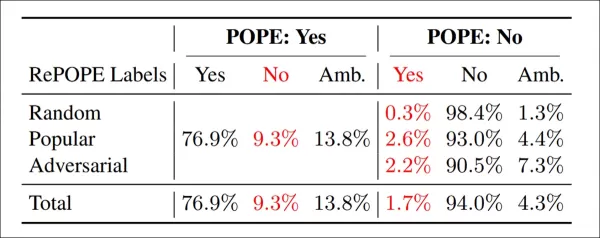

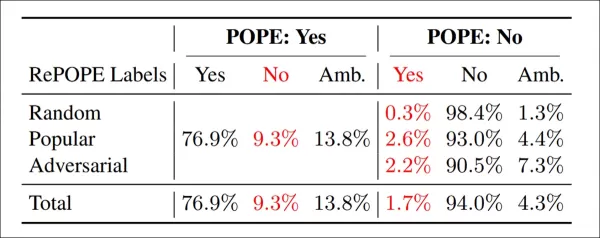

重新标注结果:在POPE变体中,‘是’标签中有9.3%不正确,13.8%模糊;‘否’标签中有1.7%错误,4.3%模糊。

团队测试了开源模型,包括InternVL2.5、LLaVA-NeXT、Vicuna、Mistral 7b、Llama、LLaVA-OneVision、Ovis2、PaliGemma-3B和PaliGemma2,跨POPE和RePOPE进行测试。

结果显示,原始标签错误导致真正例下降。虚假正例在随机子集上翻倍,流行子集上保持稳定,对抗子集上略降。重新标注改变了F1排名,Ovis2-4B和-8B等模型名列前茅。

图表显示,真正例在所有模型中下降,因为正确答案往往基于错误标签,而虚假正例变化不一。

在POPE的随机子集中,虚假正例几乎翻倍,揭示了存在但原始标注遗漏的物体。在对抗子集中,虚假正例下降,因为未标注但存在的物体常被忽略。

精确度和召回率受到影响,但模型排名保持稳定。F1分数,POPE的关键指标,显著变化,顶级模型如InternVL2.5-8B下降,Ovis2-4B和-8B上升。

由于修正数据集中正负样本不平衡,准确度分数可靠性较低。

该研究强调高质量标注的必要性,并在GitHub上共享了修正标签,指出RePOPE单独无法完全解决基准饱和问题,因为模型在真正例和负例上仍得分超过90%。建议使用DASH-B等额外基准。

结论

这项研究因数据集较小而可行,突显了扩展到超大规模数据集的挑战,隔离代表性数据很困难,可能导致结果偏差。

即使可行,当前方法表明需要更好、更广泛的人工标注。

“更好”和“更多”带来了不同挑战。像Amazon Mechanical Turk这样的低成本平台可能导致标注质量差,而外包到不同地区可能与模型预期用例不符。

这仍是机器学习经济学中一个核心、未解决的问题。

首次发布于2025年4月23日,星期三

相关文章

AI驱动的工具提升内容创作者的语音清晰度

在数字时代,纯净的音频对于吸引人的内容至关重要,无论是用于播客、视频还是专业沟通。传统方法往往无法满足需求,但人工智能(AI)正在改变音频增强的局面。本文介绍了尖端的AI工具,这些工具能提升语音清晰度,减少背景噪音,并改善音频质量,使专业级音质无需昂贵设备即可实现。主要亮点AI驱动的工具显著提升了音频质量,即使是从简单录音中也能做到。HitPaw视频增强器提供AI驱动的视频升频和噪音抑制功能。Ad

AI驱动的工具提升内容创作者的语音清晰度

在数字时代,纯净的音频对于吸引人的内容至关重要,无论是用于播客、视频还是专业沟通。传统方法往往无法满足需求,但人工智能(AI)正在改变音频增强的局面。本文介绍了尖端的AI工具,这些工具能提升语音清晰度,减少背景噪音,并改善音频质量,使专业级音质无需昂贵设备即可实现。主要亮点AI驱动的工具显著提升了音频质量,即使是从简单录音中也能做到。HitPaw视频增强器提供AI驱动的视频升频和噪音抑制功能。Ad

科技巨头通过人工智能培训计划赋能教育工作者

技术正在革命化教育,领先的科技公司为教师提供关键技能。微软、OpenAI和Anthropic等巨头与教师工会合作,建立了国家人工智能教学学院,这是一项大胆的举措,旨在培训数十万美国教育工作者。人工智能正在转变教学方式,提升课堂创新,带来动态的学习体验。科技领导者为教育工作者推出人工智能培训了解主要科技公司如何通过人工智能驱动的计划重塑教育。微软、OpenAI和Anthropic与工会合作微软、Op

科技巨头通过人工智能培训计划赋能教育工作者

技术正在革命化教育,领先的科技公司为教师提供关键技能。微软、OpenAI和Anthropic等巨头与教师工会合作,建立了国家人工智能教学学院,这是一项大胆的举措,旨在培训数十万美国教育工作者。人工智能正在转变教学方式,提升课堂创新,带来动态的学习体验。科技领导者为教育工作者推出人工智能培训了解主要科技公司如何通过人工智能驱动的计划重塑教育。微软、OpenAI和Anthropic与工会合作微软、Op

Creative Fabrica 发布 AI 字体生成器以提升设计创意

您好,设计爱好者!我们很高兴探索 Creative Fabrica 的突破性更新,它将改变您的创意过程。无论您是艺术家还是创意企业家,在线赚钱通常涉及打造独特的视觉效果。新的 AI 字体生成器赋予您增强设计能力的能力,无论您是为销售制作独特图形,还是利用 Creative Fabrica 的产品。了解这款尖端工具如何简化专业级字体的创建。主要亮点Creative Fabrica 推出其创新的 AI

评论 (0)

0/200

Creative Fabrica 发布 AI 字体生成器以提升设计创意

您好,设计爱好者!我们很高兴探索 Creative Fabrica 的突破性更新,它将改变您的创意过程。无论您是艺术家还是创意企业家,在线赚钱通常涉及打造独特的视觉效果。新的 AI 字体生成器赋予您增强设计能力的能力,无论您是为销售制作独特图形,还是利用 Creative Fabrica 的产品。了解这款尖端工具如何简化专业级字体的创建。主要亮点Creative Fabrica 推出其创新的 AI

评论 (0)

0/200

机器学习研究常常假设AI可以增强数据集标注,特别是视觉-语言模型(VLM)的图像描述,以降低成本和减少人工监督负担。

这让人想起2000年代初的“下载更多RAM”迷因,嘲笑软件可以解决硬件限制的想法。

然而,标注质量常常被忽视,被新AI模型的热潮所掩盖,尽管它在机器学习流程中扮演着关键角色。

AI识别和复制模式的能力依赖于高质量、一致的人工标注——由人在不完美环境中做出的主观判断所创建的标签和描述。

旨在模仿标注者行为以取代人工并扩展准确标注的系统,在面对未包含在人工提供示例中的数据时会遇到困难。相似性并不等同于等价性,跨领域一致性在计算机视觉中仍难以实现。

最终,人类判断定义了塑造AI系统的数据。

RAG解决方案

直到最近,数据集标注中的错误被视为次要权衡,因为生成式AI的输出虽不完美但具有市场价值。

2025年新加坡的一项研究发现,幻觉——AI生成虚假输出——是这些系统设计中固有的问题。

基于RAG的代理通过网络搜索验证事实,在研究和商业应用中逐渐受到关注,但增加了资源成本和查询延迟。新信息应用于训练模型时缺乏原生模型连接的深度。

有缺陷的标注会削弱模型性能,提高标注质量虽然因人类主观性而不完美,但至关重要。

RePOPE洞察

德国的一项研究揭示了旧数据集的缺陷,重点关注MSCOCO等基准测试中的图像描述准确性。它展示了标签错误如何扭曲视觉-语言模型的幻觉评估。

近期研究中的示例,显示MSCOCO数据集描述中物体识别错误。对POPE基准的手动修订凸显了在标注管理上节省成本的弊端。 来源:https://arxiv.org/pdf/2504.15707

考虑一个AI评估街景图像是否存在自行车。如果模型说是,但数据集声称否,则被标记为错误。然而,如果图像中明显存在自行车但标注遗漏,模型是正确的,而数据集有缺陷。此类错误会扭曲模型准确性和幻觉指标。

不正确或模糊的标注可能使准确的模型看似错误,或使有缺陷的模型看似可靠,复杂化幻觉诊断和模型排名。

该研究重新审视了基于投票的对象探测评估(POPE)基准,测试视觉-语言模型使用MSCOCO标签识别图像中物体的能力。

POPE将幻觉重新定义为是/否分类任务,通过提示如“图像中有吗?”询问模型特定物体是否出现在图像中。

视觉-语言模型中的物体幻觉示例。加粗标签标记原始标注中的物体;红色标签高亮模型产生的幻觉物体。左侧示例使用传统评估,右侧三个示例来自POPE变体。 来源:https://aclanthology.org/2023.emnlp-main.20.pdf

真实物体(答案:是)与不存在的物体(答案:否)配对,随机、频繁或基于共现选择。这实现了无需复杂描述分析的稳定、与提示无关的幻觉评估。

该研究,RePOPE:标注错误对POPE基准的影响,重新检查MSCOCO标签,发现许多错误或模糊之处。

2014年MSCOCO数据集中的图像。 来源:https://arxiv.org/pdf/1405.0312

这些错误改变了模型排名,一些高性能模型在针对修正标签评估时排名下降。

在原始POPE和重新标注的RePOPE上测试开源视觉-语言模型,显示排名显著变化,特别是在F1分数上,几个模型性能下降。

该研究认为,标注错误掩盖了模型的真实幻觉,提出RePOPE作为更准确的评估工具。

研究中的示例显示POPE描述遗漏了细微物体,如有轨电车车厢旁的人或被网球选手遮挡的椅子。

方法与测试

研究人员为MSCOCO标注重新标注,每实例由两名人工审查员处理。模糊案例,如下所述,被排除在测试之外。

POPE中的模糊案例,如泰迪熊被标注为熊或摩托车被标注为自行车,因主观分类和MSCOCO不一致而被RePOPE排除。

论文指出:

“原始标注者忽略了背景中的人或玻璃后的人,被网球选手遮挡的椅子,或凉拌卷心菜中模糊的胡萝卜。”

“MSCOCO标签不一致,如将泰迪熊分类为熊或摩托车分类为自行车,源于不同的物体定义,使此类案例被标记为模糊。”

重新标注结果:在POPE变体中,‘是’标签中有9.3%不正确,13.8%模糊;‘否’标签中有1.7%错误,4.3%模糊。

团队测试了开源模型,包括InternVL2.5、LLaVA-NeXT、Vicuna、Mistral 7b、Llama、LLaVA-OneVision、Ovis2、PaliGemma-3B和PaliGemma2,跨POPE和RePOPE进行测试。

结果显示,原始标签错误导致真正例下降。虚假正例在随机子集上翻倍,流行子集上保持稳定,对抗子集上略降。重新标注改变了F1排名,Ovis2-4B和-8B等模型名列前茅。

图表显示,真正例在所有模型中下降,因为正确答案往往基于错误标签,而虚假正例变化不一。

在POPE的随机子集中,虚假正例几乎翻倍,揭示了存在但原始标注遗漏的物体。在对抗子集中,虚假正例下降,因为未标注但存在的物体常被忽略。

精确度和召回率受到影响,但模型排名保持稳定。F1分数,POPE的关键指标,显著变化,顶级模型如InternVL2.5-8B下降,Ovis2-4B和-8B上升。

由于修正数据集中正负样本不平衡,准确度分数可靠性较低。

该研究强调高质量标注的必要性,并在GitHub上共享了修正标签,指出RePOPE单独无法完全解决基准饱和问题,因为模型在真正例和负例上仍得分超过90%。建议使用DASH-B等额外基准。

结论

这项研究因数据集较小而可行,突显了扩展到超大规模数据集的挑战,隔离代表性数据很困难,可能导致结果偏差。

即使可行,当前方法表明需要更好、更广泛的人工标注。

“更好”和“更多”带来了不同挑战。像Amazon Mechanical Turk这样的低成本平台可能导致标注质量差,而外包到不同地区可能与模型预期用例不符。

这仍是机器学习经济学中一个核心、未解决的问题。

首次发布于2025年4月23日,星期三

AI驱动的工具提升内容创作者的语音清晰度

在数字时代,纯净的音频对于吸引人的内容至关重要,无论是用于播客、视频还是专业沟通。传统方法往往无法满足需求,但人工智能(AI)正在改变音频增强的局面。本文介绍了尖端的AI工具,这些工具能提升语音清晰度,减少背景噪音,并改善音频质量,使专业级音质无需昂贵设备即可实现。主要亮点AI驱动的工具显著提升了音频质量,即使是从简单录音中也能做到。HitPaw视频增强器提供AI驱动的视频升频和噪音抑制功能。Ad

AI驱动的工具提升内容创作者的语音清晰度

在数字时代,纯净的音频对于吸引人的内容至关重要,无论是用于播客、视频还是专业沟通。传统方法往往无法满足需求,但人工智能(AI)正在改变音频增强的局面。本文介绍了尖端的AI工具,这些工具能提升语音清晰度,减少背景噪音,并改善音频质量,使专业级音质无需昂贵设备即可实现。主要亮点AI驱动的工具显著提升了音频质量,即使是从简单录音中也能做到。HitPaw视频增强器提供AI驱动的视频升频和噪音抑制功能。Ad

Creative Fabrica 发布 AI 字体生成器以提升设计创意

您好,设计爱好者!我们很高兴探索 Creative Fabrica 的突破性更新,它将改变您的创意过程。无论您是艺术家还是创意企业家,在线赚钱通常涉及打造独特的视觉效果。新的 AI 字体生成器赋予您增强设计能力的能力,无论您是为销售制作独特图形,还是利用 Creative Fabrica 的产品。了解这款尖端工具如何简化专业级字体的创建。主要亮点Creative Fabrica 推出其创新的 AI

Creative Fabrica 发布 AI 字体生成器以提升设计创意

您好,设计爱好者!我们很高兴探索 Creative Fabrica 的突破性更新,它将改变您的创意过程。无论您是艺术家还是创意企业家,在线赚钱通常涉及打造独特的视觉效果。新的 AI 字体生成器赋予您增强设计能力的能力,无论您是为销售制作独特图形,还是利用 Creative Fabrica 的产品。了解这款尖端工具如何简化专业级字体的创建。主要亮点Creative Fabrica 推出其创新的 AI