サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。

企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロバイダーやモデルに依存するのではなく、さまざまなフロンティア・モデルの強みを動的に活用し、各タスク・セグメントに最適なAIを割り当てて、最適な成果を達成することができる。

集合知の活用

フロンティアAIのモデルは急速に進歩しており、それぞれがトレーニングデータと設計に基づいた明確な強みと弱みを持っている。あるモデルはコーディングで輝き、別のモデルは創作で輝くかもしれない。サカナAIのチームは、こうした違いを欠点ではなく資産として捉えている。

「私たちは、これらのユニークな能力を、集合知を構築するための貴重なツールとして考えています」と研究者たちはブログで述べている。研究者たちは、人間のチームが多様性によって飛躍的な進歩を遂げるように、AIシステムも協力することでより多くのことを達成できると主張している。"それぞれの強みを組み合わせることで、AIシステムは、単一のモデルでは克服できなかった課題を解決することができる"

推論のパフォーマンス向上

サカナAIのアルゴリズムは、「推論時スケーリング」手法(「テスト時スケーリング」とも呼ばれる)であり、AI研究で人気を集めている。より大きなモデルやデータセットに焦点を当てる「訓練時スケーリング」とは異なり、推論時スケーリングは、訓練後の計算リソースを最適化することで性能を高める。

一つの方法は、OpenAI o3やDeepSeek-R1のようなモデルに見られるように、強化学習を使用して、モデルに詳細な思考連鎖(CoT)シーケンスを生成するように促す。もうひとつのアプローチである反復サンプリングは、ブレーンストーミングのように、多様な解決策を生成するようモデルに何度も促す。サカナAIの手法は、これらのコンセプトを改良したものだ。

「サカナAIの研究科学者で論文の共著者である秋葉卓也氏は、VentureBeatのインタビューで、「我々のフレームワークは、Best-of-Nサンプリングを改良したものです。「強化学習による拡張CoTのような推論技術を強化します。探索アプローチと適切なLLMを戦略的に選択することで、限られた呼び出しの中でパフォーマンスを最適化し、複雑なタスクに優れています。"

適応分岐探索の機能

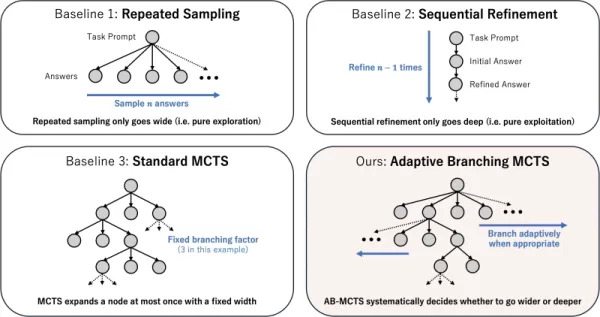

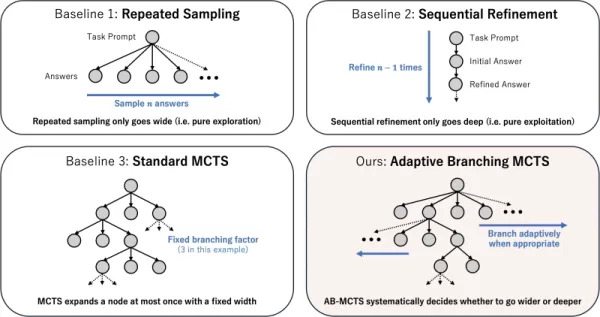

この技術の中核は、適応分岐モンテカルロ木探索(AB-MCTS)アルゴリズムである。AB-MCTSは、「より深く探索する」(有望な解を洗練する)ことと「より広く探索する」(新しい解を生成する)ことのバランスをとることで、LLMがインテリジェントな試行錯誤を行うことを可能にします。AB-MCTSはこれらのストラテジーをブレンドし、システムが必要に応じてアイデアを改良したり、新しいアイデアにピボットすることを可能にします。

これは、DeepMindのAlphaGoで使用されている意思決定アルゴリズムであるモンテカルロ木探索(MCTS)によって実現されている。AB-MCTSは確率モデルを採用し、各ステップで改良するか再開するかを決定する。

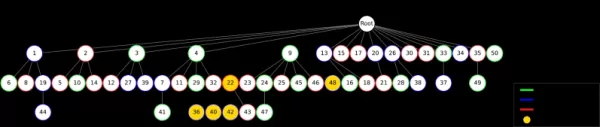

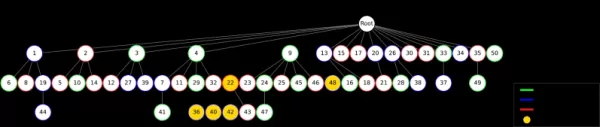

異なるテスト時間スケーリング戦略 出典:Sakana AIサカナAI マルチLLM AB-MCTSはこれをさらに推し進め、「何を」行うか(精緻化か生成か)だけでなく、「どの」LLMを使用するかも決定する。最初はタスクに最適なモデルがわからないため、システムはLLMの組み合わせをテストし、時間の経過とともにどのLLMがより良いパフォーマンスを発揮するかを学習し、より多くの仕事を割り当てます。

AIチームのテスト

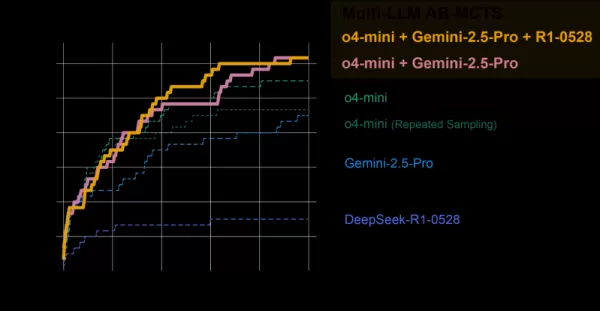

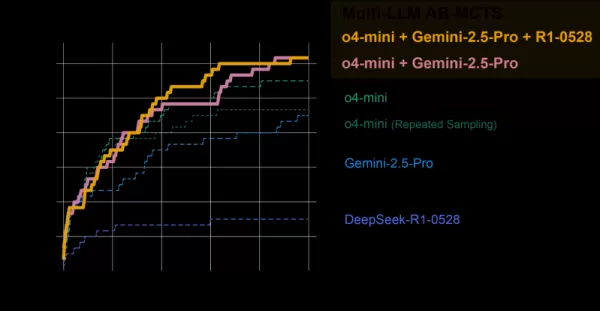

マルチLLM AB-MCTSシステムは、ARC-AGI-2ベンチマークで評価された。ARC-AGI-2は、AIにとって厳しい課題である新規の問題に対する人間のような視覚的推論をテストするベンチマークである。

チームは、o4-mini、Gemini 2.5 Pro、DeepSeek-R1などのフロンティアモデルを組み合わせた。

モデル集団は120のテスト問題の30%以上を解き、単一のモデルの性能をはるかに上回った。システムは、各タスクに最適なモデルを動的に割り当て、明確な解決パスが存在する場合には、最も効果的なLLMを迅速に特定しました。

AB-MCTSと個々のモデルの比較 出典サカナAI 驚くべきことに、このシステムは、これまで単一のモデルでは解決できなかった問題を解決した。ある例では、o4-miniの誤った解が、DeepSeek-R1とGemini-2.5 Proによって改良され、エラーが修正され、正しい解が得られました。

「これは、Multi-LLM AB-MCTSがフロンティアモデルを組み合わせることで、これまで解決できなかった課題に取り組むことができ、AI集合知の限界を拡大できることを示しています」と研究者らは述べている。

AB-MTCSは問題解決の異なる段階で異なるモデルを選択できる 出典:Sakana AIサカナAI 「各モデルの得意分野や幻覚傾向はさまざまです」と秋葉氏は指摘する。「幻覚リスクの低いモデルを組み合わせることで、強力な推論と信頼性を両立させることができ、ビジネス上の重要な課題に対処できるのです」。

研究から実用化へ

サカナAIは、開発者や企業がMulti-LLM AB-MCTSを実装することを可能にする、Apache 2.0ライセンスのオープンソース・フレームワーク、TreeQuestをリリースした。その柔軟なAPIは、多様なタスクのためのカスタムスコアリングとロジックをサポートしています。

「我々はまだAB-MCTSを具体的なビジネス課題のために模索中ですが、その可能性は明らかです」と秋葉氏は言う。

ARC-AGI-2ベンチマーク以外にも、AB-MCTSは複雑なコーディングや機械学習モデルの精度向上といったタスクで成功を収めている。

「AB-MCTSは、ソフトウェアのパフォーマンスメトリクスの最適化など、試行錯誤を繰り返すタスクを得意としています。「例えば、ウェブサービスの応答待ち時間を自動的に短縮することができます。

このオープンソースのツールは、新世代の堅牢で信頼性の高いエンタープライズAIアプリケーションを可能にするかもしれない。

関連記事

好業績のMicrosoftが人員削減を実施

マイクロソフト、戦略的な人員再編を発表マイクロソフトは、世界の従業員の約3%に相当する7,000人規模の人員削減を開始しました。重要な点として、これらの変更は財務的困難ではなく、戦略的優先事項を反映しています。同社はAI開発を加速させるため事業運営の合理化を進めており、管理層を削減しながら技術系人材の密度を高めています。再編は世界中の様々な部門に影響を与え、中間管理職および非技術部門が最も大きな影響を受けています。これは、テクノロジー企業が機動性と技術的アウトプットを最適化するという、業界全体の

好業績のMicrosoftが人員削減を実施

マイクロソフト、戦略的な人員再編を発表マイクロソフトは、世界の従業員の約3%に相当する7,000人規模の人員削減を開始しました。重要な点として、これらの変更は財務的困難ではなく、戦略的優先事項を反映しています。同社はAI開発を加速させるため事業運営の合理化を進めており、管理層を削減しながら技術系人材の密度を高めています。再編は世界中の様々な部門に影響を与え、中間管理職および非技術部門が最も大きな影響を受けています。これは、テクノロジー企業が機動性と技術的アウトプットを最適化するという、業界全体の

MIT、静的モデルを超える自己学習AIフレームワークを発表

MITの研究者が自己学習AIフレームワークを開発マサチューセッツ工科大学(MIT)の研究チームは、大規模な言語モデルの能力を自律的に進化させる、SEAL(Self-Adapting Language Models)と呼ばれる革新的なシステムを開発した。この画期的なシステムにより、AIシステムは独自のトレーニング教材と学習プロトコルを生成し、新しい知識とスキルの永続的な統合を可能にする。SEALは、

MIT、静的モデルを超える自己学習AIフレームワークを発表

MITの研究者が自己学習AIフレームワークを開発マサチューセッツ工科大学(MIT)の研究チームは、大規模な言語モデルの能力を自律的に進化させる、SEAL(Self-Adapting Language Models)と呼ばれる革新的なシステムを開発した。この画期的なシステムにより、AIシステムは独自のトレーニング教材と学習プロトコルを生成し、新しい知識とスキルの永続的な統合を可能にする。SEALは、

マルチバースAIが画期的な小型高性能モデルを発表

ヨーロッパの先駆的なAIスタートアップが、鳥や昆虫の脳にちなんで名付けられた画期的なマイクロサイズのAIモデルを発表し、強力な人工知能に大規模なスケールは必要ないことを実証した。Multiverse Computing社のイノベーションの中心は、エッジ・コンピューティング・アプリケーション向けに特別に設計された、超小型でありながら高性能なモデルである。ChickBrain」(32億パラメータ)と「

コメント (0)

0/200

マルチバースAIが画期的な小型高性能モデルを発表

ヨーロッパの先駆的なAIスタートアップが、鳥や昆虫の脳にちなんで名付けられた画期的なマイクロサイズのAIモデルを発表し、強力な人工知能に大規模なスケールは必要ないことを実証した。Multiverse Computing社のイノベーションの中心は、エッジ・コンピューティング・アプリケーション向けに特別に設計された、超小型でありながら高性能なモデルである。ChickBrain」(32億パラメータ)と「

コメント (0)

0/200

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。

企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロバイダーやモデルに依存するのではなく、さまざまなフロンティア・モデルの強みを動的に活用し、各タスク・セグメントに最適なAIを割り当てて、最適な成果を達成することができる。

集合知の活用

フロンティアAIのモデルは急速に進歩しており、それぞれがトレーニングデータと設計に基づいた明確な強みと弱みを持っている。あるモデルはコーディングで輝き、別のモデルは創作で輝くかもしれない。サカナAIのチームは、こうした違いを欠点ではなく資産として捉えている。

「私たちは、これらのユニークな能力を、集合知を構築するための貴重なツールとして考えています」と研究者たちはブログで述べている。研究者たちは、人間のチームが多様性によって飛躍的な進歩を遂げるように、AIシステムも協力することでより多くのことを達成できると主張している。"それぞれの強みを組み合わせることで、AIシステムは、単一のモデルでは克服できなかった課題を解決することができる"

推論のパフォーマンス向上

サカナAIのアルゴリズムは、「推論時スケーリング」手法(「テスト時スケーリング」とも呼ばれる)であり、AI研究で人気を集めている。より大きなモデルやデータセットに焦点を当てる「訓練時スケーリング」とは異なり、推論時スケーリングは、訓練後の計算リソースを最適化することで性能を高める。

一つの方法は、OpenAI o3やDeepSeek-R1のようなモデルに見られるように、強化学習を使用して、モデルに詳細な思考連鎖(CoT)シーケンスを生成するように促す。もうひとつのアプローチである反復サンプリングは、ブレーンストーミングのように、多様な解決策を生成するようモデルに何度も促す。サカナAIの手法は、これらのコンセプトを改良したものだ。

「サカナAIの研究科学者で論文の共著者である秋葉卓也氏は、VentureBeatのインタビューで、「我々のフレームワークは、Best-of-Nサンプリングを改良したものです。「強化学習による拡張CoTのような推論技術を強化します。探索アプローチと適切なLLMを戦略的に選択することで、限られた呼び出しの中でパフォーマンスを最適化し、複雑なタスクに優れています。"

適応分岐探索の機能

この技術の中核は、適応分岐モンテカルロ木探索(AB-MCTS)アルゴリズムである。AB-MCTSは、「より深く探索する」(有望な解を洗練する)ことと「より広く探索する」(新しい解を生成する)ことのバランスをとることで、LLMがインテリジェントな試行錯誤を行うことを可能にします。AB-MCTSはこれらのストラテジーをブレンドし、システムが必要に応じてアイデアを改良したり、新しいアイデアにピボットすることを可能にします。

これは、DeepMindのAlphaGoで使用されている意思決定アルゴリズムであるモンテカルロ木探索(MCTS)によって実現されている。AB-MCTSは確率モデルを採用し、各ステップで改良するか再開するかを決定する。

マルチLLM AB-MCTSはこれをさらに推し進め、「何を」行うか(精緻化か生成か)だけでなく、「どの」LLMを使用するかも決定する。最初はタスクに最適なモデルがわからないため、システムはLLMの組み合わせをテストし、時間の経過とともにどのLLMがより良いパフォーマンスを発揮するかを学習し、より多くの仕事を割り当てます。

AIチームのテスト

マルチLLM AB-MCTSシステムは、ARC-AGI-2ベンチマークで評価された。ARC-AGI-2は、AIにとって厳しい課題である新規の問題に対する人間のような視覚的推論をテストするベンチマークである。

チームは、o4-mini、Gemini 2.5 Pro、DeepSeek-R1などのフロンティアモデルを組み合わせた。

モデル集団は120のテスト問題の30%以上を解き、単一のモデルの性能をはるかに上回った。システムは、各タスクに最適なモデルを動的に割り当て、明確な解決パスが存在する場合には、最も効果的なLLMを迅速に特定しました。

驚くべきことに、このシステムは、これまで単一のモデルでは解決できなかった問題を解決した。ある例では、o4-miniの誤った解が、DeepSeek-R1とGemini-2.5 Proによって改良され、エラーが修正され、正しい解が得られました。

「これは、Multi-LLM AB-MCTSがフロンティアモデルを組み合わせることで、これまで解決できなかった課題に取り組むことができ、AI集合知の限界を拡大できることを示しています」と研究者らは述べている。

「各モデルの得意分野や幻覚傾向はさまざまです」と秋葉氏は指摘する。「幻覚リスクの低いモデルを組み合わせることで、強力な推論と信頼性を両立させることができ、ビジネス上の重要な課題に対処できるのです」。

研究から実用化へ

サカナAIは、開発者や企業がMulti-LLM AB-MCTSを実装することを可能にする、Apache 2.0ライセンスのオープンソース・フレームワーク、TreeQuestをリリースした。その柔軟なAPIは、多様なタスクのためのカスタムスコアリングとロジックをサポートしています。

「我々はまだAB-MCTSを具体的なビジネス課題のために模索中ですが、その可能性は明らかです」と秋葉氏は言う。

ARC-AGI-2ベンチマーク以外にも、AB-MCTSは複雑なコーディングや機械学習モデルの精度向上といったタスクで成功を収めている。

「AB-MCTSは、ソフトウェアのパフォーマンスメトリクスの最適化など、試行錯誤を繰り返すタスクを得意としています。「例えば、ウェブサービスの応答待ち時間を自動的に短縮することができます。

このオープンソースのツールは、新世代の堅牢で信頼性の高いエンタープライズAIアプリケーションを可能にするかもしれない。

MIT、静的モデルを超える自己学習AIフレームワークを発表

MITの研究者が自己学習AIフレームワークを開発マサチューセッツ工科大学(MIT)の研究チームは、大規模な言語モデルの能力を自律的に進化させる、SEAL(Self-Adapting Language Models)と呼ばれる革新的なシステムを開発した。この画期的なシステムにより、AIシステムは独自のトレーニング教材と学習プロトコルを生成し、新しい知識とスキルの永続的な統合を可能にする。SEALは、

MIT、静的モデルを超える自己学習AIフレームワークを発表

MITの研究者が自己学習AIフレームワークを開発マサチューセッツ工科大学(MIT)の研究チームは、大規模な言語モデルの能力を自律的に進化させる、SEAL(Self-Adapting Language Models)と呼ばれる革新的なシステムを開発した。この画期的なシステムにより、AIシステムは独自のトレーニング教材と学習プロトコルを生成し、新しい知識とスキルの永続的な統合を可能にする。SEALは、

マルチバースAIが画期的な小型高性能モデルを発表

ヨーロッパの先駆的なAIスタートアップが、鳥や昆虫の脳にちなんで名付けられた画期的なマイクロサイズのAIモデルを発表し、強力な人工知能に大規模なスケールは必要ないことを実証した。Multiverse Computing社のイノベーションの中心は、エッジ・コンピューティング・アプリケーション向けに特別に設計された、超小型でありながら高性能なモデルである。ChickBrain」(32億パラメータ)と「

マルチバースAIが画期的な小型高性能モデルを発表

ヨーロッパの先駆的なAIスタートアップが、鳥や昆虫の脳にちなんで名付けられた画期的なマイクロサイズのAIモデルを発表し、強力な人工知能に大規模なスケールは必要ないことを実証した。Multiverse Computing社のイノベーションの中心は、エッジ・コンピューティング・アプリケーション向けに特別に設計された、超小型でありながら高性能なモデルである。ChickBrain」(32億パラメータ)と「