TreeQuest от Sakana AI повышает производительность искусственного интеллекта благодаря совместной работе с несколькими моделями

Японская лаборатория искусственного интеллекта Sakana AI представила методику, позволяющую нескольким большим языковым моделям (LLM) работать вместе, образуя высокоэффективную команду ИИ. Этот метод, получивший название Multi-LLM AB-MCTS, позволяет моделям работать методом проб и ошибок, используя свои уникальные преимущества для решения сложных задач, недоступных для одной модели.

Для предприятий такой подход дает возможность создавать более мощные системы ИИ. Вместо того чтобы полагаться на одного поставщика или одну модель, компании могут динамически использовать сильные стороны различных пограничных моделей, назначая лучший ИИ для каждого сегмента задач, чтобы достичь оптимальных результатов.

Использование коллективного интеллекта

Передовые модели ИИ быстро развиваются, каждая из них имеет свои сильные и слабые стороны, основанные на обучающих данных и дизайне. Одна модель может быть блестящей в кодировании, другая - в творческом письме. Команда Sakana AI рассматривает эти различия как достоинства, а не недостатки.

"Мы рассматриваем эти уникальные возможности как ценные инструменты для создания коллективного интеллекта", - пишут исследователи в своем блоге. Они утверждают, что, подобно человеческим командам, добивающимся прорывов благодаря разнообразию, системы ИИ могут добиться большего, сотрудничая друг с другом. "Объединяя свои сильные стороны, системы ИИ могут решать задачи, с которыми не справится ни одна модель".

Повышение производительности в области умозаключений

Алгоритм Sakana AI - техника "масштабирования во время вывода" (также называемая "масштабированием во время тестирования") - набирает обороты в исследованиях ИИ. В отличие от "масштабирования во время обучения", которое сосредоточено на больших моделях и наборах данных, масштабирование во время вывода повышает производительность за счет оптимизации вычислительных ресурсов после обучения.

Один из методов использует обучение с подкреплением, побуждая модели создавать подробные последовательности цепочек мыслей (CoT), как это показано в таких моделях, как OpenAI o3 и DeepSeek-R1. Другой подход, повторная выборка, побуждает модель многократно генерировать различные решения, что напоминает мозговой штурм. Метод Sakana AI совершенствует эти концепции.

"Наша система улучшает выборку Best-of-N", - сказал Такуя Акиба, научный сотрудник Sakana AI и соавтор статьи, в интервью VentureBeat. "Она улучшает такие методы рассуждений, как расширенный CoT, с помощью обучения с подкреплением. Стратегически выбирая подход к поиску и правильный LLM, он оптимизирует производительность в рамках ограниченных вызовов, добиваясь превосходства в сложных задачах".

Принцип работы адаптивного ветвящегося поиска

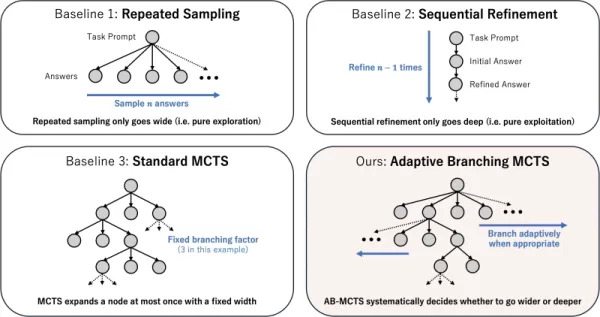

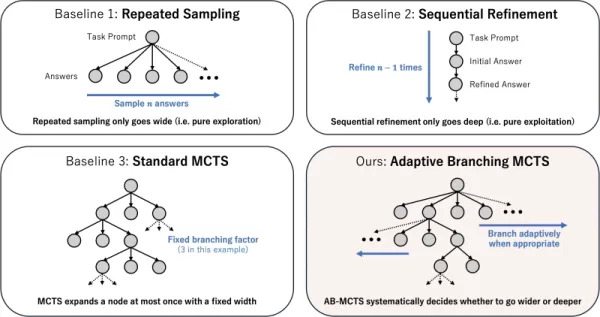

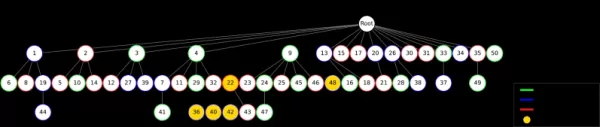

В основе технологии лежит алгоритм Adaptive Branching Monte Carlo Tree Search (AB-MCTS). Он позволяет LLM выполнять интеллектуальный метод проб и ошибок, балансируя между "поиском в глубину" (уточнение перспективного решения) и "поиском в ширину" (генерация новых решений). AB-MCTS сочетает эти стратегии, позволяя системе уточнять идеи или переходить к новым, когда это необходимо.

Для этого используется Monte Carlo Tree Search (MCTS), алгоритм принятия решений, применяемый в игре AlphaGo компании DeepMind. AB-MCTS использует вероятностные модели для принятия решения о необходимости доработки или перезапуска на каждом шаге.

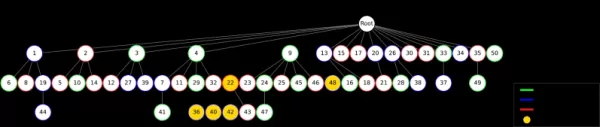

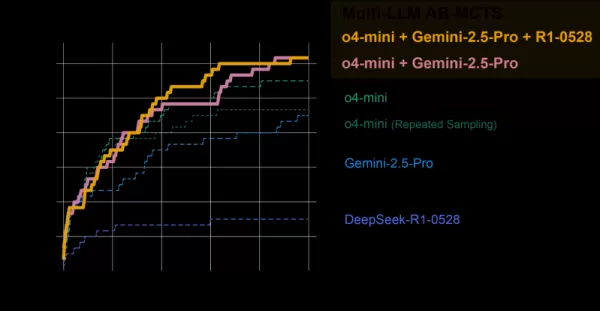

Различные стратегии масштабирования времени тестирования Источник: Sakana AI Мульти-LLM AB-MCTS идет дальше, решая не только "что" делать (уточнять или генерировать), но и "какой" LLM использовать. Изначально не зная, какая модель лучше всего подходит для решения задачи, система тестирует несколько LLM, со временем выясняя, какие из них работают лучше, и поручая им больше работы.

Тестирование команды ИИ

Система Multi-LLM AB-MCTS была оценена на эталоне ARC-AGI-2, который проверяет визуальное мышление человека при решении новых задач, что является сложной задачей для ИИ.

Команда объединила такие передовые модели, как o4-mini, Gemini 2.5 Pro и DeepSeek-R1.

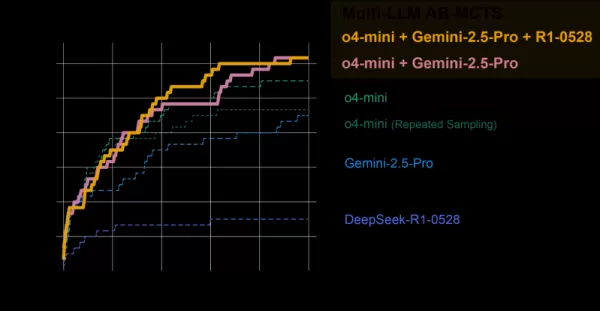

Коллективная модель решила более 30 % из 120 тестовых задач, значительно превзойдя показатели любой отдельной модели. Система динамически назначала лучшую модель для каждой задачи, быстро определяя наиболее эффективный LLM, когда существовал четкий путь решения.

AB-MCTS в сравнении с отдельными моделями Источник: Sakana AI Примечательно, что система решала задачи, которые ранее не могли быть решены ни одной отдельной моделью. В одном случае неправильное решение, полученное от o4-mini, было доработано DeepSeek-R1 и Gemini-2.5 Pro, которые исправили ошибку и выдали правильный ответ.

"Это показывает, что Multi-LLM AB-MCTS может объединять пограничные модели для решения ранее неразрешимых задач, расширяя границы коллективного интеллекта ИИ", - заявляют исследователи.

AB-MTCS может выбирать различные модели на разных этапах решения задачи Источник: Sakana AI "Сильные стороны каждой модели и ее склонность к галлюцинациям различны", - отмечает Акиба. "Соединяя модели с меньшим риском галлюцинаций, мы можем добиться как мощного рассуждения, так и надежности, решая ключевую проблему бизнеса".

От исследований к практическому применению

Компания Sakana AI выпустила TreeQuest, фреймворк с открытым исходным кодом под лицензией Apache 2.0, позволяющий разработчикам и компаниям внедрять Multi-LLM AB-MCTS. Его гибкий API поддерживает пользовательский скоринг и логику для различных задач.

"Мы все еще изучаем AB-MCTS для решения конкретных бизнес-задач, но его потенциал очевиден", - говорит Акиба.

Помимо эталона ARC-AGI-2, AB-MCTS успешно справляется с такими задачами, как сложное кодирование и повышение точности моделей машинного обучения.

"AB-MCTS отлично справляется с итеративными задачами методом проб и ошибок, такими как оптимизация показателей производительности программного обеспечения", - добавил Акиба. "Например, он может автоматически сократить время ожидания ответа веб-сервиса".

Этот инструмент с открытым исходным кодом может обеспечить создание нового поколения надежных и прочных корпоративных приложений ИИ.

Связанная статья

Microsoft сокращает штат на фоне высоких финансовых показателей

Microsoft объявляет о стратегической реорганизации персоналаMicrosoft начала сокращение штата, затрагивающее около 7 000 сотрудников, что составляет 3% от глобального персонала. Важно отметить, что эти изменения отражают стратегические приоритеты, а

Microsoft сокращает штат на фоне высоких финансовых показателей

Microsoft объявляет о стратегической реорганизации персоналаMicrosoft начала сокращение штата, затрагивающее около 7 000 сотрудников, что составляет 3% от глобального персонала. Важно отметить, что эти изменения отражают стратегические приоритеты, а

MIT представила самообучающуюся систему ИИ, которая выходит за рамки статичных моделей

Исследователи Массачусетского технологического института разработали самообучающуюся систему искусственного интеллектаГруппа исследователей из Массачусетского технологического института разработала ин

MIT представила самообучающуюся систему ИИ, которая выходит за рамки статичных моделей

Исследователи Массачусетского технологического института разработали самообучающуюся систему искусственного интеллектаГруппа исследователей из Массачусетского технологического института разработала ин

Multiverse AI запускает новые миниатюрные высокопроизводительные модели

Новаторский европейский ИИ-стартап представил революционные микроразмерные модели ИИ, названные в честь мозга птиц и насекомых, демонстрируя, что мощный искусственный интеллект не требует огромных мас

Комментарии (0)

Multiverse AI запускает новые миниатюрные высокопроизводительные модели

Новаторский европейский ИИ-стартап представил революционные микроразмерные модели ИИ, названные в честь мозга птиц и насекомых, демонстрируя, что мощный искусственный интеллект не требует огромных мас

Комментарии (0)

Японская лаборатория искусственного интеллекта Sakana AI представила методику, позволяющую нескольким большим языковым моделям (LLM) работать вместе, образуя высокоэффективную команду ИИ. Этот метод, получивший название Multi-LLM AB-MCTS, позволяет моделям работать методом проб и ошибок, используя свои уникальные преимущества для решения сложных задач, недоступных для одной модели.

Для предприятий такой подход дает возможность создавать более мощные системы ИИ. Вместо того чтобы полагаться на одного поставщика или одну модель, компании могут динамически использовать сильные стороны различных пограничных моделей, назначая лучший ИИ для каждого сегмента задач, чтобы достичь оптимальных результатов.

Использование коллективного интеллекта

Передовые модели ИИ быстро развиваются, каждая из них имеет свои сильные и слабые стороны, основанные на обучающих данных и дизайне. Одна модель может быть блестящей в кодировании, другая - в творческом письме. Команда Sakana AI рассматривает эти различия как достоинства, а не недостатки.

"Мы рассматриваем эти уникальные возможности как ценные инструменты для создания коллективного интеллекта", - пишут исследователи в своем блоге. Они утверждают, что, подобно человеческим командам, добивающимся прорывов благодаря разнообразию, системы ИИ могут добиться большего, сотрудничая друг с другом. "Объединяя свои сильные стороны, системы ИИ могут решать задачи, с которыми не справится ни одна модель".

Повышение производительности в области умозаключений

Алгоритм Sakana AI - техника "масштабирования во время вывода" (также называемая "масштабированием во время тестирования") - набирает обороты в исследованиях ИИ. В отличие от "масштабирования во время обучения", которое сосредоточено на больших моделях и наборах данных, масштабирование во время вывода повышает производительность за счет оптимизации вычислительных ресурсов после обучения.

Один из методов использует обучение с подкреплением, побуждая модели создавать подробные последовательности цепочек мыслей (CoT), как это показано в таких моделях, как OpenAI o3 и DeepSeek-R1. Другой подход, повторная выборка, побуждает модель многократно генерировать различные решения, что напоминает мозговой штурм. Метод Sakana AI совершенствует эти концепции.

"Наша система улучшает выборку Best-of-N", - сказал Такуя Акиба, научный сотрудник Sakana AI и соавтор статьи, в интервью VentureBeat. "Она улучшает такие методы рассуждений, как расширенный CoT, с помощью обучения с подкреплением. Стратегически выбирая подход к поиску и правильный LLM, он оптимизирует производительность в рамках ограниченных вызовов, добиваясь превосходства в сложных задачах".

Принцип работы адаптивного ветвящегося поиска

В основе технологии лежит алгоритм Adaptive Branching Monte Carlo Tree Search (AB-MCTS). Он позволяет LLM выполнять интеллектуальный метод проб и ошибок, балансируя между "поиском в глубину" (уточнение перспективного решения) и "поиском в ширину" (генерация новых решений). AB-MCTS сочетает эти стратегии, позволяя системе уточнять идеи или переходить к новым, когда это необходимо.

Для этого используется Monte Carlo Tree Search (MCTS), алгоритм принятия решений, применяемый в игре AlphaGo компании DeepMind. AB-MCTS использует вероятностные модели для принятия решения о необходимости доработки или перезапуска на каждом шаге.

Мульти-LLM AB-MCTS идет дальше, решая не только "что" делать (уточнять или генерировать), но и "какой" LLM использовать. Изначально не зная, какая модель лучше всего подходит для решения задачи, система тестирует несколько LLM, со временем выясняя, какие из них работают лучше, и поручая им больше работы.

Тестирование команды ИИ

Система Multi-LLM AB-MCTS была оценена на эталоне ARC-AGI-2, который проверяет визуальное мышление человека при решении новых задач, что является сложной задачей для ИИ.

Команда объединила такие передовые модели, как o4-mini, Gemini 2.5 Pro и DeepSeek-R1.

Коллективная модель решила более 30 % из 120 тестовых задач, значительно превзойдя показатели любой отдельной модели. Система динамически назначала лучшую модель для каждой задачи, быстро определяя наиболее эффективный LLM, когда существовал четкий путь решения.

Примечательно, что система решала задачи, которые ранее не могли быть решены ни одной отдельной моделью. В одном случае неправильное решение, полученное от o4-mini, было доработано DeepSeek-R1 и Gemini-2.5 Pro, которые исправили ошибку и выдали правильный ответ.

"Это показывает, что Multi-LLM AB-MCTS может объединять пограничные модели для решения ранее неразрешимых задач, расширяя границы коллективного интеллекта ИИ", - заявляют исследователи.

"Сильные стороны каждой модели и ее склонность к галлюцинациям различны", - отмечает Акиба. "Соединяя модели с меньшим риском галлюцинаций, мы можем добиться как мощного рассуждения, так и надежности, решая ключевую проблему бизнеса".

От исследований к практическому применению

Компания Sakana AI выпустила TreeQuest, фреймворк с открытым исходным кодом под лицензией Apache 2.0, позволяющий разработчикам и компаниям внедрять Multi-LLM AB-MCTS. Его гибкий API поддерживает пользовательский скоринг и логику для различных задач.

"Мы все еще изучаем AB-MCTS для решения конкретных бизнес-задач, но его потенциал очевиден", - говорит Акиба.

Помимо эталона ARC-AGI-2, AB-MCTS успешно справляется с такими задачами, как сложное кодирование и повышение точности моделей машинного обучения.

"AB-MCTS отлично справляется с итеративными задачами методом проб и ошибок, такими как оптимизация показателей производительности программного обеспечения", - добавил Акиба. "Например, он может автоматически сократить время ожидания ответа веб-сервиса".

Этот инструмент с открытым исходным кодом может обеспечить создание нового поколения надежных и прочных корпоративных приложений ИИ.

MIT представила самообучающуюся систему ИИ, которая выходит за рамки статичных моделей

Исследователи Массачусетского технологического института разработали самообучающуюся систему искусственного интеллектаГруппа исследователей из Массачусетского технологического института разработала ин

MIT представила самообучающуюся систему ИИ, которая выходит за рамки статичных моделей

Исследователи Массачусетского технологического института разработали самообучающуюся систему искусственного интеллектаГруппа исследователей из Массачусетского технологического института разработала ин

Multiverse AI запускает новые миниатюрные высокопроизводительные модели

Новаторский европейский ИИ-стартап представил революционные микроразмерные модели ИИ, названные в честь мозга птиц и насекомых, демонстрируя, что мощный искусственный интеллект не требует огромных мас

Multiverse AI запускает новые миниатюрные высокопроизводительные модели

Новаторский европейский ИИ-стартап представил революционные микроразмерные модели ИИ, названные в честь мозга птиц и насекомых, демонстрируя, что мощный искусственный интеллект не требует огромных мас