TreeQuest de Sakana AI mejora el rendimiento de la IA con la colaboración entre varios modelos

El laboratorio japonés de IA Sakana AI ha presentado una técnica que permite a varios modelos lingüísticos de gran tamaño (LLM) trabajar juntos y formar un equipo de IA muy eficaz. Con el nombre de Multi-LLM AB-MCTS, este método permite a los modelos participar en el método de ensayo y error, aprovechando sus puntos fuertes únicos para abordar tareas complejas que están fuera del alcance de un solo modelo.

Para las empresas, este enfoque ofrece una forma de construir sistemas de IA más potentes. En lugar de depender de un único proveedor o modelo, las empresas pueden aprovechar dinámicamente los puntos fuertes de varios modelos de frontera, asignando la mejor IA a cada segmento de tareas para lograr resultados óptimos.

Aprovechar la inteligencia colectiva

Los modelos de IA de frontera avanzan rápidamente, cada uno con puntos fuertes y débiles distintos basados en sus datos de formación y su diseño. Un modelo puede brillar en codificación, otro en escritura creativa. El equipo de Sakana AI ve estas diferencias como ventajas, no como defectos.

"Consideramos estas capacidades únicas como herramientas valiosas para construir inteligencia colectiva", señalan los investigadores en su blog. Argumentan que, al igual que los equipos humanos logran grandes avances gracias a la diversidad, los sistemas de IA pueden conseguir más colaborando. "Combinando sus puntos fuertes, los sistemas de IA pueden resolver retos que ningún modelo podría superar por sí solo".

Mejorar el rendimiento en la inferencia

El algoritmo de Sakana AI, una técnica de "escalado en tiempo de inferencia" (también llamado "escalado en tiempo de prueba"), está ganando terreno en la investigación de la IA. A diferencia del "escalado en tiempo de entrenamiento", que se centra en modelos y conjuntos de datos más grandes, el escalado en tiempo de inferencia aumenta el rendimiento optimizando los recursos informáticos tras el entrenamiento.

Un método utiliza el aprendizaje por refuerzo para animar a los modelos a producir secuencias detalladas de cadena de pensamiento (CoT), como se ha visto en modelos como OpenAI o3 y DeepSeek-R1. Otro método, el muestreo repetido, pide al modelo que genere varias soluciones, algo parecido a una lluvia de ideas. El método de Sakana AI refina estos conceptos.

"Nuestro marco mejora el muestreo Best-of-N", explica Takuya Akiba, investigador científico de Sakana AI y coautor del artículo, en una entrevista concedida a VentureBeat. "Mejora técnicas de razonamiento como el CoT ampliado a través del aprendizaje por refuerzo. Al elegir estratégicamente el enfoque de búsqueda y el LLM adecuado, optimiza el rendimiento dentro de unas llamadas limitadas, destacando en tareas complejas."

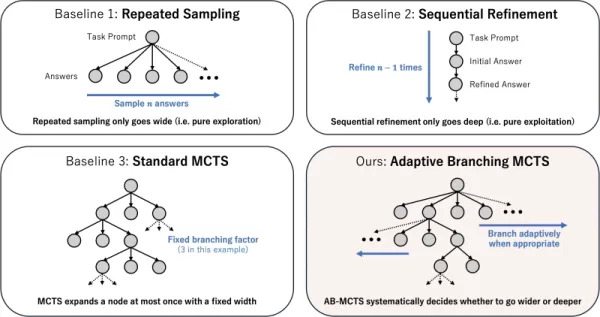

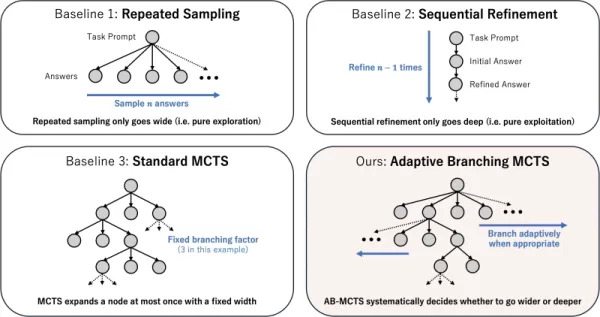

Funcionamiento de la búsqueda adaptativa por ramas

El núcleo de la técnica es el algoritmo AB-MCTS (Adaptive Branching Monte Carlo Tree Search). Este algoritmo permite a los LLM llevar a cabo un proceso inteligente de prueba y error, equilibrando la "búsqueda más profunda" (refinando una solución prometedora) y la "búsqueda más amplia" (generando nuevas soluciones). AB-MCTS combina estas estrategias, lo que permite al sistema refinar ideas o pivotar hacia otras nuevas cuando es necesario.

Para ello utiliza el algoritmo Monte Carlo Tree Search (MCTS), un algoritmo de toma de decisiones utilizado en AlphaGo de DeepMind. AB-MCTS emplea modelos de probabilidad para decidir si refinar o reiniciar en cada paso.

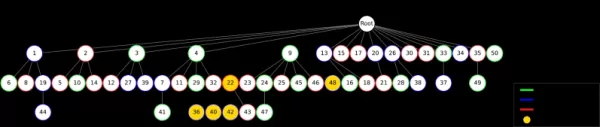

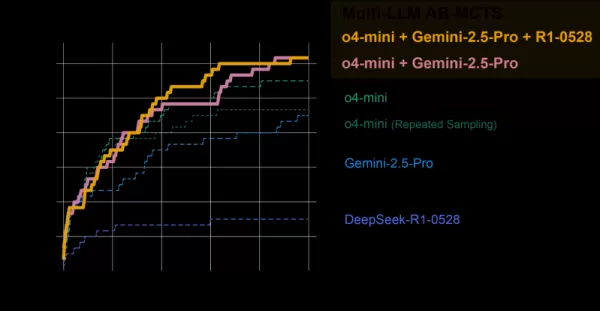

Diferentes estrategias de escalado del tiempo de prueba Fuente: Sakana AI Multi-LLM AB-MCTS va más allá al decidir no solo "qué" hacer (refinar o generar), sino también "qué" LLM utilizar. Al principio, el sistema desconoce cuál es el mejor modelo para una tarea, por lo que prueba una combinación de LLM y, con el tiempo, aprende cuáles funcionan mejor y les asigna más trabajo.

Pruebas del equipo de IA

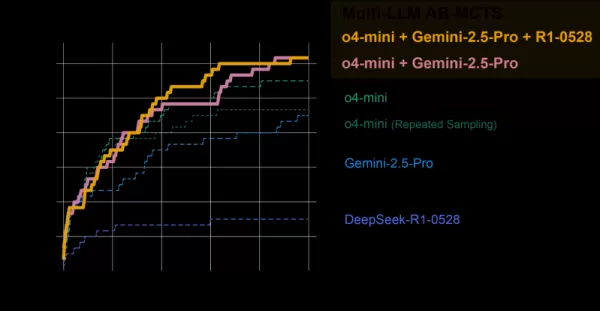

El sistema Multi-LLM AB-MCTS se evaluó en la prueba de referencia ARC-AGI-2, que pone a prueba el razonamiento visual de tipo humano en problemas novedosos, un duro reto para la IA.

El equipo combinó modelos de vanguardia como o4-mini, Gemini 2.5 Pro y DeepSeek-R1.

El modelo colectivo resolvió más del 30% de los 120 problemas de prueba, superando con creces el rendimiento de cualquier modelo individual. El sistema asignó dinámicamente el mejor modelo para cada tarea, identificando rápidamente el LLM más eficaz cuando existía una ruta de solución clara.

AB-MCTS frente a modelos individuales Fuente: Sakana AI Sorprendentemente, el sistema resolvió problemas que antes eran irresolubles para un solo modelo. En un caso, una solución incorrecta de o4-mini fue refinada por DeepSeek-R1 y Gemini-2.5 Pro, que corrigieron el error y dieron la respuesta correcta.

"Esto demuestra que Multi-LLM AB-MCTS puede combinar modelos de frontera para abordar retos que antes eran irresolubles, ampliando los límites de la inteligencia colectiva de IA", afirman los investigadores.

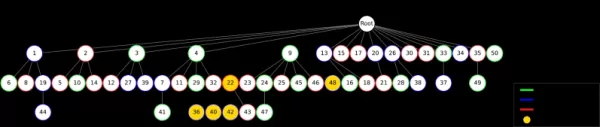

AB-MTCS puede seleccionar diferentes modelos en distintas fases de la resolución de un problema Fuente: Sakana AI "Los puntos fuertes y las tendencias de alucinación de cada modelo varían", señala Akiba. "Al emparejar modelos con menores riesgos de alucinación, podemos lograr tanto un razonamiento potente como fiabilidad, abordando una preocupación empresarial clave".

De la investigación al uso práctico

Sakana AI ha lanzado TreeQuest, un framework de código abierto bajo licencia Apache 2.0, que permite a desarrolladores y empresas implementar Multi-LLM AB-MCTS. Su flexible API permite personalizar la puntuación y la lógica para diversas tareas.

"Todavía estamos explorando AB-MCTS para retos empresariales específicos, pero su potencial es evidente", afirma Akiba.

Además de la prueba ARC-AGI-2, AB-MCTS ha tenido éxito en tareas como la codificación compleja y la mejora de la precisión de los modelos de aprendizaje automático.

"AB-MCTS destaca en tareas iterativas de ensayo y error, como la optimización de las métricas de rendimiento del software", añade Akiba. "Por ejemplo, podría reducir automáticamente la latencia de respuesta de los servicios web".

Esta herramienta de código abierto podría hacer posible una nueva generación de aplicaciones empresariales de IA robustas y fiables.

Artículo relacionado

Microsoft reduce su plantilla pese a sus sólidos resultados financieros

Microsoft anuncia una reestructuración estratégica de su plantillaMicrosoft ha iniciado recortes de personal que afectan a aproximadamente 7.000 empleados, lo que representa el 3% de su plantilla global. Es importante destacar que estos cambios refle

Microsoft reduce su plantilla pese a sus sólidos resultados financieros

Microsoft anuncia una reestructuración estratégica de su plantillaMicrosoft ha iniciado recortes de personal que afectan a aproximadamente 7.000 empleados, lo que representa el 3% de su plantilla global. Es importante destacar que estos cambios refle

El MIT presenta un marco de inteligencia artificial de autoaprendizaje que va más allá de los modelos estáticos

Investigadores del MIT, pioneros en el autoaprendizaje de la IAUn equipo del MIT ha desarrollado un innovador sistema denominado SEAL (Self-Adapting Language Models) que permite a grandes modelos ling

El MIT presenta un marco de inteligencia artificial de autoaprendizaje que va más allá de los modelos estáticos

Investigadores del MIT, pioneros en el autoaprendizaje de la IAUn equipo del MIT ha desarrollado un innovador sistema denominado SEAL (Self-Adapting Language Models) que permite a grandes modelos ling

Multiverse AI lanza innovadores modelos en miniatura de alto rendimiento

Una empresa europea pionera en el campo de la inteligencia artificial ha presentado unos revolucionarios modelos de tamaño micro que llevan el nombre de cerebros de ave e insecto y demuestran que una

comentario (0)

0/200

Multiverse AI lanza innovadores modelos en miniatura de alto rendimiento

Una empresa europea pionera en el campo de la inteligencia artificial ha presentado unos revolucionarios modelos de tamaño micro que llevan el nombre de cerebros de ave e insecto y demuestran que una

comentario (0)

0/200

El laboratorio japonés de IA Sakana AI ha presentado una técnica que permite a varios modelos lingüísticos de gran tamaño (LLM) trabajar juntos y formar un equipo de IA muy eficaz. Con el nombre de Multi-LLM AB-MCTS, este método permite a los modelos participar en el método de ensayo y error, aprovechando sus puntos fuertes únicos para abordar tareas complejas que están fuera del alcance de un solo modelo.

Para las empresas, este enfoque ofrece una forma de construir sistemas de IA más potentes. En lugar de depender de un único proveedor o modelo, las empresas pueden aprovechar dinámicamente los puntos fuertes de varios modelos de frontera, asignando la mejor IA a cada segmento de tareas para lograr resultados óptimos.

Aprovechar la inteligencia colectiva

Los modelos de IA de frontera avanzan rápidamente, cada uno con puntos fuertes y débiles distintos basados en sus datos de formación y su diseño. Un modelo puede brillar en codificación, otro en escritura creativa. El equipo de Sakana AI ve estas diferencias como ventajas, no como defectos.

"Consideramos estas capacidades únicas como herramientas valiosas para construir inteligencia colectiva", señalan los investigadores en su blog. Argumentan que, al igual que los equipos humanos logran grandes avances gracias a la diversidad, los sistemas de IA pueden conseguir más colaborando. "Combinando sus puntos fuertes, los sistemas de IA pueden resolver retos que ningún modelo podría superar por sí solo".

Mejorar el rendimiento en la inferencia

El algoritmo de Sakana AI, una técnica de "escalado en tiempo de inferencia" (también llamado "escalado en tiempo de prueba"), está ganando terreno en la investigación de la IA. A diferencia del "escalado en tiempo de entrenamiento", que se centra en modelos y conjuntos de datos más grandes, el escalado en tiempo de inferencia aumenta el rendimiento optimizando los recursos informáticos tras el entrenamiento.

Un método utiliza el aprendizaje por refuerzo para animar a los modelos a producir secuencias detalladas de cadena de pensamiento (CoT), como se ha visto en modelos como OpenAI o3 y DeepSeek-R1. Otro método, el muestreo repetido, pide al modelo que genere varias soluciones, algo parecido a una lluvia de ideas. El método de Sakana AI refina estos conceptos.

"Nuestro marco mejora el muestreo Best-of-N", explica Takuya Akiba, investigador científico de Sakana AI y coautor del artículo, en una entrevista concedida a VentureBeat. "Mejora técnicas de razonamiento como el CoT ampliado a través del aprendizaje por refuerzo. Al elegir estratégicamente el enfoque de búsqueda y el LLM adecuado, optimiza el rendimiento dentro de unas llamadas limitadas, destacando en tareas complejas."

Funcionamiento de la búsqueda adaptativa por ramas

El núcleo de la técnica es el algoritmo AB-MCTS (Adaptive Branching Monte Carlo Tree Search). Este algoritmo permite a los LLM llevar a cabo un proceso inteligente de prueba y error, equilibrando la "búsqueda más profunda" (refinando una solución prometedora) y la "búsqueda más amplia" (generando nuevas soluciones). AB-MCTS combina estas estrategias, lo que permite al sistema refinar ideas o pivotar hacia otras nuevas cuando es necesario.

Para ello utiliza el algoritmo Monte Carlo Tree Search (MCTS), un algoritmo de toma de decisiones utilizado en AlphaGo de DeepMind. AB-MCTS emplea modelos de probabilidad para decidir si refinar o reiniciar en cada paso.

Multi-LLM AB-MCTS va más allá al decidir no solo "qué" hacer (refinar o generar), sino también "qué" LLM utilizar. Al principio, el sistema desconoce cuál es el mejor modelo para una tarea, por lo que prueba una combinación de LLM y, con el tiempo, aprende cuáles funcionan mejor y les asigna más trabajo.

Pruebas del equipo de IA

El sistema Multi-LLM AB-MCTS se evaluó en la prueba de referencia ARC-AGI-2, que pone a prueba el razonamiento visual de tipo humano en problemas novedosos, un duro reto para la IA.

El equipo combinó modelos de vanguardia como o4-mini, Gemini 2.5 Pro y DeepSeek-R1.

El modelo colectivo resolvió más del 30% de los 120 problemas de prueba, superando con creces el rendimiento de cualquier modelo individual. El sistema asignó dinámicamente el mejor modelo para cada tarea, identificando rápidamente el LLM más eficaz cuando existía una ruta de solución clara.

Sorprendentemente, el sistema resolvió problemas que antes eran irresolubles para un solo modelo. En un caso, una solución incorrecta de o4-mini fue refinada por DeepSeek-R1 y Gemini-2.5 Pro, que corrigieron el error y dieron la respuesta correcta.

"Esto demuestra que Multi-LLM AB-MCTS puede combinar modelos de frontera para abordar retos que antes eran irresolubles, ampliando los límites de la inteligencia colectiva de IA", afirman los investigadores.

"Los puntos fuertes y las tendencias de alucinación de cada modelo varían", señala Akiba. "Al emparejar modelos con menores riesgos de alucinación, podemos lograr tanto un razonamiento potente como fiabilidad, abordando una preocupación empresarial clave".

De la investigación al uso práctico

Sakana AI ha lanzado TreeQuest, un framework de código abierto bajo licencia Apache 2.0, que permite a desarrolladores y empresas implementar Multi-LLM AB-MCTS. Su flexible API permite personalizar la puntuación y la lógica para diversas tareas.

"Todavía estamos explorando AB-MCTS para retos empresariales específicos, pero su potencial es evidente", afirma Akiba.

Además de la prueba ARC-AGI-2, AB-MCTS ha tenido éxito en tareas como la codificación compleja y la mejora de la precisión de los modelos de aprendizaje automático.

"AB-MCTS destaca en tareas iterativas de ensayo y error, como la optimización de las métricas de rendimiento del software", añade Akiba. "Por ejemplo, podría reducir automáticamente la latencia de respuesta de los servicios web".

Esta herramienta de código abierto podría hacer posible una nueva generación de aplicaciones empresariales de IA robustas y fiables.

El MIT presenta un marco de inteligencia artificial de autoaprendizaje que va más allá de los modelos estáticos

Investigadores del MIT, pioneros en el autoaprendizaje de la IAUn equipo del MIT ha desarrollado un innovador sistema denominado SEAL (Self-Adapting Language Models) que permite a grandes modelos ling

El MIT presenta un marco de inteligencia artificial de autoaprendizaje que va más allá de los modelos estáticos

Investigadores del MIT, pioneros en el autoaprendizaje de la IAUn equipo del MIT ha desarrollado un innovador sistema denominado SEAL (Self-Adapting Language Models) que permite a grandes modelos ling

Multiverse AI lanza innovadores modelos en miniatura de alto rendimiento

Una empresa europea pionera en el campo de la inteligencia artificial ha presentado unos revolucionarios modelos de tamaño micro que llevan el nombre de cerebros de ave e insecto y demuestran que una

Multiverse AI lanza innovadores modelos en miniatura de alto rendimiento

Una empresa europea pionera en el campo de la inteligencia artificial ha presentado unos revolucionarios modelos de tamaño micro que llevan el nombre de cerebros de ave e insecto y demuestran que una