Sakana AI 的 TreeQuest 透過多模型協作提升 AI 效能

日本 AI 實驗室 Sakana AI 發表了一項技術,可讓多個大型語言模型 (LLM) 合作,組成一個高效率的 AI 團隊。此方法命名為 Multi-LLM AB-MCTS,可讓模型進行試誤,利用其獨特優勢來處理任何單一模型無法處理的複雜任務。

對於企業而言,這種方法提供了建立更強大人工智慧系統的方法。企業可以動態地利用各種前沿模型的優勢,為每個任務區段分配最佳的人工智能,以達到最佳結果,而不是依賴於一個提供商或模型。

利用集體智慧

前沿人工智能模型發展迅速,根據其訓練資料和設計,每個模型都有明顯的優點和缺點。一個模型可能在編碼方面大放異彩,另一個則在創意寫作方面大放異彩。Sakana AI 團隊將這些差異視為資產,而非缺點。

"研究人員在部落格中指出:「我們認為這些獨特的能力是建立集體智慧的寶貴工具。他們認為,就像人類團隊透過多樣性實現突破一樣,AI 系統也能透過合作完成更多工作。「透過結合他們的優勢,AI 系統可以解決單一模型無法克服的挑戰」。

增強推理性能

Sakana AI 的演算法是一種「推理時擴展」技術(也稱為「測試時擴展」),在 AI 研究領域正逐漸受到重視。與專注於更大模型和資料集的「訓練時擴展」不同,「推理時擴展」是透過優化訓練後的計算資源來提升效能。

其中一種方法是使用強化學習來鼓勵模型產生詳細的思考連鎖 (CoT) 序列,如 OpenAI o3 和 DeepSeek-R1 等模型。另一種方法是重複取樣,促使模型多次產生不同的解決方案,類似於腦力激盪。Sakana AI 的方法完善了這些概念。

"Sakana AI 研究員兼論文合著者 Takuya Akiba 在接受 VentureBeat 訪問時表示:「我們的框架改進了 Best-of-N 取樣。"它透過強化學習增強了推理技術,例如擴展的 CoT。通過策略性地選擇搜索方法和合適的 LLM,它能在有限的調用範圍內優化性能,在複雜的任務中脫穎而出。"

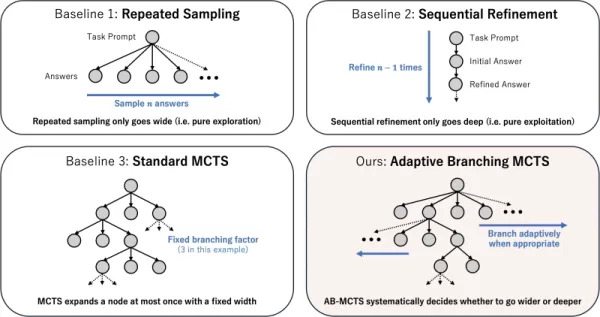

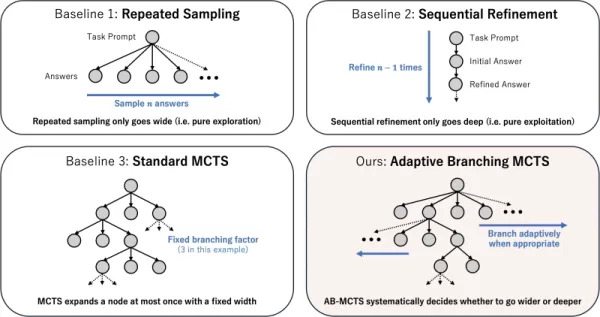

Adaptive Branching Search 如何發揮功能

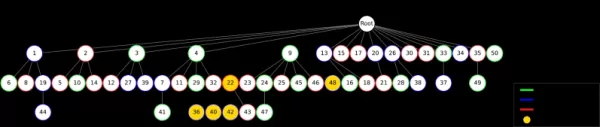

這項技術的核心是適應性分支蒙特卡洛樹搜尋 (AB-MCTS) 演算法。它使 LLM 能夠在 「深入搜尋」(完善有潛力的解決方案)和 「廣泛搜尋」(產生新解決方案)之間取得平衡,從而執行智慧型試誤。AB-MCTS 結合了這些策略,讓系統可以在需要時精煉想法或轉向新的想法。

這由 DeepMind 的 AlphaGo 所使用的決策演算法 Monte Carlo Tree Search (MCTS) 所提供。AB-MCTS 採用概率模型來決定每一步是精煉還是重新開始。

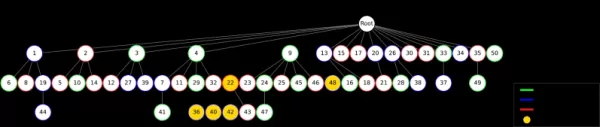

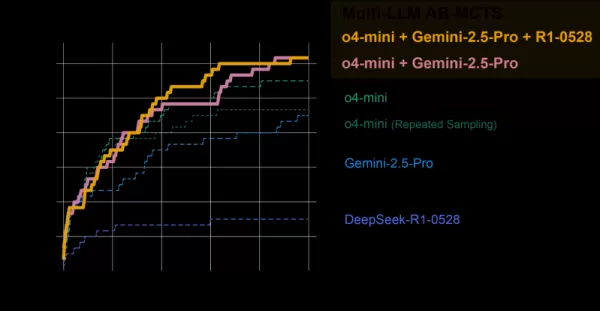

不同的測試時間縮放策略 資料來源:Sakana AISakana AI 多 LLM AB-MCTS 更進一步,不僅決定「做什麼」(精進或產生),還決定「使用哪個」LLM。一開始,系統不知道某項任務的最佳模型,因此會混合測試各種 LLM,隨著時間的推移,了解哪些 LLM 表現較佳,並為其分配更多工作。

測試 AI 團隊

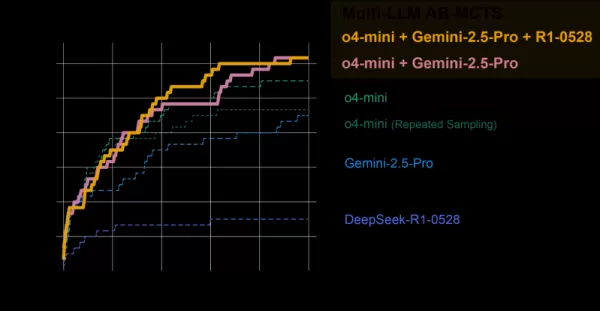

多 LLM AB-MCTS 系統在 ARC-AGI-2 基準上進行評估,該基準測試在新問題上類似於人類的視覺推理能力,對於 AI 來說是一項艱鉅的挑戰。

團隊結合了 o4-mini、Gemini 2.5 Pro 和 DeepSeek-R1 等前沿模型。

模型集體解決了 120 個測試問題中超過 30% 的問題,遠遠超過任何單一模型的表現。系統動態地為每個任務指派最佳模型,在存在明確的解決路徑時,快速找出最有效的 LLM。

AB-MCTS vs 個別模型 資料來源:Sakana AISakana AI 值得注意的是,系統解決了之前任何單一模型都無法解決的問題。在一個例子中,來自 o4-mini 的錯誤解決方案經 DeepSeek-R1 與 Gemini-2.5 Pro 改良後,糾正了錯誤並送出了正確的答案。

"研究人員表示:「這顯示 Multi-LLM AB-MCTS 可以結合前沿模型來解決之前無法解決的挑戰,擴大集體 AI 智慧的極限。

AB-MTCS 可以在解決問題的不同階段選擇不同的模型 資料來源:Sakana AISakana AI 「每個模型的優勢和幻覺傾向各不相同,」Akiba 指出。「通過搭配幻覺風險較低的模型,我們可以同時實現強大的推理能力和可靠性,解決企業關心的關鍵問題」。

從研究到實際應用

Sakana AI 發布了 Apache 2.0 授權下的開放源碼框架 TreeQuest,讓開發人員和企業能夠實現 Multi-LLM AB-MCTS。其彈性的 API 可支援各種不同任務的客製化評分與邏輯。

"Akiba 表示:「我們仍在探索 AB-MCTS 以應對特定的商業挑戰,但其潛力顯而易見。

除了 ARC-AGI-2 基準之外,AB-MCTS 在複雜編碼和提高機器學習模型準確性等任務上也取得了成功。

「AB-MCTS在迭代試誤任務(如優化軟體性能指標)方面表現優異,」Akiba補充道。「例如,它可以自動降低網路服務的回應延遲」。

這款開放原始碼工具可實現新一代強大、可靠的企業級 AI 應用程式。

相關文章

微軟財務成績亮眼仍裁員

微軟宣布戰略性人力資源調整微軟已啟動影響約7,000名員工的裁員計劃,約佔其全球員工總數的3%。重要的是,這些變動反映的是戰略優先事項而非財務困難。該公司正透過精簡運營來加速人工智慧發展,在減少管理層級的同時提升技術人才密度。此次重組影響全球多個部門,其中中階管理層與非技術職能部門受衝擊最為顯著。這符合科技產業為提升敏捷性與技術產出而進行優化的整體趨勢。財務背景此決策正值微軟公布強勁季度表現,營收達700.7億美元——超出分析師預期。同時,公司承诺投入800億美元預算年度投資,主要用於擴展AI基

微軟財務成績亮眼仍裁員

微軟宣布戰略性人力資源調整微軟已啟動影響約7,000名員工的裁員計劃,約佔其全球員工總數的3%。重要的是,這些變動反映的是戰略優先事項而非財務困難。該公司正透過精簡運營來加速人工智慧發展,在減少管理層級的同時提升技術人才密度。此次重組影響全球多個部門,其中中階管理層與非技術職能部門受衝擊最為顯著。這符合科技產業為提升敏捷性與技術產出而進行優化的整體趨勢。財務背景此決策正值微軟公布強勁季度表現,營收達700.7億美元——超出分析師預期。同時,公司承诺投入800億美元預算年度投資,主要用於擴展AI基

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

評論 (0)

0/200

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

評論 (0)

0/200

日本 AI 實驗室 Sakana AI 發表了一項技術,可讓多個大型語言模型 (LLM) 合作,組成一個高效率的 AI 團隊。此方法命名為 Multi-LLM AB-MCTS,可讓模型進行試誤,利用其獨特優勢來處理任何單一模型無法處理的複雜任務。

對於企業而言,這種方法提供了建立更強大人工智慧系統的方法。企業可以動態地利用各種前沿模型的優勢,為每個任務區段分配最佳的人工智能,以達到最佳結果,而不是依賴於一個提供商或模型。

利用集體智慧

前沿人工智能模型發展迅速,根據其訓練資料和設計,每個模型都有明顯的優點和缺點。一個模型可能在編碼方面大放異彩,另一個則在創意寫作方面大放異彩。Sakana AI 團隊將這些差異視為資產,而非缺點。

"研究人員在部落格中指出:「我們認為這些獨特的能力是建立集體智慧的寶貴工具。他們認為,就像人類團隊透過多樣性實現突破一樣,AI 系統也能透過合作完成更多工作。「透過結合他們的優勢,AI 系統可以解決單一模型無法克服的挑戰」。

增強推理性能

Sakana AI 的演算法是一種「推理時擴展」技術(也稱為「測試時擴展」),在 AI 研究領域正逐漸受到重視。與專注於更大模型和資料集的「訓練時擴展」不同,「推理時擴展」是透過優化訓練後的計算資源來提升效能。

其中一種方法是使用強化學習來鼓勵模型產生詳細的思考連鎖 (CoT) 序列,如 OpenAI o3 和 DeepSeek-R1 等模型。另一種方法是重複取樣,促使模型多次產生不同的解決方案,類似於腦力激盪。Sakana AI 的方法完善了這些概念。

"Sakana AI 研究員兼論文合著者 Takuya Akiba 在接受 VentureBeat 訪問時表示:「我們的框架改進了 Best-of-N 取樣。"它透過強化學習增強了推理技術,例如擴展的 CoT。通過策略性地選擇搜索方法和合適的 LLM,它能在有限的調用範圍內優化性能,在複雜的任務中脫穎而出。"

Adaptive Branching Search 如何發揮功能

這項技術的核心是適應性分支蒙特卡洛樹搜尋 (AB-MCTS) 演算法。它使 LLM 能夠在 「深入搜尋」(完善有潛力的解決方案)和 「廣泛搜尋」(產生新解決方案)之間取得平衡,從而執行智慧型試誤。AB-MCTS 結合了這些策略,讓系統可以在需要時精煉想法或轉向新的想法。

這由 DeepMind 的 AlphaGo 所使用的決策演算法 Monte Carlo Tree Search (MCTS) 所提供。AB-MCTS 採用概率模型來決定每一步是精煉還是重新開始。

多 LLM AB-MCTS 更進一步,不僅決定「做什麼」(精進或產生),還決定「使用哪個」LLM。一開始,系統不知道某項任務的最佳模型,因此會混合測試各種 LLM,隨著時間的推移,了解哪些 LLM 表現較佳,並為其分配更多工作。

測試 AI 團隊

多 LLM AB-MCTS 系統在 ARC-AGI-2 基準上進行評估,該基準測試在新問題上類似於人類的視覺推理能力,對於 AI 來說是一項艱鉅的挑戰。

團隊結合了 o4-mini、Gemini 2.5 Pro 和 DeepSeek-R1 等前沿模型。

模型集體解決了 120 個測試問題中超過 30% 的問題,遠遠超過任何單一模型的表現。系統動態地為每個任務指派最佳模型,在存在明確的解決路徑時,快速找出最有效的 LLM。

值得注意的是,系統解決了之前任何單一模型都無法解決的問題。在一個例子中,來自 o4-mini 的錯誤解決方案經 DeepSeek-R1 與 Gemini-2.5 Pro 改良後,糾正了錯誤並送出了正確的答案。

"研究人員表示:「這顯示 Multi-LLM AB-MCTS 可以結合前沿模型來解決之前無法解決的挑戰,擴大集體 AI 智慧的極限。

「每個模型的優勢和幻覺傾向各不相同,」Akiba 指出。「通過搭配幻覺風險較低的模型,我們可以同時實現強大的推理能力和可靠性,解決企業關心的關鍵問題」。

從研究到實際應用

Sakana AI 發布了 Apache 2.0 授權下的開放源碼框架 TreeQuest,讓開發人員和企業能夠實現 Multi-LLM AB-MCTS。其彈性的 API 可支援各種不同任務的客製化評分與邏輯。

"Akiba 表示:「我們仍在探索 AB-MCTS 以應對特定的商業挑戰,但其潛力顯而易見。

除了 ARC-AGI-2 基準之外,AB-MCTS 在複雜編碼和提高機器學習模型準確性等任務上也取得了成功。

「AB-MCTS在迭代試誤任務(如優化軟體性能指標)方面表現優異,」Akiba補充道。「例如,它可以自動降低網路服務的回應延遲」。

這款開放原始碼工具可實現新一代強大、可靠的企業級 AI 應用程式。

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román