TreeQuest von Sakana AI steigert die KI-Leistung durch Multi-Modell-Zusammenarbeit

Das japanische KI-Labor Sakana AI hat eine Technik vorgestellt, die es mehreren großen Sprachmodellen (LLMs) ermöglicht, zusammenzuarbeiten und ein hocheffizientes KI-Team zu bilden. Diese Methode mit dem Namen Multi-LLM AB-MCTS ermöglicht es den Modellen, sich im Trial-and-Error-Verfahren auszuprobieren und ihre einzigartigen Stärken zu nutzen, um komplexe Aufgaben zu bewältigen, die die Möglichkeiten eines einzelnen Modells übersteigen.

Für Unternehmen bietet dieser Ansatz eine Möglichkeit, leistungsfähigere KI-Systeme zu entwickeln. Anstatt sich auf einen einzigen Anbieter oder ein einziges Modell zu verlassen, können Unternehmen dynamisch die Stärken verschiedener Frontier-Modelle nutzen und die beste KI für jedes Aufgabensegment einsetzen, um optimale Ergebnisse zu erzielen.

Kollektive Intelligenz nutzbar machen

Frontier-KI-Modelle entwickeln sich schnell weiter, wobei jedes Modell aufgrund seiner Trainingsdaten und seines Designs unterschiedliche Stärken und Schwächen aufweist. Ein Modell kann im Programmieren glänzen, ein anderes im kreativen Schreiben. Das Team von Sakana AI betrachtet diese Unterschiede als Vorteile und nicht als Schwächen.

"Wir betrachten diese einzigartigen Fähigkeiten als wertvolle Werkzeuge für den Aufbau kollektiver Intelligenz", schreiben die Forscher in ihrem Blog. Sie argumentieren, dass KI-Systeme mehr erreichen können, wenn sie zusammenarbeiten, ähnlich wie menschliche Teams, die durch ihre Vielfalt Durchbrüche erzielen. "Indem sie ihre Stärken kombinieren, können KI-Systeme Herausforderungen lösen, die ein einzelnes Modell nicht bewältigen könnte.

Verbesserte Leistung bei der Inferenz

Der Algorithmus von Sakana AI, eine "Inferenzzeit-Skalierung" (auch "Testzeit-Skalierung" genannt), gewinnt in der KI-Forschung zunehmend an Bedeutung. Im Gegensatz zur "Skalierung zur Trainingszeit", die sich auf größere Modelle und Datensätze konzentriert, steigert die "Skalierung zur Inferenzzeit" die Leistung durch die Optimierung der Rechenressourcen nach dem Training.

Eine Methode nutzt das Verstärkungslernen, um Modelle zu ermutigen, detaillierte Gedankenketten (Chain-of-Thought, CoT) zu erzeugen, wie es bei Modellen wie OpenAI o3 und DeepSeek-R1 der Fall ist. Bei einem anderen Ansatz, dem wiederholten Sampling, wird das Modell mehrfach aufgefordert, verschiedene Lösungen zu generieren, ähnlich wie beim Brainstorming. Die Methode von Sakana AI verfeinert diese Konzepte.

"Unser Framework verbessert das Best-of-N-Sampling", sagte Takuya Akiba, ein KI-Forscher bei Sakana und Mitautor der Studie, in einem Interview mit VentureBeat. "Es verbessert Argumentationstechniken wie Extended CoT durch Reinforcement Learning. Durch die strategische Wahl des Suchansatzes und der richtigen LLM optimiert es die Leistung bei begrenzten Aufrufen und zeichnet sich bei komplexen Aufgaben aus."

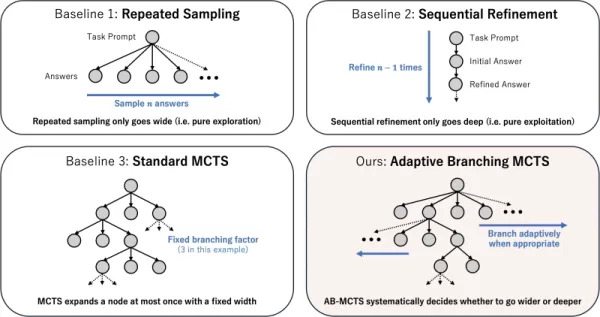

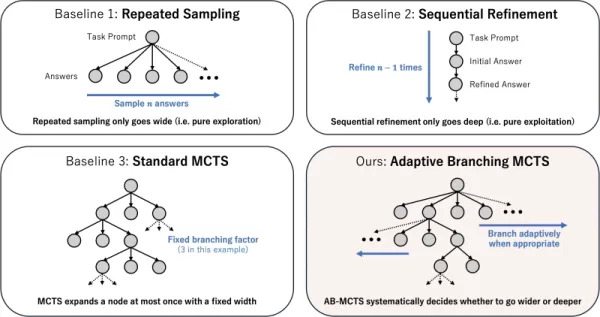

Wie Adaptive Branching Search funktioniert

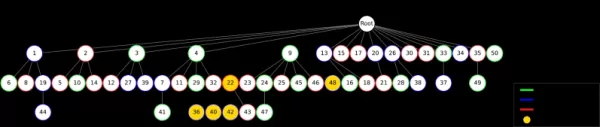

Das Herzstück der Technik ist der Algorithmus Adaptive Branching Monte Carlo Tree Search (AB-MCTS). Er versetzt LLMs in die Lage, intelligentes Trial-and-Error-Verfahren durchzuführen, indem er ein Gleichgewicht zwischen "tieferer Suche" (Verfeinerung einer vielversprechenden Lösung) und "breiterer Suche" (Generierung neuer Lösungen) schafft. AB-MCTS kombiniert diese Strategien und ermöglicht es dem System, Ideen zu verfeinern oder bei Bedarf auf neue Ideen umzuschwenken.

Die Grundlage dafür bildet die Monte-Carlo-Baumsuche (MCTS), ein Entscheidungsfindungsalgorithmus, der in DeepMinds AlphaGo verwendet wird. AB-MCTS verwendet Wahrscheinlichkeitsmodelle, um bei jedem Schritt zu entscheiden, ob verfeinert oder neu gestartet werden soll.

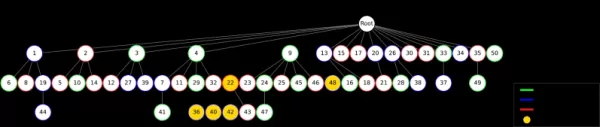

Verschiedene Strategien zur Skalierung der Testzeit Quelle: Sakana AI Multi-LLM AB-MCTS geht noch einen Schritt weiter, indem es nicht nur entscheidet, "was" zu tun ist (verfeinern oder generieren), sondern auch "welches" LLM zu verwenden ist. Da das System anfangs nicht weiß, welches Modell für eine Aufgabe am besten geeignet ist, testet es eine Mischung von LLMs und lernt mit der Zeit, welche besser funktionieren und weist ihnen mehr Arbeit zu.

Testen des KI-Teams

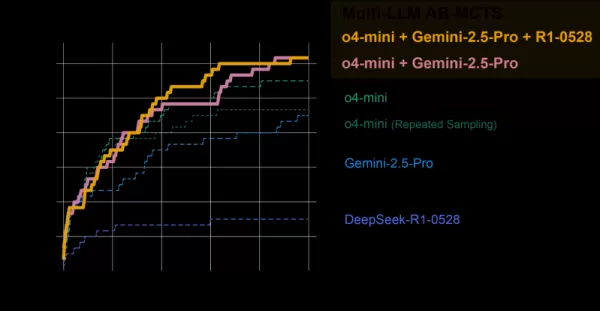

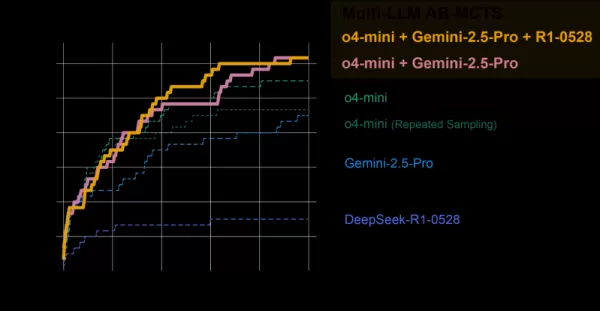

Das Multi-LLM AB-MCTS-System wurde anhand des ARC-AGI-2-Benchmark-Tests bewertet, der menschenähnliches visuelles Denken bei neuartigen Problemen testet - eine große Herausforderung für die KI.

Das Team kombinierte Spitzenmodelle wie o4-mini, Gemini 2.5 Pro und DeepSeek-R1.

Das Modellkollektiv löste über 30 % der 120 Testprobleme und übertraf damit die Leistung jedes einzelnen Modells bei weitem. Das System wies dynamisch das beste Modell für jede Aufgabe zu und identifizierte schnell das effektivste LLM, wenn ein klarer Lösungsweg bestand.

AB-MCTS im Vergleich zu einzelnen Modellen Quelle: Sakana AI Bemerkenswerterweise löste das System Probleme, die zuvor von einem einzelnen Modell nicht gelöst werden konnten. In einem Fall wurde eine falsche Lösung von o4-mini durch DeepSeek-R1 und Gemini-2.5 Pro verfeinert, was den Fehler korrigierte und die richtige Antwort lieferte.

"Dies zeigt, dass Multi-LLM AB-MCTS Grenzmodelle kombinieren kann, um zuvor unlösbare Herausforderungen zu bewältigen und die Grenzen der kollektiven KI-Intelligenz zu erweitern", so die Forscher.

AB-MTCS kann in verschiedenen Phasen der Problemlösung unterschiedliche Modelle auswählen Quelle: Sakana AI "Die Stärken und Halluzinationstendenzen der einzelnen Modelle sind unterschiedlich", so Akiba. "Indem wir Modelle mit geringerer Halluzinationstendenz kombinieren, können wir sowohl eine leistungsfähige Argumentation als auch eine hohe Zuverlässigkeit erreichen und damit ein wichtiges Geschäftsproblem angehen.

Von der Forschung zur praktischen Anwendung

Sakana AI hat TreeQuest veröffentlicht, ein Open-Source-Framework unter der Apache 2.0-Lizenz, das es Entwicklern und Unternehmen ermöglicht, Multi-LLM AB-MCTS zu implementieren. Seine flexible API unterstützt benutzerdefiniertes Scoring und Logik für verschiedene Aufgaben.

"Wir sind noch dabei, AB-MCTS für spezifische geschäftliche Herausforderungen zu erforschen, aber sein Potenzial ist klar", so Akiba.

Über den ARC-AGI-2-Benchmark hinaus ist AB-MCTS bei Aufgaben wie komplexer Codierung und der Verbesserung der Genauigkeit von Modellen des maschinellen Lernens erfolgreich.

"AB-MCTS zeichnet sich durch iterative Trial-and-Error-Aufgaben aus, wie etwa die Optimierung von Software-Performance-Metriken", so Akiba weiter. "Es könnte zum Beispiel automatisch die Antwortzeiten von Webservices reduzieren."

Dieses Open-Source-Tool könnte eine neue Generation von robusten, zuverlässigen KI-Anwendungen für Unternehmen ermöglichen.

Verwandter Artikel

Microsoft streicht Jobs trotz robuster Finanzergebnisse

Microsoft kündigt strategische Personalumstrukturierung anMicrosoft hat Personalabbau eingeleitet, von dem etwa 7.000 Mitarbeiter betroffen sind, was 3 % seiner weltweiten Belegschaft entspricht. Wichtig ist, dass diese Veränderungen strategische Pri

Microsoft streicht Jobs trotz robuster Finanzergebnisse

Microsoft kündigt strategische Personalumstrukturierung anMicrosoft hat Personalabbau eingeleitet, von dem etwa 7.000 Mitarbeiter betroffen sind, was 3 % seiner weltweiten Belegschaft entspricht. Wichtig ist, dass diese Veränderungen strategische Pri

MIT stellt selbstlernendes KI-Framework vor, das über statische Modelle hinausgeht

MIT-Forscher entwickeln selbstlernendes KI-SystemEin Team am MIT hat ein innovatives System namens SEAL (Self-Adapting Language Models) entwickelt, das große Sprachmodelle in die Lage versetzt, ihre F

MIT stellt selbstlernendes KI-Framework vor, das über statische Modelle hinausgeht

MIT-Forscher entwickeln selbstlernendes KI-SystemEin Team am MIT hat ein innovatives System namens SEAL (Self-Adapting Language Models) entwickelt, das große Sprachmodelle in die Lage versetzt, ihre F

Multiverse AI bringt bahnbrechende Miniatur-Hochleistungsmodelle auf den Markt

Ein bahnbrechendes europäisches KI-Startup hat bahnbrechende KI-Modelle in Mikrogröße vorgestellt, die nach Vogel- und Insektengehirnen benannt sind, und damit gezeigt, dass leistungsstarke künstliche

Kommentare (0)

0/200

Multiverse AI bringt bahnbrechende Miniatur-Hochleistungsmodelle auf den Markt

Ein bahnbrechendes europäisches KI-Startup hat bahnbrechende KI-Modelle in Mikrogröße vorgestellt, die nach Vogel- und Insektengehirnen benannt sind, und damit gezeigt, dass leistungsstarke künstliche

Kommentare (0)

0/200

Das japanische KI-Labor Sakana AI hat eine Technik vorgestellt, die es mehreren großen Sprachmodellen (LLMs) ermöglicht, zusammenzuarbeiten und ein hocheffizientes KI-Team zu bilden. Diese Methode mit dem Namen Multi-LLM AB-MCTS ermöglicht es den Modellen, sich im Trial-and-Error-Verfahren auszuprobieren und ihre einzigartigen Stärken zu nutzen, um komplexe Aufgaben zu bewältigen, die die Möglichkeiten eines einzelnen Modells übersteigen.

Für Unternehmen bietet dieser Ansatz eine Möglichkeit, leistungsfähigere KI-Systeme zu entwickeln. Anstatt sich auf einen einzigen Anbieter oder ein einziges Modell zu verlassen, können Unternehmen dynamisch die Stärken verschiedener Frontier-Modelle nutzen und die beste KI für jedes Aufgabensegment einsetzen, um optimale Ergebnisse zu erzielen.

Kollektive Intelligenz nutzbar machen

Frontier-KI-Modelle entwickeln sich schnell weiter, wobei jedes Modell aufgrund seiner Trainingsdaten und seines Designs unterschiedliche Stärken und Schwächen aufweist. Ein Modell kann im Programmieren glänzen, ein anderes im kreativen Schreiben. Das Team von Sakana AI betrachtet diese Unterschiede als Vorteile und nicht als Schwächen.

"Wir betrachten diese einzigartigen Fähigkeiten als wertvolle Werkzeuge für den Aufbau kollektiver Intelligenz", schreiben die Forscher in ihrem Blog. Sie argumentieren, dass KI-Systeme mehr erreichen können, wenn sie zusammenarbeiten, ähnlich wie menschliche Teams, die durch ihre Vielfalt Durchbrüche erzielen. "Indem sie ihre Stärken kombinieren, können KI-Systeme Herausforderungen lösen, die ein einzelnes Modell nicht bewältigen könnte.

Verbesserte Leistung bei der Inferenz

Der Algorithmus von Sakana AI, eine "Inferenzzeit-Skalierung" (auch "Testzeit-Skalierung" genannt), gewinnt in der KI-Forschung zunehmend an Bedeutung. Im Gegensatz zur "Skalierung zur Trainingszeit", die sich auf größere Modelle und Datensätze konzentriert, steigert die "Skalierung zur Inferenzzeit" die Leistung durch die Optimierung der Rechenressourcen nach dem Training.

Eine Methode nutzt das Verstärkungslernen, um Modelle zu ermutigen, detaillierte Gedankenketten (Chain-of-Thought, CoT) zu erzeugen, wie es bei Modellen wie OpenAI o3 und DeepSeek-R1 der Fall ist. Bei einem anderen Ansatz, dem wiederholten Sampling, wird das Modell mehrfach aufgefordert, verschiedene Lösungen zu generieren, ähnlich wie beim Brainstorming. Die Methode von Sakana AI verfeinert diese Konzepte.

"Unser Framework verbessert das Best-of-N-Sampling", sagte Takuya Akiba, ein KI-Forscher bei Sakana und Mitautor der Studie, in einem Interview mit VentureBeat. "Es verbessert Argumentationstechniken wie Extended CoT durch Reinforcement Learning. Durch die strategische Wahl des Suchansatzes und der richtigen LLM optimiert es die Leistung bei begrenzten Aufrufen und zeichnet sich bei komplexen Aufgaben aus."

Wie Adaptive Branching Search funktioniert

Das Herzstück der Technik ist der Algorithmus Adaptive Branching Monte Carlo Tree Search (AB-MCTS). Er versetzt LLMs in die Lage, intelligentes Trial-and-Error-Verfahren durchzuführen, indem er ein Gleichgewicht zwischen "tieferer Suche" (Verfeinerung einer vielversprechenden Lösung) und "breiterer Suche" (Generierung neuer Lösungen) schafft. AB-MCTS kombiniert diese Strategien und ermöglicht es dem System, Ideen zu verfeinern oder bei Bedarf auf neue Ideen umzuschwenken.

Die Grundlage dafür bildet die Monte-Carlo-Baumsuche (MCTS), ein Entscheidungsfindungsalgorithmus, der in DeepMinds AlphaGo verwendet wird. AB-MCTS verwendet Wahrscheinlichkeitsmodelle, um bei jedem Schritt zu entscheiden, ob verfeinert oder neu gestartet werden soll.

Multi-LLM AB-MCTS geht noch einen Schritt weiter, indem es nicht nur entscheidet, "was" zu tun ist (verfeinern oder generieren), sondern auch "welches" LLM zu verwenden ist. Da das System anfangs nicht weiß, welches Modell für eine Aufgabe am besten geeignet ist, testet es eine Mischung von LLMs und lernt mit der Zeit, welche besser funktionieren und weist ihnen mehr Arbeit zu.

Testen des KI-Teams

Das Multi-LLM AB-MCTS-System wurde anhand des ARC-AGI-2-Benchmark-Tests bewertet, der menschenähnliches visuelles Denken bei neuartigen Problemen testet - eine große Herausforderung für die KI.

Das Team kombinierte Spitzenmodelle wie o4-mini, Gemini 2.5 Pro und DeepSeek-R1.

Das Modellkollektiv löste über 30 % der 120 Testprobleme und übertraf damit die Leistung jedes einzelnen Modells bei weitem. Das System wies dynamisch das beste Modell für jede Aufgabe zu und identifizierte schnell das effektivste LLM, wenn ein klarer Lösungsweg bestand.

Bemerkenswerterweise löste das System Probleme, die zuvor von einem einzelnen Modell nicht gelöst werden konnten. In einem Fall wurde eine falsche Lösung von o4-mini durch DeepSeek-R1 und Gemini-2.5 Pro verfeinert, was den Fehler korrigierte und die richtige Antwort lieferte.

"Dies zeigt, dass Multi-LLM AB-MCTS Grenzmodelle kombinieren kann, um zuvor unlösbare Herausforderungen zu bewältigen und die Grenzen der kollektiven KI-Intelligenz zu erweitern", so die Forscher.

"Die Stärken und Halluzinationstendenzen der einzelnen Modelle sind unterschiedlich", so Akiba. "Indem wir Modelle mit geringerer Halluzinationstendenz kombinieren, können wir sowohl eine leistungsfähige Argumentation als auch eine hohe Zuverlässigkeit erreichen und damit ein wichtiges Geschäftsproblem angehen.

Von der Forschung zur praktischen Anwendung

Sakana AI hat TreeQuest veröffentlicht, ein Open-Source-Framework unter der Apache 2.0-Lizenz, das es Entwicklern und Unternehmen ermöglicht, Multi-LLM AB-MCTS zu implementieren. Seine flexible API unterstützt benutzerdefiniertes Scoring und Logik für verschiedene Aufgaben.

"Wir sind noch dabei, AB-MCTS für spezifische geschäftliche Herausforderungen zu erforschen, aber sein Potenzial ist klar", so Akiba.

Über den ARC-AGI-2-Benchmark hinaus ist AB-MCTS bei Aufgaben wie komplexer Codierung und der Verbesserung der Genauigkeit von Modellen des maschinellen Lernens erfolgreich.

"AB-MCTS zeichnet sich durch iterative Trial-and-Error-Aufgaben aus, wie etwa die Optimierung von Software-Performance-Metriken", so Akiba weiter. "Es könnte zum Beispiel automatisch die Antwortzeiten von Webservices reduzieren."

Dieses Open-Source-Tool könnte eine neue Generation von robusten, zuverlässigen KI-Anwendungen für Unternehmen ermöglichen.

MIT stellt selbstlernendes KI-Framework vor, das über statische Modelle hinausgeht

MIT-Forscher entwickeln selbstlernendes KI-SystemEin Team am MIT hat ein innovatives System namens SEAL (Self-Adapting Language Models) entwickelt, das große Sprachmodelle in die Lage versetzt, ihre F

MIT stellt selbstlernendes KI-Framework vor, das über statische Modelle hinausgeht

MIT-Forscher entwickeln selbstlernendes KI-SystemEin Team am MIT hat ein innovatives System namens SEAL (Self-Adapting Language Models) entwickelt, das große Sprachmodelle in die Lage versetzt, ihre F

Multiverse AI bringt bahnbrechende Miniatur-Hochleistungsmodelle auf den Markt

Ein bahnbrechendes europäisches KI-Startup hat bahnbrechende KI-Modelle in Mikrogröße vorgestellt, die nach Vogel- und Insektengehirnen benannt sind, und damit gezeigt, dass leistungsstarke künstliche

Multiverse AI bringt bahnbrechende Miniatur-Hochleistungsmodelle auf den Markt

Ein bahnbrechendes europäisches KI-Startup hat bahnbrechende KI-Modelle in Mikrogröße vorgestellt, die nach Vogel- und Insektengehirnen benannt sind, und damit gezeigt, dass leistungsstarke künstliche