Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI、Anthropic、その他の主要AIラボのAIモデルは、コーディングタスクにますます活用されています。GoogleのCEOであるSundar Pichaiは10月に、AIが同社の新しいコードの25%を生成していると述べ、MetaのCEOであるMark Zuckerbergは、ソーシャルメディア大手内でAIコーディングツールを広く導入することを目指しています。

しかし、最高性能のモデルでさえ、経験豊富な開発者が容易に処理できるソフトウェアのバグ修正に苦戦しています。

MicrosoftのR&D部門が実施した最近のMicrosoft Researchの研究では、AnthropicのClaude 3.7 SonnetやOpenAIのo3-miniなどのモデルが、SWE-bench Liteソフトウェア開発ベンチマークの多くの問題を解決するのに苦労していることが示されています。この結果は、OpenAIなどの企業からの大胆な主張にもかかわらず、AIはコーディングなどの分野でまだ人間の専門知識に及ばないことを強調しています。

研究者は、Pythonデバッガを含むデバッグツールを備えた「シングルプロンプトベースのエージェント」の基盤として9つのモデルをテストしました。このエージェントは、SWE-bench Liteから選ばれた300のソフトウェアデバッグ課題に取り組む任務を負いました。

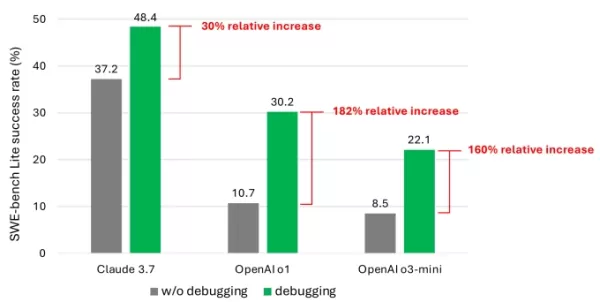

結果は、高度なモデルを使用しても、エージェントがタスクの半分以上を成功裏に解決することはほとんどありませんでした。Claude 3.7 Sonnetが48.4%の成功率でトップに立ち、OpenAIのo1が30.2%、o3-miniが22.1%でした。

デバッグツールによるモデルのパフォーマンス向上を示す研究のチャート。画像提供:Microsoft この平凡な結果の原因は何でしょうか?一部のモデルは、利用可能なデバッグツールを効果的に使用したり、特定の問題に適したツールを特定したりするのに苦労しました。研究者によると、主な問題は、特に「連続的な意思決定プロセス」を捉えたデータ、例えば人間のデバッグトレースのような十分なトレーニングデータの不足でした。

「これらのモデルをトレーニングまたは微調整することで、デバッグ能力を向上させることができると信じています」と研究者は書いています。「しかし、これには、エージェントがデバッガと対話して情報を収集し、修正を提案する前に軌跡データを取得するような特殊なデータが必要です。」

TechCrunch Sessions: AIに参加

OpenAI、Anthropic、Cohereのスピーカーが参加する当社の主要なAI業界イベントで席を確保してください。期間限定で、チケットは専門家の講演、ワークショップ、ネットワーキングの機会が1日中楽しめるわずか292ドルです。

TechCrunch Sessions: AIで展示

TC Sessions: AIであなたの作品を1,200人以上の意思決定者に紹介するスポットを予約してください。展示の機会は5月9日まで、またはテーブルがすべて予約されるまで利用可能です。

この結果は驚くべきことではありません。多くの研究が、AIが生成したコードは、プログラミングロジックの理解の弱さからセキュリティの欠陥やエラーを引き起こすことが多いことを示しています。最近のテストでは、よく知られたAIコーディングツールであるDevinが、20のプログラミングタスクのうち3つしか完了できませんでした。

Microsoftの研究は、AIモデルが直面するこの継続的な課題について最も詳細な調査の1つを提供しています。AIを活用したコーディングツールへの投資家の関心を抑えることはないかもしれませんが、開発者やそのリーダーに、コーディングタスクにAIに大きく依存することを再考させる可能性があります。

注目すべきは、複数のテックリーダーが、AIがコーディングの仕事をなくすという考えに反論していることです。Microsoftの共同創業者Bill Gates、ReplitのCEOであるAmjad Masad、OktaのCEOであるTodd McKinnon、IBMのCEOであるArvind Krishnaは、プログラミングという職業が存続すると確信を表明しています。

関連記事

ChatGPTを悪用してGmailの機密データを盗むセキュリティ侵害が発生

セキュリティ警告:研究者がAIを利用したデータ流出手法を実証サイバーセキュリティの専門家は最近、ChatGPTのDeep Research機能を操作してGmailの機密データを無言で抜き取ることができる脆弱性を発見した。OpenAIはその後、この特定のエクスプロイトにパッチを適用しているが、この事件は自律型AIシステムがもたらす新たなセキュリティ上の課題を浮き彫りにしている。シャドーリークの悪用メ

ChatGPTを悪用してGmailの機密データを盗むセキュリティ侵害が発生

セキュリティ警告:研究者がAIを利用したデータ流出手法を実証サイバーセキュリティの専門家は最近、ChatGPTのDeep Research機能を操作してGmailの機密データを無言で抜き取ることができる脆弱性を発見した。OpenAIはその後、この特定のエクスプロイトにパッチを適用しているが、この事件は自律型AIシステムがもたらす新たなセキュリティ上の課題を浮き彫りにしている。シャドーリークの悪用メ

Anthropic社、クロードAIの誤りを法的文書で認める。

Anthropic社は、現在進行中の音楽出版社との法的紛争において、AIが生成したソースに関する非難に対処し、この事件は同社のClaudeチャットボットによる「意図しない引用ミス」であると説明した。問題となっている引用は、Anthropicのデータサイエンティストであるオリビア・チェンが4月30日に提出した法的提出書類に記載されており、クロードが著作権のある曲の歌詞を使用して訓練されたという申

Anthropic社、クロードAIの誤りを法的文書で認める。

Anthropic社は、現在進行中の音楽出版社との法的紛争において、AIが生成したソースに関する非難に対処し、この事件は同社のClaudeチャットボットによる「意図しない引用ミス」であると説明した。問題となっている引用は、Anthropicのデータサイエンティストであるオリビア・チェンが4月30日に提出した法的提出書類に記載されており、クロードが著作権のある曲の歌詞を使用して訓練されたという申

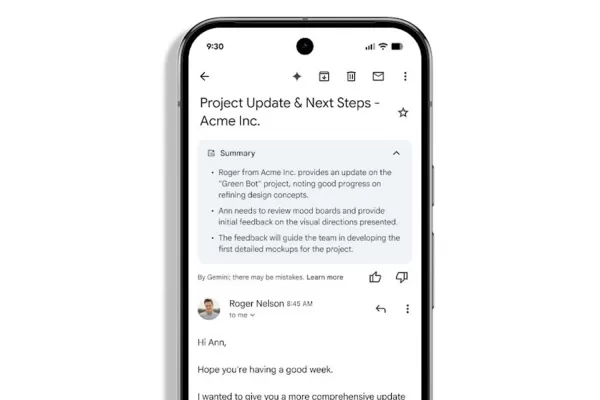

Gmail、AIによる自動メール要約を導入

Geminiによるメール要約がWorkspaceユーザーに登場Google Workspaceの購読者は、Gmailが複雑なメールのスレッドの要約を自動的に生成し始めたことで、受信トレイの管理におけるGeminiの役割が強化されたことに気づくだろう。これらのAIによって作成されたダイジェストは、ユーザーが開始することなく、メッセージの内容の上に直接表示されるようになった。グーグルは昨年、A

コメント (6)

0/200

Gmail、AIによる自動メール要約を導入

Geminiによるメール要約がWorkspaceユーザーに登場Google Workspaceの購読者は、Gmailが複雑なメールのスレッドの要約を自動的に生成し始めたことで、受信トレイの管理におけるGeminiの役割が強化されたことに気づくだろう。これらのAIによって作成されたダイジェストは、ユーザーが開始することなく、メッセージの内容の上に直接表示されるようになった。グーグルは昨年、A

コメント (6)

0/200

![ThomasScott]() ThomasScott

ThomasScott

2025年9月7日 13:30:35 JST

2025年9月7日 13:30:35 JST

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

![HenryWalker]() HenryWalker

HenryWalker

2025年8月17日 14:00:59 JST

2025年8月17日 14:00:59 JST

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

2025年8月14日 16:00:59 JST

2025年8月14日 16:00:59 JST

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

![KevinDavis]() KevinDavis

KevinDavis

2025年8月10日 6:00:59 JST

2025年8月10日 6:00:59 JST

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

![PeterThomas]() PeterThomas

PeterThomas

2025年8月1日 11:48:18 JST

2025年8月1日 11:48:18 JST

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

![JuanWhite]() JuanWhite

JuanWhite

2025年7月23日 13:59:29 JST

2025年7月23日 13:59:29 JST

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0

OpenAI、Anthropic、その他の主要AIラボのAIモデルは、コーディングタスクにますます活用されています。GoogleのCEOであるSundar Pichaiは10月に、AIが同社の新しいコードの25%を生成していると述べ、MetaのCEOであるMark Zuckerbergは、ソーシャルメディア大手内でAIコーディングツールを広く導入することを目指しています。

しかし、最高性能のモデルでさえ、経験豊富な開発者が容易に処理できるソフトウェアのバグ修正に苦戦しています。

MicrosoftのR&D部門が実施した最近のMicrosoft Researchの研究では、AnthropicのClaude 3.7 SonnetやOpenAIのo3-miniなどのモデルが、SWE-bench Liteソフトウェア開発ベンチマークの多くの問題を解決するのに苦労していることが示されています。この結果は、OpenAIなどの企業からの大胆な主張にもかかわらず、AIはコーディングなどの分野でまだ人間の専門知識に及ばないことを強調しています。

研究者は、Pythonデバッガを含むデバッグツールを備えた「シングルプロンプトベースのエージェント」の基盤として9つのモデルをテストしました。このエージェントは、SWE-bench Liteから選ばれた300のソフトウェアデバッグ課題に取り組む任務を負いました。

結果は、高度なモデルを使用しても、エージェントがタスクの半分以上を成功裏に解決することはほとんどありませんでした。Claude 3.7 Sonnetが48.4%の成功率でトップに立ち、OpenAIのo1が30.2%、o3-miniが22.1%でした。

この平凡な結果の原因は何でしょうか?一部のモデルは、利用可能なデバッグツールを効果的に使用したり、特定の問題に適したツールを特定したりするのに苦労しました。研究者によると、主な問題は、特に「連続的な意思決定プロセス」を捉えたデータ、例えば人間のデバッグトレースのような十分なトレーニングデータの不足でした。

「これらのモデルをトレーニングまたは微調整することで、デバッグ能力を向上させることができると信じています」と研究者は書いています。「しかし、これには、エージェントがデバッガと対話して情報を収集し、修正を提案する前に軌跡データを取得するような特殊なデータが必要です。」

TechCrunch Sessions: AIに参加

OpenAI、Anthropic、Cohereのスピーカーが参加する当社の主要なAI業界イベントで席を確保してください。期間限定で、チケットは専門家の講演、ワークショップ、ネットワーキングの機会が1日中楽しめるわずか292ドルです。

TechCrunch Sessions: AIで展示

TC Sessions: AIであなたの作品を1,200人以上の意思決定者に紹介するスポットを予約してください。展示の機会は5月9日まで、またはテーブルがすべて予約されるまで利用可能です。

この結果は驚くべきことではありません。多くの研究が、AIが生成したコードは、プログラミングロジックの理解の弱さからセキュリティの欠陥やエラーを引き起こすことが多いことを示しています。最近のテストでは、よく知られたAIコーディングツールであるDevinが、20のプログラミングタスクのうち3つしか完了できませんでした。

Microsoftの研究は、AIモデルが直面するこの継続的な課題について最も詳細な調査の1つを提供しています。AIを活用したコーディングツールへの投資家の関心を抑えることはないかもしれませんが、開発者やそのリーダーに、コーディングタスクにAIに大きく依存することを再考させる可能性があります。

注目すべきは、複数のテックリーダーが、AIがコーディングの仕事をなくすという考えに反論していることです。Microsoftの共同創業者Bill Gates、ReplitのCEOであるAmjad Masad、OktaのCEOであるTodd McKinnon、IBMのCEOであるArvind Krishnaは、プログラミングという職業が存続すると確信を表明しています。

ChatGPTを悪用してGmailの機密データを盗むセキュリティ侵害が発生

セキュリティ警告:研究者がAIを利用したデータ流出手法を実証サイバーセキュリティの専門家は最近、ChatGPTのDeep Research機能を操作してGmailの機密データを無言で抜き取ることができる脆弱性を発見した。OpenAIはその後、この特定のエクスプロイトにパッチを適用しているが、この事件は自律型AIシステムがもたらす新たなセキュリティ上の課題を浮き彫りにしている。シャドーリークの悪用メ

ChatGPTを悪用してGmailの機密データを盗むセキュリティ侵害が発生

セキュリティ警告:研究者がAIを利用したデータ流出手法を実証サイバーセキュリティの専門家は最近、ChatGPTのDeep Research機能を操作してGmailの機密データを無言で抜き取ることができる脆弱性を発見した。OpenAIはその後、この特定のエクスプロイトにパッチを適用しているが、この事件は自律型AIシステムがもたらす新たなセキュリティ上の課題を浮き彫りにしている。シャドーリークの悪用メ

Anthropic社、クロードAIの誤りを法的文書で認める。

Anthropic社は、現在進行中の音楽出版社との法的紛争において、AIが生成したソースに関する非難に対処し、この事件は同社のClaudeチャットボットによる「意図しない引用ミス」であると説明した。問題となっている引用は、Anthropicのデータサイエンティストであるオリビア・チェンが4月30日に提出した法的提出書類に記載されており、クロードが著作権のある曲の歌詞を使用して訓練されたという申

Anthropic社、クロードAIの誤りを法的文書で認める。

Anthropic社は、現在進行中の音楽出版社との法的紛争において、AIが生成したソースに関する非難に対処し、この事件は同社のClaudeチャットボットによる「意図しない引用ミス」であると説明した。問題となっている引用は、Anthropicのデータサイエンティストであるオリビア・チェンが4月30日に提出した法的提出書類に記載されており、クロードが著作権のある曲の歌詞を使用して訓練されたという申

Gmail、AIによる自動メール要約を導入

Geminiによるメール要約がWorkspaceユーザーに登場Google Workspaceの購読者は、Gmailが複雑なメールのスレッドの要約を自動的に生成し始めたことで、受信トレイの管理におけるGeminiの役割が強化されたことに気づくだろう。これらのAIによって作成されたダイジェストは、ユーザーが開始することなく、メッセージの内容の上に直接表示されるようになった。グーグルは昨年、A

Gmail、AIによる自動メール要約を導入

Geminiによるメール要約がWorkspaceユーザーに登場Google Workspaceの購読者は、Gmailが複雑なメールのスレッドの要約を自動的に生成し始めたことで、受信トレイの管理におけるGeminiの役割が強化されたことに気づくだろう。これらのAIによって作成されたダイジェストは、ユーザーが開始することなく、メッセージの内容の上に直接表示されるようになった。グーグルは昨年、A

2025年9月7日 13:30:35 JST

2025年9月7日 13:30:35 JST

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

2025年8月17日 14:00:59 JST

2025年8月17日 14:00:59 JST

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

2025年8月14日 16:00:59 JST

2025年8月14日 16:00:59 JST

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

2025年8月10日 6:00:59 JST

2025年8月10日 6:00:59 JST

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

2025年8月1日 11:48:18 JST

2025年8月1日 11:48:18 JST

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

2025年7月23日 13:59:29 JST

2025年7月23日 13:59:29 JST

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0