Estudio de Microsoft Revela Limitaciones de Modelos de IA en Depuración de Software

Modelos de IA de OpenAI, Anthropic y otros laboratorios líderes de IA se utilizan cada vez más para tareas de codificación. El CEO de Google, Sundar Pichai, señaló en octubre que la IA genera el 25% del nuevo código en la empresa, mientras que el CEO de Meta, Mark Zuckerberg, busca implementar ampliamente herramientas de codificación de IA en el gigante de las redes sociales.

Sin embargo, incluso los modelos de mejor rendimiento tienen dificultades para corregir errores de software que los desarrolladores experimentados manejan con facilidad.

Un reciente estudio de Microsoft Research, realizado por la división de I+D de Microsoft, muestra que modelos como Claude 3.7 Sonnet de Anthropic y o3-mini de OpenAI tienen dificultades para resolver muchos problemas en el punto de referencia de desarrollo de software SWE-bench Lite. Los hallazgos destacan que, a pesar de las ambiciosas afirmaciones de empresas como OpenAI, la IA aún está lejos de la experiencia humana en áreas como la codificación.

Los investigadores del estudio probaron nueve modelos como base para un “agente basado en un solo prompt” equipado con herramientas de depuración, incluido un depurador de Python. El agente tuvo la tarea de abordar 300 desafíos de depuración de software seleccionados de SWE-bench Lite.

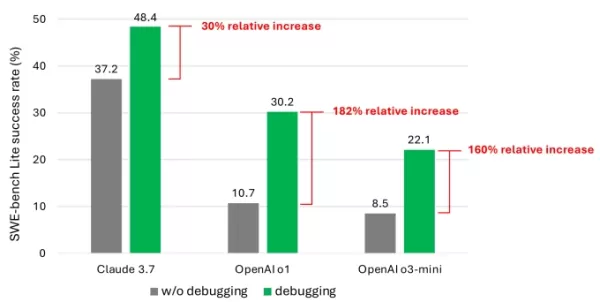

Los resultados mostraron que incluso con modelos avanzados, el agente rara vez resolvió más de la mitad de las tareas con éxito. Claude 3.7 Sonnet lideró con una tasa de éxito del 48.4%, seguido por o1 de OpenAI con un 30.2% y o3-mini con un 22.1%.

Un gráfico del estudio que muestra el aumento de rendimiento que los modelos obtuvieron con herramientas de depuración. Créditos de la imagen: Microsoft ¿Qué explica los resultados mediocres? Algunos modelos tuvieron dificultades para usar efectivamente las herramientas de depuración disponibles o identificar qué herramientas eran adecuadas para problemas específicos. El problema principal, según los investigadores, fue la falta de datos de entrenamiento suficientes, particularmente datos que capturen “procesos de toma de decisiones secuenciales” como los rastros de depuración humana.

“Creemos que entrenar o ajustar estos modelos puede mejorar sus capacidades de depuración,” escribieron los investigadores. “Sin embargo, esto requiere datos especializados, como datos de trayectoria que capturen a los agentes interactuando con un depurador para recopilar información antes de proponer soluciones.”

Asiste a TechCrunch Sessions: AI

Reserva tu lugar en nuestro evento principal de la industria de IA, con oradores de OpenAI, Anthropic y Cohere. Por tiempo limitado, las entradas cuestan solo $292 para un día completo de charlas de expertos, talleres y oportunidades de networking.

Exhibe en TechCrunch Sessions: AI

Reserva tu espacio en TC Sessions: AI para presentar tu trabajo a más de 1,200 tomadores de decisiones. Las oportunidades de exhibición están disponibles hasta el 9 de mayo o hasta que las mesas estén completamente reservadas.

Los hallazgos no son sorprendentes. Numerosos estudios han demostrado que el código generado por IA a menudo introduce fallos de seguridad y errores debido a debilidades en la comprensión de la lógica de programación. Una prueba reciente de Devin, una conocida herramienta de codificación de IA, reveló que solo pudo completar tres de 20 tareas de programación.

El estudio de Microsoft ofrece uno de los exámenes más profundos de este desafío continuo para los modelos de IA. Aunque es poco probable que frene el interés de los inversores en herramientas de codificación impulsadas por IA, puede llevar a los desarrolladores y sus líderes a reconsiderar depender en gran medida de la IA para tareas de codificación.

Notablemente, varios líderes tecnológicos han rechazado la idea de que la IA eliminará los empleos de codificación. El cofundador de Microsoft, Bill Gates, el CEO de Replit, Amjad Masad, el CEO de Okta, Todd McKinnon, y el CEO de IBM, Arvind Krishna, han expresado confianza en que la programación como profesión perdurará.

Artículo relacionado

ChatGPT se aprovecha para robar datos confidenciales de Gmail en una brecha de seguridad

Alerta de seguridad: investigadores demuestran una técnica de filtración de datos impulsada por IAExpertos en ciberseguridad descubrieron recientemente una preocupante vulnerabilidad que permitía mani

ChatGPT se aprovecha para robar datos confidenciales de Gmail en una brecha de seguridad

Alerta de seguridad: investigadores demuestran una técnica de filtración de datos impulsada por IAExpertos en ciberseguridad descubrieron recientemente una preocupante vulnerabilidad que permitía mani

Anthropic admite el error de Claude AI en un escrito legal y lo califica de "vergonzoso y no intencionado"

Anthropic ha respondido a las acusaciones relativas a una fuente generada por IA en su actual disputa legal con los editores de música, caracterizando el incidente como un "error de citación involunta

Anthropic admite el error de Claude AI en un escrito legal y lo califica de "vergonzoso y no intencionado"

Anthropic ha respondido a las acusaciones relativas a una fuente generada por IA en su actual disputa legal con los editores de música, caracterizando el incidente como un "error de citación involunta

Gmail lanza resúmenes automáticos de correo electrónico basados en inteligencia artificial

Los resúmenes de correo electrónico de Gemini llegan a los usuarios de WorkspaceLos suscriptores de Google Workspace notarán el papel mejorado de Gemini en la gestión de sus bandejas de entrada, ya

comentario (6)

0/200

Gmail lanza resúmenes automáticos de correo electrónico basados en inteligencia artificial

Los resúmenes de correo electrónico de Gemini llegan a los usuarios de WorkspaceLos suscriptores de Google Workspace notarán el papel mejorado de Gemini en la gestión de sus bandejas de entrada, ya

comentario (6)

0/200

![ThomasScott]() ThomasScott

ThomasScott

7 de septiembre de 2025 06:30:35 GMT+02:00

7 de septiembre de 2025 06:30:35 GMT+02:00

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

![HenryWalker]() HenryWalker

HenryWalker

17 de agosto de 2025 07:00:59 GMT+02:00

17 de agosto de 2025 07:00:59 GMT+02:00

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

14 de agosto de 2025 09:00:59 GMT+02:00

14 de agosto de 2025 09:00:59 GMT+02:00

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

![KevinDavis]() KevinDavis

KevinDavis

9 de agosto de 2025 23:00:59 GMT+02:00

9 de agosto de 2025 23:00:59 GMT+02:00

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

![PeterThomas]() PeterThomas

PeterThomas

1 de agosto de 2025 04:48:18 GMT+02:00

1 de agosto de 2025 04:48:18 GMT+02:00

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

![JuanWhite]() JuanWhite

JuanWhite

23 de julio de 2025 06:59:29 GMT+02:00

23 de julio de 2025 06:59:29 GMT+02:00

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0

Modelos de IA de OpenAI, Anthropic y otros laboratorios líderes de IA se utilizan cada vez más para tareas de codificación. El CEO de Google, Sundar Pichai, señaló en octubre que la IA genera el 25% del nuevo código en la empresa, mientras que el CEO de Meta, Mark Zuckerberg, busca implementar ampliamente herramientas de codificación de IA en el gigante de las redes sociales.

Sin embargo, incluso los modelos de mejor rendimiento tienen dificultades para corregir errores de software que los desarrolladores experimentados manejan con facilidad.

Un reciente estudio de Microsoft Research, realizado por la división de I+D de Microsoft, muestra que modelos como Claude 3.7 Sonnet de Anthropic y o3-mini de OpenAI tienen dificultades para resolver muchos problemas en el punto de referencia de desarrollo de software SWE-bench Lite. Los hallazgos destacan que, a pesar de las ambiciosas afirmaciones de empresas como OpenAI, la IA aún está lejos de la experiencia humana en áreas como la codificación.

Los investigadores del estudio probaron nueve modelos como base para un “agente basado en un solo prompt” equipado con herramientas de depuración, incluido un depurador de Python. El agente tuvo la tarea de abordar 300 desafíos de depuración de software seleccionados de SWE-bench Lite.

Los resultados mostraron que incluso con modelos avanzados, el agente rara vez resolvió más de la mitad de las tareas con éxito. Claude 3.7 Sonnet lideró con una tasa de éxito del 48.4%, seguido por o1 de OpenAI con un 30.2% y o3-mini con un 22.1%.

¿Qué explica los resultados mediocres? Algunos modelos tuvieron dificultades para usar efectivamente las herramientas de depuración disponibles o identificar qué herramientas eran adecuadas para problemas específicos. El problema principal, según los investigadores, fue la falta de datos de entrenamiento suficientes, particularmente datos que capturen “procesos de toma de decisiones secuenciales” como los rastros de depuración humana.

“Creemos que entrenar o ajustar estos modelos puede mejorar sus capacidades de depuración,” escribieron los investigadores. “Sin embargo, esto requiere datos especializados, como datos de trayectoria que capturen a los agentes interactuando con un depurador para recopilar información antes de proponer soluciones.”

Asiste a TechCrunch Sessions: AI

Reserva tu lugar en nuestro evento principal de la industria de IA, con oradores de OpenAI, Anthropic y Cohere. Por tiempo limitado, las entradas cuestan solo $292 para un día completo de charlas de expertos, talleres y oportunidades de networking.

Exhibe en TechCrunch Sessions: AI

Reserva tu espacio en TC Sessions: AI para presentar tu trabajo a más de 1,200 tomadores de decisiones. Las oportunidades de exhibición están disponibles hasta el 9 de mayo o hasta que las mesas estén completamente reservadas.

Los hallazgos no son sorprendentes. Numerosos estudios han demostrado que el código generado por IA a menudo introduce fallos de seguridad y errores debido a debilidades en la comprensión de la lógica de programación. Una prueba reciente de Devin, una conocida herramienta de codificación de IA, reveló que solo pudo completar tres de 20 tareas de programación.

El estudio de Microsoft ofrece uno de los exámenes más profundos de este desafío continuo para los modelos de IA. Aunque es poco probable que frene el interés de los inversores en herramientas de codificación impulsadas por IA, puede llevar a los desarrolladores y sus líderes a reconsiderar depender en gran medida de la IA para tareas de codificación.

Notablemente, varios líderes tecnológicos han rechazado la idea de que la IA eliminará los empleos de codificación. El cofundador de Microsoft, Bill Gates, el CEO de Replit, Amjad Masad, el CEO de Okta, Todd McKinnon, y el CEO de IBM, Arvind Krishna, han expresado confianza en que la programación como profesión perdurará.

ChatGPT se aprovecha para robar datos confidenciales de Gmail en una brecha de seguridad

Alerta de seguridad: investigadores demuestran una técnica de filtración de datos impulsada por IAExpertos en ciberseguridad descubrieron recientemente una preocupante vulnerabilidad que permitía mani

ChatGPT se aprovecha para robar datos confidenciales de Gmail en una brecha de seguridad

Alerta de seguridad: investigadores demuestran una técnica de filtración de datos impulsada por IAExpertos en ciberseguridad descubrieron recientemente una preocupante vulnerabilidad que permitía mani

Anthropic admite el error de Claude AI en un escrito legal y lo califica de "vergonzoso y no intencionado"

Anthropic ha respondido a las acusaciones relativas a una fuente generada por IA en su actual disputa legal con los editores de música, caracterizando el incidente como un "error de citación involunta

Anthropic admite el error de Claude AI en un escrito legal y lo califica de "vergonzoso y no intencionado"

Anthropic ha respondido a las acusaciones relativas a una fuente generada por IA en su actual disputa legal con los editores de música, caracterizando el incidente como un "error de citación involunta

Gmail lanza resúmenes automáticos de correo electrónico basados en inteligencia artificial

Los resúmenes de correo electrónico de Gemini llegan a los usuarios de WorkspaceLos suscriptores de Google Workspace notarán el papel mejorado de Gemini en la gestión de sus bandejas de entrada, ya

Gmail lanza resúmenes automáticos de correo electrónico basados en inteligencia artificial

Los resúmenes de correo electrónico de Gemini llegan a los usuarios de WorkspaceLos suscriptores de Google Workspace notarán el papel mejorado de Gemini en la gestión de sus bandejas de entrada, ya

7 de septiembre de 2025 06:30:35 GMT+02:00

7 de septiembre de 2025 06:30:35 GMT+02:00

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

17 de agosto de 2025 07:00:59 GMT+02:00

17 de agosto de 2025 07:00:59 GMT+02:00

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

14 de agosto de 2025 09:00:59 GMT+02:00

14 de agosto de 2025 09:00:59 GMT+02:00

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

9 de agosto de 2025 23:00:59 GMT+02:00

9 de agosto de 2025 23:00:59 GMT+02:00

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

1 de agosto de 2025 04:48:18 GMT+02:00

1 de agosto de 2025 04:48:18 GMT+02:00

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

23 de julio de 2025 06:59:29 GMT+02:00

23 de julio de 2025 06:59:29 GMT+02:00

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0