Étude de Microsoft révèle les limites des modèles d'IA dans le débogage de logiciels

Les modèles d'IA d'OpenAI, Anthropic et d'autres laboratoires d'IA de pointe sont de plus en plus utilisés pour les tâches de codage. Le PDG de Google, Sundar Pichai, a noté en octobre que l'IA génère 25 % du nouveau code dans l'entreprise, tandis que le PDG de Meta, Mark Zuckerberg, vise à implémenter largement des outils de codage par IA au sein du géant des réseaux sociaux.

Cependant, même les modèles les plus performants peinent à corriger les bogues logiciels que les développeurs expérimentés gèrent avec aisance.

Une récente étude de Microsoft Research, menée par la division R&D de Microsoft, montre que des modèles comme Claude 3.7 Sonnet d'Anthropic et o3-mini d'OpenAI ont du mal à résoudre de nombreux problèmes dans le benchmark de développement logiciel SWE-bench Lite. Les résultats soulignent que, malgré les revendications ambitieuses d'entreprises comme OpenAI, l'IA reste en deçà de l'expertise humaine dans des domaines comme le codage.

Les chercheurs de l'étude ont testé neuf modèles comme base pour un « agent basé sur une seule invite » équipé d'outils de débogage, y compris un débogueur Python. L'agent a été chargé de relever 300 défis de débogage logiciel soigneusement sélectionnés dans SWE-bench Lite.

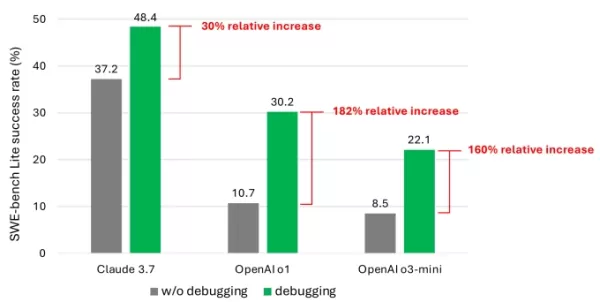

Les résultats ont montré que même avec des modèles avancés, l'agent a rarement réussi à résoudre plus de la moitié des tâches avec succès. Claude 3.7 Sonnet a dominé avec un taux de réussite de 48,4 %, suivi par o1 d'OpenAI à 30,2 %, et o3-mini à 22,1 %.

Un graphique de l'étude montrant l'amélioration des performances des modèles grâce aux outils de débogage. Crédits image : Microsoft Qu'explique ces résultats décevants ? Certains modèles ont eu du mal à utiliser efficacement les outils de débogage disponibles ou à identifier quels outils convenaient à des problèmes spécifiques. Le principal problème, selon les chercheurs, était un manque de données d'entraînement suffisantes, en particulier des données capturant les « processus de prise de décision séquentielle » comme les traces de débogage humain.

« Nous pensons que l'entraînement ou l'ajustement fin de ces modèles peut améliorer leurs capacités de débogage », ont écrit les chercheurs. « Cependant, cela nécessite des données spécialisées, telles que des données de trajectoire capturant les interactions des agents avec un débogueur pour recueillir des informations avant de proposer des corrections. »

Participez aux sessions TechCrunch : IA

Réservez votre place à notre événement phare de l'industrie de l'IA, avec des conférenciers d'OpenAI, Anthropic et Cohere. Pour une durée limitée, les billets coûtent seulement 292 $ pour une journée complète de conférences d'experts, d'ateliers et d'opportunités de réseautage.

Exposez aux sessions TechCrunch : IA

Réservez votre place aux sessions TC : IA pour présenter votre travail à plus de 1 200 décideurs. Des opportunités d'exposition sont disponibles jusqu'au 9 mai ou jusqu'à ce que les stands soient entièrement réservés.

Les résultats ne sont pas surprenants. De nombreuses études ont montré que le code généré par l'IA introduit souvent des failles de sécurité et des erreurs en raison de faiblesses dans la compréhension de la logique de programmation. Un test récent de Devin, un outil de codage IA bien connu, a révélé qu'il ne pouvait accomplir que trois des 20 tâches de programmation.

L'étude de Microsoft offre l'un des examens les plus approfondis de ce défi persistant pour les modèles d'IA. Bien qu'il soit peu probable que cela freine l'intérêt des investisseurs pour les outils de codage alimentés par l'IA, cela pourrait inciter les développeurs et leurs dirigeants à reconsidérer une dépendance excessive envers l'IA pour les tâches de codage.

Notamment, plusieurs leaders technologiques ont repoussé l'idée que l'IA éliminera les emplois de codage. Le cofondateur de Microsoft, Bill Gates, le PDG de Replit, Amjad Masad, le PDG d'Okta, Todd McKinnon, et le PDG d'IBM, Arvind Krishna, ont tous exprimé leur confiance dans la pérennité de la profession de programmeur.

Article connexe

ChatGPT exploité pour voler des données Gmail sensibles dans le cadre d'une faille de sécurité

Alerte de sécurité : des chercheurs démontrent une technique d'exfiltration de données basée sur l'IADes experts en cybersécurité ont récemment découvert une vulnérabilité inquiétante dans laquelle la

ChatGPT exploité pour voler des données Gmail sensibles dans le cadre d'une faille de sécurité

Alerte de sécurité : des chercheurs démontrent une technique d'exfiltration de données basée sur l'IADes experts en cybersécurité ont récemment découvert une vulnérabilité inquiétante dans laquelle la

Anthropic admet l'erreur d'IA de Claude dans son dossier juridique, la qualifiant de "gênante et non intentionnelle".

Anthropic a répondu aux accusations concernant une source générée par l'IA dans le cadre de son litige avec les éditeurs de musique, qualifiant l'incident d'"erreur de citation involontaire" commise p

Anthropic admet l'erreur d'IA de Claude dans son dossier juridique, la qualifiant de "gênante et non intentionnelle".

Anthropic a répondu aux accusations concernant une source générée par l'IA dans le cadre de son litige avec les éditeurs de musique, qualifiant l'incident d'"erreur de citation involontaire" commise p

Gmail déploie des résumés automatiques d'e-mails alimentés par l'IA

Les utilisateurs de l'espace de travail vont pouvoir bénéficier de résumés d'e-mails générés par GeminiLes abonnés à Google Workspace remarqueront le rôle accru de Gemini dans la gestion de leur boî

commentaires (6)

0/200

Gmail déploie des résumés automatiques d'e-mails alimentés par l'IA

Les utilisateurs de l'espace de travail vont pouvoir bénéficier de résumés d'e-mails générés par GeminiLes abonnés à Google Workspace remarqueront le rôle accru de Gemini dans la gestion de leur boî

commentaires (6)

0/200

![ThomasScott]() ThomasScott

ThomasScott

7 septembre 2025 06:30:35 UTC+02:00

7 septembre 2025 06:30:35 UTC+02:00

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

![HenryWalker]() HenryWalker

HenryWalker

17 août 2025 07:00:59 UTC+02:00

17 août 2025 07:00:59 UTC+02:00

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

14 août 2025 09:00:59 UTC+02:00

14 août 2025 09:00:59 UTC+02:00

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

![KevinDavis]() KevinDavis

KevinDavis

9 août 2025 23:00:59 UTC+02:00

9 août 2025 23:00:59 UTC+02:00

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

![PeterThomas]() PeterThomas

PeterThomas

1 août 2025 04:48:18 UTC+02:00

1 août 2025 04:48:18 UTC+02:00

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

![JuanWhite]() JuanWhite

JuanWhite

23 juillet 2025 06:59:29 UTC+02:00

23 juillet 2025 06:59:29 UTC+02:00

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0

Les modèles d'IA d'OpenAI, Anthropic et d'autres laboratoires d'IA de pointe sont de plus en plus utilisés pour les tâches de codage. Le PDG de Google, Sundar Pichai, a noté en octobre que l'IA génère 25 % du nouveau code dans l'entreprise, tandis que le PDG de Meta, Mark Zuckerberg, vise à implémenter largement des outils de codage par IA au sein du géant des réseaux sociaux.

Cependant, même les modèles les plus performants peinent à corriger les bogues logiciels que les développeurs expérimentés gèrent avec aisance.

Une récente étude de Microsoft Research, menée par la division R&D de Microsoft, montre que des modèles comme Claude 3.7 Sonnet d'Anthropic et o3-mini d'OpenAI ont du mal à résoudre de nombreux problèmes dans le benchmark de développement logiciel SWE-bench Lite. Les résultats soulignent que, malgré les revendications ambitieuses d'entreprises comme OpenAI, l'IA reste en deçà de l'expertise humaine dans des domaines comme le codage.

Les chercheurs de l'étude ont testé neuf modèles comme base pour un « agent basé sur une seule invite » équipé d'outils de débogage, y compris un débogueur Python. L'agent a été chargé de relever 300 défis de débogage logiciel soigneusement sélectionnés dans SWE-bench Lite.

Les résultats ont montré que même avec des modèles avancés, l'agent a rarement réussi à résoudre plus de la moitié des tâches avec succès. Claude 3.7 Sonnet a dominé avec un taux de réussite de 48,4 %, suivi par o1 d'OpenAI à 30,2 %, et o3-mini à 22,1 %.

Qu'explique ces résultats décevants ? Certains modèles ont eu du mal à utiliser efficacement les outils de débogage disponibles ou à identifier quels outils convenaient à des problèmes spécifiques. Le principal problème, selon les chercheurs, était un manque de données d'entraînement suffisantes, en particulier des données capturant les « processus de prise de décision séquentielle » comme les traces de débogage humain.

« Nous pensons que l'entraînement ou l'ajustement fin de ces modèles peut améliorer leurs capacités de débogage », ont écrit les chercheurs. « Cependant, cela nécessite des données spécialisées, telles que des données de trajectoire capturant les interactions des agents avec un débogueur pour recueillir des informations avant de proposer des corrections. »

Participez aux sessions TechCrunch : IA

Réservez votre place à notre événement phare de l'industrie de l'IA, avec des conférenciers d'OpenAI, Anthropic et Cohere. Pour une durée limitée, les billets coûtent seulement 292 $ pour une journée complète de conférences d'experts, d'ateliers et d'opportunités de réseautage.

Exposez aux sessions TechCrunch : IA

Réservez votre place aux sessions TC : IA pour présenter votre travail à plus de 1 200 décideurs. Des opportunités d'exposition sont disponibles jusqu'au 9 mai ou jusqu'à ce que les stands soient entièrement réservés.

Les résultats ne sont pas surprenants. De nombreuses études ont montré que le code généré par l'IA introduit souvent des failles de sécurité et des erreurs en raison de faiblesses dans la compréhension de la logique de programmation. Un test récent de Devin, un outil de codage IA bien connu, a révélé qu'il ne pouvait accomplir que trois des 20 tâches de programmation.

L'étude de Microsoft offre l'un des examens les plus approfondis de ce défi persistant pour les modèles d'IA. Bien qu'il soit peu probable que cela freine l'intérêt des investisseurs pour les outils de codage alimentés par l'IA, cela pourrait inciter les développeurs et leurs dirigeants à reconsidérer une dépendance excessive envers l'IA pour les tâches de codage.

Notamment, plusieurs leaders technologiques ont repoussé l'idée que l'IA éliminera les emplois de codage. Le cofondateur de Microsoft, Bill Gates, le PDG de Replit, Amjad Masad, le PDG d'Okta, Todd McKinnon, et le PDG d'IBM, Arvind Krishna, ont tous exprimé leur confiance dans la pérennité de la profession de programmeur.

ChatGPT exploité pour voler des données Gmail sensibles dans le cadre d'une faille de sécurité

Alerte de sécurité : des chercheurs démontrent une technique d'exfiltration de données basée sur l'IADes experts en cybersécurité ont récemment découvert une vulnérabilité inquiétante dans laquelle la

ChatGPT exploité pour voler des données Gmail sensibles dans le cadre d'une faille de sécurité

Alerte de sécurité : des chercheurs démontrent une technique d'exfiltration de données basée sur l'IADes experts en cybersécurité ont récemment découvert une vulnérabilité inquiétante dans laquelle la

Anthropic admet l'erreur d'IA de Claude dans son dossier juridique, la qualifiant de "gênante et non intentionnelle".

Anthropic a répondu aux accusations concernant une source générée par l'IA dans le cadre de son litige avec les éditeurs de musique, qualifiant l'incident d'"erreur de citation involontaire" commise p

Anthropic admet l'erreur d'IA de Claude dans son dossier juridique, la qualifiant de "gênante et non intentionnelle".

Anthropic a répondu aux accusations concernant une source générée par l'IA dans le cadre de son litige avec les éditeurs de musique, qualifiant l'incident d'"erreur de citation involontaire" commise p

Gmail déploie des résumés automatiques d'e-mails alimentés par l'IA

Les utilisateurs de l'espace de travail vont pouvoir bénéficier de résumés d'e-mails générés par GeminiLes abonnés à Google Workspace remarqueront le rôle accru de Gemini dans la gestion de leur boî

Gmail déploie des résumés automatiques d'e-mails alimentés par l'IA

Les utilisateurs de l'espace de travail vont pouvoir bénéficier de résumés d'e-mails générés par GeminiLes abonnés à Google Workspace remarqueront le rôle accru de Gemini dans la gestion de leur boî

7 septembre 2025 06:30:35 UTC+02:00

7 septembre 2025 06:30:35 UTC+02:00

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

17 août 2025 07:00:59 UTC+02:00

17 août 2025 07:00:59 UTC+02:00

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

14 août 2025 09:00:59 UTC+02:00

14 août 2025 09:00:59 UTC+02:00

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

9 août 2025 23:00:59 UTC+02:00

9 août 2025 23:00:59 UTC+02:00

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

1 août 2025 04:48:18 UTC+02:00

1 août 2025 04:48:18 UTC+02:00

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

23 juillet 2025 06:59:29 UTC+02:00

23 juillet 2025 06:59:29 UTC+02:00

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0