Microsoft 연구, AI 모델의 소프트웨어 디버깅 한계 드러내다

OpenAI, Anthropic 및 기타 주요 AI 연구소의 AI 모델은 코딩 작업에 점점 더 많이 활용되고 있다. Google CEO Sundar Pichai는 10월에 AI가 회사 내 새로운 코드의 25%를 생성한다고 언급했으며, Meta CEO Mark Zuckerberg는 소셜 미디어 대기업 내에서 AI 코딩 도구를 광범위하게 구현하려고 한다.

그러나 최고 성능의 모델조차도 숙련된 개발자들이 쉽게 처리하는 소프트웨어 버그를 수정하는 데 어려움을 겪는다.

Microsoft의 R&D 부서에서 수행한 최근 Microsoft Research 연구에 따르면, Anthropic의 Claude 3.7 Sonnet과 OpenAI의 o3-mini와 같은 모델은 SWE-bench Lite 소프트웨어 개발 벤치마크에서 많은 문제를 해결하지 못한다. 이 결과는 OpenAI와 같은 기업의 야심찬 주장에도 불구하고 AI가 코딩과 같은 분야에서 인간의 전문성을 아직 따라가지 못한다는 점을 강조한다.

연구진은 Python 디버거를 포함한 디버깅 도구를 갖춘 “단일 프롬프트 기반 에이전트”의 기반으로 9개의 모델을 테스트했다. 이 에이전트는 SWE-bench Lite에서 선별된 300개의 소프트웨어 디버깅 과제를 해결해야 했다.

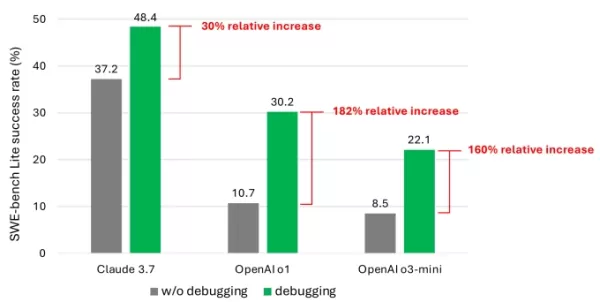

결과는 고급 모델을 사용했음에도 불구하고 에이전트가 과제의 절반 이상을 성공적으로 해결한 경우가 드물다는 것을 보여주었다. Claude 3.7 Sonnet이 48.4%의 성공률로 선두를 달렸으며, OpenAI의 o1이 30.2%, o3-mini가 22.1%로 뒤를 이었다.

디버깅 도구로 인해 모델이 얻은 성능 향상을 보여주는 연구의 차트. 이미지 제공: Microsoft 실망스러운 결과의 원인은 무엇일까? 일부 모델은 사용 가능한 디버깅 도구를 효과적으로 사용하거나 특정 문제에 적합한 도구를 식별하는 데 어려움을 겪었다. 연구진에 따르면 주요 문제는 충분한 훈련 데이터, 특히 인간의 디버깅 흔적과 같은 “순차적 의사결정 과정”을 포착한 데이터의 부족이었다.

“우리는 이러한 모델을 훈련시키거나 미세 조정하면 디버깅 능력을 개선할 수 있다고 믿는다,”라고 연구진은 썼다. “그러나 이를 위해서는 에이전트가 디버거와 상호작용하여 정보를 수집한 후 수정안을 제안하는 궤적 데이터와 같은 특수 데이터가 필요하다.”

TechCrunch Sessions: AI 참석

OpenAI, Anthropic, Cohere의 연사들이 참여하는 최고의 AI 산업 행사에 자리를 예약하라. 한정된 시간 동안, 전문가 강연, 워크숍, 네트워킹 기회를 포함한 하루 종일 티켓이 단돈 292달러다.

TechCrunch Sessions: AI에서 전시

TC Sessions: AI에서 1,200명 이상의 의사결정자에게 당신의 작업을 선보일 기회를 예약하라. 전시 기회는 5월 9일까지 또는 테이블이 모두 예약될 때까지 가능하다.

이 결과는 놀랍지 않다. 수많은 연구에서 AI가 생성한 코드는 프로그래밍 논리를 이해하는 약점 때문에 보안 결함과 오류를 종종 초래한다고 보여주었다. 잘 알려진 AI 코딩 도구인 Devin의 최근 테스트에서는 20개의 프로그래밍 작업 중 단지 3개만 완료할 수 있었다.

Microsoft의 연구는 AI 모델이 직면한 이 지속적인 도전에 대한 가장 심층적인 검토 중 하나를 제공한다. AI 기반 코딩 도구에 대한 투자자 관심을 억제할 가능성은 낮지만, 개발자와 그들의 리더들이 코딩 작업에 AI를 크게 의존하는 것을 재고하게 만들 수 있다.

특히, 여러 기술 리더들은 AI가 코딩 직업을 없애줄 것이라는 생각에 반대해 왔다. Microsoft 공동 창립자 Bill Gates, Replit CEO Amjad Masad, Okta CEO Todd McKinnon, IBM CEO Arvind Krishna는 모두 프로그래밍이 직업으로서 지속될 것이라는 자신감을 표명했다.

관련 기사

보안 침해에서 민감한 지메일 데이터를 훔치는 데 악용된 ChatGPT

보안 경보: 연구원, AI 기반 데이터 유출 기법 시연사이버 보안 전문가들은 최근 ChatGPT의 딥 리서치 기능을 조작하여 기밀 Gmail 데이터를 조용히 추출할 수 있는 우려스러운 취약점을 발견했습니다. 이후 OpenAI는 이 특정 익스플로잇을 패치했지만, 이 사건은 자율 AI 시스템이 제기하는 새로운 보안 문제를 강조합니다.섀도 유출 익스플로잇 메커니

보안 침해에서 민감한 지메일 데이터를 훔치는 데 악용된 ChatGPT

보안 경보: 연구원, AI 기반 데이터 유출 기법 시연사이버 보안 전문가들은 최근 ChatGPT의 딥 리서치 기능을 조작하여 기밀 Gmail 데이터를 조용히 추출할 수 있는 우려스러운 취약점을 발견했습니다. 이후 OpenAI는 이 특정 익스플로잇을 패치했지만, 이 사건은 자율 AI 시스템이 제기하는 새로운 보안 문제를 강조합니다.섀도 유출 익스플로잇 메커니

앤트로픽, 법적 소송에서 클로드 AI 오류 인정, "당황스럽고 의도치 않은 실수"

음악 퍼블리셔와 진행 중인 법적 분쟁에서 AI가 생성한 소스에 대한 비난이 제기된 가운데, Anthropic은 이 사건을 자사의 Claude 챗봇이 저지른 '의도치 않은 인용 오류'로 규정하고 해명했습니다.논란이 된 인용은 4월 30일 Anthropic의 데이터 과학자 올리비아 첸이 제출한 법적 서류에 나타난 것으로, Claude가 저작권이 있는 노래

앤트로픽, 법적 소송에서 클로드 AI 오류 인정, "당황스럽고 의도치 않은 실수"

음악 퍼블리셔와 진행 중인 법적 분쟁에서 AI가 생성한 소스에 대한 비난이 제기된 가운데, Anthropic은 이 사건을 자사의 Claude 챗봇이 저지른 '의도치 않은 인용 오류'로 규정하고 해명했습니다.논란이 된 인용은 4월 30일 Anthropic의 데이터 과학자 올리비아 첸이 제출한 법적 서류에 나타난 것으로, Claude가 저작권이 있는 노래

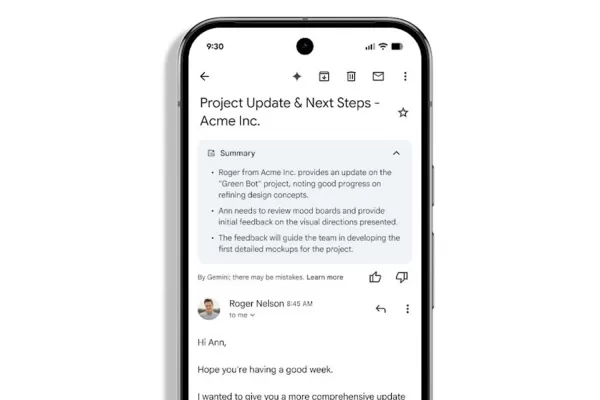

Gmail, AI 기반 자동 이메일 요약 기능 출시

Workspace 사용자에게 제공되는 Gemini 기반 이메일 요약 기능Gmail이 복잡한 이메일 스레드에 대한 요약을 자동으로 생성하기 시작하면서 받은 편지함 관리에서 Gemini의 역할이 강화된 것을 Google Workspace 가입자는 알게 될 것입니다. 이제 AI가 생성한 요약은 사용자가 시작할 필요 없이 메시지 내용 바로 위에 표시됩니다.

의견 (6)

0/200

Gmail, AI 기반 자동 이메일 요약 기능 출시

Workspace 사용자에게 제공되는 Gemini 기반 이메일 요약 기능Gmail이 복잡한 이메일 스레드에 대한 요약을 자동으로 생성하기 시작하면서 받은 편지함 관리에서 Gemini의 역할이 강화된 것을 Google Workspace 가입자는 알게 될 것입니다. 이제 AI가 생성한 요약은 사용자가 시작할 필요 없이 메시지 내용 바로 위에 표시됩니다.

의견 (6)

0/200

![ThomasScott]() ThomasScott

ThomasScott

2025년 9월 7일 오후 1시 30분 35초 GMT+09:00

2025년 9월 7일 오후 1시 30분 35초 GMT+09:00

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

![HenryWalker]() HenryWalker

HenryWalker

2025년 8월 17일 오후 2시 0분 59초 GMT+09:00

2025년 8월 17일 오후 2시 0분 59초 GMT+09:00

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

2025년 8월 14일 오후 4시 0분 59초 GMT+09:00

2025년 8월 14일 오후 4시 0분 59초 GMT+09:00

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

![KevinDavis]() KevinDavis

KevinDavis

2025년 8월 10일 오전 6시 0분 59초 GMT+09:00

2025년 8월 10일 오전 6시 0분 59초 GMT+09:00

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

![PeterThomas]() PeterThomas

PeterThomas

2025년 8월 1일 오전 11시 48분 18초 GMT+09:00

2025년 8월 1일 오전 11시 48분 18초 GMT+09:00

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

![JuanWhite]() JuanWhite

JuanWhite

2025년 7월 23일 오후 1시 59분 29초 GMT+09:00

2025년 7월 23일 오후 1시 59분 29초 GMT+09:00

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0

OpenAI, Anthropic 및 기타 주요 AI 연구소의 AI 모델은 코딩 작업에 점점 더 많이 활용되고 있다. Google CEO Sundar Pichai는 10월에 AI가 회사 내 새로운 코드의 25%를 생성한다고 언급했으며, Meta CEO Mark Zuckerberg는 소셜 미디어 대기업 내에서 AI 코딩 도구를 광범위하게 구현하려고 한다.

그러나 최고 성능의 모델조차도 숙련된 개발자들이 쉽게 처리하는 소프트웨어 버그를 수정하는 데 어려움을 겪는다.

Microsoft의 R&D 부서에서 수행한 최근 Microsoft Research 연구에 따르면, Anthropic의 Claude 3.7 Sonnet과 OpenAI의 o3-mini와 같은 모델은 SWE-bench Lite 소프트웨어 개발 벤치마크에서 많은 문제를 해결하지 못한다. 이 결과는 OpenAI와 같은 기업의 야심찬 주장에도 불구하고 AI가 코딩과 같은 분야에서 인간의 전문성을 아직 따라가지 못한다는 점을 강조한다.

연구진은 Python 디버거를 포함한 디버깅 도구를 갖춘 “단일 프롬프트 기반 에이전트”의 기반으로 9개의 모델을 테스트했다. 이 에이전트는 SWE-bench Lite에서 선별된 300개의 소프트웨어 디버깅 과제를 해결해야 했다.

결과는 고급 모델을 사용했음에도 불구하고 에이전트가 과제의 절반 이상을 성공적으로 해결한 경우가 드물다는 것을 보여주었다. Claude 3.7 Sonnet이 48.4%의 성공률로 선두를 달렸으며, OpenAI의 o1이 30.2%, o3-mini가 22.1%로 뒤를 이었다.

실망스러운 결과의 원인은 무엇일까? 일부 모델은 사용 가능한 디버깅 도구를 효과적으로 사용하거나 특정 문제에 적합한 도구를 식별하는 데 어려움을 겪었다. 연구진에 따르면 주요 문제는 충분한 훈련 데이터, 특히 인간의 디버깅 흔적과 같은 “순차적 의사결정 과정”을 포착한 데이터의 부족이었다.

“우리는 이러한 모델을 훈련시키거나 미세 조정하면 디버깅 능력을 개선할 수 있다고 믿는다,”라고 연구진은 썼다. “그러나 이를 위해서는 에이전트가 디버거와 상호작용하여 정보를 수집한 후 수정안을 제안하는 궤적 데이터와 같은 특수 데이터가 필요하다.”

TechCrunch Sessions: AI 참석

OpenAI, Anthropic, Cohere의 연사들이 참여하는 최고의 AI 산업 행사에 자리를 예약하라. 한정된 시간 동안, 전문가 강연, 워크숍, 네트워킹 기회를 포함한 하루 종일 티켓이 단돈 292달러다.

TechCrunch Sessions: AI에서 전시

TC Sessions: AI에서 1,200명 이상의 의사결정자에게 당신의 작업을 선보일 기회를 예약하라. 전시 기회는 5월 9일까지 또는 테이블이 모두 예약될 때까지 가능하다.

이 결과는 놀랍지 않다. 수많은 연구에서 AI가 생성한 코드는 프로그래밍 논리를 이해하는 약점 때문에 보안 결함과 오류를 종종 초래한다고 보여주었다. 잘 알려진 AI 코딩 도구인 Devin의 최근 테스트에서는 20개의 프로그래밍 작업 중 단지 3개만 완료할 수 있었다.

Microsoft의 연구는 AI 모델이 직면한 이 지속적인 도전에 대한 가장 심층적인 검토 중 하나를 제공한다. AI 기반 코딩 도구에 대한 투자자 관심을 억제할 가능성은 낮지만, 개발자와 그들의 리더들이 코딩 작업에 AI를 크게 의존하는 것을 재고하게 만들 수 있다.

특히, 여러 기술 리더들은 AI가 코딩 직업을 없애줄 것이라는 생각에 반대해 왔다. Microsoft 공동 창립자 Bill Gates, Replit CEO Amjad Masad, Okta CEO Todd McKinnon, IBM CEO Arvind Krishna는 모두 프로그래밍이 직업으로서 지속될 것이라는 자신감을 표명했다.

보안 침해에서 민감한 지메일 데이터를 훔치는 데 악용된 ChatGPT

보안 경보: 연구원, AI 기반 데이터 유출 기법 시연사이버 보안 전문가들은 최근 ChatGPT의 딥 리서치 기능을 조작하여 기밀 Gmail 데이터를 조용히 추출할 수 있는 우려스러운 취약점을 발견했습니다. 이후 OpenAI는 이 특정 익스플로잇을 패치했지만, 이 사건은 자율 AI 시스템이 제기하는 새로운 보안 문제를 강조합니다.섀도 유출 익스플로잇 메커니

보안 침해에서 민감한 지메일 데이터를 훔치는 데 악용된 ChatGPT

보안 경보: 연구원, AI 기반 데이터 유출 기법 시연사이버 보안 전문가들은 최근 ChatGPT의 딥 리서치 기능을 조작하여 기밀 Gmail 데이터를 조용히 추출할 수 있는 우려스러운 취약점을 발견했습니다. 이후 OpenAI는 이 특정 익스플로잇을 패치했지만, 이 사건은 자율 AI 시스템이 제기하는 새로운 보안 문제를 강조합니다.섀도 유출 익스플로잇 메커니

앤트로픽, 법적 소송에서 클로드 AI 오류 인정, "당황스럽고 의도치 않은 실수"

음악 퍼블리셔와 진행 중인 법적 분쟁에서 AI가 생성한 소스에 대한 비난이 제기된 가운데, Anthropic은 이 사건을 자사의 Claude 챗봇이 저지른 '의도치 않은 인용 오류'로 규정하고 해명했습니다.논란이 된 인용은 4월 30일 Anthropic의 데이터 과학자 올리비아 첸이 제출한 법적 서류에 나타난 것으로, Claude가 저작권이 있는 노래

앤트로픽, 법적 소송에서 클로드 AI 오류 인정, "당황스럽고 의도치 않은 실수"

음악 퍼블리셔와 진행 중인 법적 분쟁에서 AI가 생성한 소스에 대한 비난이 제기된 가운데, Anthropic은 이 사건을 자사의 Claude 챗봇이 저지른 '의도치 않은 인용 오류'로 규정하고 해명했습니다.논란이 된 인용은 4월 30일 Anthropic의 데이터 과학자 올리비아 첸이 제출한 법적 서류에 나타난 것으로, Claude가 저작권이 있는 노래

Gmail, AI 기반 자동 이메일 요약 기능 출시

Workspace 사용자에게 제공되는 Gemini 기반 이메일 요약 기능Gmail이 복잡한 이메일 스레드에 대한 요약을 자동으로 생성하기 시작하면서 받은 편지함 관리에서 Gemini의 역할이 강화된 것을 Google Workspace 가입자는 알게 될 것입니다. 이제 AI가 생성한 요약은 사용자가 시작할 필요 없이 메시지 내용 바로 위에 표시됩니다.

Gmail, AI 기반 자동 이메일 요약 기능 출시

Workspace 사용자에게 제공되는 Gemini 기반 이메일 요약 기능Gmail이 복잡한 이메일 스레드에 대한 요약을 자동으로 생성하기 시작하면서 받은 편지함 관리에서 Gemini의 역할이 강화된 것을 Google Workspace 가입자는 알게 될 것입니다. 이제 AI가 생성한 요약은 사용자가 시작할 필요 없이 메시지 내용 바로 위에 표시됩니다.

2025년 9월 7일 오후 1시 30분 35초 GMT+09:00

2025년 9월 7일 오후 1시 30분 35초 GMT+09:00

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

2025년 8월 17일 오후 2시 0분 59초 GMT+09:00

2025년 8월 17일 오후 2시 0분 59초 GMT+09:00

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

2025년 8월 14일 오후 4시 0분 59초 GMT+09:00

2025년 8월 14일 오후 4시 0분 59초 GMT+09:00

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

2025년 8월 10일 오전 6시 0분 59초 GMT+09:00

2025년 8월 10일 오전 6시 0분 59초 GMT+09:00

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

2025년 8월 1일 오전 11시 48분 18초 GMT+09:00

2025년 8월 1일 오전 11시 48분 18초 GMT+09:00

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

2025년 7월 23일 오후 1시 59분 29초 GMT+09:00

2025년 7월 23일 오후 1시 59분 29초 GMT+09:00

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0