Estudo da Microsoft Revela Limitações de Modelos de IA na Depuração de Software

Modelos de IA da OpenAI, Anthropic e outros laboratórios de IA líderes estão sendo cada vez mais utilizados para tarefas de codificação. O CEO da Google, Sundar Pichai, observou em outubro que a IA gera 25% do novo código na empresa, enquanto o CEO da Meta, Mark Zuckerberg, pretende implementar amplamente ferramentas de codificação por IA na gigante das redes sociais.

No entanto, mesmo os modelos de melhor desempenho têm dificuldades para corrigir bugs de software que desenvolvedores experientes lidam com facilidade.

Um recente estudo da Microsoft Research, conduzido pela divisão de P&D da Microsoft, mostra que modelos como o Claude 3.7 Sonnet da Anthropic e o o3-mini da OpenAI têm dificuldades para resolver muitos problemas no benchmark de desenvolvimento de software SWE-bench Lite. As descobertas destacam que, apesar das afirmações ambiciosas de empresas como a OpenAI, a IA ainda fica aquém da expertise humana em áreas como codificação.

Os pesquisadores do estudo testaram nove modelos como base para um “agente baseado em prompt único” equipado com ferramentas de depuração, incluindo um depurador Python. O agente foi encarregado de abordar 300 desafios de depuração de software selecionados do SWE-bench Lite.

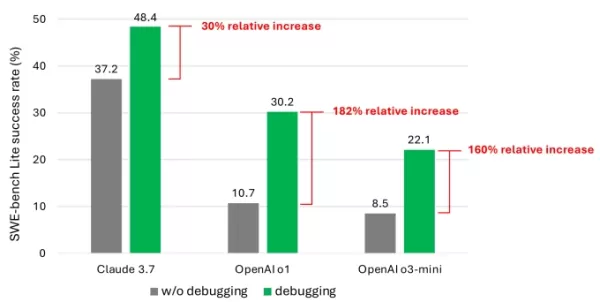

Os resultados mostraram que, mesmo com modelos avançados, o agente raramente resolveu mais da metade das tarefas com sucesso. O Claude 3.7 Sonnet liderou com uma taxa de sucesso de 48,4%, seguido pelo o1 da OpenAI com 30,2% e o o3-mini com 22,1%.

Um gráfico do estudo mostrando o aumento de desempenho que os modelos obtiveram com ferramentas de depuração. Créditos da imagem: Microsoft O que explica os resultados decepcionantes? Alguns modelos tiveram dificuldades para usar efetivamente as ferramentas de depuração disponíveis ou identificar quais ferramentas eram adequadas para problemas específicos. O principal problema, segundo os pesquisadores, foi a falta de dados de treinamento suficientes, particularmente dados que capturam “processos de tomada de decisão sequencial” como rastros de depuração humana.

“Acreditamos que treinar ou ajustar esses modelos pode melhorar suas capacidades de depuração”, escreveram os pesquisadores. “No entanto, isso requer dados especializados, como dados de trajetória que capturam agentes interagindo com um depurador para coletar informações antes de propor correções.”

Participe das Sessões TechCrunch: IA

Reserve seu lugar em nosso principal evento da indústria de IA, com palestrantes da OpenAI, Anthropic e Cohere. Por tempo limitado, os ingressos custam apenas $292 para um dia inteiro de palestras de especialistas, workshops e oportunidades de networking.

Exiba no TechCrunch Sessions: IA

Reserve seu espaço no TC Sessions: IA para apresentar seu trabalho a mais de 1.200 tomadores de decisão. Oportunidades de exposição estão disponíveis até 9 de maio ou até que as mesas estejam totalmente reservadas.

As descobertas não são surpreendentes. Numerosos estudos mostraram que o código gerado por IA frequentemente introduz falhas de segurança e erros devido a fraquezas na compreensão da lógica de programação. Um teste recente do Devin, uma conhecida ferramenta de codificação por IA, revelou que ela só conseguiu completar três de 20 tarefas de programação.

O estudo da Microsoft oferece uma das análises mais aprofundadas desse desafio contínuo para modelos de IA. Embora seja improvável que isso reduza o interesse dos investidores em ferramentas de codificação alimentadas por IA, pode levar desenvolvedores e seus líderes a reconsiderarem a dependência excessiva em IA para tarefas de codificação.

Notavelmente, vários líderes de tecnologia refutaram a ideia de que a IA eliminará empregos de codificação. O cofundador da Microsoft, Bill Gates, o CEO da Replit, Amjad Masad, o CEO da Okta, Todd McKinnon, e o CEO da IBM, Arvind Krishna, expressaram confiança de que a programação como profissão perdurará.

Artigo relacionado

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Comentários (6)

0/200

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Comentários (6)

0/200

![ThomasScott]() ThomasScott

ThomasScott

7 de Setembro de 2025 à35 05:30:35 WEST

7 de Setembro de 2025 à35 05:30:35 WEST

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

![HenryWalker]() HenryWalker

HenryWalker

17 de Agosto de 2025 à59 06:00:59 WEST

17 de Agosto de 2025 à59 06:00:59 WEST

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

14 de Agosto de 2025 à59 08:00:59 WEST

14 de Agosto de 2025 à59 08:00:59 WEST

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

![KevinDavis]() KevinDavis

KevinDavis

9 de Agosto de 2025 à59 22:00:59 WEST

9 de Agosto de 2025 à59 22:00:59 WEST

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

![PeterThomas]() PeterThomas

PeterThomas

1 de Agosto de 2025 à18 03:48:18 WEST

1 de Agosto de 2025 à18 03:48:18 WEST

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

![JuanWhite]() JuanWhite

JuanWhite

23 de Julho de 2025 à29 05:59:29 WEST

23 de Julho de 2025 à29 05:59:29 WEST

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0

Modelos de IA da OpenAI, Anthropic e outros laboratórios de IA líderes estão sendo cada vez mais utilizados para tarefas de codificação. O CEO da Google, Sundar Pichai, observou em outubro que a IA gera 25% do novo código na empresa, enquanto o CEO da Meta, Mark Zuckerberg, pretende implementar amplamente ferramentas de codificação por IA na gigante das redes sociais.

No entanto, mesmo os modelos de melhor desempenho têm dificuldades para corrigir bugs de software que desenvolvedores experientes lidam com facilidade.

Um recente estudo da Microsoft Research, conduzido pela divisão de P&D da Microsoft, mostra que modelos como o Claude 3.7 Sonnet da Anthropic e o o3-mini da OpenAI têm dificuldades para resolver muitos problemas no benchmark de desenvolvimento de software SWE-bench Lite. As descobertas destacam que, apesar das afirmações ambiciosas de empresas como a OpenAI, a IA ainda fica aquém da expertise humana em áreas como codificação.

Os pesquisadores do estudo testaram nove modelos como base para um “agente baseado em prompt único” equipado com ferramentas de depuração, incluindo um depurador Python. O agente foi encarregado de abordar 300 desafios de depuração de software selecionados do SWE-bench Lite.

Os resultados mostraram que, mesmo com modelos avançados, o agente raramente resolveu mais da metade das tarefas com sucesso. O Claude 3.7 Sonnet liderou com uma taxa de sucesso de 48,4%, seguido pelo o1 da OpenAI com 30,2% e o o3-mini com 22,1%.

O que explica os resultados decepcionantes? Alguns modelos tiveram dificuldades para usar efetivamente as ferramentas de depuração disponíveis ou identificar quais ferramentas eram adequadas para problemas específicos. O principal problema, segundo os pesquisadores, foi a falta de dados de treinamento suficientes, particularmente dados que capturam “processos de tomada de decisão sequencial” como rastros de depuração humana.

“Acreditamos que treinar ou ajustar esses modelos pode melhorar suas capacidades de depuração”, escreveram os pesquisadores. “No entanto, isso requer dados especializados, como dados de trajetória que capturam agentes interagindo com um depurador para coletar informações antes de propor correções.”

Participe das Sessões TechCrunch: IA

Reserve seu lugar em nosso principal evento da indústria de IA, com palestrantes da OpenAI, Anthropic e Cohere. Por tempo limitado, os ingressos custam apenas $292 para um dia inteiro de palestras de especialistas, workshops e oportunidades de networking.

Exiba no TechCrunch Sessions: IA

Reserve seu espaço no TC Sessions: IA para apresentar seu trabalho a mais de 1.200 tomadores de decisão. Oportunidades de exposição estão disponíveis até 9 de maio ou até que as mesas estejam totalmente reservadas.

As descobertas não são surpreendentes. Numerosos estudos mostraram que o código gerado por IA frequentemente introduz falhas de segurança e erros devido a fraquezas na compreensão da lógica de programação. Um teste recente do Devin, uma conhecida ferramenta de codificação por IA, revelou que ela só conseguiu completar três de 20 tarefas de programação.

O estudo da Microsoft oferece uma das análises mais aprofundadas desse desafio contínuo para modelos de IA. Embora seja improvável que isso reduza o interesse dos investidores em ferramentas de codificação alimentadas por IA, pode levar desenvolvedores e seus líderes a reconsiderarem a dependência excessiva em IA para tarefas de codificação.

Notavelmente, vários líderes de tecnologia refutaram a ideia de que a IA eliminará empregos de codificação. O cofundador da Microsoft, Bill Gates, o CEO da Replit, Amjad Masad, o CEO da Okta, Todd McKinnon, e o CEO da IBM, Arvind Krishna, expressaram confiança de que a programação como profissão perdurará.

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

7 de Setembro de 2025 à35 05:30:35 WEST

7 de Setembro de 2025 à35 05:30:35 WEST

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

17 de Agosto de 2025 à59 06:00:59 WEST

17 de Agosto de 2025 à59 06:00:59 WEST

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

14 de Agosto de 2025 à59 08:00:59 WEST

14 de Agosto de 2025 à59 08:00:59 WEST

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

9 de Agosto de 2025 à59 22:00:59 WEST

9 de Agosto de 2025 à59 22:00:59 WEST

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

1 de Agosto de 2025 à18 03:48:18 WEST

1 de Agosto de 2025 à18 03:48:18 WEST

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

23 de Julho de 2025 à29 05:59:29 WEST

23 de Julho de 2025 à29 05:59:29 WEST

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0