微软研究揭示AI模型在软件调试中的局限性

来自OpenAI、Anthropic和其他领先AI实验室的AI模型越来越多地用于编码任务。谷歌首席执行官桑达尔·皮查伊在十月指出,AI在公司中生成25%的新代码,而Meta首席执行官马克·扎克伯格计划在社交媒体巨头内部广泛实施AI编码工具。

然而,即使是表现最好的模型也难以修复经验丰富的开发者轻松处理的软件错误。

微软研发部门近期开展的一项微软研究显示,像Anthropic的Claude 3.7 Sonnet和OpenAI的o3-mini这样的模型在SWE-bench Lite软件开发基准测试中难以解决许多问题。研究结果表明,尽管OpenAI等公司提出了雄心勃勃的主张,AI在编码等领域仍不及人类专长。

研究人员测试了九种模型作为“单一提示代理”的基础,配备了包括Python调试器在内的调试工具。该代理被分配处理SWE-bench Lite中300个精选的软件调试挑战。

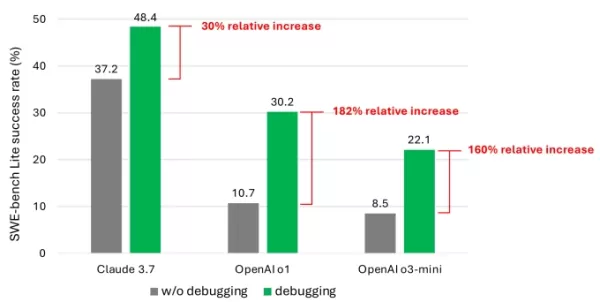

结果显示,即便是使用先进模型,代理也很少能成功解决超过一半的任务。Claude 3.7 Sonnet以48.4%的成功率领先,其次是OpenAI的o1为30.2%,o3-mini为22.1%。

研究中的一张图表,显示调试工具为模型带来的性能提升。图片来源:微软 是什么导致了这些平庸的结果?一些模型难以有效使用可用的调试工具或识别适合特定问题的工具。研究人员认为,主要问题是缺乏足够的训练数据,特别是捕捉“顺序决策过程”的数据,如人类调试轨迹。

“我们相信,通过训练或微调这些模型可以提高它们的调试能力,”研究人员写道。“然而,这需要专门的数据,例如捕捉代理与调试器交互以收集信息并提出修复建议的轨迹数据。”

参加TechCrunch Sessions:AI

预订我们在首屈一指的AI行业活动中的席位,活动将邀请来自OpenAI、Anthropic和Cohere的演讲者。目前票价仅为292美元,可享受全天专家演讲、研讨会和网络交流机会,机会有限。

在TechCrunch Sessions:AI上展示

预订TC Sessions:AI的席位,向超过1200名决策者展示你的工作。展览机会开放至5月9日或展位售罄为止。

这些发现并不令人意外。众多研究表明,AI生成的代码常常因理解编程逻辑的弱点而引入安全漏洞和错误。最近对知名AI编码工具Devin的测试显示,它只能完成20个编程任务中的三个。

微软的研究提供了对AI模型这一持续挑战的最深入检查之一。虽然这不太可能抑制投资者对AI驱动编码工具的兴趣,但可能会促使开发者和他们的领导者重新考虑在编码任务中过度依赖AI。

值得注意的是,几位科技领袖反驳了AI将消灭编码工作的观点。微软联合创始人比尔·盖茨、Replit首席执行官阿姆贾德·马萨德、Okta首席执行官托德·麦金农和IBM首席执行官阿文德·克里希纳均表示对编程作为职业的持久性充满信心。

相关文章

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

Anthropic 在法律文件中承认克劳德人工智能错误,称其 "令人尴尬且非故意"

Anthropic公司在与音乐出版商的法律纠纷中回应了有关人工智能生成的消息来源的指控,称该事件是其克劳德聊天机器人 "无意中的引用错误"。有争议的引用出现在 Anthropic 数据科学家奥利维亚-陈(Olivia Chen)于 4 月 30 日提交的法律文件中,这是该公司针对克劳德使用受版权保护的歌词进行训练的指控进行辩护的一部分。在法庭审理过程中,代表环球音乐集团(Universal M

Anthropic 在法律文件中承认克劳德人工智能错误,称其 "令人尴尬且非故意"

Anthropic公司在与音乐出版商的法律纠纷中回应了有关人工智能生成的消息来源的指控,称该事件是其克劳德聊天机器人 "无意中的引用错误"。有争议的引用出现在 Anthropic 数据科学家奥利维亚-陈(Olivia Chen)于 4 月 30 日提交的法律文件中,这是该公司针对克劳德使用受版权保护的歌词进行训练的指控进行辩护的一部分。在法庭审理过程中,代表环球音乐集团(Universal M

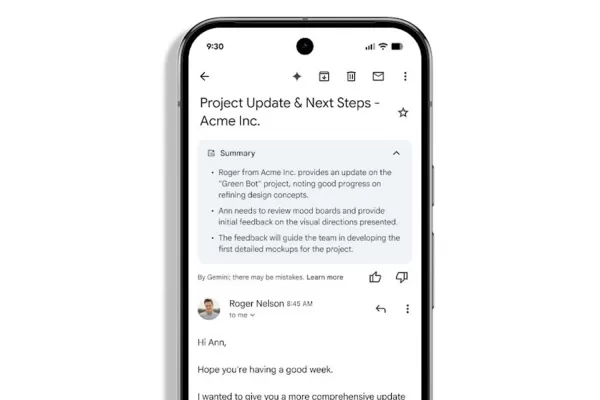

Gmail 推出人工智能驱动的自动电子邮件摘要

工作区用户将使用双子座邮件摘要功能随着 Gmail 开始为复杂的电子邮件线程自动生成摘要,Gemini 在管理收件箱方面的作用将得到增强。这些人工智能生成的摘要现在会直接显示在邮件内容上方,无需用户启动。虽然谷歌去年首次推出了人工智能生成的电子邮件摘要,但该功能以前需要手动激活。升级后的实现采用了人工智能,可以智能地判断摘要何时对用户有益,尤其是对于 "较长的电子邮件线程或有多个回复的邮件

评论 (6)

0/200

Gmail 推出人工智能驱动的自动电子邮件摘要

工作区用户将使用双子座邮件摘要功能随着 Gmail 开始为复杂的电子邮件线程自动生成摘要,Gemini 在管理收件箱方面的作用将得到增强。这些人工智能生成的摘要现在会直接显示在邮件内容上方,无需用户启动。虽然谷歌去年首次推出了人工智能生成的电子邮件摘要,但该功能以前需要手动激活。升级后的实现采用了人工智能,可以智能地判断摘要何时对用户有益,尤其是对于 "较长的电子邮件线程或有多个回复的邮件

评论 (6)

0/200

![ThomasScott]() ThomasScott

ThomasScott

2025-09-07 12:30:35

2025-09-07 12:30:35

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

![HenryWalker]() HenryWalker

HenryWalker

2025-08-17 13:00:59

2025-08-17 13:00:59

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

![BrianRoberts]() BrianRoberts

BrianRoberts

2025-08-14 15:00:59

2025-08-14 15:00:59

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

![KevinDavis]() KevinDavis

KevinDavis

2025-08-10 05:00:59

2025-08-10 05:00:59

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

![PeterThomas]() PeterThomas

PeterThomas

2025-08-01 10:48:18

2025-08-01 10:48:18

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

![JuanWhite]() JuanWhite

JuanWhite

2025-07-23 12:59:29

2025-07-23 12:59:29

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0

来自OpenAI、Anthropic和其他领先AI实验室的AI模型越来越多地用于编码任务。谷歌首席执行官桑达尔·皮查伊在十月指出,AI在公司中生成25%的新代码,而Meta首席执行官马克·扎克伯格计划在社交媒体巨头内部广泛实施AI编码工具。

然而,即使是表现最好的模型也难以修复经验丰富的开发者轻松处理的软件错误。

微软研发部门近期开展的一项微软研究显示,像Anthropic的Claude 3.7 Sonnet和OpenAI的o3-mini这样的模型在SWE-bench Lite软件开发基准测试中难以解决许多问题。研究结果表明,尽管OpenAI等公司提出了雄心勃勃的主张,AI在编码等领域仍不及人类专长。

研究人员测试了九种模型作为“单一提示代理”的基础,配备了包括Python调试器在内的调试工具。该代理被分配处理SWE-bench Lite中300个精选的软件调试挑战。

结果显示,即便是使用先进模型,代理也很少能成功解决超过一半的任务。Claude 3.7 Sonnet以48.4%的成功率领先,其次是OpenAI的o1为30.2%,o3-mini为22.1%。

是什么导致了这些平庸的结果?一些模型难以有效使用可用的调试工具或识别适合特定问题的工具。研究人员认为,主要问题是缺乏足够的训练数据,特别是捕捉“顺序决策过程”的数据,如人类调试轨迹。

“我们相信,通过训练或微调这些模型可以提高它们的调试能力,”研究人员写道。“然而,这需要专门的数据,例如捕捉代理与调试器交互以收集信息并提出修复建议的轨迹数据。”

参加TechCrunch Sessions:AI

预订我们在首屈一指的AI行业活动中的席位,活动将邀请来自OpenAI、Anthropic和Cohere的演讲者。目前票价仅为292美元,可享受全天专家演讲、研讨会和网络交流机会,机会有限。

在TechCrunch Sessions:AI上展示

预订TC Sessions:AI的席位,向超过1200名决策者展示你的工作。展览机会开放至5月9日或展位售罄为止。

这些发现并不令人意外。众多研究表明,AI生成的代码常常因理解编程逻辑的弱点而引入安全漏洞和错误。最近对知名AI编码工具Devin的测试显示,它只能完成20个编程任务中的三个。

微软的研究提供了对AI模型这一持续挑战的最深入检查之一。虽然这不太可能抑制投资者对AI驱动编码工具的兴趣,但可能会促使开发者和他们的领导者重新考虑在编码任务中过度依赖AI。

值得注意的是,几位科技领袖反驳了AI将消灭编码工作的观点。微软联合创始人比尔·盖茨、Replit首席执行官阿姆贾德·马萨德、Okta首席执行官托德·麦金农和IBM首席执行官阿文德·克里希纳均表示对编程作为职业的持久性充满信心。

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

在安全漏洞中利用 ChatGPT 窃取 Gmail 敏感数据

安全警报:研究人员展示人工智能驱动的数据外渗技术网络安全专家最近发现了一个令人担忧的漏洞,即 ChatGPT 的 "深度研究"(Deep Research)功能可被用来悄悄提取 Gmail 的机密数据。虽然 OpenAI 已经修补了这一特定漏洞,但这一事件凸显了自主人工智能系统带来的新安全挑战。影子泄漏漏洞利用机制Radware 的安全分析师开发了这一概念验证攻击,展示了人工智能固有的助人功能如何

Anthropic 在法律文件中承认克劳德人工智能错误,称其 "令人尴尬且非故意"

Anthropic公司在与音乐出版商的法律纠纷中回应了有关人工智能生成的消息来源的指控,称该事件是其克劳德聊天机器人 "无意中的引用错误"。有争议的引用出现在 Anthropic 数据科学家奥利维亚-陈(Olivia Chen)于 4 月 30 日提交的法律文件中,这是该公司针对克劳德使用受版权保护的歌词进行训练的指控进行辩护的一部分。在法庭审理过程中,代表环球音乐集团(Universal M

Anthropic 在法律文件中承认克劳德人工智能错误,称其 "令人尴尬且非故意"

Anthropic公司在与音乐出版商的法律纠纷中回应了有关人工智能生成的消息来源的指控,称该事件是其克劳德聊天机器人 "无意中的引用错误"。有争议的引用出现在 Anthropic 数据科学家奥利维亚-陈(Olivia Chen)于 4 月 30 日提交的法律文件中,这是该公司针对克劳德使用受版权保护的歌词进行训练的指控进行辩护的一部分。在法庭审理过程中,代表环球音乐集团(Universal M

Gmail 推出人工智能驱动的自动电子邮件摘要

工作区用户将使用双子座邮件摘要功能随着 Gmail 开始为复杂的电子邮件线程自动生成摘要,Gemini 在管理收件箱方面的作用将得到增强。这些人工智能生成的摘要现在会直接显示在邮件内容上方,无需用户启动。虽然谷歌去年首次推出了人工智能生成的电子邮件摘要,但该功能以前需要手动激活。升级后的实现采用了人工智能,可以智能地判断摘要何时对用户有益,尤其是对于 "较长的电子邮件线程或有多个回复的邮件

Gmail 推出人工智能驱动的自动电子邮件摘要

工作区用户将使用双子座邮件摘要功能随着 Gmail 开始为复杂的电子邮件线程自动生成摘要,Gemini 在管理收件箱方面的作用将得到增强。这些人工智能生成的摘要现在会直接显示在邮件内容上方,无需用户启动。虽然谷歌去年首次推出了人工智能生成的电子邮件摘要,但该功能以前需要手动激活。升级后的实现采用了人工智能,可以智能地判断摘要何时对用户有益,尤其是对于 "较长的电子邮件线程或有多个回复的邮件

2025-09-07 12:30:35

2025-09-07 12:30:35

微软这个研究结果太真实了😂 前几天用Copilot改bug,它居然把正确代码改得更错了…看来AI写代码还是得人工把关,至少现阶段别太依赖它们debug。

0

0

2025-08-17 13:00:59

2025-08-17 13:00:59

It's wild that AI is pumping out 25% of Google's code, but this Microsoft study shows it's not perfect at debugging. Kinda makes you wonder if we're trusting these models a bit too much too soon. 😅 Anyone else worried about buggy AI code sneaking into big projects?

0

0

2025-08-14 15:00:59

2025-08-14 15:00:59

It's wild that AI is cranking out 25% of Google's code, but the debugging struggles are real. Makes me wonder if we're leaning too hard on AI without fixing its blind spots first. 🧑💻

0

0

2025-08-10 05:00:59

2025-08-10 05:00:59

It's wild that AI is pumping out 25% of Google's code, but the debugging limitations in this study make me wonder if we're leaning too hard on these models without enough human oversight. 🤔

0

0

2025-08-01 10:48:18

2025-08-01 10:48:18

Interesting read! AI generating 25% of Google's code is wild, but I'm not surprised it struggles with debugging. Machines can churn out code fast, but catching tricky bugs? That’s still a human’s game. 🧑💻

0

0

2025-07-23 12:59:29

2025-07-23 12:59:29

AI coding sounds cool, but if it can't debug properly, what's the point? 🤔 Feels like we're hyping up half-baked tools while devs still clean up the mess.

0

0