Clonage vocal par l'IA et escroqueries Deepfake : Comment se prémunir contre la fraude

À mesure que les technologies numériques progressent, les cybercriminels déploient des méthodes de plus en plus sophistiquées, notamment le clonage de la voix par l'IA et la technologie "deepfake". Les organismes chargés de l'application de la loi avertissent que ces outils sont utilisés pour créer des escroqueries hautement personnalisées qui peuvent se faire passer de manière convaincante pour des contacts de confiance. Ce guide complet examine ces menaces émergentes, propose des stratégies de détection et décrit les mesures de protection à prendre pour se prémunir contre les préjudices financiers et personnels.

Points clés

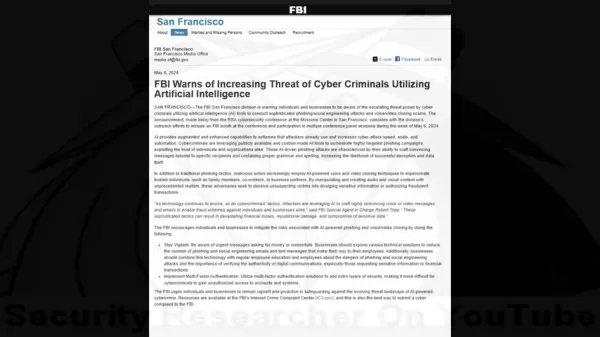

Les alertes du FBI font état d'une augmentation de la cybercriminalité basée sur l'IA et ciblant les particuliers et les organisations.

Les fraudeurs utilisent désormais le clonage de la voix et la technologie des vidéos truquées pour mettre au point des stratagèmes sophistiqués.

La collecte d'informations personnelles permet des attaques d'ingénierie sociale très ciblées.

L'identification des anomalies audio/visuelles reste essentielle pour la détection des escroqueries.

Les systèmes de vérification multicouches et les protocoles de sécurité offrent une protection essentielle.

Une formation complète à la sensibilisation réduit considérablement la vulnérabilité à ces escroqueries.

La menace croissante des escroqueries basées sur l'IA

Comprendre l'avertissement du FBI

La course aux armements numériques entre les professionnels de la sécurité et les cybercriminels est entrée dans une nouvelle phase dangereuse avec l'avènement d'outils d'IA accessibles. Ce qui n'était au départ que des technologies de recherche de niche est devenu une arme puissante entre les mains des fraudeurs.

Les experts en sécurité ont mis en évidence une tendance alarmante où les criminels combinent l'ingénierie sociale traditionnelle avec des médias générés par l'IA pour contourner l'instinct de confiance de l'homme. Les avertissements du FBI soulignent que ces techniques créent des scénarios frauduleux d'une crédibilité sans précédent, capables de vaincre même un scepticisme prudent.

Comment fonctionnent le clonage vocal par l'IA et les imitations profondes ?

Les systèmes de fraude modernes utilisent une combinaison troublante d'apprentissage automatique et de manipulation psychologique. Les attaquants suivent un processus méticuleux pour maximiser leur taux de réussite.

Le cycle de vie de l'attaque comporte généralement trois étapes :

- Collecte de données : Les escrocs recueillent des échantillons de voix dans les médias sociaux, les discours publics ou les appels vidéo.

- Synthèse vocale : Des modèles d'intelligence artificielle analysent les modèles vocaux pour générer des répliques synthétiques.

- Falsification multimédia : Des outils perfectionnés synchronisent de faux sons avec des éléments vidéo manipulés.

Statistiques sur l'impact financier

Les conséquences financières de ces escroqueries fondées sur l'IA démontrent leur efficacité dévastatrice :

- Plus de 100 millions de dollars perdus par les Américains en 2023 à cause d'escroqueries par clonage de voix

- 14 000 $ de perte moyenne par incident

- 1,03 trillion de dollars de pertes annuelles liées à la fraude au niveau mondial

Repérer les escroqueries à l'IA : Stratégies de détection

La méthodologie de l'attaque

Comprendre les tactiques criminelles aide les cibles potentielles à reconnaître les signaux d'alarme :

- Établir la confiance : Utiliser des voix clonées de contacts connus

- Recueillir des renseignements : Recherche de cibles par le biais de l'ingénierie sociale

- Exécuter l'attaque : Déployer des scénarios de tromperie personnalisés

Identifier la manipulation de l'IA

Les signes avant-coureurs des médias synthétiques sont les suivants

- caractéristiques vocales et rythme incohérents

- Modèles de discours ou de phrasé non naturels

- Artéfacts mécaniques dans la qualité audio

- Réponses émotionnelles qui semblent écrites à l'avance

- Erreurs factuelles dans les références personnelles

Contre-mesures de protection

Meilleures pratiques en matière de vérification

Les stratégies défensives doivent comprendre

- une vérification indépendante par le biais de canaux de contact établis

- Codes d'authentification préétablis avec des contacts fréquents

- Confirmation en personne pour les demandes inhabituelles

Renforcement de la sécurité

Les mesures de protection techniques comprennent

- l'authentification multifactorielle obligatoire

- Politiques de rotation régulière des informations d'identification

- Systèmes de contrôle des fraudes

Sensibilisation

Les initiatives en matière d'éducation doivent porter sur les points suivants

- les tactiques d'escroquerie actuelles et les études de cas

- les techniques de manipulation psychologique

- Protocoles de réponse aux communications suspectes

Gestion de la confidentialité des données

Réduire les surfaces d'attaque en

- vérifiant l'exposition aux médias sociaux

- limitant le partage d'informations personnelles

- mettant en œuvre des politiques strictes de traitement des données

Avantages et défis

Avantages

Création d'usurpations d'identité très réalistes

Déclenche des réactions de confiance instinctives

Produit un contenu multimédia convaincant

Inconvénients

Risque de pertes financières importantes

Atteinte à la psychologie et à la réputation

Érosion des écosystèmes de confiance numériques

Questions fréquemment posées

Comment fonctionne le clonage vocal par IA ?

La technologie analyse des échantillons de voix pour créer des répliques synthétiques qui imitent les schémas d'élocution, le ton et la cadence, ce qui permet des imitations convaincantes.

Quels sont les indicateurs des vidéos "deepfake" ?

Il faut rechercher des mouvements faciaux non naturels, des éclairages et des tons de peau incohérents, ainsi que des artefacts sur les bords ou pendant les mouvements.

Comment dois-je réagir aux appels de détresse suspects ?

Vérifiez par plusieurs canaux indépendants avant d'agir ou de fournir des informations.

Questions connexes

Les deepfakes d'IA sont-ils illégaux ?

Le statut juridique varie en fonction de la juridiction et du contexte d'utilisation. La plupart des pays interdisent les deepfakes utilisés à des fins de fraude, de harcèlement ou de contenu non consensuel.

Qu'est-ce qui protège les entreprises de la fraude par l'IA ?

Les principales protections comprennent la formation des employés, les garanties techniques, les protocoles de vérification et la planification des interventions en cas d'incident.

Article connexe

North.Cloud obtient 5 millions de dollars pour révolutionner le Cloud FinOps avec un système d'exploitation basé sur l'IA

North.Cloud obtient un financement de série A de 5 millions de dollars pour être le pionnier de la gestion de l'infrastructure cloud de nouvelle générationNorth.Cloud, leader de l'optimisation du cl

North.Cloud obtient 5 millions de dollars pour révolutionner le Cloud FinOps avec un système d'exploitation basé sur l'IA

North.Cloud obtient un financement de série A de 5 millions de dollars pour être le pionnier de la gestion de l'infrastructure cloud de nouvelle générationNorth.Cloud, leader de l'optimisation du cl

Artifism Review : Script SaaS générateur de contenu et d'images alimenté par l'IA

Dans l'écosystème numérique d'aujourd'hui, axé sur le contenu, la production constante de matériel de haute qualité présente des défis importants pour les créateurs et les spécialistes du marketing. L

Artifism Review : Script SaaS générateur de contenu et d'images alimenté par l'IA

Dans l'écosystème numérique d'aujourd'hui, axé sur le contenu, la production constante de matériel de haute qualité présente des défis importants pour les créateurs et les spécialistes du marketing. L

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

commentaires (0)

0/200

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

commentaires (0)

0/200

À mesure que les technologies numériques progressent, les cybercriminels déploient des méthodes de plus en plus sophistiquées, notamment le clonage de la voix par l'IA et la technologie "deepfake". Les organismes chargés de l'application de la loi avertissent que ces outils sont utilisés pour créer des escroqueries hautement personnalisées qui peuvent se faire passer de manière convaincante pour des contacts de confiance. Ce guide complet examine ces menaces émergentes, propose des stratégies de détection et décrit les mesures de protection à prendre pour se prémunir contre les préjudices financiers et personnels.

Points clés

Les alertes du FBI font état d'une augmentation de la cybercriminalité basée sur l'IA et ciblant les particuliers et les organisations.

Les fraudeurs utilisent désormais le clonage de la voix et la technologie des vidéos truquées pour mettre au point des stratagèmes sophistiqués.

La collecte d'informations personnelles permet des attaques d'ingénierie sociale très ciblées.

L'identification des anomalies audio/visuelles reste essentielle pour la détection des escroqueries.

Les systèmes de vérification multicouches et les protocoles de sécurité offrent une protection essentielle.

Une formation complète à la sensibilisation réduit considérablement la vulnérabilité à ces escroqueries.

La menace croissante des escroqueries basées sur l'IA

Comprendre l'avertissement du FBI

La course aux armements numériques entre les professionnels de la sécurité et les cybercriminels est entrée dans une nouvelle phase dangereuse avec l'avènement d'outils d'IA accessibles. Ce qui n'était au départ que des technologies de recherche de niche est devenu une arme puissante entre les mains des fraudeurs.

Les experts en sécurité ont mis en évidence une tendance alarmante où les criminels combinent l'ingénierie sociale traditionnelle avec des médias générés par l'IA pour contourner l'instinct de confiance de l'homme. Les avertissements du FBI soulignent que ces techniques créent des scénarios frauduleux d'une crédibilité sans précédent, capables de vaincre même un scepticisme prudent.

Comment fonctionnent le clonage vocal par l'IA et les imitations profondes ?

Les systèmes de fraude modernes utilisent une combinaison troublante d'apprentissage automatique et de manipulation psychologique. Les attaquants suivent un processus méticuleux pour maximiser leur taux de réussite.

Le cycle de vie de l'attaque comporte généralement trois étapes :

- Collecte de données : Les escrocs recueillent des échantillons de voix dans les médias sociaux, les discours publics ou les appels vidéo.

- Synthèse vocale : Des modèles d'intelligence artificielle analysent les modèles vocaux pour générer des répliques synthétiques.

- Falsification multimédia : Des outils perfectionnés synchronisent de faux sons avec des éléments vidéo manipulés.

Statistiques sur l'impact financier

Les conséquences financières de ces escroqueries fondées sur l'IA démontrent leur efficacité dévastatrice :

- Plus de 100 millions de dollars perdus par les Américains en 2023 à cause d'escroqueries par clonage de voix

- 14 000 $ de perte moyenne par incident

- 1,03 trillion de dollars de pertes annuelles liées à la fraude au niveau mondial

Repérer les escroqueries à l'IA : Stratégies de détection

La méthodologie de l'attaque

Comprendre les tactiques criminelles aide les cibles potentielles à reconnaître les signaux d'alarme :

- Établir la confiance : Utiliser des voix clonées de contacts connus

- Recueillir des renseignements : Recherche de cibles par le biais de l'ingénierie sociale

- Exécuter l'attaque : Déployer des scénarios de tromperie personnalisés

Identifier la manipulation de l'IA

Les signes avant-coureurs des médias synthétiques sont les suivants

- caractéristiques vocales et rythme incohérents

- Modèles de discours ou de phrasé non naturels

- Artéfacts mécaniques dans la qualité audio

- Réponses émotionnelles qui semblent écrites à l'avance

- Erreurs factuelles dans les références personnelles

Contre-mesures de protection

Meilleures pratiques en matière de vérification

Les stratégies défensives doivent comprendre

- une vérification indépendante par le biais de canaux de contact établis

- Codes d'authentification préétablis avec des contacts fréquents

- Confirmation en personne pour les demandes inhabituelles

Renforcement de la sécurité

Les mesures de protection techniques comprennent

- l'authentification multifactorielle obligatoire

- Politiques de rotation régulière des informations d'identification

- Systèmes de contrôle des fraudes

Sensibilisation

Les initiatives en matière d'éducation doivent porter sur les points suivants

- les tactiques d'escroquerie actuelles et les études de cas

- les techniques de manipulation psychologique

- Protocoles de réponse aux communications suspectes

Gestion de la confidentialité des données

Réduire les surfaces d'attaque en

- vérifiant l'exposition aux médias sociaux

- limitant le partage d'informations personnelles

- mettant en œuvre des politiques strictes de traitement des données

Avantages et défis

Avantages

Création d'usurpations d'identité très réalistes

Déclenche des réactions de confiance instinctives

Produit un contenu multimédia convaincant

Inconvénients

Risque de pertes financières importantes

Atteinte à la psychologie et à la réputation

Érosion des écosystèmes de confiance numériques

Questions fréquemment posées

Comment fonctionne le clonage vocal par IA ?

La technologie analyse des échantillons de voix pour créer des répliques synthétiques qui imitent les schémas d'élocution, le ton et la cadence, ce qui permet des imitations convaincantes.

Quels sont les indicateurs des vidéos "deepfake" ?

Il faut rechercher des mouvements faciaux non naturels, des éclairages et des tons de peau incohérents, ainsi que des artefacts sur les bords ou pendant les mouvements.

Comment dois-je réagir aux appels de détresse suspects ?

Vérifiez par plusieurs canaux indépendants avant d'agir ou de fournir des informations.

Questions connexes

Les deepfakes d'IA sont-ils illégaux ?

Le statut juridique varie en fonction de la juridiction et du contexte d'utilisation. La plupart des pays interdisent les deepfakes utilisés à des fins de fraude, de harcèlement ou de contenu non consensuel.

Qu'est-ce qui protège les entreprises de la fraude par l'IA ?

Les principales protections comprennent la formation des employés, les garanties techniques, les protocoles de vérification et la planification des interventions en cas d'incident.

Artifism Review : Script SaaS générateur de contenu et d'images alimenté par l'IA

Dans l'écosystème numérique d'aujourd'hui, axé sur le contenu, la production constante de matériel de haute qualité présente des défis importants pour les créateurs et les spécialistes du marketing. L

Artifism Review : Script SaaS générateur de contenu et d'images alimenté par l'IA

Dans l'écosystème numérique d'aujourd'hui, axé sur le contenu, la production constante de matériel de haute qualité présente des défis importants pour les créateurs et les spécialistes du marketing. L

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google

Google AI Ultra dévoilé : Abonnement Premium à 249,99 $ par mois

Google dévoile l'abonnement Premium AI UltraLors de la conférence Google I/O 2025, le géant de la technologie a annoncé son nouveau service complet d'abonnement à l'intelligence artificielle - Google