AI Voice Cloning und Deepfake-Betrug: Wie Sie sich vor Betrug schützen können

Im Zuge des Fortschritts der digitalen Technologien setzen Cyberkriminelle immer ausgefeiltere Methoden ein, darunter KI-gestütztes Stimmenklonen und Deepfake-Technologie. Die Strafverfolgungsbehörden warnen, dass diese Tools als Waffe eingesetzt werden, um hochgradig personalisierte Betrügereien zu erstellen, die sich überzeugend als vertrauenswürdige Kontakte ausgeben können. Dieser umfassende Leitfaden untersucht diese aufkommenden Bedrohungen, bietet Erkennungsstrategien und zeigt Schutzmaßnahmen auf, um sich vor finanziellen und persönlichen Schäden zu schützen.

Wichtige Punkte

FBI-Warnungen weisen auf zunehmende KI-gestützte Cyberkriminalität hin, die sich gegen Einzelpersonen und Organisationen richtet.

Betrüger nutzen jetzt Stimmenklonen und Deepfake-Videotechnologie für ausgeklügelte Betrügereien.

Das Auslesen persönlicher Daten ermöglicht gezielte Social-Engineering-Angriffe.

Die Erkennung von audio-visuellen Anomalien ist nach wie vor entscheidend für die Betrugserkennung.

Mehrschichtige Überprüfungssysteme und Sicherheitsprotokolle bieten einen wesentlichen Schutz.

Umfassende Sensibilisierungsschulungen verringern die Anfälligkeit für diese Betrügereien erheblich.

Die wachsende Bedrohung durch KI-gestützte Betrügereien

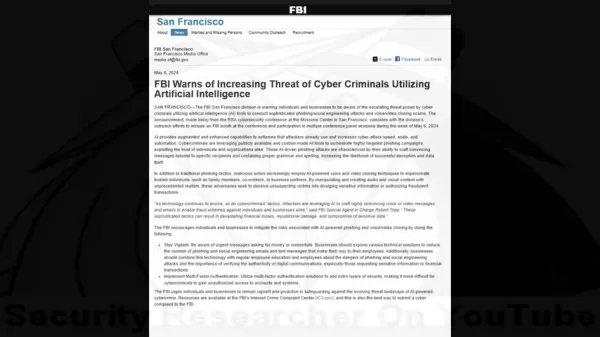

Die Warnung des FBI verstehen

Das digitale Wettrüsten zwischen Sicherheitsexperten und Cyberkriminellen ist mit dem Aufkommen zugänglicher KI-Tools in eine gefährliche neue Phase getreten. Was als Nischenforschungstechnologie begann, hat sich zu einer mächtigen Waffe in den Händen von Betrügern entwickelt.

Sicherheitsexperten haben einen alarmierenden Trend dokumentiert, bei dem Kriminelle traditionelles Social Engineering mit KI-generierten Medien kombinieren, um den menschlichen Instinkt für Vertrauen zu umgehen. Die Warnungen des FBI verdeutlichen, wie diese Techniken Betrugsszenarien von beispielloser Glaubwürdigkeit schaffen, die selbst vorsichtige Skepsis überwinden können.

Wie AI Voice Cloning und Deepfakes funktionieren

Moderne Betrugsmethoden nutzen eine beunruhigende Kombination aus maschinellem Lernen und psychologischer Manipulation. Die Angreifer folgen einem akribischen Prozess, um ihre Erfolgsquote zu maximieren.

Der Lebenszyklus eines Angriffs umfasst in der Regel drei Phasen:

- Datenerfassung: Die Betrüger sammeln Stimmproben aus sozialen Medien, öffentlichen Reden oder Videoanrufen

- Sprachsynthese: KI-Modelle analysieren Sprachmuster, um synthetische Replikate zu erzeugen

- Multimedia-Fälschung: Hochentwickelte Tools synchronisieren gefälschten Ton mit manipulierten Videoelementen

Statistiken zu den finanziellen Auswirkungen

Die finanziellen Folgen dieser KI-gestützten Betrügereien zeigen ihre verheerende Wirksamkeit:

- Amerikaner verlieren im Jahr 2023 mehr als 100 Millionen Dollar durch Stimmenklon-Betrug

- 14.000 $ durchschnittlicher Verlust pro Vorfall

- 1,03 Billionen Dollar weltweite Betrugsverluste jährlich

Erkennen von AI-Betrug: Erkennungsstrategien

Die Angriffsmethode

Ein Verständnis der kriminellen Taktiken hilft potenziellen Zielen, rote Fahnen zu erkennen:

- Vertrauen aufbauen: Geklonte Stimmen von bekannten Kontakten verwenden

- Informationen sammeln: Ziele durch Social Engineering ausforschen

- Angriff ausführen: Einsatz von personalisierten Täuschungsszenarien

Erkennen von KI-Manipulation

Zu den Warnzeichen für synthetische Medien gehören:

- Inkonsistente Stimmcharakteristik und -tempo

- Unnatürliche Sprachmuster oder Phrasierung

- Mechanische Artefakte in der Audioqualität

- Emotionale Reaktionen, die wie ein Drehbuch wirken

- Sachliche Fehler in persönlichen Bezügen

Schützende Gegenmaßnahmen

Bewährte Praktiken der Verifizierung

Defensivstrategien sollten Folgendes beinhalten:

- Unabhängige Überprüfung durch etablierte Kontaktkanäle

- Im Voraus vereinbarte Authentifizierungscodes bei häufigen Kontakten

- Persönliche Bestätigung für ungewöhnliche Anfragen

Sicherheitsverbesserungen

Technische Schutzmaßnahmen umfassen:

- Obligatorische Multi-Faktor-Authentifizierung

- Regelmäßige Richtlinien zur Rotation der Zugangsdaten

- Systeme zur Betrugsüberwachung

Bewusstseinsschulung

Schulungsinitiativen sollten Folgendes umfassen:

- Aktuelle Betrugstaktiken und Fallstudien

- Psychologische Manipulationstechniken

- Reaktionsprotokolle für verdächtige Mitteilungen

Management des Datenschutzes

Verringern Sie Angriffsflächen durch:

- Überprüfung des Engagements in sozialen Medien

- Einschränkung der Weitergabe persönlicher Informationen

- Implementierung strenger Richtlinien für den Umgang mit Daten

Vorteile und Herausforderungen

Vorteile

Erzeugt äußerst realistische Imitationen

Löst instinktive Vertrauensreaktionen aus

Produziert überzeugende Multimedia-Inhalte

Nachteile

Potenziell erheblicher finanzieller Verlust

Psychologischer und rufschädigender Schaden

Erosion des digitalen Vertrauensökosystems

Häufig gestellte Fragen

Wie funktioniert das Klonen von KI-Stimmen?

Die Technologie analysiert Stimmproben, um synthetische Nachbildungen zu erstellen, die Sprachmuster, Tonfall und Kadenz imitieren und so überzeugende Imitationen ermöglichen.

Was sind Anzeichen für gefälschte Videos?

Achten Sie auf unnatürliche Gesichtsbewegungen, ungleichmäßige Beleuchtung/Hauttöne und Artefakte an den Rändern oder bei Bewegungen.

Wie sollte ich auf verdächtige Notrufe reagieren?

Überprüfen Sie den Sachverhalt über mehrere unabhängige Kanäle, bevor Sie Maßnahmen ergreifen oder Informationen weitergeben.

Verwandte Fragen

Sind KI-Deefakes illegal?

Der rechtliche Status variiert je nach Gerichtsbarkeit und Nutzungskontext. Die meisten Länder verbieten Deepfakes, die für Betrug, Belästigung oder nicht einvernehmliche Inhalte verwendet werden.

Wie können sich Unternehmen vor KI-Betrug schützen?

Zu den wichtigsten Schutzmaßnahmen gehören Mitarbeiterschulungen, technische Sicherheitsvorkehrungen, Überprüfungsprotokolle und die Planung von Reaktionen auf Vorfälle.

Verwandter Artikel

North.Cloud sichert sich 5 Millionen Dollar für die Revolutionierung von Cloud-FinOps mit einem KI-gesteuerten Betriebssystem

North.Cloud sichert sich 5 Millionen Dollar in der Serie A, um das Cloud-Infrastrukturmanagement der nächsten Generation voranzutreibenDas führende Unternehmen für Cloud-Optimierung North.Cloud hat

North.Cloud sichert sich 5 Millionen Dollar für die Revolutionierung von Cloud-FinOps mit einem KI-gesteuerten Betriebssystem

North.Cloud sichert sich 5 Millionen Dollar in der Serie A, um das Cloud-Infrastrukturmanagement der nächsten Generation voranzutreibenDas führende Unternehmen für Cloud-Optimierung North.Cloud hat

Artifism Überprüfung: KI-gesteuerter Inhalts- & Bildgenerator SaaS Script

Im heutigen inhaltsgesteuerten digitalen Ökosystem stellt die konsistente Erstellung von qualitativ hochwertigem Material sowohl für Kreative als auch für Vermarkter eine große Herausforderung dar. Da

Artifism Überprüfung: KI-gesteuerter Inhalts- & Bildgenerator SaaS Script

Im heutigen inhaltsgesteuerten digitalen Ökosystem stellt die konsistente Erstellung von qualitativ hochwertigem Material sowohl für Kreative als auch für Vermarkter eine große Herausforderung dar. Da

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Kommentare (0)

0/200

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Kommentare (0)

0/200

Im Zuge des Fortschritts der digitalen Technologien setzen Cyberkriminelle immer ausgefeiltere Methoden ein, darunter KI-gestütztes Stimmenklonen und Deepfake-Technologie. Die Strafverfolgungsbehörden warnen, dass diese Tools als Waffe eingesetzt werden, um hochgradig personalisierte Betrügereien zu erstellen, die sich überzeugend als vertrauenswürdige Kontakte ausgeben können. Dieser umfassende Leitfaden untersucht diese aufkommenden Bedrohungen, bietet Erkennungsstrategien und zeigt Schutzmaßnahmen auf, um sich vor finanziellen und persönlichen Schäden zu schützen.

Wichtige Punkte

FBI-Warnungen weisen auf zunehmende KI-gestützte Cyberkriminalität hin, die sich gegen Einzelpersonen und Organisationen richtet.

Betrüger nutzen jetzt Stimmenklonen und Deepfake-Videotechnologie für ausgeklügelte Betrügereien.

Das Auslesen persönlicher Daten ermöglicht gezielte Social-Engineering-Angriffe.

Die Erkennung von audio-visuellen Anomalien ist nach wie vor entscheidend für die Betrugserkennung.

Mehrschichtige Überprüfungssysteme und Sicherheitsprotokolle bieten einen wesentlichen Schutz.

Umfassende Sensibilisierungsschulungen verringern die Anfälligkeit für diese Betrügereien erheblich.

Die wachsende Bedrohung durch KI-gestützte Betrügereien

Die Warnung des FBI verstehen

Das digitale Wettrüsten zwischen Sicherheitsexperten und Cyberkriminellen ist mit dem Aufkommen zugänglicher KI-Tools in eine gefährliche neue Phase getreten. Was als Nischenforschungstechnologie begann, hat sich zu einer mächtigen Waffe in den Händen von Betrügern entwickelt.

Sicherheitsexperten haben einen alarmierenden Trend dokumentiert, bei dem Kriminelle traditionelles Social Engineering mit KI-generierten Medien kombinieren, um den menschlichen Instinkt für Vertrauen zu umgehen. Die Warnungen des FBI verdeutlichen, wie diese Techniken Betrugsszenarien von beispielloser Glaubwürdigkeit schaffen, die selbst vorsichtige Skepsis überwinden können.

Wie AI Voice Cloning und Deepfakes funktionieren

Moderne Betrugsmethoden nutzen eine beunruhigende Kombination aus maschinellem Lernen und psychologischer Manipulation. Die Angreifer folgen einem akribischen Prozess, um ihre Erfolgsquote zu maximieren.

Der Lebenszyklus eines Angriffs umfasst in der Regel drei Phasen:

- Datenerfassung: Die Betrüger sammeln Stimmproben aus sozialen Medien, öffentlichen Reden oder Videoanrufen

- Sprachsynthese: KI-Modelle analysieren Sprachmuster, um synthetische Replikate zu erzeugen

- Multimedia-Fälschung: Hochentwickelte Tools synchronisieren gefälschten Ton mit manipulierten Videoelementen

Statistiken zu den finanziellen Auswirkungen

Die finanziellen Folgen dieser KI-gestützten Betrügereien zeigen ihre verheerende Wirksamkeit:

- Amerikaner verlieren im Jahr 2023 mehr als 100 Millionen Dollar durch Stimmenklon-Betrug

- 14.000 $ durchschnittlicher Verlust pro Vorfall

- 1,03 Billionen Dollar weltweite Betrugsverluste jährlich

Erkennen von AI-Betrug: Erkennungsstrategien

Die Angriffsmethode

Ein Verständnis der kriminellen Taktiken hilft potenziellen Zielen, rote Fahnen zu erkennen:

- Vertrauen aufbauen: Geklonte Stimmen von bekannten Kontakten verwenden

- Informationen sammeln: Ziele durch Social Engineering ausforschen

- Angriff ausführen: Einsatz von personalisierten Täuschungsszenarien

Erkennen von KI-Manipulation

Zu den Warnzeichen für synthetische Medien gehören:

- Inkonsistente Stimmcharakteristik und -tempo

- Unnatürliche Sprachmuster oder Phrasierung

- Mechanische Artefakte in der Audioqualität

- Emotionale Reaktionen, die wie ein Drehbuch wirken

- Sachliche Fehler in persönlichen Bezügen

Schützende Gegenmaßnahmen

Bewährte Praktiken der Verifizierung

Defensivstrategien sollten Folgendes beinhalten:

- Unabhängige Überprüfung durch etablierte Kontaktkanäle

- Im Voraus vereinbarte Authentifizierungscodes bei häufigen Kontakten

- Persönliche Bestätigung für ungewöhnliche Anfragen

Sicherheitsverbesserungen

Technische Schutzmaßnahmen umfassen:

- Obligatorische Multi-Faktor-Authentifizierung

- Regelmäßige Richtlinien zur Rotation der Zugangsdaten

- Systeme zur Betrugsüberwachung

Bewusstseinsschulung

Schulungsinitiativen sollten Folgendes umfassen:

- Aktuelle Betrugstaktiken und Fallstudien

- Psychologische Manipulationstechniken

- Reaktionsprotokolle für verdächtige Mitteilungen

Management des Datenschutzes

Verringern Sie Angriffsflächen durch:

- Überprüfung des Engagements in sozialen Medien

- Einschränkung der Weitergabe persönlicher Informationen

- Implementierung strenger Richtlinien für den Umgang mit Daten

Vorteile und Herausforderungen

Vorteile

Erzeugt äußerst realistische Imitationen

Löst instinktive Vertrauensreaktionen aus

Produziert überzeugende Multimedia-Inhalte

Nachteile

Potenziell erheblicher finanzieller Verlust

Psychologischer und rufschädigender Schaden

Erosion des digitalen Vertrauensökosystems

Häufig gestellte Fragen

Wie funktioniert das Klonen von KI-Stimmen?

Die Technologie analysiert Stimmproben, um synthetische Nachbildungen zu erstellen, die Sprachmuster, Tonfall und Kadenz imitieren und so überzeugende Imitationen ermöglichen.

Was sind Anzeichen für gefälschte Videos?

Achten Sie auf unnatürliche Gesichtsbewegungen, ungleichmäßige Beleuchtung/Hauttöne und Artefakte an den Rändern oder bei Bewegungen.

Wie sollte ich auf verdächtige Notrufe reagieren?

Überprüfen Sie den Sachverhalt über mehrere unabhängige Kanäle, bevor Sie Maßnahmen ergreifen oder Informationen weitergeben.

Verwandte Fragen

Sind KI-Deefakes illegal?

Der rechtliche Status variiert je nach Gerichtsbarkeit und Nutzungskontext. Die meisten Länder verbieten Deepfakes, die für Betrug, Belästigung oder nicht einvernehmliche Inhalte verwendet werden.

Wie können sich Unternehmen vor KI-Betrug schützen?

Zu den wichtigsten Schutzmaßnahmen gehören Mitarbeiterschulungen, technische Sicherheitsvorkehrungen, Überprüfungsprotokolle und die Planung von Reaktionen auf Vorfälle.

Artifism Überprüfung: KI-gesteuerter Inhalts- & Bildgenerator SaaS Script

Im heutigen inhaltsgesteuerten digitalen Ökosystem stellt die konsistente Erstellung von qualitativ hochwertigem Material sowohl für Kreative als auch für Vermarkter eine große Herausforderung dar. Da

Artifism Überprüfung: KI-gesteuerter Inhalts- & Bildgenerator SaaS Script

Im heutigen inhaltsgesteuerten digitalen Ökosystem stellt die konsistente Erstellung von qualitativ hochwertigem Material sowohl für Kreative als auch für Vermarkter eine große Herausforderung dar. Da

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet

Google AI Ultra enthüllt: Premium-Abonnement für $249,99 pro Monat

Google stellt Premium AI Ultra-Abonnement vorAuf der Google I/O 2025 kündigte der Tech-Gigant seinen neuen umfassenden KI-Abonnementdienst an - Google AI Ultra. Zum Preis von 249,99 $ monatlich bietet