Клонирование голоса искусственного интеллекта и мошенничество Deepfake: Как уберечься от мошенничества

По мере развития цифровых технологий киберпреступники применяют все более изощренные методы, включая клонирование голоса с помощью искусственного интеллекта и технологию глубокой подделки. Правоохранительные органы предупреждают, что эти инструменты используются для создания высоко персонализированных афер, которые могут убедительно выдавать себя за доверенных лиц. В этом комплексном руководстве рассматриваются эти новые угрозы, предлагаются стратегии обнаружения и описываются меры защиты от финансового и личного ущерба.

Ключевые моменты

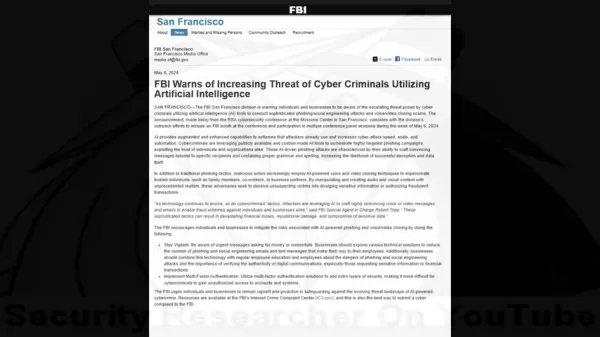

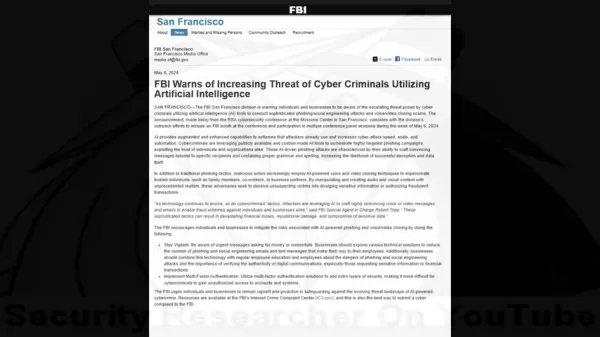

ФБР сообщает о росте числа киберпреступлений с использованием искусственного интеллекта, направленных против частных лиц и организаций.

Мошенники используют клонирование голоса и технологию глубокой подделки видео в сложных схемах.

Сбор личной информации позволяет проводить целенаправленные атаки с использованием социальной инженерии.

Выявление аудио/визуальных аномалий по-прежнему имеет решающее значение для обнаружения мошенничества.

Многоуровневые системы проверки и протоколы безопасности обеспечивают необходимую защиту.

Всесторонняя информационная подготовка значительно снижает уязвимость перед этими мошенниками.

Растущая угроза мошенничества с использованием искусственного интеллекта

Понимание предупреждения ФБР

Цифровая гонка вооружений между специалистами по безопасности и киберпреступниками вступила в новую опасную фазу с появлением доступных инструментов искусственного интеллекта. То, что начиналось как нишевые исследовательские технологии, превратилось в мощное оружие в руках мошенников.

Эксперты по безопасности зафиксировали тревожную тенденцию, когда преступники сочетают традиционную социальную инженерию с искусственным интеллектом, чтобы обойти человеческие инстинкты доверия. Предупреждения ФБР подчеркивают, как эти методы создают мошеннические сценарии беспрецедентной правдоподобности, способные преодолеть даже осторожный скептицизм.

Как работает искусственный интеллект для клонирования голоса и глубоких подделок

В современных мошеннических схемах используется тревожное сочетание машинного обучения и психологических манипуляций. Злоумышленники следуют тщательному процессу, чтобы добиться максимального успеха.

Жизненный цикл атаки обычно включает три этапа:

- Сбор данных: Мошенники собирают образцы голоса из социальных сетей, публичных выступлений или видеозвонков.

- Синтез голоса: Модели искусственного интеллекта анализируют речевые шаблоны для создания синтетических реплик.

- Подделка мультимедиа: Усовершенствованные инструменты синхронизируют поддельное аудио с манипулируемыми видеоэлементами

Статистика финансовых последствий

Денежные последствия этих мошенничеств с использованием искусственного интеллекта демонстрируют их разрушительную эффективность:

- $100 млн+ потеряли американцы в 2023 году из-за мошенничества с клонированием голоса

- 14 000 долларов в среднем на один инцидент

- 1,03 триллиона долларов в год - глобальный ущерб от мошенничества.

Выявление мошенничества с использованием искусственного интеллекта: Стратегии обнаружения

Методология атаки

Понимание криминальной тактики помогает потенциальным жертвам распознать тревожные сигналы:

- Установить доверие: Используйте клонированные голоса известных людей.

- Сбор информации: Изучение целей с помощью социальной инженерии.

- Осуществить атаку: Развертывание персонализированных сценариев обмана.

Выявление манипуляций ИИ

Предупреждающие признаки синтетических СМИ включают:

- Несоответствующие голосовые характеристики и темп речи

- Неестественные речевые шаблоны или фразы

- Механические артефакты в качестве звука

- Эмоциональные реакции, которые кажутся заскриптованными

- Фактические ошибки в личных рекомендациях

Защитные контрмеры

Лучшие практики верификации

Защитные стратегии должны включать в себя:

- Независимая проверка по установленным каналам связи

- Заранее согласованные коды аутентификации при частых контактах

- Личное подтверждение необычных запросов

Усиление безопасности

Технические средства защиты включают:

- Обязательная многофакторная аутентификация

- Политика регулярной ротации учетных данных

- Системы мониторинга мошенничества

Обучение для повышения осведомленности

Образовательные инициативы должны охватывать:

- Современные тактики мошенничества и примеры из практики

- Методы психологического манипулирования

- Протоколы реагирования на подозрительные сообщения

Управление конфиденциальностью данных

Сократите площадь атак путем:

- Аудита социальных сетей

- Ограничение обмена личной информацией

- внедрения строгих политик работы с данными

Преимущества и проблемы

Плюсы

Создает очень реалистичные пародии

Вызывает инстинктивную реакцию доверия

Создает убедительный мультимедийный контент

Минусы

Потенциал значительных финансовых потерь

Психологический и репутационный ущерб

Эрозия цифровых экосистем доверия

Часто задаваемые вопросы

Как работает искусственный интеллект для клонирования голоса?

Технология анализирует образцы голоса для создания синтетических копий, которые имитируют речевые паттерны, тон и каденцию, позволяя убедительно выдать себя за другого.

Каковы признаки видео глубокой подделки?

Ищите неестественные движения лица, несоответствующее освещение/оттенки кожи, а также артефакты по краям или во время движения.

Как реагировать на подозрительные сигналы бедствия?

Проверьте информацию по нескольким независимым каналам, прежде чем предпринимать какие-либо действия или предоставлять информацию.

Похожие вопросы

Являются ли глубокие подделки ИИ незаконными?

Правовой статус зависит от юрисдикции и контекста использования. В большинстве стран запрещены глубокие подделки, используемые для мошенничества, преследования или предоставления контента без согласия.

Что защищает компании от мошенничества с использованием ИИ?

Основные меры защиты включают обучение сотрудников, технические средства защиты, протоколы проверки и планирование реагирования на инциденты.

Связанная статья

North.Cloud получила $5M на революцию в облачном FinOps с помощью операционной системы, основанной на искусственном интеллекте

North.Cloud получила $5 млн в рамках серии А, чтобы стать пионером в управлении облачной инфраструктурой нового поколенияКомпания North.Cloud, лидер в области оптимизации облачных вычислений, объяви

North.Cloud получила $5M на революцию в облачном FinOps с помощью операционной системы, основанной на искусственном интеллекте

North.Cloud получила $5 млн в рамках серии А, чтобы стать пионером в управлении облачной инфраструктурой нового поколенияКомпания North.Cloud, лидер в области оптимизации облачных вычислений, объяви

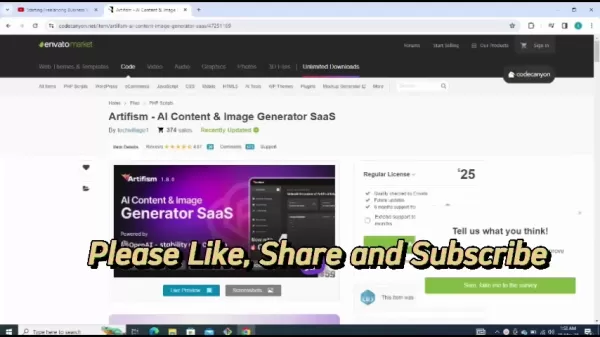

Обзор Artifism: SaaS-скрипт генератора контента и изображений на основе искусственного интеллекта

В современной цифровой экосистеме, ориентированной на контент, постоянное создание высококачественных материалов представляет собой серьезную проблему как для создателей, так и для маркетологов. SaaS-

Обзор Artifism: SaaS-скрипт генератора контента и изображений на основе искусственного интеллекта

В современной цифровой экосистеме, ориентированной на контент, постоянное создание высококачественных материалов представляет собой серьезную проблему как для создателей, так и для маркетологов. SaaS-

Представлен Google AI Ultra: Премиум-подписка по цене 249,99 долларов в месяц

Google представляет премиальную подписку на AI UltraНа выставке Google I/O 2025 технологический гигант анонсировал новый комплексный сервис подписки на услуги искусственного интеллекта - Google AI Ult

Комментарии (0)

Представлен Google AI Ultra: Премиум-подписка по цене 249,99 долларов в месяц

Google представляет премиальную подписку на AI UltraНа выставке Google I/O 2025 технологический гигант анонсировал новый комплексный сервис подписки на услуги искусственного интеллекта - Google AI Ult

Комментарии (0)

По мере развития цифровых технологий киберпреступники применяют все более изощренные методы, включая клонирование голоса с помощью искусственного интеллекта и технологию глубокой подделки. Правоохранительные органы предупреждают, что эти инструменты используются для создания высоко персонализированных афер, которые могут убедительно выдавать себя за доверенных лиц. В этом комплексном руководстве рассматриваются эти новые угрозы, предлагаются стратегии обнаружения и описываются меры защиты от финансового и личного ущерба.

Ключевые моменты

ФБР сообщает о росте числа киберпреступлений с использованием искусственного интеллекта, направленных против частных лиц и организаций.

Мошенники используют клонирование голоса и технологию глубокой подделки видео в сложных схемах.

Сбор личной информации позволяет проводить целенаправленные атаки с использованием социальной инженерии.

Выявление аудио/визуальных аномалий по-прежнему имеет решающее значение для обнаружения мошенничества.

Многоуровневые системы проверки и протоколы безопасности обеспечивают необходимую защиту.

Всесторонняя информационная подготовка значительно снижает уязвимость перед этими мошенниками.

Растущая угроза мошенничества с использованием искусственного интеллекта

Понимание предупреждения ФБР

Цифровая гонка вооружений между специалистами по безопасности и киберпреступниками вступила в новую опасную фазу с появлением доступных инструментов искусственного интеллекта. То, что начиналось как нишевые исследовательские технологии, превратилось в мощное оружие в руках мошенников.

Эксперты по безопасности зафиксировали тревожную тенденцию, когда преступники сочетают традиционную социальную инженерию с искусственным интеллектом, чтобы обойти человеческие инстинкты доверия. Предупреждения ФБР подчеркивают, как эти методы создают мошеннические сценарии беспрецедентной правдоподобности, способные преодолеть даже осторожный скептицизм.

Как работает искусственный интеллект для клонирования голоса и глубоких подделок

В современных мошеннических схемах используется тревожное сочетание машинного обучения и психологических манипуляций. Злоумышленники следуют тщательному процессу, чтобы добиться максимального успеха.

Жизненный цикл атаки обычно включает три этапа:

- Сбор данных: Мошенники собирают образцы голоса из социальных сетей, публичных выступлений или видеозвонков.

- Синтез голоса: Модели искусственного интеллекта анализируют речевые шаблоны для создания синтетических реплик.

- Подделка мультимедиа: Усовершенствованные инструменты синхронизируют поддельное аудио с манипулируемыми видеоэлементами

Статистика финансовых последствий

Денежные последствия этих мошенничеств с использованием искусственного интеллекта демонстрируют их разрушительную эффективность:

- $100 млн+ потеряли американцы в 2023 году из-за мошенничества с клонированием голоса

- 14 000 долларов в среднем на один инцидент

- 1,03 триллиона долларов в год - глобальный ущерб от мошенничества.

Выявление мошенничества с использованием искусственного интеллекта: Стратегии обнаружения

Методология атаки

Понимание криминальной тактики помогает потенциальным жертвам распознать тревожные сигналы:

- Установить доверие: Используйте клонированные голоса известных людей.

- Сбор информации: Изучение целей с помощью социальной инженерии.

- Осуществить атаку: Развертывание персонализированных сценариев обмана.

Выявление манипуляций ИИ

Предупреждающие признаки синтетических СМИ включают:

- Несоответствующие голосовые характеристики и темп речи

- Неестественные речевые шаблоны или фразы

- Механические артефакты в качестве звука

- Эмоциональные реакции, которые кажутся заскриптованными

- Фактические ошибки в личных рекомендациях

Защитные контрмеры

Лучшие практики верификации

Защитные стратегии должны включать в себя:

- Независимая проверка по установленным каналам связи

- Заранее согласованные коды аутентификации при частых контактах

- Личное подтверждение необычных запросов

Усиление безопасности

Технические средства защиты включают:

- Обязательная многофакторная аутентификация

- Политика регулярной ротации учетных данных

- Системы мониторинга мошенничества

Обучение для повышения осведомленности

Образовательные инициативы должны охватывать:

- Современные тактики мошенничества и примеры из практики

- Методы психологического манипулирования

- Протоколы реагирования на подозрительные сообщения

Управление конфиденциальностью данных

Сократите площадь атак путем:

- Аудита социальных сетей

- Ограничение обмена личной информацией

- внедрения строгих политик работы с данными

Преимущества и проблемы

Плюсы

Создает очень реалистичные пародии

Вызывает инстинктивную реакцию доверия

Создает убедительный мультимедийный контент

Минусы

Потенциал значительных финансовых потерь

Психологический и репутационный ущерб

Эрозия цифровых экосистем доверия

Часто задаваемые вопросы

Как работает искусственный интеллект для клонирования голоса?

Технология анализирует образцы голоса для создания синтетических копий, которые имитируют речевые паттерны, тон и каденцию, позволяя убедительно выдать себя за другого.

Каковы признаки видео глубокой подделки?

Ищите неестественные движения лица, несоответствующее освещение/оттенки кожи, а также артефакты по краям или во время движения.

Как реагировать на подозрительные сигналы бедствия?

Проверьте информацию по нескольким независимым каналам, прежде чем предпринимать какие-либо действия или предоставлять информацию.

Похожие вопросы

Являются ли глубокие подделки ИИ незаконными?

Правовой статус зависит от юрисдикции и контекста использования. В большинстве стран запрещены глубокие подделки, используемые для мошенничества, преследования или предоставления контента без согласия.

Что защищает компании от мошенничества с использованием ИИ?

Основные меры защиты включают обучение сотрудников, технические средства защиты, протоколы проверки и планирование реагирования на инциденты.

Обзор Artifism: SaaS-скрипт генератора контента и изображений на основе искусственного интеллекта

В современной цифровой экосистеме, ориентированной на контент, постоянное создание высококачественных материалов представляет собой серьезную проблему как для создателей, так и для маркетологов. SaaS-

Обзор Artifism: SaaS-скрипт генератора контента и изображений на основе искусственного интеллекта

В современной цифровой экосистеме, ориентированной на контент, постоянное создание высококачественных материалов представляет собой серьезную проблему как для создателей, так и для маркетологов. SaaS-

Представлен Google AI Ultra: Премиум-подписка по цене 249,99 долларов в месяц

Google представляет премиальную подписку на AI UltraНа выставке Google I/O 2025 технологический гигант анонсировал новый комплексный сервис подписки на услуги искусственного интеллекта - Google AI Ult

Представлен Google AI Ultra: Премиум-подписка по цене 249,99 долларов в месяц

Google представляет премиальную подписку на AI UltraНа выставке Google I/O 2025 технологический гигант анонсировал новый комплексный сервис подписки на услуги искусственного интеллекта - Google AI Ult