Clonagem de voz por IA e golpes de deepfake: Como se proteger de fraudes

À medida que as tecnologias digitais avançam, os criminosos cibernéticos estão implantando métodos cada vez mais sofisticados, incluindo clonagem de voz com tecnologia de IA e tecnologia deepfake. As agências de aplicação da lei alertam que essas ferramentas estão sendo usadas como armas para criar golpes altamente personalizados que podem se passar por contatos confiáveis de forma convincente. Este guia abrangente examina essas ameaças emergentes, fornece estratégias de detecção e descreve medidas de proteção para se proteger contra danos financeiros e pessoais.

Pontos principais

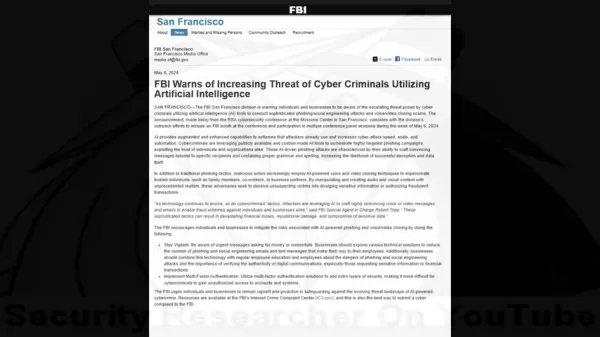

Os alertas do FBI indicam o aumento de crimes cibernéticos habilitados para IA direcionados a indivíduos e organizações.

Os fraudadores agora utilizam a clonagem de voz e a tecnologia de vídeo deepfake em esquemas sofisticados.

A coleta de informações pessoais permite ataques de engenharia social altamente direcionados.

A identificação de anomalias audiovisuais continua sendo essencial para a detecção de fraudes.

Os sistemas de verificação em várias camadas e os protocolos de segurança oferecem proteção essencial.

Um treinamento abrangente de conscientização reduz significativamente a vulnerabilidade a esses golpes.

A crescente ameaça de golpes com tecnologia de IA

Entendendo o alerta do FBI

A corrida armamentista digital entre profissionais de segurança e criminosos cibernéticos entrou em uma nova e perigosa fase com o advento de ferramentas de IA acessíveis. O que começou como tecnologias de pesquisa de nicho se tornou uma arma poderosa nas mãos dos fraudadores.

Os especialistas em segurança documentaram uma tendência alarmante em que os criminosos combinam a engenharia social tradicional com a mídia gerada por IA para contornar os instintos humanos de confiança. Os avisos do FBI destacam como essas técnicas criam cenários fraudulentos de credibilidade sem precedentes, capazes de superar até mesmo o ceticismo cauteloso.

Como funcionam a clonagem de voz por IA e as falsificações profundas

Os esquemas modernos de fraude empregam uma combinação perturbadora de aprendizado de máquina e manipulação psicológica. Os invasores seguem um processo meticuloso para maximizar suas taxas de sucesso.

O ciclo de vida do ataque geralmente envolve três estágios:

- Coleta de dados: Os golpistas coletam amostras de voz de mídias sociais, discursos públicos ou chamadas de vídeo

- Síntese de voz: Modelos de IA analisam padrões de fala para gerar réplicas sintéticas

- Falsificação de multimídia: Ferramentas avançadas sincronizam áudio falso com elementos de vídeo manipulados

Estatísticas de impacto financeiro

As consequências monetárias desses golpes habilitados para IA demonstram sua eficácia devastadora:

- Mais de US$ 100 milhões perdidos pelos americanos em 2023 com golpes de clonagem de voz

- Perda média de US$ 14.000 por incidente

- Perdas anuais de US$ 1,03 trilhão em fraudes globais

Detectando golpes de IA: Estratégias de detecção

A metodologia de ataque

Compreender as táticas criminosas ajuda os alvos em potencial a reconhecer os sinais de alerta:

- Estabelecer confiança: Use vozes clonadas de contatos conhecidos

- Obter inteligência: Pesquisar alvos por meio de engenharia social

- Executar o ataque: Implantar cenários de engano personalizados

Identificação de manipulação de IA

Os sinais de alerta da mídia sintética incluem:

- Características vocais e ritmo inconsistentes

- Padrões ou frases de fala não naturais

- Artefatos mecânicos na qualidade do áudio

- Respostas emocionais que parecem roteirizadas

- Erros factuais em referências pessoais

Contramedidas de proteção

Práticas recomendadas de verificação

As estratégias defensivas devem incorporar:

- Verificação independente por meio de canais de contato estabelecidos

- Códigos de autenticação previamente combinados com contatos frequentes

- Confirmação pessoal para solicitações incomuns

Aprimoramentos de segurança

As proteções técnicas incluem:

- Autenticação multifatorial obrigatória

- Políticas regulares de rotação de credenciais

- Sistemas de monitoramento de fraudes

Treinamento de conscientização

As iniciativas de educação devem abranger:

- Táticas atuais de fraude e estudos de caso

- Técnicas de manipulação psicológica

- Protocolos de resposta para comunicações suspeitas

Gerenciamento da privacidade dos dados

Reduzir as superfícies de ataque por meio de:

- Auditoria da exposição à mídia social

- Restringir o compartilhamento de informações pessoais

- Implementação de políticas rígidas de manuseio de dados

Vantagens e desafios

Prós

Cria imitações altamente realistas

Provoca respostas instintivas de confiança

Produz conteúdo multimídia convincente

Contras

Potencial para perdas financeiras significativas

Danos psicológicos e à reputação

Erosão dos ecossistemas de confiança digital

Perguntas frequentes

Como funciona a clonagem de voz por IA?

A tecnologia analisa amostras de voz para criar réplicas sintéticas que imitam os padrões de fala, o tom e a cadência, permitindo imitações convincentes.

Quais são os indicadores de vídeos deepfake?

Procure por movimentos faciais não naturais, iluminação/tons de pele inconsistentes e artefatos nas bordas ou durante o movimento.

Como devo responder a pedidos de socorro suspeitos?

Verifique por meio de vários canais independentes antes de tomar qualquer medida ou fornecer informações.

Perguntas relacionadas

As deepfakes de IA são ilegais?

O status legal varia de acordo com a jurisdição e o contexto de uso. A maioria dos países proíbe deepfakes usados para fraude, assédio ou conteúdo não consensual.

O que protege as empresas contra fraudes de IA?

As principais proteções incluem treinamento de funcionários, proteções técnicas, protocolos de verificação e planejamento de resposta a incidentes.

Artigo relacionado

North.Cloud obtém US$ 5 milhões para revolucionar o Cloud FinOps com um sistema operacional orientado por IA

North.Cloud obtém US$ 5 milhões da Série A para ser pioneira no gerenciamento de infraestrutura de nuvem de última geraçãoA North.Cloud, líder em otimização de nuvem, anunciou uma rodada de financia

North.Cloud obtém US$ 5 milhões para revolucionar o Cloud FinOps com um sistema operacional orientado por IA

North.Cloud obtém US$ 5 milhões da Série A para ser pioneira no gerenciamento de infraestrutura de nuvem de última geraçãoA North.Cloud, líder em otimização de nuvem, anunciou uma rodada de financia

Revisão do Artifism: Script SaaS gerador de imagens e conteúdo alimentado por IA

No atual ecossistema digital orientado por conteúdo, a produção consistente de materiais de alta qualidade apresenta desafios significativos tanto para os criadores quanto para os profissionais de mar

Revisão do Artifism: Script SaaS gerador de imagens e conteúdo alimentado por IA

No atual ecossistema digital orientado por conteúdo, a produção consistente de materiais de alta qualidade apresenta desafios significativos tanto para os criadores quanto para os profissionais de mar

Google AI Ultra revelado: Assinatura Premium com preço mensal de US$ 249,99

Google revela assinatura premium do AI UltraNo Google I/O 2025, a gigante da tecnologia anunciou seu novo e abrangente serviço de assinatura de IA - o Google AI Ultra. Com um preço mensal de US$ 249,9

Comentários (0)

0/200

Google AI Ultra revelado: Assinatura Premium com preço mensal de US$ 249,99

Google revela assinatura premium do AI UltraNo Google I/O 2025, a gigante da tecnologia anunciou seu novo e abrangente serviço de assinatura de IA - o Google AI Ultra. Com um preço mensal de US$ 249,9

Comentários (0)

0/200

À medida que as tecnologias digitais avançam, os criminosos cibernéticos estão implantando métodos cada vez mais sofisticados, incluindo clonagem de voz com tecnologia de IA e tecnologia deepfake. As agências de aplicação da lei alertam que essas ferramentas estão sendo usadas como armas para criar golpes altamente personalizados que podem se passar por contatos confiáveis de forma convincente. Este guia abrangente examina essas ameaças emergentes, fornece estratégias de detecção e descreve medidas de proteção para se proteger contra danos financeiros e pessoais.

Pontos principais

Os alertas do FBI indicam o aumento de crimes cibernéticos habilitados para IA direcionados a indivíduos e organizações.

Os fraudadores agora utilizam a clonagem de voz e a tecnologia de vídeo deepfake em esquemas sofisticados.

A coleta de informações pessoais permite ataques de engenharia social altamente direcionados.

A identificação de anomalias audiovisuais continua sendo essencial para a detecção de fraudes.

Os sistemas de verificação em várias camadas e os protocolos de segurança oferecem proteção essencial.

Um treinamento abrangente de conscientização reduz significativamente a vulnerabilidade a esses golpes.

A crescente ameaça de golpes com tecnologia de IA

Entendendo o alerta do FBI

A corrida armamentista digital entre profissionais de segurança e criminosos cibernéticos entrou em uma nova e perigosa fase com o advento de ferramentas de IA acessíveis. O que começou como tecnologias de pesquisa de nicho se tornou uma arma poderosa nas mãos dos fraudadores.

Os especialistas em segurança documentaram uma tendência alarmante em que os criminosos combinam a engenharia social tradicional com a mídia gerada por IA para contornar os instintos humanos de confiança. Os avisos do FBI destacam como essas técnicas criam cenários fraudulentos de credibilidade sem precedentes, capazes de superar até mesmo o ceticismo cauteloso.

Como funcionam a clonagem de voz por IA e as falsificações profundas

Os esquemas modernos de fraude empregam uma combinação perturbadora de aprendizado de máquina e manipulação psicológica. Os invasores seguem um processo meticuloso para maximizar suas taxas de sucesso.

O ciclo de vida do ataque geralmente envolve três estágios:

- Coleta de dados: Os golpistas coletam amostras de voz de mídias sociais, discursos públicos ou chamadas de vídeo

- Síntese de voz: Modelos de IA analisam padrões de fala para gerar réplicas sintéticas

- Falsificação de multimídia: Ferramentas avançadas sincronizam áudio falso com elementos de vídeo manipulados

Estatísticas de impacto financeiro

As consequências monetárias desses golpes habilitados para IA demonstram sua eficácia devastadora:

- Mais de US$ 100 milhões perdidos pelos americanos em 2023 com golpes de clonagem de voz

- Perda média de US$ 14.000 por incidente

- Perdas anuais de US$ 1,03 trilhão em fraudes globais

Detectando golpes de IA: Estratégias de detecção

A metodologia de ataque

Compreender as táticas criminosas ajuda os alvos em potencial a reconhecer os sinais de alerta:

- Estabelecer confiança: Use vozes clonadas de contatos conhecidos

- Obter inteligência: Pesquisar alvos por meio de engenharia social

- Executar o ataque: Implantar cenários de engano personalizados

Identificação de manipulação de IA

Os sinais de alerta da mídia sintética incluem:

- Características vocais e ritmo inconsistentes

- Padrões ou frases de fala não naturais

- Artefatos mecânicos na qualidade do áudio

- Respostas emocionais que parecem roteirizadas

- Erros factuais em referências pessoais

Contramedidas de proteção

Práticas recomendadas de verificação

As estratégias defensivas devem incorporar:

- Verificação independente por meio de canais de contato estabelecidos

- Códigos de autenticação previamente combinados com contatos frequentes

- Confirmação pessoal para solicitações incomuns

Aprimoramentos de segurança

As proteções técnicas incluem:

- Autenticação multifatorial obrigatória

- Políticas regulares de rotação de credenciais

- Sistemas de monitoramento de fraudes

Treinamento de conscientização

As iniciativas de educação devem abranger:

- Táticas atuais de fraude e estudos de caso

- Técnicas de manipulação psicológica

- Protocolos de resposta para comunicações suspeitas

Gerenciamento da privacidade dos dados

Reduzir as superfícies de ataque por meio de:

- Auditoria da exposição à mídia social

- Restringir o compartilhamento de informações pessoais

- Implementação de políticas rígidas de manuseio de dados

Vantagens e desafios

Prós

Cria imitações altamente realistas

Provoca respostas instintivas de confiança

Produz conteúdo multimídia convincente

Contras

Potencial para perdas financeiras significativas

Danos psicológicos e à reputação

Erosão dos ecossistemas de confiança digital

Perguntas frequentes

Como funciona a clonagem de voz por IA?

A tecnologia analisa amostras de voz para criar réplicas sintéticas que imitam os padrões de fala, o tom e a cadência, permitindo imitações convincentes.

Quais são os indicadores de vídeos deepfake?

Procure por movimentos faciais não naturais, iluminação/tons de pele inconsistentes e artefatos nas bordas ou durante o movimento.

Como devo responder a pedidos de socorro suspeitos?

Verifique por meio de vários canais independentes antes de tomar qualquer medida ou fornecer informações.

Perguntas relacionadas

As deepfakes de IA são ilegais?

O status legal varia de acordo com a jurisdição e o contexto de uso. A maioria dos países proíbe deepfakes usados para fraude, assédio ou conteúdo não consensual.

O que protege as empresas contra fraudes de IA?

As principais proteções incluem treinamento de funcionários, proteções técnicas, protocolos de verificação e planejamento de resposta a incidentes.

Revisão do Artifism: Script SaaS gerador de imagens e conteúdo alimentado por IA

No atual ecossistema digital orientado por conteúdo, a produção consistente de materiais de alta qualidade apresenta desafios significativos tanto para os criadores quanto para os profissionais de mar

Revisão do Artifism: Script SaaS gerador de imagens e conteúdo alimentado por IA

No atual ecossistema digital orientado por conteúdo, a produção consistente de materiais de alta qualidade apresenta desafios significativos tanto para os criadores quanto para os profissionais de mar

Google AI Ultra revelado: Assinatura Premium com preço mensal de US$ 249,99

Google revela assinatura premium do AI UltraNo Google I/O 2025, a gigante da tecnologia anunciou seu novo e abrangente serviço de assinatura de IA - o Google AI Ultra. Com um preço mensal de US$ 249,9

Google AI Ultra revelado: Assinatura Premium com preço mensal de US$ 249,99

Google revela assinatura premium do AI UltraNo Google I/O 2025, a gigante da tecnologia anunciou seu novo e abrangente serviço de assinatura de IA - o Google AI Ultra. Com um preço mensal de US$ 249,9