AI 語音克隆與 Deepfake 詐騙:如何避免受騙

隨著數位技術的進步,網路罪犯正在部署越來越複雜的方法 - 包括 AI 驅動的語音克隆和深度偽造技術。執法機關警告,這些工具正被利用來製造高度個人化的詐欺,令人信服地冒充可信賴的聯絡人。本綜合指南檢視這些新興威脅,提供偵測策略,並概述防護措施,以避免財務和個人傷害。

重點

FBI 警報顯示,針對個人和組織的 AI 網路犯罪正在增加。

詐騙者現在利用語音克隆和深度偽造視訊技術進行複雜的詐騙。

個人資訊收集可實現高度針對性的社交工程攻擊。

識別音訊/視訊異常仍是偵測詐騙的關鍵。

多層驗證系統和安全協定可提供必要的保護。

全面的認知訓練可大幅降低詐欺的風險。

人工智能驅動的詐欺威脅日益嚴重

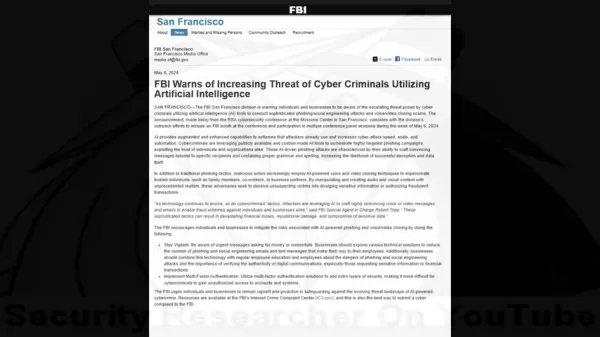

瞭解 FBI 的警告

隨著人工智能工具的出現,安全專業人員與網路罪犯之間的數位軍備競賽已進入一個危險的新階段。一開始只是小眾的研究技術,現在已經成為騙子手中的強大武器。

安全專家已經記錄了一種令人警覺的趨勢,犯罪分子將傳統的社交工程與 AI 產生的媒體結合,繞過人類本能的信任。FBI 的警告強調這些技術如何創造出前所未有的可信騙局,甚至能夠克服謹慎的懷疑態度。

AI 語音克隆和深度偽造是如何運作的

現代詐騙方案採用令人不安的機器學習與心理操縱的結合。攻擊者遵循一絲不苟的流程,以最大化成功率。

攻擊的生命週期通常包含三個階段:

- 資料收集:騙徒從社交媒體、公開演講或視訊通話中收集語音樣本。

- 語音合成:AI 模型分析語音模式以產生合成複本

- 多媒體偽造:先進的工具可將虛假音訊與篡改的視訊元素同步化

財務影響統計

這些人工智慧詐騙所造成的金錢損失顯示了其毀滅性的效果:

- 2023 年美國人因語音複製詐騙損失超過 1 億美元

- 每起事件平均損失 14,000 美元

- 每年全球詐騙損失 1.03 兆美元

識別 AI 詐騙:偵測策略

攻擊方法

瞭解犯罪手法有助於潛在目標識別紅旗:

- 建立信任:使用已知聯絡人的複製聲音

- 收集情報:透過社交工程研究目標

- 執行攻擊:部署個人化的欺騙情境

識別人工智能操控

合成媒體的警示跡象包括

- 不一致的語音特性和步調

- 不自然的語音模式或措辭

- 音訊品質中的機械假象

- 看起來是照本宣科的情緒反應

- 個人提述中的事實錯誤

防護對策

驗證最佳實務

防禦策略應包含

- 透過已建立的聯絡管道進行獨立驗證

- 與經常聯繫的人預先安排驗證碼

- 親自確認不尋常的要求

安全強化

技術防護措施包括

- 強制性多因素驗證

- 定期憑證輪換政策

- 詐欺監控系統

認知訓練

教育活動應包括

- 目前的詐欺手法和案例研究

- 心理操縱技巧

- 可疑通訊的回應規範

資料隱私權管理

透過以下方式減少攻擊面

- 審核社交媒體曝光

- 限制個人資訊共用

- 實施嚴格的資料處理政策

優點與挑戰

優點

創造高度逼真的模仿

觸發本能的信任反應

產生令人信服的多媒體內容

缺點

可能造成重大財務損失

心理和聲譽傷害

侵蝕數位信任生態系統

常見問題

AI 語音複製如何運作?

此技術會分析語音樣本,以創造出可模仿語音模式、語調和腔調的合成複製品,從而實現令人信服的模仿。

深度偽造視訊有哪些指標?

尋找不自然的臉部動作、不一致的光線/膚色,以及邊緣或動作時的假象。

我該如何回應可疑的求救電話?

在採取任何行動或提供資訊前,先透過多個獨立管道進行確認。

相關問題

AI 深度偽造是否違法?

法律地位因司法管轄區和使用環境而異。大多數國家/地區都禁止將深度假冒用於欺詐、騷擾或未經同意的內容。

如何保護企業免受 AI 詐騙?

主要的防護措施包括員工訓練、技術防護、驗證協定和事件回應規劃。

相關文章

North.Cloud 獲得 500 萬美元資金,以人工智能驅動的作業系統革新雲端 FinOps

North.Cloud 獲得 500 萬美元 A 輪融資,開創下一代雲基礎設施管理先河雲端優化領導廠商 North.Cloud 宣佈獲得由 Companyon Ventures 領投的 500 萬美元 A 輪融資,以推動其突破性的 North 2.0 作業系統的推出。此創新平台透過無縫整合 FinOps 與 GreenOps 功能,重新定義了雲端基礎架構管理,適合在多雲端複雜性中遨遊的企業環境

North.Cloud 獲得 500 萬美元資金,以人工智能驅動的作業系統革新雲端 FinOps

North.Cloud 獲得 500 萬美元 A 輪融資,開創下一代雲基礎設施管理先河雲端優化領導廠商 North.Cloud 宣佈獲得由 Companyon Ventures 領投的 500 萬美元 A 輪融資,以推動其突破性的 North 2.0 作業系統的推出。此創新平台透過無縫整合 FinOps 與 GreenOps 功能,重新定義了雲端基礎架構管理,適合在多雲端複雜性中遨遊的企業環境

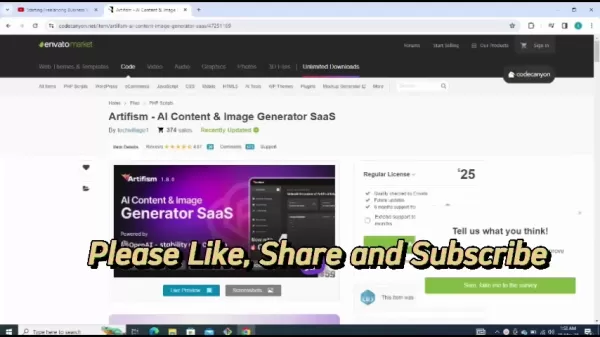

Artifism 評論:AI 驅動的內容和圖像產生器 SaaS 腳本

在現今內容驅動的數位生態系統中,持續製作高品質的資料對創作者和行銷人員而言都是重大的挑戰。Artifism AI 內容與圖片產生器 SaaS script 可將內容創作流程自動化,提供創新的解決方案。本深入評論將探討該平台的功能、價值主張及實施指引,為尋求以 AI 協助強化內容策略並維持製作品質的專業人士提供可行的見解。重點Artifism 是一個採用 SaaS 架構的全面性人工智能內容創作平台。

Artifism 評論:AI 驅動的內容和圖像產生器 SaaS 腳本

在現今內容驅動的數位生態系統中,持續製作高品質的資料對創作者和行銷人員而言都是重大的挑戰。Artifism AI 內容與圖片產生器 SaaS script 可將內容創作流程自動化,提供創新的解決方案。本深入評論將探討該平台的功能、價值主張及實施指引,為尋求以 AI 協助強化內容策略並維持製作品質的專業人士提供可行的見解。重點Artifism 是一個採用 SaaS 架構的全面性人工智能內容創作平台。

Google AI Ultra 正式亮相:高級訂閱月費為 249.99 美元

Google 推出 Premium AI Ultra 訂閱服務在 2025 年的 Google I/O 大會上,科技巨擘發表了全新的全面性 AI 訂閱服務 - Google AI Ultra。這項高級服務的月費為 249.99 美元,可獨家使用 Google 目前最先進的人工智慧工具。AI Ultra 包含哪些內容?Veo 3:Google 最先進的 AI 視訊產生平台Flow:公司的下一代視訊編

評論 (0)

0/200

Google AI Ultra 正式亮相:高級訂閱月費為 249.99 美元

Google 推出 Premium AI Ultra 訂閱服務在 2025 年的 Google I/O 大會上,科技巨擘發表了全新的全面性 AI 訂閱服務 - Google AI Ultra。這項高級服務的月費為 249.99 美元,可獨家使用 Google 目前最先進的人工智慧工具。AI Ultra 包含哪些內容?Veo 3:Google 最先進的 AI 視訊產生平台Flow:公司的下一代視訊編

評論 (0)

0/200

隨著數位技術的進步,網路罪犯正在部署越來越複雜的方法 - 包括 AI 驅動的語音克隆和深度偽造技術。執法機關警告,這些工具正被利用來製造高度個人化的詐欺,令人信服地冒充可信賴的聯絡人。本綜合指南檢視這些新興威脅,提供偵測策略,並概述防護措施,以避免財務和個人傷害。

重點

FBI 警報顯示,針對個人和組織的 AI 網路犯罪正在增加。

詐騙者現在利用語音克隆和深度偽造視訊技術進行複雜的詐騙。

個人資訊收集可實現高度針對性的社交工程攻擊。

識別音訊/視訊異常仍是偵測詐騙的關鍵。

多層驗證系統和安全協定可提供必要的保護。

全面的認知訓練可大幅降低詐欺的風險。

人工智能驅動的詐欺威脅日益嚴重

瞭解 FBI 的警告

隨著人工智能工具的出現,安全專業人員與網路罪犯之間的數位軍備競賽已進入一個危險的新階段。一開始只是小眾的研究技術,現在已經成為騙子手中的強大武器。

安全專家已經記錄了一種令人警覺的趨勢,犯罪分子將傳統的社交工程與 AI 產生的媒體結合,繞過人類本能的信任。FBI 的警告強調這些技術如何創造出前所未有的可信騙局,甚至能夠克服謹慎的懷疑態度。

AI 語音克隆和深度偽造是如何運作的

現代詐騙方案採用令人不安的機器學習與心理操縱的結合。攻擊者遵循一絲不苟的流程,以最大化成功率。

攻擊的生命週期通常包含三個階段:

- 資料收集:騙徒從社交媒體、公開演講或視訊通話中收集語音樣本。

- 語音合成:AI 模型分析語音模式以產生合成複本

- 多媒體偽造:先進的工具可將虛假音訊與篡改的視訊元素同步化

財務影響統計

這些人工智慧詐騙所造成的金錢損失顯示了其毀滅性的效果:

- 2023 年美國人因語音複製詐騙損失超過 1 億美元

- 每起事件平均損失 14,000 美元

- 每年全球詐騙損失 1.03 兆美元

識別 AI 詐騙:偵測策略

攻擊方法

瞭解犯罪手法有助於潛在目標識別紅旗:

- 建立信任:使用已知聯絡人的複製聲音

- 收集情報:透過社交工程研究目標

- 執行攻擊:部署個人化的欺騙情境

識別人工智能操控

合成媒體的警示跡象包括

- 不一致的語音特性和步調

- 不自然的語音模式或措辭

- 音訊品質中的機械假象

- 看起來是照本宣科的情緒反應

- 個人提述中的事實錯誤

防護對策

驗證最佳實務

防禦策略應包含

- 透過已建立的聯絡管道進行獨立驗證

- 與經常聯繫的人預先安排驗證碼

- 親自確認不尋常的要求

安全強化

技術防護措施包括

- 強制性多因素驗證

- 定期憑證輪換政策

- 詐欺監控系統

認知訓練

教育活動應包括

- 目前的詐欺手法和案例研究

- 心理操縱技巧

- 可疑通訊的回應規範

資料隱私權管理

透過以下方式減少攻擊面

- 審核社交媒體曝光

- 限制個人資訊共用

- 實施嚴格的資料處理政策

優點與挑戰

優點

創造高度逼真的模仿

觸發本能的信任反應

產生令人信服的多媒體內容

缺點

可能造成重大財務損失

心理和聲譽傷害

侵蝕數位信任生態系統

常見問題

AI 語音複製如何運作?

此技術會分析語音樣本,以創造出可模仿語音模式、語調和腔調的合成複製品,從而實現令人信服的模仿。

深度偽造視訊有哪些指標?

尋找不自然的臉部動作、不一致的光線/膚色,以及邊緣或動作時的假象。

我該如何回應可疑的求救電話?

在採取任何行動或提供資訊前,先透過多個獨立管道進行確認。

相關問題

AI 深度偽造是否違法?

法律地位因司法管轄區和使用環境而異。大多數國家/地區都禁止將深度假冒用於欺詐、騷擾或未經同意的內容。

如何保護企業免受 AI 詐騙?

主要的防護措施包括員工訓練、技術防護、驗證協定和事件回應規劃。

Artifism 評論:AI 驅動的內容和圖像產生器 SaaS 腳本

在現今內容驅動的數位生態系統中,持續製作高品質的資料對創作者和行銷人員而言都是重大的挑戰。Artifism AI 內容與圖片產生器 SaaS script 可將內容創作流程自動化,提供創新的解決方案。本深入評論將探討該平台的功能、價值主張及實施指引,為尋求以 AI 協助強化內容策略並維持製作品質的專業人士提供可行的見解。重點Artifism 是一個採用 SaaS 架構的全面性人工智能內容創作平台。

Artifism 評論:AI 驅動的內容和圖像產生器 SaaS 腳本

在現今內容驅動的數位生態系統中,持續製作高品質的資料對創作者和行銷人員而言都是重大的挑戰。Artifism AI 內容與圖片產生器 SaaS script 可將內容創作流程自動化,提供創新的解決方案。本深入評論將探討該平台的功能、價值主張及實施指引,為尋求以 AI 協助強化內容策略並維持製作品質的專業人士提供可行的見解。重點Artifism 是一個採用 SaaS 架構的全面性人工智能內容創作平台。

Google AI Ultra 正式亮相:高級訂閱月費為 249.99 美元

Google 推出 Premium AI Ultra 訂閱服務在 2025 年的 Google I/O 大會上,科技巨擘發表了全新的全面性 AI 訂閱服務 - Google AI Ultra。這項高級服務的月費為 249.99 美元,可獨家使用 Google 目前最先進的人工智慧工具。AI Ultra 包含哪些內容?Veo 3:Google 最先進的 AI 視訊產生平台Flow:公司的下一代視訊編

Google AI Ultra 正式亮相:高級訂閱月費為 249.99 美元

Google 推出 Premium AI Ultra 訂閱服務在 2025 年的 Google I/O 大會上,科技巨擘發表了全新的全面性 AI 訂閱服務 - Google AI Ultra。這項高級服務的月費為 249.99 美元,可獨家使用 Google 目前最先進的人工智慧工具。AI Ultra 包含哪些內容?Veo 3:Google 最先進的 AI 視訊產生平台Flow:公司的下一代視訊編