人工智能语音克隆和深度伪造诈骗:如何远离诈骗

随着数字技术的发展,网络犯罪分子正在部署越来越复杂的方法,包括人工智能驱动的语音克隆和深度伪造技术。执法机构警告说,这些工具正被用来制造高度个性化的骗局,令人信服地冒充可信联系人。本综合指南探讨了这些新出现的威胁,提供了检测策略,并概述了防范财务和人身伤害的保护措施。

要点

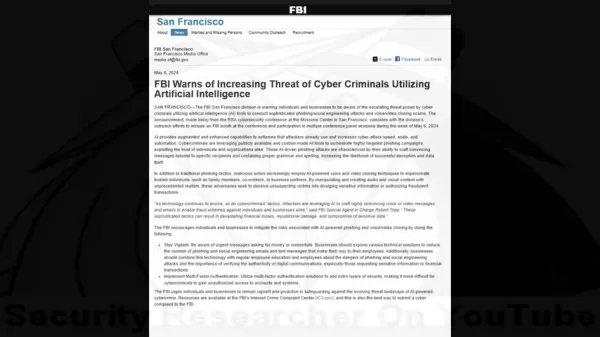

联邦调查局的警报显示,针对个人和组织的人工智能网络犯罪不断增加。

欺诈者现在利用语音克隆和深度伪造视频技术实施复杂的阴谋。

个人信息收集使社交工程攻击具有高度针对性。

识别音频/视频异常仍然是侦测诈骗的关键。

多层验证系统和安全协议提供了必要的保护。

全面的意识培训可大大降低受骗的可能性。

人工智能驱动的诈骗威胁日益严重

了解联邦调查局的警告

随着人工智能工具的出现,安全专业人员与网络犯罪分子之间的数字军备竞赛进入了一个危险的新阶段。最初的小众研究技术已经成为欺诈者手中的有力武器。

安全专家记录了一种令人震惊的趋势,即犯罪分子将传统的社交工程与人工智能生成的媒体结合起来,绕过人类的信任本能。联邦调查局的警告强调了这些技术是如何创造出空前可信的欺诈场景,甚至能够克服谨慎的怀疑态度。

人工智能语音克隆和深度伪造是如何实现的

现代欺诈计划采用了令人不安的机器学习和心理操纵相结合的方法。攻击者遵循一套缜密的流程,以最大限度地提高成功率。

攻击的生命周期通常包括三个阶段:

- 数据收集:骗子从社交媒体、公开演讲或视频通话中获取语音样本

- 语音合成:人工智能模型分析语音模式,生成合成复制品

- 多媒体伪造:先进工具将伪造的音频与经过处理的视频元素同步

财务影响统计

这些由人工智能驱动的骗局所造成的金钱损失证明了它们的破坏性效果:

- 2023 年美国人因语音克隆诈骗损失超过 1 亿美元

- 每起事件平均损失 14,000 美元

- 每年全球诈骗损失 1.03 万亿美元

识别人工智能诈骗:检测策略

攻击方法

了解犯罪手法有助于潜在目标识别红色信号:

- 建立信任:使用已知联系人的克隆声音

- 收集情报:通过社交工程研究目标

- 实施攻击:部署个性化欺骗方案

识别人工智能操纵

合成媒体的警示信号包括

- 不一致的声音特征和节奏

- 不自然的语音模式或措辞

- 音频质量中的机械人工痕迹

- 似乎是照本宣科的情绪反应

- 个人引用中的事实错误

保护对策

验证最佳实践

防御策略应包括

- 通过已建立的联系渠道进行独立核实

- 与经常联系的人事先约定验证码

- 亲自确认异常请求

安全增强措施

技术保障措施包括

- 强制性多因素验证

- 定期凭证轮换政策

- 欺诈监控系统

提高认识培训

教育活动应包括

- 当前的诈骗策略和案例研究

- 心理操纵技巧

- 可疑通信的响应协议

数据隐私管理

通过以下方式减少攻击面

- 审核社交媒体曝光

- 限制个人信息共享

- 实施严格的数据处理政策

优势和挑战

优点

创建高度逼真的模仿

引发本能的信任反应

制作令人信服的多媒体内容

缺点

可能造成重大经济损失

心理和声誉伤害

侵蚀数字信任生态系统

常见问题

人工智能语音克隆是如何工作的?

该技术通过分析语音样本来创建合成复制品,模仿语音模式、语气和语调,从而实现令人信服的模仿。

深度伪造视频有哪些迹象?

查找不自然的面部动作、不一致的光线/肤色以及边缘或运动过程中的伪影。

我应该如何应对可疑的求救信号?

在采取任何行动或提供信息之前,通过多个独立渠道进行核实。

相关问题

人工智能深度伪造是否违法?

法律地位因司法管辖区和使用环境而异。大多数国家禁止将深度伪造用于欺诈、骚扰或未经同意的内容。

如何保护企业免受人工智能欺诈?

主要保护措施包括员工培训、技术保障、验证协议和事件响应计划。

相关文章

North.Cloud 获 500 万美元投资,利用人工智能驱动的操作系统革新云 FinOps

North.Cloud获500万美元A轮融资,开创下一代云基础设施管理先河云优化领导者 North.Cloud 宣布获得由 Companyon Ventures 领投的 500 万美元 A 轮融资,以推动其开创性的 North 2.0 操作系统的推出。这一创新平台通过无缝集成 FinOps 和 GreenOps 功能,重新定义了云基础设施管理,适用于驾驭多云复杂性的企业环境。2,000 亿

North.Cloud 获 500 万美元投资,利用人工智能驱动的操作系统革新云 FinOps

North.Cloud获500万美元A轮融资,开创下一代云基础设施管理先河云优化领导者 North.Cloud 宣布获得由 Companyon Ventures 领投的 500 万美元 A 轮融资,以推动其开创性的 North 2.0 操作系统的推出。这一创新平台通过无缝集成 FinOps 和 GreenOps 功能,重新定义了云基础设施管理,适用于驾驭多云复杂性的企业环境。2,000 亿

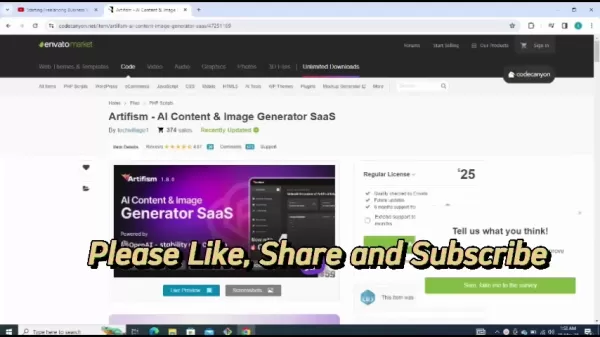

Artifism 评论:人工智能驱动的内容与图片生成器 SaaS 脚本

在当今内容驱动的数字生态系统中,持续制作高质量的材料对创作者和营销人员都是巨大的挑战。Artifism AI 内容和图像生成器 SaaS 脚本通过自动内容创建流程提供了一种创新的解决方案。本深度评论将探讨该平台的功能、价值主张和实施指南,为寻求在保持制作质量的同时利用人工智能辅助增强内容战略的专业人士提供可操作的见解。要点Artifism 是一个采用 SaaS 架构、由人工智能驱动的综合性内容创作

Artifism 评论:人工智能驱动的内容与图片生成器 SaaS 脚本

在当今内容驱动的数字生态系统中,持续制作高质量的材料对创作者和营销人员都是巨大的挑战。Artifism AI 内容和图像生成器 SaaS 脚本通过自动内容创建流程提供了一种创新的解决方案。本深度评论将探讨该平台的功能、价值主张和实施指南,为寻求在保持制作质量的同时利用人工智能辅助增强内容战略的专业人士提供可操作的见解。要点Artifism 是一个采用 SaaS 架构、由人工智能驱动的综合性内容创作

Google AI Ultra 正式发布:高级订阅月费 249.99 美元

谷歌推出高级 AI Ultra 订阅服务在 2025 年的谷歌 I/O 大会上,这家科技巨头宣布推出全新的综合人工智能订阅服务--谷歌人工智能 Ultra。这项高级服务的月费为 249.99 美元,用户可以独家使用谷歌目前最先进的人工智能工具。AI Ultra 包括哪些内容?Veo 3:谷歌最先进的人工智能视频生成平台Flow:公司的下一代视频编辑应用程序Gemini 2.5 Pro 深度思考:即

评论 (0)

0/200

Google AI Ultra 正式发布:高级订阅月费 249.99 美元

谷歌推出高级 AI Ultra 订阅服务在 2025 年的谷歌 I/O 大会上,这家科技巨头宣布推出全新的综合人工智能订阅服务--谷歌人工智能 Ultra。这项高级服务的月费为 249.99 美元,用户可以独家使用谷歌目前最先进的人工智能工具。AI Ultra 包括哪些内容?Veo 3:谷歌最先进的人工智能视频生成平台Flow:公司的下一代视频编辑应用程序Gemini 2.5 Pro 深度思考:即

评论 (0)

0/200

随着数字技术的发展,网络犯罪分子正在部署越来越复杂的方法,包括人工智能驱动的语音克隆和深度伪造技术。执法机构警告说,这些工具正被用来制造高度个性化的骗局,令人信服地冒充可信联系人。本综合指南探讨了这些新出现的威胁,提供了检测策略,并概述了防范财务和人身伤害的保护措施。

要点

联邦调查局的警报显示,针对个人和组织的人工智能网络犯罪不断增加。

欺诈者现在利用语音克隆和深度伪造视频技术实施复杂的阴谋。

个人信息收集使社交工程攻击具有高度针对性。

识别音频/视频异常仍然是侦测诈骗的关键。

多层验证系统和安全协议提供了必要的保护。

全面的意识培训可大大降低受骗的可能性。

人工智能驱动的诈骗威胁日益严重

了解联邦调查局的警告

随着人工智能工具的出现,安全专业人员与网络犯罪分子之间的数字军备竞赛进入了一个危险的新阶段。最初的小众研究技术已经成为欺诈者手中的有力武器。

安全专家记录了一种令人震惊的趋势,即犯罪分子将传统的社交工程与人工智能生成的媒体结合起来,绕过人类的信任本能。联邦调查局的警告强调了这些技术是如何创造出空前可信的欺诈场景,甚至能够克服谨慎的怀疑态度。

人工智能语音克隆和深度伪造是如何实现的

现代欺诈计划采用了令人不安的机器学习和心理操纵相结合的方法。攻击者遵循一套缜密的流程,以最大限度地提高成功率。

攻击的生命周期通常包括三个阶段:

- 数据收集:骗子从社交媒体、公开演讲或视频通话中获取语音样本

- 语音合成:人工智能模型分析语音模式,生成合成复制品

- 多媒体伪造:先进工具将伪造的音频与经过处理的视频元素同步

财务影响统计

这些由人工智能驱动的骗局所造成的金钱损失证明了它们的破坏性效果:

- 2023 年美国人因语音克隆诈骗损失超过 1 亿美元

- 每起事件平均损失 14,000 美元

- 每年全球诈骗损失 1.03 万亿美元

识别人工智能诈骗:检测策略

攻击方法

了解犯罪手法有助于潜在目标识别红色信号:

- 建立信任:使用已知联系人的克隆声音

- 收集情报:通过社交工程研究目标

- 实施攻击:部署个性化欺骗方案

识别人工智能操纵

合成媒体的警示信号包括

- 不一致的声音特征和节奏

- 不自然的语音模式或措辞

- 音频质量中的机械人工痕迹

- 似乎是照本宣科的情绪反应

- 个人引用中的事实错误

保护对策

验证最佳实践

防御策略应包括

- 通过已建立的联系渠道进行独立核实

- 与经常联系的人事先约定验证码

- 亲自确认异常请求

安全增强措施

技术保障措施包括

- 强制性多因素验证

- 定期凭证轮换政策

- 欺诈监控系统

提高认识培训

教育活动应包括

- 当前的诈骗策略和案例研究

- 心理操纵技巧

- 可疑通信的响应协议

数据隐私管理

通过以下方式减少攻击面

- 审核社交媒体曝光

- 限制个人信息共享

- 实施严格的数据处理政策

优势和挑战

优点

创建高度逼真的模仿

引发本能的信任反应

制作令人信服的多媒体内容

缺点

可能造成重大经济损失

心理和声誉伤害

侵蚀数字信任生态系统

常见问题

人工智能语音克隆是如何工作的?

该技术通过分析语音样本来创建合成复制品,模仿语音模式、语气和语调,从而实现令人信服的模仿。

深度伪造视频有哪些迹象?

查找不自然的面部动作、不一致的光线/肤色以及边缘或运动过程中的伪影。

我应该如何应对可疑的求救信号?

在采取任何行动或提供信息之前,通过多个独立渠道进行核实。

相关问题

人工智能深度伪造是否违法?

法律地位因司法管辖区和使用环境而异。大多数国家禁止将深度伪造用于欺诈、骚扰或未经同意的内容。

如何保护企业免受人工智能欺诈?

主要保护措施包括员工培训、技术保障、验证协议和事件响应计划。

Artifism 评论:人工智能驱动的内容与图片生成器 SaaS 脚本

在当今内容驱动的数字生态系统中,持续制作高质量的材料对创作者和营销人员都是巨大的挑战。Artifism AI 内容和图像生成器 SaaS 脚本通过自动内容创建流程提供了一种创新的解决方案。本深度评论将探讨该平台的功能、价值主张和实施指南,为寻求在保持制作质量的同时利用人工智能辅助增强内容战略的专业人士提供可操作的见解。要点Artifism 是一个采用 SaaS 架构、由人工智能驱动的综合性内容创作

Artifism 评论:人工智能驱动的内容与图片生成器 SaaS 脚本

在当今内容驱动的数字生态系统中,持续制作高质量的材料对创作者和营销人员都是巨大的挑战。Artifism AI 内容和图像生成器 SaaS 脚本通过自动内容创建流程提供了一种创新的解决方案。本深度评论将探讨该平台的功能、价值主张和实施指南,为寻求在保持制作质量的同时利用人工智能辅助增强内容战略的专业人士提供可操作的见解。要点Artifism 是一个采用 SaaS 架构、由人工智能驱动的综合性内容创作

Google AI Ultra 正式发布:高级订阅月费 249.99 美元

谷歌推出高级 AI Ultra 订阅服务在 2025 年的谷歌 I/O 大会上,这家科技巨头宣布推出全新的综合人工智能订阅服务--谷歌人工智能 Ultra。这项高级服务的月费为 249.99 美元,用户可以独家使用谷歌目前最先进的人工智能工具。AI Ultra 包括哪些内容?Veo 3:谷歌最先进的人工智能视频生成平台Flow:公司的下一代视频编辑应用程序Gemini 2.5 Pro 深度思考:即

Google AI Ultra 正式发布:高级订阅月费 249.99 美元

谷歌推出高级 AI Ultra 订阅服务在 2025 年的谷歌 I/O 大会上,这家科技巨头宣布推出全新的综合人工智能订阅服务--谷歌人工智能 Ultra。这项高级服务的月费为 249.99 美元,用户可以独家使用谷歌目前最先进的人工智能工具。AI Ultra 包括哪些内容?Veo 3:谷歌最先进的人工智能视频生成平台Flow:公司的下一代视频编辑应用程序Gemini 2.5 Pro 深度思考:即