Clonación de voz por IA y estafas Deepfake: Cómo protegerse del fraude

A medida que avanzan las tecnologías digitales, los ciberdelincuentes despliegan métodos cada vez más sofisticados, como la clonación de voz con IA y la tecnología deepfake. Las fuerzas de seguridad advierten de que estas herramientas están siendo utilizadas para crear estafas altamente personalizadas que pueden suplantar de forma convincente a contactos de confianza. Esta completa guía examina estas amenazas emergentes, proporciona estrategias de detección y describe medidas de protección para evitar daños financieros y personales.

Puntos clave

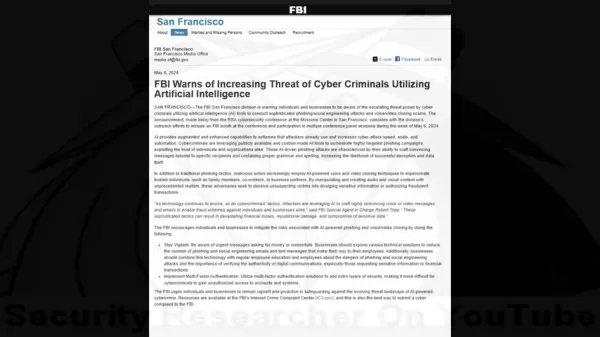

Las alertas del FBI indican un aumento de los ciberdelitos basados en IA dirigidos a particulares y organizaciones.

Los estafadores utilizan ahora la clonación de voz y la tecnología de vídeo "deepfake" en sofisticadas estafas.

La recopilación de información personal permite realizar ataques de ingeniería social muy selectivos.

La identificación de anomalías audiovisuales sigue siendo fundamental para la detección de estafas.

Los sistemas de verificación multicapa y los protocolos de seguridad proporcionan una protección esencial.

Una formación exhaustiva de concienciación reduce significativamente la vulnerabilidad a estas estafas.

La creciente amenaza de las estafas basadas en inteligencia artificial

Comprender la advertencia del FBI

La carrera armamentística digital entre los profesionales de la seguridad y los ciberdelincuentes ha entrado en una nueva y peligrosa fase con la llegada de herramientas de IA accesibles. Lo que empezaron siendo tecnologías de investigación de nicho se han convertido en poderosas armas en manos de los estafadores.

Los expertos en seguridad han documentado una tendencia alarmante en la que los delincuentes combinan la ingeniería social tradicional con medios generados por IA para eludir los instintos humanos de confianza. Las advertencias del FBI destacan cómo estas técnicas crean escenarios fraudulentos de una credibilidad sin precedentes, capaces de superar incluso el escepticismo más cauto.

Cómo funcionan la clonación de voz por IA y las falsificaciones profundas

Las estafas modernas emplean una inquietante combinación de aprendizaje automático y manipulación psicológica. Los atacantes siguen un meticuloso proceso para maximizar sus tasas de éxito.

El ciclo de vida del ataque suele constar de tres etapas:

- Recogida de datos: Los estafadores recogen muestras de voz de redes sociales, discursos públicos o videollamadas.

- Síntesis de voz: Los modelos de IA analizan los patrones de voz para generar réplicas sintéticas.

- Falsificación multimedia: Herramientas avanzadas sincronizan audio falso con elementos de vídeo manipulados

Estadísticas de impacto financiero

Las consecuencias monetarias de estas estafas basadas en IA demuestran su devastadora eficacia:

- Más de 100 millones de dólares perdidos por los estadounidenses en 2023 por estafas de clonación de voz

- Pérdida media de 14.000 dólares por incidente

- 1,03 billones de dólares anuales de pérdidas globales por fraude

Detectar estafas basadas en IA: Estrategias de detección

Metodología de ataque

Comprender las tácticas delictivas ayuda a los objetivos potenciales a reconocer las señales de alarma:

- Establecer confianza: Utilizar voces clonadas de contactos conocidos

- Recopilar información: Investigar los objetivos mediante ingeniería social

- Ejecutar el ataque: Desplegar escenarios de engaño personalizados

Identificación de la manipulación de la IA

Las señales de advertencia de medios sintéticos incluyen

- Características vocales y ritmo incoherentes

- Patrones de habla o fraseo poco naturales

- Artefactos mecánicos en la calidad del audio

- Respuestas emocionales que parecen guionizadas

- Errores en las referencias personales

Contramedidas de protección

Mejores prácticas de verificación

Las estrategias defensivas deben incorporar

- Verificación independiente a través de canales de contacto establecidos

- Códigos de autenticación preestablecidos con contactos frecuentes

- Confirmación en persona para solicitudes inusuales

Mejoras de seguridad

Las salvaguardias técnicas incluyen:

- Autenticación multifactor obligatoria

- Políticas de rotación periódica de credenciales

- Sistemas de control del fraude

Formación para la concienciación

Las iniciativas educativas deben abarcar

- Tácticas actuales de estafa y casos prácticos

- Técnicas de manipulación psicológica

- Protocolos de respuesta ante comunicaciones sospechosas

Gestión de la privacidad de los datos

Reducir las superficies de ataque mediante:

- Auditoría de la exposición a las redes sociales

- Restricción del intercambio de información personal

- Aplicando políticas estrictas de tratamiento de datos

Ventajas y retos

Ventajas

Crea suplantaciones muy realistas

Provoca respuestas instintivas de confianza

Produce contenidos multimedia convincentes

Contras

Posibilidad de pérdidas financieras significativas

Daños psicológicos y de reputación

Erosión de los ecosistemas digitales de confianza

Preguntas más frecuentes

¿Cómo funciona la clonación de voz por IA?

La tecnología analiza muestras de voz para crear réplicas sintéticas que imitan los patrones del habla, el tono y la cadencia, permitiendo suplantaciones convincentes.

¿Cuáles son los indicadores de los vídeos deepfake?

Busque movimientos faciales poco naturales, iluminación y tonos de piel incoherentes y artefactos en los bordes o durante el movimiento.

¿Cómo debo responder a las llamadas de socorro sospechosas?

Verifíquelo a través de varios canales independientes antes de emprender cualquier acción o facilitar información.

Preguntas relacionadas

¿Son ilegales los deepfakes de IA?

El estatus legal varía según la jurisdicción y el contexto de uso. La mayoría de los países prohíben las deepfakes utilizadas para el fraude, el acoso o el contenido no consentido.

¿Qué protege a las empresas del fraude de IA?

Las protecciones clave incluyen la formación de los empleados, las salvaguardas técnicas, los protocolos de verificación y la planificación de la respuesta ante incidentes.

Artículo relacionado

North.Cloud obtiene 5 millones de dólares para revolucionar las operaciones financieras en la nube con un sistema operativo basado en IA

North.Cloud obtiene 5 millones de dólares de la Serie A para ser pionera en la gestión de infraestructuras en la nube de última generaciónNorth.Cloud, líder en optimización de la nube, ha anunciado

North.Cloud obtiene 5 millones de dólares para revolucionar las operaciones financieras en la nube con un sistema operativo basado en IA

North.Cloud obtiene 5 millones de dólares de la Serie A para ser pionera en la gestión de infraestructuras en la nube de última generaciónNorth.Cloud, líder en optimización de la nube, ha anunciado

Revisión de Artifism: Script SaaS generador de contenidos e imágenes basado en IA

En el ecosistema digital actual, impulsado por los contenidos, la producción constante de materiales de alta calidad presenta retos significativos tanto para los creadores como para los profesionales

Revisión de Artifism: Script SaaS generador de contenidos e imágenes basado en IA

En el ecosistema digital actual, impulsado por los contenidos, la producción constante de materiales de alta calidad presenta retos significativos tanto para los creadores como para los profesionales

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

comentario (0)

0/200

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

comentario (0)

0/200

A medida que avanzan las tecnologías digitales, los ciberdelincuentes despliegan métodos cada vez más sofisticados, como la clonación de voz con IA y la tecnología deepfake. Las fuerzas de seguridad advierten de que estas herramientas están siendo utilizadas para crear estafas altamente personalizadas que pueden suplantar de forma convincente a contactos de confianza. Esta completa guía examina estas amenazas emergentes, proporciona estrategias de detección y describe medidas de protección para evitar daños financieros y personales.

Puntos clave

Las alertas del FBI indican un aumento de los ciberdelitos basados en IA dirigidos a particulares y organizaciones.

Los estafadores utilizan ahora la clonación de voz y la tecnología de vídeo "deepfake" en sofisticadas estafas.

La recopilación de información personal permite realizar ataques de ingeniería social muy selectivos.

La identificación de anomalías audiovisuales sigue siendo fundamental para la detección de estafas.

Los sistemas de verificación multicapa y los protocolos de seguridad proporcionan una protección esencial.

Una formación exhaustiva de concienciación reduce significativamente la vulnerabilidad a estas estafas.

La creciente amenaza de las estafas basadas en inteligencia artificial

Comprender la advertencia del FBI

La carrera armamentística digital entre los profesionales de la seguridad y los ciberdelincuentes ha entrado en una nueva y peligrosa fase con la llegada de herramientas de IA accesibles. Lo que empezaron siendo tecnologías de investigación de nicho se han convertido en poderosas armas en manos de los estafadores.

Los expertos en seguridad han documentado una tendencia alarmante en la que los delincuentes combinan la ingeniería social tradicional con medios generados por IA para eludir los instintos humanos de confianza. Las advertencias del FBI destacan cómo estas técnicas crean escenarios fraudulentos de una credibilidad sin precedentes, capaces de superar incluso el escepticismo más cauto.

Cómo funcionan la clonación de voz por IA y las falsificaciones profundas

Las estafas modernas emplean una inquietante combinación de aprendizaje automático y manipulación psicológica. Los atacantes siguen un meticuloso proceso para maximizar sus tasas de éxito.

El ciclo de vida del ataque suele constar de tres etapas:

- Recogida de datos: Los estafadores recogen muestras de voz de redes sociales, discursos públicos o videollamadas.

- Síntesis de voz: Los modelos de IA analizan los patrones de voz para generar réplicas sintéticas.

- Falsificación multimedia: Herramientas avanzadas sincronizan audio falso con elementos de vídeo manipulados

Estadísticas de impacto financiero

Las consecuencias monetarias de estas estafas basadas en IA demuestran su devastadora eficacia:

- Más de 100 millones de dólares perdidos por los estadounidenses en 2023 por estafas de clonación de voz

- Pérdida media de 14.000 dólares por incidente

- 1,03 billones de dólares anuales de pérdidas globales por fraude

Detectar estafas basadas en IA: Estrategias de detección

Metodología de ataque

Comprender las tácticas delictivas ayuda a los objetivos potenciales a reconocer las señales de alarma:

- Establecer confianza: Utilizar voces clonadas de contactos conocidos

- Recopilar información: Investigar los objetivos mediante ingeniería social

- Ejecutar el ataque: Desplegar escenarios de engaño personalizados

Identificación de la manipulación de la IA

Las señales de advertencia de medios sintéticos incluyen

- Características vocales y ritmo incoherentes

- Patrones de habla o fraseo poco naturales

- Artefactos mecánicos en la calidad del audio

- Respuestas emocionales que parecen guionizadas

- Errores en las referencias personales

Contramedidas de protección

Mejores prácticas de verificación

Las estrategias defensivas deben incorporar

- Verificación independiente a través de canales de contacto establecidos

- Códigos de autenticación preestablecidos con contactos frecuentes

- Confirmación en persona para solicitudes inusuales

Mejoras de seguridad

Las salvaguardias técnicas incluyen:

- Autenticación multifactor obligatoria

- Políticas de rotación periódica de credenciales

- Sistemas de control del fraude

Formación para la concienciación

Las iniciativas educativas deben abarcar

- Tácticas actuales de estafa y casos prácticos

- Técnicas de manipulación psicológica

- Protocolos de respuesta ante comunicaciones sospechosas

Gestión de la privacidad de los datos

Reducir las superficies de ataque mediante:

- Auditoría de la exposición a las redes sociales

- Restricción del intercambio de información personal

- Aplicando políticas estrictas de tratamiento de datos

Ventajas y retos

Ventajas

Crea suplantaciones muy realistas

Provoca respuestas instintivas de confianza

Produce contenidos multimedia convincentes

Contras

Posibilidad de pérdidas financieras significativas

Daños psicológicos y de reputación

Erosión de los ecosistemas digitales de confianza

Preguntas más frecuentes

¿Cómo funciona la clonación de voz por IA?

La tecnología analiza muestras de voz para crear réplicas sintéticas que imitan los patrones del habla, el tono y la cadencia, permitiendo suplantaciones convincentes.

¿Cuáles son los indicadores de los vídeos deepfake?

Busque movimientos faciales poco naturales, iluminación y tonos de piel incoherentes y artefactos en los bordes o durante el movimiento.

¿Cómo debo responder a las llamadas de socorro sospechosas?

Verifíquelo a través de varios canales independientes antes de emprender cualquier acción o facilitar información.

Preguntas relacionadas

¿Son ilegales los deepfakes de IA?

El estatus legal varía según la jurisdicción y el contexto de uso. La mayoría de los países prohíben las deepfakes utilizadas para el fraude, el acoso o el contenido no consentido.

¿Qué protege a las empresas del fraude de IA?

Las protecciones clave incluyen la formación de los empleados, las salvaguardas técnicas, los protocolos de verificación y la planificación de la respuesta ante incidentes.

Revisión de Artifism: Script SaaS generador de contenidos e imágenes basado en IA

En el ecosistema digital actual, impulsado por los contenidos, la producción constante de materiales de alta calidad presenta retos significativos tanto para los creadores como para los profesionales

Revisión de Artifism: Script SaaS generador de contenidos e imágenes basado en IA

En el ecosistema digital actual, impulsado por los contenidos, la producción constante de materiales de alta calidad presenta retos significativos tanto para los creadores como para los profesionales

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es

Presentación de Google AI Ultra: Suscripción Premium a 249,99 $ al mes

Google presenta la suscripción Premium AI UltraEn Google I/O 2025, el gigante tecnológico anunció su nuevo servicio integral de suscripción a IA: Google AI Ultra. Con un precio mensual de 249,99 $, es