Benchmarks du modèle AI de Meta: trompeur?

Ainsi, Meta a lancé son nouveau modèle d'IA, Maverick, pendant le week-end, et il fait déjà des vagues en décrochant la deuxième place sur LM Arena. Vous savez, c'est l'endroit où les humains jouent les juges et les jurés, comparant différents modèles d'IA et choisissant leurs favoris. Mais, attendez une seconde, il y a un rebondissement ! Il s'avère que la version de Maverick qui parade sur LM Arena n'est pas tout à fait la même que celle que vous pouvez télécharger et utiliser en tant que développeur.

Certains chercheurs en IA aux yeux de lynx sur X (oui, la plateforme autrefois connue sous le nom de Twitter) ont remarqué que Meta a qualifié la version de LM Arena de "version expérimentale de chat". Et si vous jetez un œil au site web de Llama, il y a un tableau qui révèle tout, indiquant que les tests ont été réalisés avec "Llama 4 Maverick optimisé pour la conversation". Nous en avons déjà parlé, mais LM Arena n'est pas exactement l'étalon-or pour mesurer les performances des IA. La plupart des entreprises d'IA ne modifient pas leurs modèles juste pour obtenir un meilleur score à ce test — ou du moins, elles ne l'admettent pas.

Le problème, c'est que lorsqu'on ajuste un modèle pour exceller dans un benchmark mais qu'on publie ensuite une version "vanille" différente au public, il est difficile pour les développeurs de comprendre comment le modèle se comportera réellement dans des scénarios du monde réel. De plus, c'est un peu trompeur, non ? Les benchmarks, imparfaits qu'ils soient, devraient nous donner une image claire de ce qu'un modèle peut et ne peut pas faire à travers différentes tâches.

Les chercheurs sur X ont rapidement remarqué des différences significatives entre le Maverick que vous pouvez télécharger et celui sur LM Arena. La version Arena semble être très portée sur les emojis et adore donner des réponses longues et détaillées.

Okay Llama 4 is def a littled cooked lol, what is this yap city pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) April 6, 2025

for some reason, the Llama 4 model in Arena uses a lot more Emojis

on together . ai, it seems better: pic.twitter.com/f74ODX4zTt

— Tech Dev Notes (@techdevnotes) April 6, 2025

Nous avons contacté Meta et les responsables de Chatbot Arena, qui gèrent LM Arena, pour savoir ce qu'ils ont à dire à ce sujet. Restez à l'écoute !

Article connexe

Zuckerberg, de Meta, déclare que tous les modèles de "superintelligence" de l'IA ne seront pas ouverts au public

Le virage stratégique de Meta vers la superintelligence personnelleMark Zuckerberg, PDG de Meta, a présenté cette semaine une vision ambitieuse de la "superintelligence personnelle" - des systèmes d'I

Zuckerberg, de Meta, déclare que tous les modèles de "superintelligence" de l'IA ne seront pas ouverts au public

Le virage stratégique de Meta vers la superintelligence personnelleMark Zuckerberg, PDG de Meta, a présenté cette semaine une vision ambitieuse de la "superintelligence personnelle" - des systèmes d'I

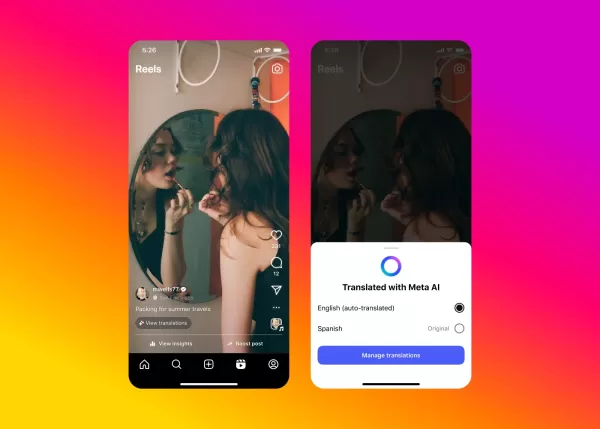

L'IA de Meta s'attaque au doublage vidéo pour les contenus Instagram

Meta élargit l'accès à sa technologie révolutionnaire de doublage alimentée par l'IA sur Facebook et Instagram, en introduisant des capacités de traduction vidéo transparentes qui conservent votre voi

L'IA de Meta s'attaque au doublage vidéo pour les contenus Instagram

Meta élargit l'accès à sa technologie révolutionnaire de doublage alimentée par l'IA sur Facebook et Instagram, en introduisant des capacités de traduction vidéo transparentes qui conservent votre voi

Application Meta AI pour introduire un niveau premium et des publicités

L'application d'IA de Meta pourrait bientôt proposer un abonnement payant, à l'image des offres de concurrents comme OpenAI, Google et Microsoft. Lors d'une conférence sur les résultats du premier tri

commentaires (36)

0/200

Application Meta AI pour introduire un niveau premium et des publicités

L'application d'IA de Meta pourrait bientôt proposer un abonnement payant, à l'image des offres de concurrents comme OpenAI, Google et Microsoft. Lors d'une conférence sur les résultats du premier tri

commentaires (36)

0/200

![ScottWalker]() ScottWalker

ScottWalker

28 juillet 2025 03:20:54 UTC+02:00

28 juillet 2025 03:20:54 UTC+02:00

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

![KennethMartin]() KennethMartin

KennethMartin

21 avril 2025 12:14:21 UTC+02:00

21 avril 2025 12:14:21 UTC+02:00

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

![WalterThomas]() WalterThomas

WalterThomas

21 avril 2025 04:55:14 UTC+02:00

21 avril 2025 04:55:14 UTC+02:00

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

![JohnYoung]() JohnYoung

JohnYoung

18 avril 2025 17:03:42 UTC+02:00

18 avril 2025 17:03:42 UTC+02:00

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

![JohnHernández]() JohnHernández

JohnHernández

17 avril 2025 18:58:48 UTC+02:00

17 avril 2025 18:58:48 UTC+02:00

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

![MarkScott]() MarkScott

MarkScott

17 avril 2025 07:54:17 UTC+02:00

17 avril 2025 07:54:17 UTC+02:00

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0

Ainsi, Meta a lancé son nouveau modèle d'IA, Maverick, pendant le week-end, et il fait déjà des vagues en décrochant la deuxième place sur LM Arena. Vous savez, c'est l'endroit où les humains jouent les juges et les jurés, comparant différents modèles d'IA et choisissant leurs favoris. Mais, attendez une seconde, il y a un rebondissement ! Il s'avère que la version de Maverick qui parade sur LM Arena n'est pas tout à fait la même que celle que vous pouvez télécharger et utiliser en tant que développeur.

Certains chercheurs en IA aux yeux de lynx sur X (oui, la plateforme autrefois connue sous le nom de Twitter) ont remarqué que Meta a qualifié la version de LM Arena de "version expérimentale de chat". Et si vous jetez un œil au site web de Llama, il y a un tableau qui révèle tout, indiquant que les tests ont été réalisés avec "Llama 4 Maverick optimisé pour la conversation". Nous en avons déjà parlé, mais LM Arena n'est pas exactement l'étalon-or pour mesurer les performances des IA. La plupart des entreprises d'IA ne modifient pas leurs modèles juste pour obtenir un meilleur score à ce test — ou du moins, elles ne l'admettent pas.

Le problème, c'est que lorsqu'on ajuste un modèle pour exceller dans un benchmark mais qu'on publie ensuite une version "vanille" différente au public, il est difficile pour les développeurs de comprendre comment le modèle se comportera réellement dans des scénarios du monde réel. De plus, c'est un peu trompeur, non ? Les benchmarks, imparfaits qu'ils soient, devraient nous donner une image claire de ce qu'un modèle peut et ne peut pas faire à travers différentes tâches.

Les chercheurs sur X ont rapidement remarqué des différences significatives entre le Maverick que vous pouvez télécharger et celui sur LM Arena. La version Arena semble être très portée sur les emojis et adore donner des réponses longues et détaillées.

Okay Llama 4 is def a littled cooked lol, what is this yap city pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) April 6, 2025

for some reason, the Llama 4 model in Arena uses a lot more Emojis

— Tech Dev Notes (@techdevnotes) April 6, 2025

on together . ai, it seems better: pic.twitter.com/f74ODX4zTt

Nous avons contacté Meta et les responsables de Chatbot Arena, qui gèrent LM Arena, pour savoir ce qu'ils ont à dire à ce sujet. Restez à l'écoute !

Zuckerberg, de Meta, déclare que tous les modèles de "superintelligence" de l'IA ne seront pas ouverts au public

Le virage stratégique de Meta vers la superintelligence personnelleMark Zuckerberg, PDG de Meta, a présenté cette semaine une vision ambitieuse de la "superintelligence personnelle" - des systèmes d'I

Zuckerberg, de Meta, déclare que tous les modèles de "superintelligence" de l'IA ne seront pas ouverts au public

Le virage stratégique de Meta vers la superintelligence personnelleMark Zuckerberg, PDG de Meta, a présenté cette semaine une vision ambitieuse de la "superintelligence personnelle" - des systèmes d'I

L'IA de Meta s'attaque au doublage vidéo pour les contenus Instagram

Meta élargit l'accès à sa technologie révolutionnaire de doublage alimentée par l'IA sur Facebook et Instagram, en introduisant des capacités de traduction vidéo transparentes qui conservent votre voi

L'IA de Meta s'attaque au doublage vidéo pour les contenus Instagram

Meta élargit l'accès à sa technologie révolutionnaire de doublage alimentée par l'IA sur Facebook et Instagram, en introduisant des capacités de traduction vidéo transparentes qui conservent votre voi

Application Meta AI pour introduire un niveau premium et des publicités

L'application d'IA de Meta pourrait bientôt proposer un abonnement payant, à l'image des offres de concurrents comme OpenAI, Google et Microsoft. Lors d'une conférence sur les résultats du premier tri

Application Meta AI pour introduire un niveau premium et des publicités

L'application d'IA de Meta pourrait bientôt proposer un abonnement payant, à l'image des offres de concurrents comme OpenAI, Google et Microsoft. Lors d'une conférence sur les résultats du premier tri

28 juillet 2025 03:20:54 UTC+02:00

28 juillet 2025 03:20:54 UTC+02:00

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

21 avril 2025 12:14:21 UTC+02:00

21 avril 2025 12:14:21 UTC+02:00

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

21 avril 2025 04:55:14 UTC+02:00

21 avril 2025 04:55:14 UTC+02:00

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

18 avril 2025 17:03:42 UTC+02:00

18 avril 2025 17:03:42 UTC+02:00

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

17 avril 2025 18:58:48 UTC+02:00

17 avril 2025 18:58:48 UTC+02:00

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

17 avril 2025 07:54:17 UTC+02:00

17 avril 2025 07:54:17 UTC+02:00

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0