Metas KI -Modell Benchmarks: irreführend?

Meta hat am Wochenende sein neues AI-Modell Maverick veröffentlicht, und es sorgt bereits für Aufsehen, indem es den zweiten Platz auf LM Arena erobert. Das ist der Ort, an dem Menschen Richter und Geschworene spielen, verschiedene AI-Modelle vergleichen und ihre Favoriten auswählen. Aber Moment, es gibt einen Haken! Es stellt sich heraus, dass die Maverick-Version, die auf LM Arena glänzt, nicht ganz die gleiche ist, die Entwickler herunterladen und nutzen können.

Einige aufmerksame AI-Forscher auf X (ja, die Plattform, die früher als Twitter bekannt war) haben bemerkt, dass Meta die LM Arena-Version als „experimentelle Chat-Version“ bezeichnet hat. Und wenn man auf die Llama-Website schaut, gibt es eine Tabelle, die verrät, dass die Tests mit „Llama 4 Maverick, optimiert für Konversation“ durchgeführt wurden. Wir haben schon früher darüber gesprochen, aber LM Arena ist nicht gerade der Goldstandard zur Messung von AI-Leistung. Die meisten AI-Unternehmen manipulieren ihre Modelle nicht, um in diesem Test besser abzuschneiden – oder geben es zumindest nicht zu.

Die Sache ist, wenn man ein Modell optimiert, um in einem Benchmark zu glänzen, aber dann eine andere „Standard“-Version für die Öffentlichkeit veröffentlicht, ist es für Entwickler schwierig herauszufinden, wie gut das Modell in realen Szenarien tatsächlich abschneidet. Außerdem ist das irgendwie irreführend, oder? Benchmarks, so fehlerhaft sie auch sind, sollten ein klares Bild davon vermitteln, was ein Modell kann und was nicht, über verschiedene Aufgaben hinweg.

Forscher auf X haben schnell große Unterschiede zwischen der herunterladbaren Maverick-Version und der auf LM Arena bemerkt. Die Arena-Version setzt offenbar stark auf Emojis und liebt es, lange, ausführliche Antworten zu geben.

Okay Llama 4 is def a littled cooked lol, what is this yap city pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) April 6, 2025

for some reason, the Llama 4 model in Arena uses a lot more Emojis

on together . ai, it seems better: pic.twitter.com/f74ODX4zTt

— Tech Dev Notes (@techdevnotes) April 6, 2025

Wir haben Meta und die Leute von Chatbot Arena, die LM Arena betreiben, kontaktiert, um zu hören, was sie dazu zu sagen haben. Bleibt dran!

Verwandter Artikel

Metas Zuckerberg sagt, dass nicht alle KI-"Superintelligenz"-Modelle offen zugänglich sein werden

Metas Strategiewechsel hin zu persönlicher SuperintelligenzMeta-CEO Mark Zuckerberg skizzierte diese Woche eine ehrgeizige Vision für "persönliche Superintelligenz" - KI-Systeme, die Einzelpersonen in

Metas Zuckerberg sagt, dass nicht alle KI-"Superintelligenz"-Modelle offen zugänglich sein werden

Metas Strategiewechsel hin zu persönlicher SuperintelligenzMeta-CEO Mark Zuckerberg skizzierte diese Woche eine ehrgeizige Vision für "persönliche Superintelligenz" - KI-Systeme, die Einzelpersonen in

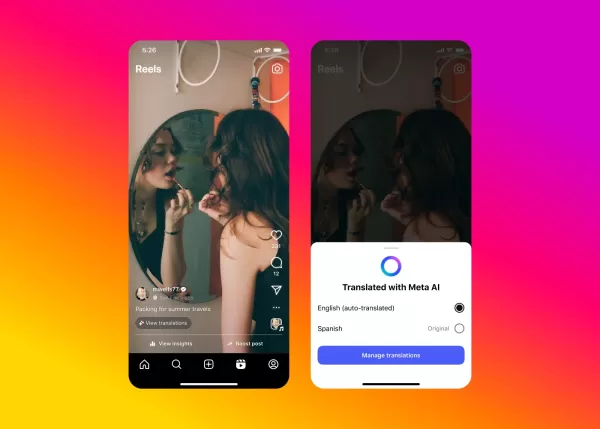

Metas KI nimmt die Videovertonung für Instagram-Inhalte in Angriff

Meta erweitert den Zugang zu seiner bahnbrechenden KI-gesteuerten Synchronisationstechnologie auf Facebook und Instagram und führt nahtlose Videoübersetzungsfunktionen ein, die Ihre authentische Stimm

Metas KI nimmt die Videovertonung für Instagram-Inhalte in Angriff

Meta erweitert den Zugang zu seiner bahnbrechenden KI-gesteuerten Synchronisationstechnologie auf Facebook und Instagram und führt nahtlose Videoübersetzungsfunktionen ein, die Ihre authentische Stimm

Meta AI App führt Premium-Stufe und Werbung ein

Die AI-App von Meta könnte bald ein kostenpflichtiges Abonnement einführen, ähnlich den Angeboten von Konkurrenten wie OpenAI, Google und Microsoft. Während eines Q1 2025 Earnings Calls skizzierte Met

Kommentare (36)

0/200

Meta AI App führt Premium-Stufe und Werbung ein

Die AI-App von Meta könnte bald ein kostenpflichtiges Abonnement einführen, ähnlich den Angeboten von Konkurrenten wie OpenAI, Google und Microsoft. Während eines Q1 2025 Earnings Calls skizzierte Met

Kommentare (36)

0/200

![ScottWalker]() ScottWalker

ScottWalker

28. Juli 2025 03:20:54 MESZ

28. Juli 2025 03:20:54 MESZ

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

![KennethMartin]() KennethMartin

KennethMartin

21. April 2025 12:14:21 MESZ

21. April 2025 12:14:21 MESZ

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

![WalterThomas]() WalterThomas

WalterThomas

21. April 2025 04:55:14 MESZ

21. April 2025 04:55:14 MESZ

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

![JohnYoung]() JohnYoung

JohnYoung

18. April 2025 17:03:42 MESZ

18. April 2025 17:03:42 MESZ

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

![JohnHernández]() JohnHernández

JohnHernández

17. April 2025 18:58:48 MESZ

17. April 2025 18:58:48 MESZ

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

![MarkScott]() MarkScott

MarkScott

17. April 2025 07:54:17 MESZ

17. April 2025 07:54:17 MESZ

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0

Meta hat am Wochenende sein neues AI-Modell Maverick veröffentlicht, und es sorgt bereits für Aufsehen, indem es den zweiten Platz auf LM Arena erobert. Das ist der Ort, an dem Menschen Richter und Geschworene spielen, verschiedene AI-Modelle vergleichen und ihre Favoriten auswählen. Aber Moment, es gibt einen Haken! Es stellt sich heraus, dass die Maverick-Version, die auf LM Arena glänzt, nicht ganz die gleiche ist, die Entwickler herunterladen und nutzen können.

Einige aufmerksame AI-Forscher auf X (ja, die Plattform, die früher als Twitter bekannt war) haben bemerkt, dass Meta die LM Arena-Version als „experimentelle Chat-Version“ bezeichnet hat. Und wenn man auf die Llama-Website schaut, gibt es eine Tabelle, die verrät, dass die Tests mit „Llama 4 Maverick, optimiert für Konversation“ durchgeführt wurden. Wir haben schon früher darüber gesprochen, aber LM Arena ist nicht gerade der Goldstandard zur Messung von AI-Leistung. Die meisten AI-Unternehmen manipulieren ihre Modelle nicht, um in diesem Test besser abzuschneiden – oder geben es zumindest nicht zu.

Die Sache ist, wenn man ein Modell optimiert, um in einem Benchmark zu glänzen, aber dann eine andere „Standard“-Version für die Öffentlichkeit veröffentlicht, ist es für Entwickler schwierig herauszufinden, wie gut das Modell in realen Szenarien tatsächlich abschneidet. Außerdem ist das irgendwie irreführend, oder? Benchmarks, so fehlerhaft sie auch sind, sollten ein klares Bild davon vermitteln, was ein Modell kann und was nicht, über verschiedene Aufgaben hinweg.

Forscher auf X haben schnell große Unterschiede zwischen der herunterladbaren Maverick-Version und der auf LM Arena bemerkt. Die Arena-Version setzt offenbar stark auf Emojis und liebt es, lange, ausführliche Antworten zu geben.

Okay Llama 4 is def a littled cooked lol, what is this yap city pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) April 6, 2025

for some reason, the Llama 4 model in Arena uses a lot more Emojis

— Tech Dev Notes (@techdevnotes) April 6, 2025

on together . ai, it seems better: pic.twitter.com/f74ODX4zTt

Wir haben Meta und die Leute von Chatbot Arena, die LM Arena betreiben, kontaktiert, um zu hören, was sie dazu zu sagen haben. Bleibt dran!

Metas Zuckerberg sagt, dass nicht alle KI-"Superintelligenz"-Modelle offen zugänglich sein werden

Metas Strategiewechsel hin zu persönlicher SuperintelligenzMeta-CEO Mark Zuckerberg skizzierte diese Woche eine ehrgeizige Vision für "persönliche Superintelligenz" - KI-Systeme, die Einzelpersonen in

Metas Zuckerberg sagt, dass nicht alle KI-"Superintelligenz"-Modelle offen zugänglich sein werden

Metas Strategiewechsel hin zu persönlicher SuperintelligenzMeta-CEO Mark Zuckerberg skizzierte diese Woche eine ehrgeizige Vision für "persönliche Superintelligenz" - KI-Systeme, die Einzelpersonen in

Metas KI nimmt die Videovertonung für Instagram-Inhalte in Angriff

Meta erweitert den Zugang zu seiner bahnbrechenden KI-gesteuerten Synchronisationstechnologie auf Facebook und Instagram und führt nahtlose Videoübersetzungsfunktionen ein, die Ihre authentische Stimm

Metas KI nimmt die Videovertonung für Instagram-Inhalte in Angriff

Meta erweitert den Zugang zu seiner bahnbrechenden KI-gesteuerten Synchronisationstechnologie auf Facebook und Instagram und führt nahtlose Videoübersetzungsfunktionen ein, die Ihre authentische Stimm

Meta AI App führt Premium-Stufe und Werbung ein

Die AI-App von Meta könnte bald ein kostenpflichtiges Abonnement einführen, ähnlich den Angeboten von Konkurrenten wie OpenAI, Google und Microsoft. Während eines Q1 2025 Earnings Calls skizzierte Met

Meta AI App führt Premium-Stufe und Werbung ein

Die AI-App von Meta könnte bald ein kostenpflichtiges Abonnement einführen, ähnlich den Angeboten von Konkurrenten wie OpenAI, Google und Microsoft. Während eines Q1 2025 Earnings Calls skizzierte Met

28. Juli 2025 03:20:54 MESZ

28. Juli 2025 03:20:54 MESZ

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

21. April 2025 12:14:21 MESZ

21. April 2025 12:14:21 MESZ

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

21. April 2025 04:55:14 MESZ

21. April 2025 04:55:14 MESZ

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

18. April 2025 17:03:42 MESZ

18. April 2025 17:03:42 MESZ

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

17. April 2025 18:58:48 MESZ

17. April 2025 18:58:48 MESZ

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

17. April 2025 07:54:17 MESZ

17. April 2025 07:54:17 MESZ

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0