메타의 AI 모델 벤치 마크 : 오도?

그래서, 메타가 주말에 새로운 AI 모델인 Maverick을 공개했는데, 이미 LM Arena에서 2위를 차지하며 파장을 일으키고 있습니다. 아시다시피, 그곳은 사람들이 판사와 배심원 역할을 하며 다양한 AI 모델을 비교하고 마음에 드는 것을 선택하는 곳입니다. 하지만, 잠깐! 여기서 반전이 있습니다! LM Arena에서 멋지게 활약 중인 Maverick 버전은 개발자가 다운로드해서 사용할 수 있는 버전과는 조금 다르다는 것이 밝혀졌습니다.

X(예전 트위터로 알려진 플랫폼)에서 예리한 AI 연구원들이 메타가 LM Arena 버전을 "실험적 대화 버전"이라고 불렀다는 것을 발견했습니다. 그리고 Llama 웹사이트를 살펴보면, 테스트가 "대화에 최적화된 Llama 4 Maverick"으로 이루어졌다고 밝히는 차트가 있습니다. 이전에도 이야기했지만, LM Arena는 AI 성능을 측정하는 데 있어 최고의 기준은 아닙니다. 대부분의 AI 회사들은 이 테스트에서 더 높은 점수를 얻기 위해 모델을 조작하지 않거나, 적어도 그렇게 인정하지 않습니다.

문제는, 벤치마크에서 좋은 성적을 내도록 모델을 조정한 뒤, 일반 사용자에게는 다른 "기본" 버전을 공개하면, 개발자들이 실제 시나리오에서 모델이 얼마나 잘 작동할지 파악하기 어렵다는 점입니다. 게다가, 이건 좀 오해의 소지가 있지 않나요? 벤치마크는, 결함이 있더라도, 모델이 다양한 작업에서 무엇을 할 수 있고 할 수 없는지에 대한 명확한 그림을 제공해야 합니다.

X의 연구원들은 다운로드 가능한 Maverick과 LM Arena의 Maverick 사이에 큰 차이가 있다는 것을 빠르게 알아차렸습니다. Arena 버전은 이모지를 많이 사용하고, 길고 장황한 답변을 제공하는 것을 좋아한다고 합니다.

좋아요, Llama 4는 확실히 좀 과장된 느낌이네요 lol, 이건 뭐 수다 도시인가요 pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) 2025년 4월 6일

어떤 이유로, Arena의 Llama 4 모델은 이모지를 훨씬 더 많이 사용합니다

together.ai에서는 더 나아 보입니다: pic.twitter.com/f74ODX4zTt

— Tech Dev Notes (@techdevnotes) 2025년 4월 6일

우리는 메타와 LM Arena를 운영하는 Chatbot Arena 팀에 연락해 이에 대해 어떤 입장인지 알아봤습니다. 계속 지켜봐 주세요!

관련 기사

메타의 주커버그, 모든 AI '초지능' 모델이 오픈소스로 제공되지는 않을 것이라고 말하다

개인 초지능을 향한 Meta의 전략적 전환이번 주 Meta의 CEO 마크 저커버그는 개인이 개인적인 목표를 달성할 수 있도록 지원하는 AI 시스템인 '개인 초지능'에 대한 야심찬 비전을 발표하며 회사의 AI 배포 전략에 잠재적인 변화를 예고했습니다.오픈 소스 딜레마주커버그의 성명은 초지능 시스템을 추구하면서 고급 AI 모델을 오픈소스화하려는 메타의 노력을

메타의 주커버그, 모든 AI '초지능' 모델이 오픈소스로 제공되지는 않을 것이라고 말하다

개인 초지능을 향한 Meta의 전략적 전환이번 주 Meta의 CEO 마크 저커버그는 개인이 개인적인 목표를 달성할 수 있도록 지원하는 AI 시스템인 '개인 초지능'에 대한 야심찬 비전을 발표하며 회사의 AI 배포 전략에 잠재적인 변화를 예고했습니다.오픈 소스 딜레마주커버그의 성명은 초지능 시스템을 추구하면서 고급 AI 모델을 오픈소스화하려는 메타의 노력을

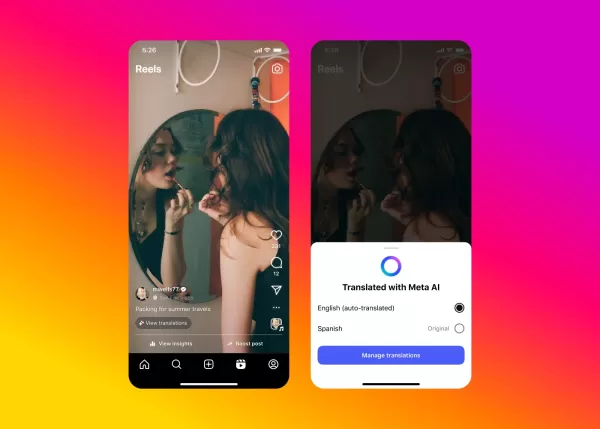

Instagram 콘텐츠의 비디오 더빙 문제를 해결한 Meta의 AI

메타는 획기적인 AI 기반 더빙 기술을 Facebook과 Instagram에 확대 적용하여 실제 목소리와 자연스러운 입술 움직임을 유지하는 매끄러운 동영상 번역 기능을 선보이고 있습니다.이문화 콘텐츠의 혁신메타의 새로운 AI 번역 기능은 제작자의 목소리와 립싱크를 그대로 유지하면서 영어와 스페인어 릴을 자동으로 변환합니다. 이 혁신은 작년 메타 커넥트 행사

Instagram 콘텐츠의 비디오 더빙 문제를 해결한 Meta의 AI

메타는 획기적인 AI 기반 더빙 기술을 Facebook과 Instagram에 확대 적용하여 실제 목소리와 자연스러운 입술 움직임을 유지하는 매끄러운 동영상 번역 기능을 선보이고 있습니다.이문화 콘텐츠의 혁신메타의 새로운 AI 번역 기능은 제작자의 목소리와 립싱크를 그대로 유지하면서 영어와 스페인어 릴을 자동으로 변환합니다. 이 혁신은 작년 메타 커넥트 행사

Meta AI 앱, 프리미엄 티어 및 광고 도입

Meta의 AI 앱은 OpenAI, Google, Microsoft와 같은 경쟁사의 제품과 유사하게 유료 구독 서비스를 곧 선보일 예정입니다. 2025년 1분기 실적 발표에서 Meta CEO Mark Zuckerberg는 프리미엄 서비스 계획을 밝히며, 이를 통해 사용자가 Meta AI에서 향상된 컴퓨팅 파워나 추가 기능을 이용할 수 있다고 전했습니다.Ch

의견 (36)

0/200

Meta AI 앱, 프리미엄 티어 및 광고 도입

Meta의 AI 앱은 OpenAI, Google, Microsoft와 같은 경쟁사의 제품과 유사하게 유료 구독 서비스를 곧 선보일 예정입니다. 2025년 1분기 실적 발표에서 Meta CEO Mark Zuckerberg는 프리미엄 서비스 계획을 밝히며, 이를 통해 사용자가 Meta AI에서 향상된 컴퓨팅 파워나 추가 기능을 이용할 수 있다고 전했습니다.Ch

의견 (36)

0/200

![ScottWalker]() ScottWalker

ScottWalker

2025년 7월 28일 오전 10시 20분 54초 GMT+09:00

2025년 7월 28일 오전 10시 20분 54초 GMT+09:00

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

![KennethMartin]() KennethMartin

KennethMartin

2025년 4월 21일 오후 7시 14분 21초 GMT+09:00

2025년 4월 21일 오후 7시 14분 21초 GMT+09:00

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

![WalterThomas]() WalterThomas

WalterThomas

2025년 4월 21일 오전 11시 55분 14초 GMT+09:00

2025년 4월 21일 오전 11시 55분 14초 GMT+09:00

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

![JohnYoung]() JohnYoung

JohnYoung

2025년 4월 19일 오전 12시 3분 42초 GMT+09:00

2025년 4월 19일 오전 12시 3분 42초 GMT+09:00

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

![JohnHernández]() JohnHernández

JohnHernández

2025년 4월 18일 오전 1시 58분 48초 GMT+09:00

2025년 4월 18일 오전 1시 58분 48초 GMT+09:00

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

![MarkScott]() MarkScott

MarkScott

2025년 4월 17일 오후 2시 54분 17초 GMT+09:00

2025년 4월 17일 오후 2시 54분 17초 GMT+09:00

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0

그래서, 메타가 주말에 새로운 AI 모델인 Maverick을 공개했는데, 이미 LM Arena에서 2위를 차지하며 파장을 일으키고 있습니다. 아시다시피, 그곳은 사람들이 판사와 배심원 역할을 하며 다양한 AI 모델을 비교하고 마음에 드는 것을 선택하는 곳입니다. 하지만, 잠깐! 여기서 반전이 있습니다! LM Arena에서 멋지게 활약 중인 Maverick 버전은 개발자가 다운로드해서 사용할 수 있는 버전과는 조금 다르다는 것이 밝혀졌습니다.

X(예전 트위터로 알려진 플랫폼)에서 예리한 AI 연구원들이 메타가 LM Arena 버전을 "실험적 대화 버전"이라고 불렀다는 것을 발견했습니다. 그리고 Llama 웹사이트를 살펴보면, 테스트가 "대화에 최적화된 Llama 4 Maverick"으로 이루어졌다고 밝히는 차트가 있습니다. 이전에도 이야기했지만, LM Arena는 AI 성능을 측정하는 데 있어 최고의 기준은 아닙니다. 대부분의 AI 회사들은 이 테스트에서 더 높은 점수를 얻기 위해 모델을 조작하지 않거나, 적어도 그렇게 인정하지 않습니다.

문제는, 벤치마크에서 좋은 성적을 내도록 모델을 조정한 뒤, 일반 사용자에게는 다른 "기본" 버전을 공개하면, 개발자들이 실제 시나리오에서 모델이 얼마나 잘 작동할지 파악하기 어렵다는 점입니다. 게다가, 이건 좀 오해의 소지가 있지 않나요? 벤치마크는, 결함이 있더라도, 모델이 다양한 작업에서 무엇을 할 수 있고 할 수 없는지에 대한 명확한 그림을 제공해야 합니다.

X의 연구원들은 다운로드 가능한 Maverick과 LM Arena의 Maverick 사이에 큰 차이가 있다는 것을 빠르게 알아차렸습니다. Arena 버전은 이모지를 많이 사용하고, 길고 장황한 답변을 제공하는 것을 좋아한다고 합니다.

좋아요, Llama 4는 확실히 좀 과장된 느낌이네요 lol, 이건 뭐 수다 도시인가요 pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) 2025년 4월 6일

어떤 이유로, Arena의 Llama 4 모델은 이모지를 훨씬 더 많이 사용합니다

— Tech Dev Notes (@techdevnotes) 2025년 4월 6일

together.ai에서는 더 나아 보입니다: pic.twitter.com/f74ODX4zTt

우리는 메타와 LM Arena를 운영하는 Chatbot Arena 팀에 연락해 이에 대해 어떤 입장인지 알아봤습니다. 계속 지켜봐 주세요!

메타의 주커버그, 모든 AI '초지능' 모델이 오픈소스로 제공되지는 않을 것이라고 말하다

개인 초지능을 향한 Meta의 전략적 전환이번 주 Meta의 CEO 마크 저커버그는 개인이 개인적인 목표를 달성할 수 있도록 지원하는 AI 시스템인 '개인 초지능'에 대한 야심찬 비전을 발표하며 회사의 AI 배포 전략에 잠재적인 변화를 예고했습니다.오픈 소스 딜레마주커버그의 성명은 초지능 시스템을 추구하면서 고급 AI 모델을 오픈소스화하려는 메타의 노력을

메타의 주커버그, 모든 AI '초지능' 모델이 오픈소스로 제공되지는 않을 것이라고 말하다

개인 초지능을 향한 Meta의 전략적 전환이번 주 Meta의 CEO 마크 저커버그는 개인이 개인적인 목표를 달성할 수 있도록 지원하는 AI 시스템인 '개인 초지능'에 대한 야심찬 비전을 발표하며 회사의 AI 배포 전략에 잠재적인 변화를 예고했습니다.오픈 소스 딜레마주커버그의 성명은 초지능 시스템을 추구하면서 고급 AI 모델을 오픈소스화하려는 메타의 노력을

Instagram 콘텐츠의 비디오 더빙 문제를 해결한 Meta의 AI

메타는 획기적인 AI 기반 더빙 기술을 Facebook과 Instagram에 확대 적용하여 실제 목소리와 자연스러운 입술 움직임을 유지하는 매끄러운 동영상 번역 기능을 선보이고 있습니다.이문화 콘텐츠의 혁신메타의 새로운 AI 번역 기능은 제작자의 목소리와 립싱크를 그대로 유지하면서 영어와 스페인어 릴을 자동으로 변환합니다. 이 혁신은 작년 메타 커넥트 행사

Instagram 콘텐츠의 비디오 더빙 문제를 해결한 Meta의 AI

메타는 획기적인 AI 기반 더빙 기술을 Facebook과 Instagram에 확대 적용하여 실제 목소리와 자연스러운 입술 움직임을 유지하는 매끄러운 동영상 번역 기능을 선보이고 있습니다.이문화 콘텐츠의 혁신메타의 새로운 AI 번역 기능은 제작자의 목소리와 립싱크를 그대로 유지하면서 영어와 스페인어 릴을 자동으로 변환합니다. 이 혁신은 작년 메타 커넥트 행사

Meta AI 앱, 프리미엄 티어 및 광고 도입

Meta의 AI 앱은 OpenAI, Google, Microsoft와 같은 경쟁사의 제품과 유사하게 유료 구독 서비스를 곧 선보일 예정입니다. 2025년 1분기 실적 발표에서 Meta CEO Mark Zuckerberg는 프리미엄 서비스 계획을 밝히며, 이를 통해 사용자가 Meta AI에서 향상된 컴퓨팅 파워나 추가 기능을 이용할 수 있다고 전했습니다.Ch

Meta AI 앱, 프리미엄 티어 및 광고 도입

Meta의 AI 앱은 OpenAI, Google, Microsoft와 같은 경쟁사의 제품과 유사하게 유료 구독 서비스를 곧 선보일 예정입니다. 2025년 1분기 실적 발표에서 Meta CEO Mark Zuckerberg는 프리미엄 서비스 계획을 밝히며, 이를 통해 사용자가 Meta AI에서 향상된 컴퓨팅 파워나 추가 기능을 이용할 수 있다고 전했습니다.Ch

2025년 7월 28일 오전 10시 20분 54초 GMT+09:00

2025년 7월 28일 오전 10시 20분 54초 GMT+09:00

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

2025년 4월 21일 오후 7시 14분 21초 GMT+09:00

2025년 4월 21일 오후 7시 14분 21초 GMT+09:00

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

2025년 4월 21일 오전 11시 55분 14초 GMT+09:00

2025년 4월 21일 오전 11시 55분 14초 GMT+09:00

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

2025년 4월 19일 오전 12시 3분 42초 GMT+09:00

2025년 4월 19일 오전 12시 3분 42초 GMT+09:00

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

2025년 4월 18일 오전 1시 58분 48초 GMT+09:00

2025년 4월 18일 오전 1시 58분 48초 GMT+09:00

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

2025년 4월 17일 오후 2시 54분 17초 GMT+09:00

2025년 4월 17일 오후 2시 54분 17초 GMT+09:00

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0